#como hacer web scraping con python

Explore tagged Tumblr posts

Text

Simple Scraping con Google Sheets (2020 actualizado)

Este herramienta de web scraping puede automatizar el proceso de copia y pegado repetitivos. En realidad, las hojas de Google pueden considerarse un web scraping básico. Puede usar una fórmula especial para extraer datos de una página web, importar los datos directamente a las hojas de Google y compartirlos con sus amigos.

En este artículo, primero le mostraré cómo construir un web scraping simple con Hojas de cálculo de Google. Luego lo compararé con Octoparse web scraping automático. Después de leerlo, tendrá una idea clara sobre qué método funcionaría mejor para sus necesidades específicas de web scraping.

Opción#1: Cree un web scraping sencillo con ImportXML en Google Spreadsheets

Paso 1: Abre una nueva hoja de Google.

Paso 2: Abra un sitio web de destino con Chrome. En este caso, elegimos ’Games sales’. Haga clic derecho en la página web y aparecerá un menú desplegable. Luego seleccione "inspeccionar". Presione una combinación de tres teclas: "Ctrl” + "Shift" + "C" para activar "Selector". Esto permitiría al panel de inspección obtener la información del elemento seleccionado dentro de la página web.

Paso 3: Copie y pegue la URL del sitio web en la hoja.

Opción#2: Intentemos obtener datos de precios con una fórmula simple: ImportXML

Paso 1: Copie el Xpath del elemento. Seleccione el elemento de precio y haga clic con el botón derecho para que aparezca el menú desplegable. Luego seleccione "Copiar", elija "Copiar XPath".

Paso 2: Escriba la fórmula en la hoja de cálculo.

=IMPORTXML(“URL”, “XPATH expression”)

Tenga en cuenta que la "expresión Xpath" es la que acabamos de copiar de Chrome. Reemplace la comilla doble "" dentro de la expresión Xpath con una comilla simple ''.

Opción#3: Hay otra fórmula que podemos usar:

=IMPORTHTML(“URL”, “QUERY”, Index)

Con esta fórmula, extraes toda la tabla.

Ahora, veamos cómo se puede lograr la misma tarea de raspado con un rastreador web, Octoparse.

Paso 1: Abra Octoparse, cree una nueva tarea seleccionando "+ Tarea" en el "Modo avanzado"

Paso 2: Elija su grupo de tareas preferido. Luego ingrese la URL del sitio web de destino y haga clic en "Guardar URL". En este caso: sitio web de Game Sale http://steamspy.com/

Paso 3: Aviso El sitio web de Game Sale se muestra en la sección de vista interactiva de Octoparse. Necesitamos crear una lista de bucles para que Octoparse revise los listados.

1. Haga clic en una fila de la tabla (podría ser cualquier archivo dentro de la tabla). Octoparse detectará elementos similares y los resaltará en rojo.

2. Necesitamos extraer por filas, así que elija "TR" (Fila de Tabla) desde el panel de control.

3. Después de seleccionar una fila, elija el comando "Seleccionar todos los subelementos" en el panel Consejos de acción. Elija el comando "Seleccionar todo" para seleccionar todas las filas de la tabla.

Paso 4: Elija "Extraer datos en el bucle" para extraer los datos.

Puede exportar los datos a Excel, CSV, TXT u otros formatos deseados. Las hojas de cálculo requieren que se copie y pegue, pero Octoparse automatiza el proceso. Además, Octoparse tiene más control sobre sitios web dinámicos con AJAX o reCaptcha.

Más recursos:

Create your first scraper with Octoparse [Video]

Los 20 mejores programas gratuitos de web scraping

Comparacion de las 5 mejores herramientas de web scraping

#Web scraping precios#scraping mensaje#como hacer web scraping con python#web scraping legal#web scraping javascript#scraper idealista#extraer datos de una web#correos electrónicos buscar#buscar personas por ccorreo electrónico#scrab in linkedin#Búsqueda de correos electrónicos#chrome scrab in

0 notes

Text

4 Formas de Extraer Datos del Sitio Web a Excel

Probablemente sepas cómo usar funciones básicas en Excel. Es fácil hacer cosas como ordenar, aplicar filtros, hacer gráficos y delinear datos con Excel. Incluso puedes realizar análisis de datos avanzados utilizando modelos de pivote y regresión. Se convierte en un trabajo fácil cuando los datos en vivo se convierten en un formato estructurado.

El problema es, ¿Cómo podemos extraer datos y ponerlos en Excel? Esto puede ser tedioso si lo haces manualmente escribiendo, buscando, copiando y pegando repetidamente. En cambio, puedes lograr la extracciñon automática de datos de la web para sobresalir.

En este artículo, te presentaré varias formas de ahorrar tiempo y energía, scrapear datos web en Excel.

Descargo de responsabilidad: Hay muchas otras formas de scrapear datos desde una web utilizando lenguajes de programación como PHP, Python, Perl, Ruby, etc. Aquí solo hablamos sobre cómo obtener datos de una web en Excel para no codificadores.

Tabla de contenidos

Obtener datos web utilizando Excel Web Queries

Obtener datos de la web usando Excel VBA

Utilizar herramientas de web scraping automatizadas

Subcontratar tu proyecto de web scraping

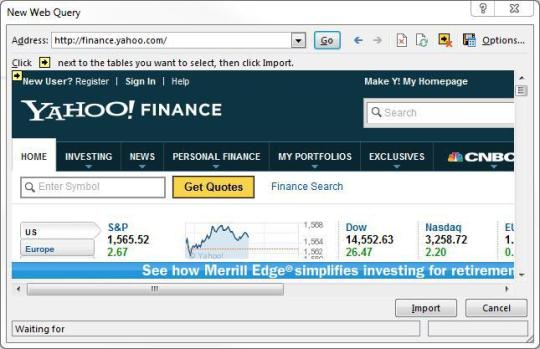

Obtener datos web utilizando Excel Web Queries

Excepto para transformar manualmente los datos de una página web copiando y pegando, Excel Web Queries se utiliza para recuperar rápidamente datos de páginas web estándar en hojas de cálculo de Excel. Puede detectar automáticamente tablas incrustadas en el HTML de la página web. Excel Web queries también se pueden usar en situaciones en las que es difícil crear o mantener una conexión estándar ODBC (Open Database Connectivity). Puede scrapear directamente una tabla desde cualquier sitio web utilizando Excel Web Queries.

El proceso se reduce a varios pasos simples (consulta este artículo):

1. Ir a Datos> Obtener datos externos> Dar la web

2. Aparecerá una ventana del navegador llamada "New Web Query"

3. Escribir la dirección web en la barra de direcciones.

4. Se cargará y mostrará iconos amarillos contra datos/tablas en la página.

5. Seleccionar uno apropiado

6. Presionar el botón Importar.

Ahora has scrapeado los datos de la web en una hoja de cálculo de Excel, perfecta permutación en filas y columnas como desees.

Obtener datos de la web usando Excel VBA

La mayoría de nosotros usaría fórmulas en Excel (p. Ej. = Avg (...), = sum (...), = if (...), etc.) mucho, pero menos familiarizado con el lenguaje incorporado: Visual BasicVisual Basic for Application a.k.a VBA. Se conoce comúnmente como "Macros" y dichos archivos de Excel se guardan como a **.xlsm.

Antes de usarlo,

Primero debes habilitar la pestaña la pestaña Desarrollador en la barra (hacer clic con el botón derecho en Archivo -> Personalizar barra -> verificar la pestaña Desarrollador),

Luego configura tu diseño. En esta interfaz de desarrollador, puedes escribir código VBA adjunto a varios eventos. Haz clic AQUÍ (https://msdn.microsoft.com/en-us/library/office/ee814737(v=office.14).aspx) para comenzar a utilizar VBA en Excel 2010.

Usar Excel VBA va a ser un poco técnico, esto no es muy amigable para quienes no son programadores entre nosotros. VBA funciona ejecutando macros, procedimientos paso a paso escritos en Excel Visual Basic. Para scrapear datos de sitios web a Excel usando VBA, necesitamos construir u obtener un script VBA para enviar alguna solicitud a las páginas web y obtener datos devueltos de estas páginas web. Es común usar VBA con XMLHTTP y expresiones regulares para analizar las páginas web. Para Windows, puedes usar VBA con WinHTTP o InternetExplorer para scrapear datos de sitios web a Excel.

Con un poco de paciencia y práctica, te convendría aprender algo de código Excel VBA y algo de conocimiento HTML para que tu Web scraping en Excel sea mucho más fácil y eficiente para automatizar el trabajo repetitivo. Hay una gran cantidad de material y foros para que aprendas a escribir código VBA.

Utilizar herramientas de web scraping automatizadas

Para alguien que está buscando una herramienta rápida para scrapear datos de las páginas a Excel y no quiere configurar el código VBA tú mismo, te recomiendo encarecidamente herramientas de web scraping automatizadas como Octoparse para scrapear datos para tu hoja de cálculo de Excel directamente o mediante API.

No hay necesidad de aprender a programar. Puedes elegir uno de esos programas gratuitos de web scraping de la lista y comenzar a extraer datos de sitios web de inmediato y exportarlos a Excel. Las diferentes herramientas de web scraping tienen sus ventajas y desventajas, y puedes elegir la perfecta para tus necesidades.

Echa un vistazo a esta publicación y prueba estas TOP 30 herramientas gratuitas de web scraping.

Subcontratar tu proyecto de web scraping

Si el tiempo es tu activo más valioso y deseas enfocarte en tus negocios principales, la mejor opción sería subcontratar un trabajo tan complicado de scrapear de contenido web a un equipo competente de scrapear de contenido web que tenga experiencia y conocimientos.

Es difícil scapear datos de sitios web debido al hecho de que la presencia de bots anti-scrape restringirá la práctica del web scraping. Un equipo competente de web scraping te ayudaría a obtener datos de los sitios web de manera adecuada y a entregarte datos estructurados en una hoja de Excel o en cualquier formato que necesites.

Octoparse proporciona todo lo que necesitas para la extracción automática de datos. Puedes scrapear los datos web rápidamente sin codificar y convierte las páginas web en datos estructurados con clics, o simplemente relájate y déjanos el trabajo a nosotros, ofrecemos servico de datos que nuestro equipo de datos se reunirá contigo para analizar el rastreo web y los requisitos de procesamiento de datos.

0 notes

Link

¿Cómo puede descargar imágenes de enlaces de forma gratuita en lote?

Para descargar la imagen del enlace, es posible que desee buscar en "Descargadores de imágenes a granel". Inspirado por las consultas recibidas, decidí hacer una lista de "los 5 mejores descargadores de imágenes masivas" para usted. Asegúrese de consultar este artículo Si desea descargar imágenes del enlace sin costo. (Si no está seguro de cómo extraer las URL de las imágenes, consulte esto: Cómo construir un rastreador de imágenes sin codificación)

#Web scraping precios#scraping mensaje#como hacer web scraping con python#web scraping legal#web scraping javascript#scraper idealista#extraer datos de una web#correos electrónicos buscar#buscar personas por ccorreo electrónico#scrab in linkedin#Búsqueda de correos electrónicos#chrome scrab in#web scraping software#crawly web scraper

0 notes

Text

Perspectiva de Datos: 54 Industrias que Usan Web Scraping

¿Qué es el web scraping?

Web Scraping (también llamado Web Crawling, Data Extraction, Screen Scraping) es el proceso de extraer datos de múltiples sitios web y guardarlos Excel, txt, CSV y JSON en formatos de databases locales. Con los abrumadores datos disponibles en Internet, el web scraping se convierte en un enfoque esencial para agregar Big Data.

¿Quién está usando web scraping?

Vamos a abordar esta pregunta analizando las diferentes industrias y trabajos que requieren habilidades de web scraping. Para hacer esto, hemos compilado y analizado información de trabajo extraída de sitios de trabajo, incluidos Indeed, Glassdoor y LinkedIn.

Para ver exactamente qué trabajos están usando habilidades de web scraping, tomamos un gigante tecnológico (Google) como ejemplo en esta investigación. Raspamos y analizamos las ofertas de trabajo de Google, para descubrir cuáles y cuántos trabajos requieren habilidades de web scraping.

Nuestros hallazgos se muestran a continuación. Después de leerlos, puede que estés tan sorprendido como nosotros. Si está interesado en el proceso de scraping, puede consultar los GitHub Repositories para descargar los rastreadores (que se ejecutan en una herramienta de web scraping gratuita Octoparse) para obtener los datos que desea.

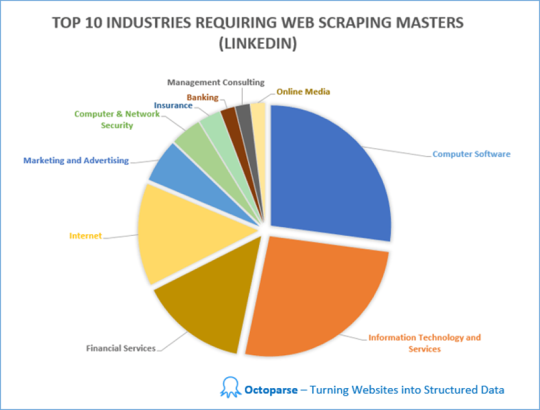

Encontrar 1: 54 Industrias Requieren habilidades de Web Scraping

Raspamos y analizamos las ofertas de trabajo en diferentes industrias que requieren web scraping skills en LinkedIn. En total, hay trabajos en 54 industrias que requieren habilidades de web scraping. Las 10 principales industrias con la mayor demanda de habilidades de web scraping son Software de Computadora (22%), Tecnología de la Información y Servicios (21%), Servicios Financieros (12%), Internet (11%), Marketing y Publicidad (5%) Computadora&Seguridad de red (3%), Seguros (2%), Banca (2%), Consultoría de Gestión (2%) y Medios en línea (2%).

Otras industrias incluyen Petróleo & Energía, Construcción, Bienes de Consumo, Defensa y Espacio, Personal y Reclutamiento, Atención Hospitalaria & de Salud, Gestión Educativa, Gestión de Organizaciones sin fines de lucro, Productos Farmacéuticos, Publicaciones, Investigación, Fabricación Eléctrica/Electrónica, Administración Gubernamental ... etc.

Hallazgo 2: Los trabajos no tecnológicos requieren Web Scraping Skills

También en base a la información extraída de LinkedIn, descubrimos que los trabajos no tecnológicos también incluyen el web scraping en sus requisitos de trabajo.

La sabiduría tradicional dice que la mayoría de los trabajos que requieren web scraping son relevantes para la tecnología, como la tecnología de la información y la ingeniería. Sin embargo, sorprendentemente, hay muchos otros tipos de trabajos que requieren habilidades de web scraping, como ventas, desarrollo de negocios, marketing, recursos humanos, redacción/edición y consultoría.

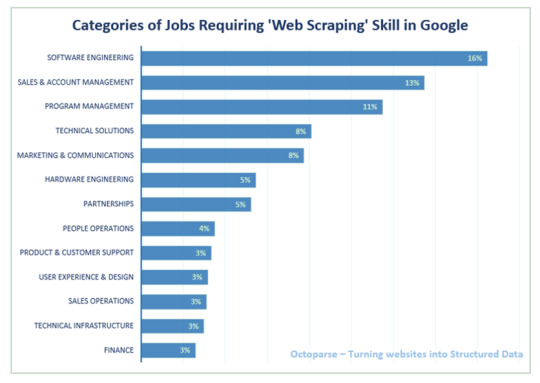

Específicamente, exploramos de web scraping jobs in Google, para descubrir cuántos trabajos requieren habilidades de web scraping y qué otros requisitos hay además del web scraping.

Hallazgo 3: Habilidades de Web Scraping en Tech Company (Google como ejemplo) Dado que es bastante obvio que las compañías de software y tecnología de la información tienen la mayor demanda de expertos en web scraping, decidimos profundizar en las ofertas de trabajo de Google. Las categorías de trabajo que más necesitan habilidades de web scraping son Ingeniería de Software, Ventas y Gestión de Cuentas y Gestión de Programas, seguidas de Soluciones Técnicas y Marketing & Comunicaciones.

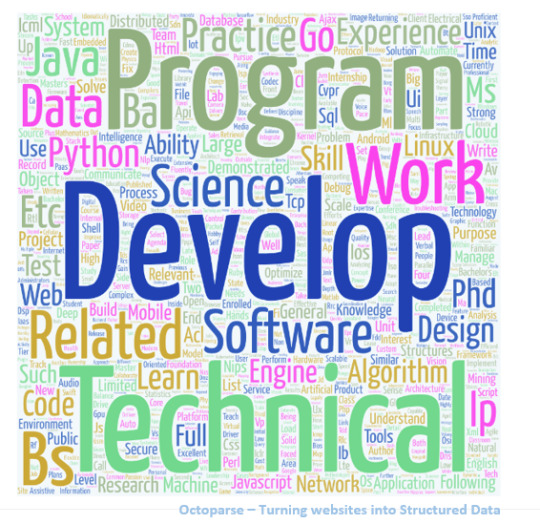

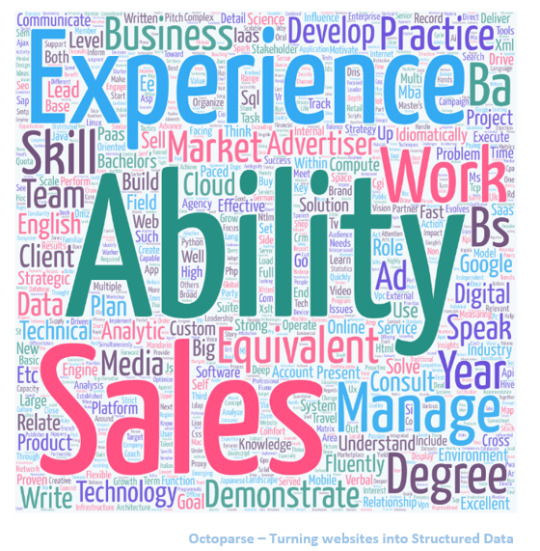

Para aquellos que tienen curiosidad sobre otros requisitos de habilidades para el ingeniero de software y ventas y administración de cuentas en Google, convertimos los requisitos del trabajo en nubes de palabras para darle una mejor idea.

Requisitos sobre Ingeniería de Software en Google

Requisitos sobre Ventas & Gestión de Cuentas en Google

Además de analizar las ofertas de trabajo que requieren habilidades de web scraping, también logramos ver una imagen más amplia de todos los trabajos disponibles en todas las industrias. Aquí hay información adicional que obtuvimos.

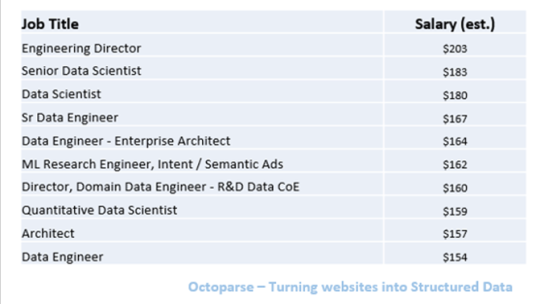

Hallazgo 4: Los 10 mejores trabajos mejor pagados

Según la información agregada de Glassdoor, existen grandes diferencias en los salarios para diferentes trabajos, que van desde $25K a $203K. Entre todos, los ingenieros de datos superiores y los científicos de datos son los trabajos mejor pagados.

Los datos anteriores se basan en la estimación de Glassdoor de los salarios base de los trabajos, que no necesariamente es respaldada por los empleadores. )

Entre toda la información sobre el trabajo que recopilamos, los trabajos que pagan menos son Político Reportero y Reclutador Junior, a partir de $25K y $29K.

Hallazgo 5: Las 10 Mejores Industrias de Pago

También exploramos el salario promedio en diferentes industrias, en base al mismo conjunto de datos extraído de Glassdoor. Las industrias con los salarios más altos son los servicios de petróleo y gas, biotecnología y productos farmacéuticos, y mercadería general y supermercado. Para nuestra sorpresa, Information Technology solo ocupa el número 5 en la lista.

Conclusión

Es seguro decir que el web scraping se ha convertido en una habilidad esencial para adquirir en el mundo digital actual, no solo para empresas tecnológicas y puestos tecnológicos, sino también para trabajos no tecnológicos. La capacidad de compilar grandes conjuntos de datos es fundamental para el análisis de Big Data, el aprendizaje automático y la inteligencia artificial.

Afortunadamente, Big Data es cada vez más fácil de acceder que nunca. Con Los 30 Mejores Software Gratuitos de Web Scraping en 2020 que se vuelven más inteligentes y populares, incluso las personas sin experiencia en programación pueden aplicar fácilmente el web scraping para agregar todo tipo de datos, trabajar con los conocimientos de Big Data para potenciar su negocio.

Dicho esto, si desea aprender sobre el web scraping pero no quiere lidiar con Python u otros lenguajes de programación, una herramienta de web scraping es una gran opción. He perfilado una lista de herramientas de web scraping a continuación para su referencia. Entre todas las opciones en el mercado, Octoparse se destaca como el mejor web scraper automático GRATUITO como una solución para la extracción de datos a escala.

#Web scraping precios#scraping y crawling scraping y crawling#web scraping extracción de datos#web scraping import io#web scraper chrome#scraper parsers#excel importar datos web contraseña#buscar personas por ccorreo electrónico#crawly web scraper#web scraping extracción de datos en la web

0 notes

Text

Los 30 Mejores Software de Web Scraping Gratis en 2020

El Web scraping (también denominado extracción de datos web, web crawler, captura de pantalla o recolección web) es una técnica web para extraer datos de los sitios web. Convierte datos no estructurados en datos estructurados que pueden almacenarse en su computadora local o en una base de datos.

Puede ser difícil crear un web scraping para personas que no saben nada sobre codificación. Afortunadamente, hay herramientas disponibles tanto para personas que tienen o no habilidades de programación. Aquí está nuestra lista de las 30 herramientas de web scraping más populares, desde bibliotecas de código abierto hasta extensiones de navegador y software de escritorio.

1. Beautiful Soup

¿Para quién es esto?: desarrolladores que dominan la programación para crear un web scraping/web crawler para rastrear los sitios web.

Por qué deberías usarlo:Beautiful Soup es una biblioteca de Python de código abierto diseñada para scrape archivos HTML y XML. Son los principales analizadores de Python que se han utilizado ampliamente. Si tiene habilidades de programación, funciona mejor cuando combina esta biblioteca con Python.

2. Octoparse

¿Cómo hacer web scraping?: Las empresas o las personas tienen la necesidad de extraer datos de la web: comercio electrónico, inversión, criptomoneda, marketing, bienes raíces, etc. Este software no requiere habilidades de programación y codificación.

Por qué debería usarlo: Octoparse es una plataforma de datos web SaaS gratuita de por vida. Puede usar para raspar datos web y convertir datos no estructurados o semiestructurados de sitios web en un conjunto de datos estructurados sin codificación. También proporciona task templates para usar, como eBay, Twitter, BestBuy y muchas otras. Octoparse también proporciona servicio de datos web. Puede personalizar el tarea scraper según sus necesidades de raspado.

3. Import.io

Para quién es esto: Empresa que busca una solución de integración en datos web.

Por qué debería usarlo: Import.io es una plataforma de datos web SaaS. Proporciona un software de web scraping que le permite raspar datos de sitios web y organizarlos en conjuntos de datos. Pueden integrar los datos web en herramientas analíticas para ventas y marketing para obtener información.

4. Mozenda

Para quién es esto: Empresas y negocios hay necesidades de fluctuantes de datos/datos en tiempo real.

Por qué debería usarlo: Mozenda proporciona una herramienta de extracción de datos que facilita la captura de contenido de la web. También proporcionan servicios de visualización de datos. Elimina la necesidad de contratar a un analista de datos.

5. Parsehub

Para quién es esto: analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: ParseHub es un software visual de web scrapinng que puede usar para obtener datos de la web. Puede extraer los datos haciendo clic en cualquier campo del sitio web. También tiene una rotación de IP que ayudaría a cambiar su dirección IP cuando se encuentre con sitios web agresivos con una técnica anti-raspado.

6. Crawlmonster

Para quién es esto: SEO y especialistas en marketing

Por qué deberías usarlo: CrawlMonster es un software gratuito de web scraping. Le permite escanear sitios web y analizar el contenido de su sitio web, el código fuente, el estado de la página y muchos otros.

7. Connotate

Para quién es esto: Empresa que busca una solución de integración en datos web.

Por qué debería usarlo: Connotate ha estado trabajando junto con Import.IO, que proporciona una solución para automatizar el scraping de datos web. Proporciona un servicio de datos web que puede ayudarlo a raspar, recopilar y manejar los datos.

8. Common Crawl

Para quién es esto: Investigador, estudiantes y profesores.

Por qué deberías usarlo: Common Crawl se basa en la idea del código abierto en la era digital. Proporciona conjuntos de datos abiertos de sitios web rastreados. Contiene datos sin procesar de la página web, metadatos extraídos y extracciones de texto.

9. Crawly

Para quién es esto: Personas con requisitos de datos básicos sin hababilidad de codificación.

Por qué debería usarlo: Crawly proporciona un servicio automático que raspa un sitio web y lo convierte en datos estructurados en forma de JSON o CSV. Pueden extraer elementos limitados en segundos, lo que incluye: Texto del título. HTML, comentarios, etiquetas de fecha y entidad, autor, URL de imágenes, videos, editor y país.

10. Content Grabber

Para quién es esto: Desarrolladores de Python que son expertos en programación.

Por qué debería usarlo: Content Grabber es un software de web scraping dirigido a empresas. Puede crear sus propios agentes de web scraping con sus herramientas integradas de terceros. Es muy flexible en el manejo de sitios web complejos y extracción de datos.

11. Diffbot

Para quién es esto: Desarrolladores y empresas.

Por qué debería usarlo: Diffbot es una herramienta de web scraping que utiliza aprendizaje automático y algoritmos y API públicas para extraer datos de páginas web (web scraping). Puede usar Diffbot para el análisis de la competencia, el monitoreo de precios, analizar el comportamiento del consumidor y muchos más.

12. Dexi.io

Para quién es esto: Personas con habilidades de programación y cotificación.

Por qué deberías usarlo: Dexi.io es un rastreador web basado en navegador. Proporciona tres tipos de robots: extractor, rastreador y tuberías. PIPES tiene una función de robot maestro donde 1 robot puede controlar múltiples tareas. Admite muchos servicios de terceros (solucionadores de captcha, almacenamiento en la nube, etc.) que puede integrar fácilmente en sus robots.

13. DataScraping.co

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: Data Scraping Studio es un software gratuito de raspado web para recolectar datos de páginas web, HTML, XML y pdf. Actualmente, el cliente de escritorio solo está disponible para Windows.

14. Easy Web Extract

Para quién es esto: Negocios con necesidades limitadas de datos, especialistas en marketing e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: Easy Web Extract es un software visual de raspado web para fines comerciales. Puede extraer el contenido (texto, URL, imagen, archivos) de las páginas web y transformar los resultados en múltiples formatos.

15. FMiner

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: FMiner es un software de web scraping con un diseñador de diagramas visuales, y le permite construir un proyecto con una grabadora de macros sin codificación. La característica avanzada le permite raspar desde sitios web dinámicos usando Ajax y Javascript.

16. Scrapy

Para quién es esto: Desarrollador de Python con habilidades de programación y scraping

Por qué deberías usarlo: Scrapy se usa para desarrollar y construir una araña web. Lo bueno de este producto es que tiene una biblioteca de red asincrónica que le permitirá avanzar en la siguiente tarea antes de que finalice.

17. Helium Scrape

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: Helium Scraper es un software visual de scraping de datos web que funciona bastante bien, especialmente eficaz para elementos pequeños en el sitio web. Tiene una interfaz fácil de apuntar y hacer clic, lo que facilita su uso.

18. Scrape.it

Para quién es esto: Personas que necesitan datos escalables sin codificación.

Por qué deberías usarlo: Permite que los datos raspados se almacenen en tu disco local que autorizas. Puede crear un Scraper utilizando su lenguaje de web scraping (WSL), que tiene una curva de aprendizaje baja y no tiene que estudiar codificación. Es una buena opción y vale la pena intentarlo si está buscando una herramienta de web scraping segura.

19. ScraperWiki

Para quién es esto: Un entorno de análisis de datos Python y R, ideal para economistas, estadísticos y administradores de datos que son nuevos en la codificación.

Por qué deberías usarlo: Tiene dos partes dentro de la empresa. Uno es QuickCode, que está diseñado para economistas, estadísticos y administradores de datos con conocimiento del lenguaje Python y R. La segunda parte es The Sensible Code Company, que proporciona un servicio de datos web para convertir información desordenada en datos estructurados.

20. Scrapinghub

¿Para quién es esto?: Python/Desarrolladores de web scraping

Por qué debería usarlo: Scraping Hub es una plataforma web basada en la nube. Tiene cuatro tipos diferentes de herramientas: Scrapy Cloud, Portia, Crawlera y Splash. Es genial que Scrapinghub ofrezca una colección de direcciones IP cubiertas en más de 50 países, que es una solución para los problemas de prohibición de IP.

21. Screen-Scraper

Para quién es esto: Para los negocios se relaciona con la industria automotriz, médica, financiera y de comercio electrónico.

Por qué debería usarlo: Screen Scraper puede proporcionar servicios de datos web para las industrias automotriz, médica, financiera y de comercio electrónico. Es más conveniente y básico en comparación con otras herramientas de web scraping como Octoparse. También tiene un ciclo de aprendizaje corto para las personas que no tienen experiencia en el web scraping.

22. Salestools.io

Para quién es esto: Comercializador y ventas.

Por qué debería usarlo: Salestools.io proporciona un software de web scraping que ayuda a los vendedores a recopilar datos en redes profesionales como LinkedIn, Angellist, Viadeo.

23. ScrapeHero

¿Quién es este: Para inversores, Hedge Funds, Market Analyst es muy útil.

Por qué debería usarlo: ScrapeHero como proveedor de API le permite convertir sitios web en datos. Proporciona servicios de datos web personalizados para empresas y empresas.

24. UniPath

Para quién es esto: Negocios con todos los tamaños

Por qué debería usarlo: UiPath es un software de automatización de procesos robótico para el web scraping gratuito. Permite a los usuarios crear, implementar y administrar la automatización en los procesos comerciales. Es una gran opción para los usuarios de negocios, ya que te hace crear reglas para la gestión de datos.

25. Web Content Extractor

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: Web Content Extractor es un software de web scraping fácil de usar para fines privados o empresariales. Es muy fácil de aprender y dominar. Tiene una prueba gratuita de 14 días

26. Webharvy

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: WebHarvy es un software de web scraping de apuntar y hacer clic. Está diseñado para no programadores. El extractor no le permite programar. Tienen tutoriales de web scraping que son muy útiles para la mayoría de los usuarios principiantes.

27. Web Scraper.io

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: Web Scraper es una extensión de navegador Chrome creada para extraer datos de sitios web. Es un software gratuito de web scraping para raspar páginas web dinámicas.

28. Web Sundew

Para quién es esto: Empresas, comercializadores e investigadores.

Por qué debería usarlo: WebSundew es una herramienta de raspado visual que funciona para el raspado estructurado de datos web. La edición Enterprise le permite ejecutar el scraping en un servidor remoto y publicar los datos recopilados a través de FTP.

29. Winautomation

Para quién es esto: Desarrolladores, líderes de operaciones comerciales, profesionales de IT

Por qué debería usarlo: Winautomation es una herramienta de web scraping de Windows que le permite automatizar tareas de escritorio y basadas en la web.

30. Web Robots

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: Web Robots es una plataforma de web scraping basada en la nube para raspar sitios web dinámicos con mucho Javascript. Tiene una extensión de navegador web, así como un software de escritorio que es fácil para las personas para extraer datos de los sitios web.

#web scraping precios#cómo hhacer web scraping python#scraping mensaje#web scraping legal#web scraping javascript#scraper idealista#extraer datos de una web#scrab in linkedin

0 notes