#scraping mensaje

Explore tagged Tumblr posts

Text

Simple Scraping con Google Sheets (2020 actualizado)

Este herramienta de web scraping puede automatizar el proceso de copia y pegado repetitivos. En realidad, las hojas de Google pueden considerarse un web scraping básico. Puede usar una fórmula especial para extraer datos de una página web, importar los datos directamente a las hojas de Google y compartirlos con sus amigos.

En este artículo, primero le mostraré cómo construir un web scraping simple con Hojas de cálculo de Google. Luego lo compararé con Octoparse web scraping automático. Después de leerlo, tendrá una idea clara sobre qué método funcionaría mejor para sus necesidades específicas de web scraping.

Opción#1: Cree un web scraping sencillo con ImportXML en Google Spreadsheets

Paso 1: Abre una nueva hoja de Google.

Paso 2: Abra un sitio web de destino con Chrome. En este caso, elegimos ’Games sales’. Haga clic derecho en la página web y aparecerá un menú desplegable. Luego seleccione "inspeccionar". Presione una combinación de tres teclas: "Ctrl” + "Shift" + "C" para activar "Selector". Esto permitiría al panel de inspección obtener la información del elemento seleccionado dentro de la página web.

Paso 3: Copie y pegue la URL del sitio web en la hoja.

Opción#2: Intentemos obtener datos de precios con una fórmula simple: ImportXML

Paso 1: Copie el Xpath del elemento. Seleccione el elemento de precio y haga clic con el botón derecho para que aparezca el menú desplegable. Luego seleccione "Copiar", elija "Copiar XPath".

Paso 2: Escriba la fórmula en la hoja de cálculo.

=IMPORTXML(“URL”, “XPATH expression”)

Tenga en cuenta que la "expresión Xpath" es la que acabamos de copiar de Chrome. Reemplace la comilla doble "" dentro de la expresión Xpath con una comilla simple ''.

Opción#3: Hay otra fórmula que podemos usar:

=IMPORTHTML(“URL”, “QUERY”, Index)

Con esta fórmula, extraes toda la tabla.

Ahora, veamos cómo se puede lograr la misma tarea de raspado con un rastreador web, Octoparse.

Paso 1: Abra Octoparse, cree una nueva tarea seleccionando "+ Tarea" en el "Modo avanzado"

Paso 2: Elija su grupo de tareas preferido. Luego ingrese la URL del sitio web de destino y haga clic en "Guardar URL". En este caso: sitio web de Game Sale http://steamspy.com/

Paso 3: Aviso El sitio web de Game Sale se muestra en la sección de vista interactiva de Octoparse. Necesitamos crear una lista de bucles para que Octoparse revise los listados.

1. Haga clic en una fila de la tabla (podría ser cualquier archivo dentro de la tabla). Octoparse detectará elementos similares y los resaltará en rojo.

2. Necesitamos extraer por filas, así que elija "TR" (Fila de Tabla) desde el panel de control.

3. Después de seleccionar una fila, elija el comando "Seleccionar todos los subelementos" en el panel Consejos de acción. Elija el comando "Seleccionar todo" para seleccionar todas las filas de la tabla.

Paso 4: Elija "Extraer datos en el bucle" para extraer los datos.

Puede exportar los datos a Excel, CSV, TXT u otros formatos deseados. Las hojas de cálculo requieren que se copie y pegue, pero Octoparse automatiza el proceso. Además, Octoparse tiene más control sobre sitios web dinámicos con AJAX o reCaptcha.

Más recursos:

Create your first scraper with Octoparse [Video]

Los 20 mejores programas gratuitos de web scraping

Comparacion de las 5 mejores herramientas de web scraping

#Web scraping precios#scraping mensaje#como hacer web scraping con python#web scraping legal#web scraping javascript#scraper idealista#extraer datos de una web#correos electrónicos buscar#buscar personas por ccorreo electrónico#scrab in linkedin#Búsqueda de correos electrónicos#chrome scrab in

0 notes

Text

Publican base de datos con más de 480 millones de números de WhatsApp

New Post has been published on https://entretodos.com.mx/noticias/publican-base-de-datos-con-mas-de-480-millones-de-numeros-de-whatsapp/

Publican base de datos con más de 480 millones de números de WhatsApp

Redacción .- ESET, compañía líder en detección proactiva de amenazas, analiza la publicación para la venta en un conocido foro de hacking de una supuesta base de datos que contiene 487 millones de números de usuarios y usuarias de WhatsApp de 84 países diferentes.

Los números de WhatsApp publicados supuestamente pertenece a 45 millones de personas de Egipto, 35 millones de Italia, 32 millones de Estados Unidos, 29 millones de Arabia Saudita, 20 millones de Francia, 20 millones de Turquía y más de 11 millones de Estados Unidos.

De América Latina, la base de datos asegura contar con 2.3 millones de números de Argentina, 2.9 millones de Bolivia, 8 millones de Brasil, más de 17 millones de Colombia, más de 6 millones de Chile, 1.4 millones de Costa Rica, 13 millones de México, 10 millones de España y 1.5 millones de Uruguay. La publicación incluye una cuenta de Telegram para que los interesados se pongan en contacto. Según reveló Cybernews, el medio que dio a conocer esta publicación en el foro, investigadores analizaron una muestra que recibieron y confirmaron que son números de teléfono asociados a cuentas de WhatsApp activas.

“Los números de WhatsApp pueden ser utilizados por actores maliciosos para distribuir engaños o para lanzar ataques de phishing que busquen robar cuentas de WhatsApp, entre otras acciones.”, comenta Camilo Gutiérrez Amaya, Jefe del Laboratorio de Investigación de ESET Latinoamérica. “En el último tiempo hemos visto casos donde los estafadores intentaron robar el código de verificación para robar cuentas de WhatsApp utilizando excusas como un falso mensaje de soporte de WhatsApp, turno para las vacunas o incluso a través de mensajes que llegan repentinamente de números desconocidos solicitando el código de seis dígitos sin utilizar. Cuando se entrega el código de seis dígitos los cibercriminales toman el control de las cuentas de WhatsApp y se contactan con los contactos de la víctima para engañarlos y solicitar una transferencia por una urgencia o un imprevisto. Lamentablemente, muchas personas caen en la trampa y envían dinero a los delincuentes al no saber que sus contactos sufrieron el robo de sus cuentas”, agrega el especialista.

Por su parte, un vocero de Meta, la compañía propietaria de WhatsApp, desmintió que se trate de una filtración, ya que no hay evidencia de que Meta haya sufrido una filtración a sus sistemas. Además, desde Meta aseguran que están al tanto de la publicación que se realizó en el foro y que los números puestos a la venta no contienen información adicional de las personas.

Según la publicación realizada en el foro de hacking, el actor de amenaza afirma que los datos fueron recolectados mediante scraping. El web scraping es el uso de herramientas que permiten extraer y/o recolectar datos de sitios web y de esta manera crear una base de datos.

En el pasado se han visto varios casos de publicaciones de bases de datos con información de las personas que fueron recolectados mediante el scraping. Por ejemplo, cuando se publicaron a la venta datos de 1.500 millones de usuarios de Facebook o cuando se publicaron a la venta datos de 500 millones de usuarios de LinkedIn.

Desde ESET recomiendan a los usuarios estar atentas ante la posibilidad de recibir mensajes desde números desconocidos y bloquearlos ante la mínima sospecha.

Fuente/Reportero: Uniradio Noticias.

0 notes

Text

Procesos comunicacionales en las redes sociales

Las redes sociales se han vuelto cada vez más prominentes en los últimos años. Ahora parece que no podemos vivir sin ellas, pues es la forma principal por la que nos comunicamos hoy en dia. Cabe mencionar que las redes sociales ya no solo son plataformas donde podemos compartir nuestras ideas y tener conversaciones con amigos, ahora son todo un mundo donde las empresas pueden ofrecer, promocionar y vender sus productos. Un gran ejemplo de este caso es Instagram, esta red inició el año 2010 como una simple plataforma para compartir imágenes, pero con el tiempo y especialmente desde que fue adquirida por Facebook, esta red se parece cada vez más a una tienda, los negocios utilizan las herramientas de instagram para promocionar sus productos con la esperanza de llegar a una audiencia cada vez más grande y vender. Instagram implementa cada vez más publicidad, botones y funciones que solo tienen el objetivo de que los negocios obtengan más ventas. Esto va de la mano con el hecho de que la venta de información de los usuarios aumenta de forma innegable. Este es un fenómeno que está rodeado de discusión y controversia, sin embargo, escapar de él es casi imposible. Cada movimiento que hacemos en internet es utilizado para alimentar los datos que son acumulados y vendidos, con el objetivo de vender más cosas a los usuarios de las redes sociales.

En esta dinámica, el emisor resulta ser la red y el usuario, pues existe un constante intercambio de mensajes, los cuales vienen siendo, por parte del usuario: búsquedas, compras, conversaciones, etc. y por parte de la red: los productos y servicios que se ofrecen.

https://www.abc.net.au/triplej/programs/hack/a-brief-history-of-the-first-10-years-of-instagram/12731664

https://www.theguardian.com/technology/2020/may/03/how-instagram-changed-our-world

https://www.welivesecurity.com/la-es/2021/10/05/venden-datos-1-500-millones-usuarios-facebook-recopilados-mediante-scraping/

0 notes

Text

Facebook enfrenta una demanda de 'acción masiva' en Europa por incumplimiento de 2019

Nueva Noticia publicada en https://noticiasq.com/facebook-enfrenta-una-demanda-de-accion-masiva-en-europa-por-incumplimiento-de-2019/

Facebook enfrenta una demanda de 'acción masiva' en Europa por incumplimiento de 2019

Facebook será demandado en Europa por la importante filtración de datos de usuarios que se remonta a 2019, pero que solo salió a la luz recientemente después de que se encontró información sobre más de 533 millones de cuentas publicada para su descarga gratuita en un foro de piratas informáticos.

Hoy, Digital Rights Ireland (DRI) anunció que está comenzando una «acción masiva» para demandar a Facebook, citando el derecho a una compensación monetaria por violaciones de datos personales que se establece en el Reglamento General de Protección de Datos (GDPR) de la Unión Europea.

El artículo 82 del RGPD establece un «derecho a indemnización y responsabilidad» para los afectados por violaciones de la ley. Desde que entró en vigor el reglamento, en mayo de 2018, los litigios civiles relacionados han ido en aumento en la región.

El grupo de derechos digitales con sede en Irlanda está instando a los usuarios de Facebook que viven en la Unión Europea o en el Espacio Económico Europeo a verificar si sus datos fueron violados, a través del sitio web haveibeenpwned (que le permite verificar por dirección de correo electrónico o número de teléfono móvil), y registrarse en únete al caso si es así.

La información filtrada a través de la violación incluye las ID de Facebook, la ubicación, los números de teléfono móvil, la dirección de correo electrónico, el estado de la relación y el empleador.

Se ha contactado a Facebook para comentar sobre el litigio. Actualizar: Un portavoz de Facebook dijo:

Entendemos las preocupaciones de la gente, por eso continuamos fortaleciendo nuestros sistemas para hacer que el scraping de Facebook sin nuestro permiso sea más difícil y perseguir a las personas detrás de él. Como han demostrado LinkedIn y Clubhouse, ninguna empresa puede eliminar por completo el raspado o evitar que aparezcan conjuntos de datos como estos. Es por eso que dedicamos recursos sustanciales para combatirlo y continuaremos desarrollando nuestras capacidades para ayudarnos a adelantarnos a este desafío.

La sede europea del gigante tecnológico se encuentra en Irlanda y, a principios de esta semana, el organismo de control nacional de datos abrió una investigación, de conformidad con las leyes de protección de datos de la UE e Irlanda.

Un mecanismo en el GDPR para simplificar la investigación de casos transfronterizos significa que la Comisión de Protección de Datos (DPC) de Irlanda es el principal regulador de datos de Facebook en la UE. Sin embargo, ha sido criticado por su manejo y enfoque de las quejas e investigaciones de GDPR, incluido el tiempo que lleva emitir decisiones sobre los principales casos transfronterizos. Y esto es particularmente cierto para Facebook.

Con el tercer aniversario del GDPR acercándose rápidamente, el DPC tiene múltiples investigaciones abiertas sobre varios aspectos del negocio de Facebook, pero aún no ha emitido una sola decisión contra la empresa.

(Lo más cerca que ha llegado es una orden de suspensión preliminar emitida el año pasado, en relación con las transferencias de datos de la UE a los EE. UU. De Facebook. Sin embargo, esa queja es mucho anterior al GDPR; y Facebook presentó de inmediato para bloquear la orden a través de los tribunales. Se espera una resolución más adelante. año después de que el litigante interpusiera su propia revisión judicial de los procesos de la DPC).

Desde mayo de 2018, el régimen de protección de datos de la UE ha impuesto, al menos en papel, multas de hasta el 4% de la facturación anual global de una empresa por las infracciones más graves.

Una vez más, sin embargo, la única multa de GDPR emitida hasta la fecha por el DPC contra un gigante tecnológico (Twitter) está muy lejos de ese máximo teórico. En diciembre pasado, el regulador anunció una sanción de 450.000 € (~ 547.000 dólares) contra Twitter, lo que equivale a aproximadamente el 0,1% de los ingresos anuales de la empresa.

Esa sanción también fue por una violación de datos, pero una que, a diferencia de la filtración de Facebook, tenido se dio a conocer públicamente cuando Twitter lo encontró en 2019. Por lo tanto, el hecho de que Facebook no reveló la vulnerabilidad que descubrió y afirma que se solucionó en septiembre de 2019, lo que llevó a la filtración de 533 millones de cuentas ahora, sugiere que debería enfrentan una sanción más alta por parte del DPC que la que recibió Twitter.

Sin embargo, incluso si Facebook termina con una sanción más sustancial de GDPR por esta infracción, la carga de casos pendientes del organismo de control y el lento ritmo de los procedimientos hacen que sea difícil imaginar una resolución rápida para una investigación que solo tiene unos días de antigüedad.

A juzgar por el desempeño pasado, pasarán años antes de que el DPC decida sobre esta filtración de Facebook de 2019, lo que probablemente explica por qué el DRI ve valor en instigar un litigio al estilo de acción colectiva en paralelo a la investigación regulatoria.

“La compensación no es lo único que hace que valga la pena unirse a esta acción masiva. Es importante enviar un mensaje a los grandes controladores de datos de que deben cumplir con la ley y que tienen un costo si no lo hacen ”, escribe DRI en su sitio web.

También presentó una queja sobre la violación de Facebook a la DPC a principios de este mes, y escribió que «también estaba consultando con sus asesores legales sobre otras opciones, incluida una acción masiva por daños y perjuicios en los tribunales irlandeses».

Está claro que la brecha en la aplicación de GDPR está creando una oportunidad creciente para que los financiadores de litigios intervengan en Europa y apuesten por demandar por daños y perjuicios relacionados con los datos, con una serie de otras acciones masivas anunciadas el año pasado.

En el caso de DRI, su enfoque está evidentemente en buscar asegurar que se respeten los derechos digitales. Pero le dijo a RTE que cree que las reclamaciones de compensación que obligan a los gigantes tecnológicos a pagar dinero a los usuarios cuyos derechos de privacidad han sido violados es la mejor manera de hacerlos cumplir legalmente.

Mientras tanto, Facebook ha tratado de restar importancia a la violación que no reveló en 2019, alegando que se trata de «datos antiguos», una desviación que ignora el hecho de que las fechas de nacimiento de las personas no cambian (ni la mayoría de las personas cambian rutinariamente su número de teléfono móvil). o dirección de correo electrónico).

Muchos de los datos “antiguos” expuestos en esta última filtración masiva de Facebook serán muy útiles para que los spammers y estafadores apunten a los usuarios de Facebook, y ahora también para que los litigantes apunten a Facebook por daños relacionados con los datos.

0 notes

Text

Cómo instalar Seren en Kodi

En este tutorial vamos a ver cómo instalar el addon Seren en Kodi. Seren es un addon de nuevo aparición que todavía está en grado beta pero que promete mucho. Incluye una importante colección de películas y series, siendo una alternativa asaz buena a otros addons que van desapareciendo.

Acerca de Seren

Seren es un addon que se centra en las películas y en las series. Es muy parecido a Venom, su hermano, ya que los dos son del mismo creador. Seren soporta nada más enlaces Positivo Debrid y Premiunize, requiriendo los dos servicios una suscripción premium. Con estos servicios obtendrás enlaces de calidad y podrás descargarte contenidos a la longevo velocidad que soporte tu conexión. Sin retención, de entre estos dos servicios es más recomendable Positivo Debrid. Lo parte buena de los enlaces premium es que dan ciertas garantías y te evitan el arduo trabajo de tener que estar probando los enlaces hasta dar con el bueno, como ocurre con algunos addons.

La interfaz de Seren es muy simple e incluye pocas categorías, pero esto no quiere opinar que no incluya contenidos en riqueza. A continuación veremos cómo instalar Seren en Kodi y, seguidamente, veremos una folleto de uso y una serie de soluciones a los problemas más comunes con este addon.

Cómo instalar Seren en Kodi

Seren no es un addon oficial de Kodi, puesto que ha sido desarrollado por un tercero, siendo este el motivo de que sea necesario activar la opción de orígenes desconocidos en Kodi. Si no tienes la opción activada o si no estás seguro de ello, consulta la folleto para activar las fuentes de orígenes desconocidos en Kodi. Poco que todavía es más que recomendable es que tengas Kodi actualizado a su última lectura. Si no sabes cómo actualizarlo, consulta la folleto para modernizar Kodi.

Alerta! Utilizar ciertos addons de Kodi puede tener consecuencias legales. Los ISP escanean tu IP para identificar el streaming ilegal de contenidos, reduciendo la velocidad de tu conexión en dirección a ciertos servidores o enviando tu actividad a las autoridades.

Puedes evitarlo si ocultas tu IP con una VPN de modo que tu actividad sea totalmente privada. Tras probar la mayoría de los servicios VPN, la mejor VPN para Kodi resulta ser ExpressVPN.

Una vez te hayas asegurado de que la opción de orígenes desconocidos está activada, ya puedes proceder con la instalación de Seren siguiendo estos pasos:

Inicia Kodi y sitúate en la pantalla de inicio, desde donde debes hacer clic en el icono de Ajustes de la parte superior del menú principal, en el icono con forma de engranaje.

Haz clic en el explorador de archivos.

Haz clic en la opción Añadir fuente.

Haz doble clic en <Nadie> e introduce la URL https://ift.tt/2NMm1Ry, que es la URL del repositorio en el que está Seren.

Cuando introduzcas la URL haz clic en OK.

Introduce Venom como nombre de la fuente en el campo inferior. Seguidamente haz clic en OK.

Vuelve a situarte en la pantalla de inicio de Kodi y haz clic en Addons.

Haz clic en el icono que tiene una caja abierta que hay en la parte superior del menú principal para cascar el explorador del addons. Además puedes ceder a él desde la sección de Ajustes de Kodi.

Haz clic en la opción para instalar desde un archivo Zip.

En la serie de fuentes que se mostrará debes hacer clic en Venom.

Haz clic en el archivo repository.venom-x.x.x.zip. Las «x» representan la lectura del archivo del repositorio, por lo que pueden variar. El repositorio en el que está Seren se instalará cuando hagas clic en el archivo. Cuando la instalación del repositorio termine verás un mensaje de confirmación.

Ahora que está instalado el repositorio vamos a instalar el addon. Para ello, haz clic en instalar desde repositorio desde el explorador de addons

Haz clic en Venom Repo.

Seguidamente, haz clic en addons de vídeo.

Haz clic en Seren para ceder a la clarividencia previa del addon.

Por postrero, desde ha clarividencia previa del addon, haz clic en Instalar.

La instalación del addon dará aparición. Si se muestra un mensaje indicando que tienes que instalar todavía ciertas dependencias, acéptalo para continuar con la instalación.

Y con esto, Seren estará ya instalado. Para iniciar el addon, haz clic en Ejecutar desde su clarividencia previa.

Para iniciar Seren, vete a la sección de Addons de Kodi y haz clic en addons de vídeo. Seren debería aparecer en la serie de addons instalados.

Prontuario de entrada a Seren

Seren es un addon que se limita a utilizar enlaces premium mediante los servicios Premiunize y Positivo Debrid. De entre estos dos servicios, el más recomendable podríamos opinar que es Positivo Debrid, ya que adicionalmente de ser más rápido, dispone de fuentes de mejor calidad.

Configuración de Positivo Debrid en Seren

Antaño de utilizar este addon tendrás que crear una cuenta de Positivo Debrid. Para hacerlo, consulta cómo configurar Positivo Debrid en Kodi. Sin retención, todavía necesitarás que Seren tenga acercamiento patente a Positivo Debrid, cosa que se explica a continuación:

Antaño de comenzar, asegúrate de acaecer creado una cuenta de Positivo Debrid, en caso de que no la tuvieses. Luego, inicia Seren desde la sección de Addons de Kodi, interiormente del apartado de Addons de vídeo.

En Seren, haz clic en Tools (Herramientas).

Luego abre el menú de configuración haciendo clic en Open Settings Menu.

Selecciona la pestaña Scraping del menú de la izquierda.

Bajo la sección Add Un-Cached Sources to Debrid, selecciona Positivo Debrid como tu delimitación cloud preferida, en la opción Preferred Cloud Location.

Haz clic en la pestaña Cuentas y activa la opción Enable Positivo Debrid para activar Positivo Debrid.

En esta misma pestaña, haz clic en Authorize Positivo Debrid.

Seguidamente, verás un mensaje en el que se mostrará un código de autorización.

Debes introducir el código precedente en tu cuenta de Positivo Debrid para así autorizar el acercamiento de Seren. Para ello, accede a esta URL, introduce el código mostrado en Kodi y haz clic en Continuar. En caso de que no hayas accedido a tu cuenta de Positivo Debrid, se te pedirá que introduzcas tus credenciales de acercamiento.

Si todo va proporcionadamente, verás un mensaje de confirmación en Kodi indicando que la autenticación en Positivo Debrid se ha realizado correctamente.

Y con esto, ya habrás configurado Positivo Debrid en Seren.

Cómo utilizar Seren

Tras acaecer competente el acercamiento de Seren a tu cuenta de Positivo Debrid, ya podrás disfrutar de todas las secciones de Seren. En la pantalla principal verás una sección con películas y otra con series. Ambas secciones clasifican sus contenidos con las mismas categorías.

Podrás despabilarse contenidos por popularidad, año, artículos, votos de los usuarios y más. Cuando hagas clic en un enlace, Seren usará proporcionadamente Premiunize o proporcionadamente Positivo Debrid, dependiendo de la opción que hayas escogido. Seren es un addon muy rápido, por lo que podrás ver todos los enlaces casi al instante. Cuando hagas clic en uno de ellos, comenzará a reproducirse en streaming a la máxima velocidad que soporte tu conexión.

Opción de problemas de Seren

Seren no es un addon que venga con buscadores o providers de enlaces de serie. Esto se debe a que utiliza nada más enlaces Positivo Debrid y Premiunize. Sin retención, podría darse el caso de que Seren no encuentre contenidos a pesar de acaecer configurado estos servicios. Si esto ocurre, tendrás que juntar que juntar los providers de enlaces manualmente. Puedes hacerlo instalando sus paquetes correspondientes.

Para hacer esto, accede a la sección de Addons desde la pantalla de inicio de Kodi y haz clic en Addons de vídeo. Luego inicia Seren para iniciar el addon.

Lo que vamos a hacer es juntar dos providers o scrapers. Para juntar el primero de ellos, sigue estos pasos:

Haz clic en Tools (Herramientas).

Haz clic en Provider Tools (Herramientas de Providers).

Selecciona la opción Install Provider package (Instalar Paquete de Provider).

Haz clic en Web Location.

En el campo de texto que verás debes introducir la URL https://ift.tt/2reahfV y hacer clic en OK.

Haz clic en Install (Instalar).

Cuando se muestre el mensaje de confirmación, haz clic en OK.

Y con esto, ya está el primer scraper junto.

Una vez junto el primer scraper, vamos a juntar el segundo de ellos. Debes seguir exactamente los mismos pasos que para el precedente. Solo has de introducir una URL diferente:

Cuando introduzcas la URL del scraper, tienes que introducir la URL http://bit.ly/a4kScrapers y luego hacer clic en OK.

Cuando se muestre el mensaje de confirmación, haz clic en Install (Instalar).

Haz clic en OK cuando se muestre el mensaje diciendo que al instalación se ha completado.

Con esto, ya habrás junto los dos scrapers.

Estos pasos no garantizan que los enlaces vayan a funcionar. Seren es un addon muy nuevo, así que en caso de que no consigas que funcione correctamente, lo mejor es que pruebes el addon Venom, que es su mejor alternativa. Para ello, consulta la folleto de instalación de Venom en Kodi.

Alternativas a Seren

Seren es un addon que todavía está en grado de pruebas. Aunque debería funcionar correctamente con enlaces Positivo Debrid, siempre puedes carecer alguna alternativa. Positivo Debrid es nada más una de las muchas opciones de estos otros addons:

Si quieres ver más alternativas, consulta la serie con los mejores addons de Kodi. Para cualquier duda, puedes consultar la folleto definitiva de Kodi.

La entrada Cómo instalar Seren en Kodi se publicó primero en El rincon de diego.

Por El rincon de diego

0 notes

Photo

Thanks for all your messages and the 💕for this look. So here I give you the effect on both eyes/lips and yes you can use @marykayus to achieve it! (Substitute eye primer instead is lipstick on eyes). Gracias por todo los mensajes y me encanta que les guste este look de Halloween. Así es que les enseñó la versión con los labios y los ojos preparados de la misma manera!! 🎃#HALLOWEEN #grafittimakeup 💋 1-Apply a couple of coats of lipstick or gloss 2-Scrape off a little bit of product from any bright eyeshadows (cheek color works great too!) and mix all together on a small tray or plate 3- Dab the mix over the lipstick with a clean, porous sponge (I used a velcro roller) #themorethebetter #LABIOSPARAHALLOWEEN 💋 1- Aplica dos o mas capas de un labial o gloss (base de ojos) 2- Raspa pedacitos de cualquier sombra o rubor (tonos claros funcionan mejor!) y mezclalos en un platito 3- Aplica la mezcla sobre los labios con una esponja porosa limpia (como las de la cocina) :) #luiscasco #luiscascomakeup #halloweeninspo #getinspired #inspirate #halloweenmakeup lip 📷@Giulianobekor

#labiosparahalloween#luiscasco#halloweeninspo#luiscascomakeup#inspirate#halloweenmakeup#getinspired#themorethebetter#halloween#grafittimakeup

0 notes

Photo

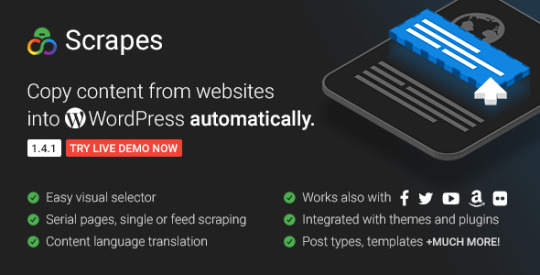

Scrapes v1.4.1 – Contenido web automático Robot automático para el contenido web, y un plugin para WordPress mensajes automáticos Plugin que automáticamente copia el contenido de un sitio web a su sitio una o más veces en los intervalos de tiempo seleccionados. Es muy simple de usar, no requiere ningún conocimiento de programación y... -

#AliExpress#Amazon#auto Amazon#Autoblog#Automaticamente#Automático robot#Envato Auto objetos#plug-in#plugin#plugin gratuito#plugin nulled#Respuestas automáticas Facebook#Twitter#WooCommerce#wordpress#wordpress plugin

0 notes

Photo

THE NINTH HOUR LATIN AMERICAN TOUR EMPIEZA POR CASA

Interview available also in English

Con motivo de los dos shows que estarán dando los finlandeses de Sonata Arctica en nuestro país, uno en Rosario y otro en la ciudad de Buenos Aires, hace poco tuvimos la oportunidad de cruzar unas palabras con Henrik Klingerberg, tecladista de la banda, quien nos habló acerca del último disco, la gira que estarán haciendo por Latinoamérica y principalmente, acerca de la llegada del grupo por primera vez a tierras rosarinas.

MSM: «The Ninth Hour» es su último y más reciente álbum. Si hubiera nuevos fans que descubrieran la banda escuchando tan sólo este disco, ¿cómo creen que los presentaría, el nuevo álbum, a la banda? ¿Qué representa «The Ninth Hour» en la carrera musical de la banda?

Henrik: Probablemente yo iría por “White Pearl, Black Oceans”, ya que son canciones que contienen muchos de los elementos que usamos en nuestra música. Está claro que «The Ninth Hour» es sólo una pieza en lo que es el “rompecabezas Sonata Arctica”, y que más piezas van a llegar, y más piezas han estado ahí desde el inicio, así que es muy difícil elegir solamente una canción o un álbum si querés presentarle la banda a alguien.

MSM: “The Ninth Hour” is your latest and newest album. If new fans just discover the band and first listen to this album, how would you introduce to them the band through it? What does “The Ninth Hour” represent to Sonata Arctica’s lifetime?

Henrik: I’d probably turn on “White Pearl, Black Oceans” since that song has most of the elements that we use in our music. Of course “The Ninth Hour” is just one piece in the Sonata Arctica puzzle and more pieces will come and more pieces have been there from the start so it’s really hard to just pick one song or one album if you want to introduce the band to someone.

MSM: A primera vista, cuando alguien ve la tapa del disco, parece decir algo acerca de los humanos, la tecnología y la naturaleza en perfecto balance y armonía, pero sólo algunas canciones explotan ese mismo tono. ¿Por qué decidieron mezclar distintos temas y conectar las canciones con historias de álbumes previos? Por ejemplo, a todos nos encantó el segundo capítulo de White Pearl, Black Oceans.

Henrik: El arte de tapa va a la par de algunas canciones, hablando de la naturaleza y demás. El resto del álbum tiene una variedad de temas con toda clase de historias sucediendo al mismo tiempo. WPBO parte 2 era una gran canción para hacer, por supuesto, y teníamos que ser cuidadosos de no arruinarla, por la importancia que tiene la primera parte en nuestro repertorio.

MSM: At first sight when you contemplate the artwork it seems to tell something about humans, technology and nature in perfect balance and harmony, but only a few songs scrape the same subject. So, why to mix up different topics and connect the songs with stories from previous albums? For example, we all love the second chapter of “White Pearl, Black Oceans”.

Henrik: The artwork goes together with a couple of songs, dealing with nature stuff; the rest of the album has a variety of topics with all kinds of stories going on. WPBO part 2 was of course a big song to make and we had to be careful not to mess it up because the first part is such an important piece in the Sonata Arctica catalog.

MSM: ¿Qué fue lo más desafiante de este álbum?

Henrik: Poder mantener las fechas de entrega al día fue probablemente lo más desafiante. Obviamente, hubo ciertas cosas que eran más difíciles de aprender a tocar que otras, pero nada particularmente imposible esta vez.

MSM: What was the most challenging thing on this album?

Henrik: Trying to keep the deadlines was probably the most challenging thing. There was of course some stuff that was harder to learn how to play than others but nothing really impossible this time.

youtube

MSM: ¡El cover de Bryan Adams es realmente fantástico! Sonata Arctica siempre se las ingenia para tocar canciones de los 80s de una manera perfecta. ¡También la canción “I Can’t Dance”, de Génesis es increíble! ¿Por qué se desafían a ustedes mismos con estas canciones? ¿Podríamos esperar algún cover de Abba o de Queen hecho por Sonata Arctica, quizás?

Henrik: Creo que se puede esperar cualquier cosa, jaja. Estábamos hablando acerca de hacer algún cover, y un día en el estudio se nos ocurrió esto, lo grabamos y eso fue básicamente todo. Personalmente, no disfruto tanto de hacer covers, prefiero invertir mi tiempo haciendo música original, pero de vez en cuando es divertido hacer un cover sólo por hacerlo.

MSM: Bryan Adam’s cover is truly fantastic! Sonata Arctica always fits perfect to perform 80’s songs. Also “I Can’t Dance” originally from Genesis is amazing! Tell us why to challenge yourself with those songs? Could we expect a Queen or Abba cover, by Sonata Arctica, maybe?

Henrik: I think you can expect anything, haha. We were talking about doing a cover and one day in the studio we came up with this, recorded it straight away and that was basically it. Personally I don’t like to do covers that much, I rather spend my time doing original music but every once in a while it’s fun to just do a cover just for the hell of it.

MSM: Pasar por Latinoamérica en sus tours ya es algo obligatorio para la banda. ¿Cómo se siente volver a la Argentina y tocar en otra ciudad

Henrik: Es realmente genial volver, ya que los fans en Argentina siempre nos han recibido con los brazos abiertos, y empezar el tour ahí es perfecto para nosotros… además, tener una nueva ciudad en el mapa de los lugares visitados es algo extra, va a ser interesante ver cómo es todo.

MSM: Touring over Latin America is already a MUST for the band. How does it feel to come back to Argentina and to play in another city?

Henrik: It’s really great to come back since the fans in Argentina have always been very welcoming to us and to start the tour there is just perfect… and to get a new city on the “map of places we’ve been” is a nice bonus, it will be interesting to see what it’s like.

youtube

MSM: En todas nuestras entrevistas tenemos una sección llamada “Until Your Last Breath”, en la que le pedimos a los músicos que nos digan cuáles son los 5 álbumes que la gente tiene que escuchar antes de morir. ¿Nos podrían decir cuáles serían para ustedes esos 5 discos?

MSM: In all our interviews we have a section called 'Until Your Last Breath” where we ask the musicians about the 5 albums people should listen to before they die. Would you like to share with us your top five?

Henrik: ¡Claro! Sin ningún orden en particular / Sure thing: in no particular order:

- Lana del Rey / Born to Die

- Ghost / Meliora

- Pantera / The Great Southern Trendkill

- Frank Zappa / Jazz from Hell

- Metallica / Master of Puppets

MSM: Para cerrar esta entrevista, ¿algún mensaje especial para todos los fans de Sonata Arctica?

Henrik: Venimos haciendo esto desde hace un largo tiempo, y hoy seguimos viajando por el mundo, dando shows y haciendo música nueva… todo esto es gracias a ustedes. ¡Muchísimas gracias por el apoyo y nos vemos allá! ¡Saludos!

MSM: To conclude this interview, any special message to all the Sonata Arctica fans out there?

Henrik: We’ve been doing this for a long time and we’re still traveling the world playing shows and making new music… this is all because of YOU. Thanks a lot for the support and see you out there! Cheers!

MSM: Gracias por su tiempo y nos vemos pronto en nuestra ciudad, Rosario. ¡Saludos!

MSM: Thank you for your time and see you soon in our city, Rosario! Cheers!

Entrevista: Brenda S. Rivero Traducción: Elías Gómez Edición: Julieta Iglesias Corrección: Romina Ordazzo

¡No te pierdas ninguno de los shows de Sonata Arctica en Argentina! Jueves 4 de mayo de 2017 - Teatro Vorterix ROSARIO

Entradas en venta en: https://www.allaccess.com.ar/event/sonata-arctica-en-rosario

Viernes 5 de mayo - Teatro Vorterix BUENOS AIRES

Entradas en venta en: https://www.allaccess.com.ar/event/sonata-arctica

#sonataarctica#argentina#buenosaires#rosario#theninthhourtour#latinamerica#gigs#international#teatrovorterix#msm#entrevistas#interview

0 notes

Link

¿Cómo puede descargar imágenes de enlaces de forma gratuita en lote?

Para descargar la imagen del enlace, es posible que desee buscar en "Descargadores de imágenes a granel". Inspirado por las consultas recibidas, decidí hacer una lista de "los 5 mejores descargadores de imágenes masivas" para usted. Asegúrese de consultar este artículo Si desea descargar imágenes del enlace sin costo. (Si no está seguro de cómo extraer las URL de las imágenes, consulte esto: Cómo construir un rastreador de imágenes sin codificación)

#Web scraping precios#scraping mensaje#como hacer web scraping con python#web scraping legal#web scraping javascript#scraper idealista#extraer datos de una web#correos electrónicos buscar#buscar personas por ccorreo electrónico#scrab in linkedin#Búsqueda de correos electrónicos#chrome scrab in#web scraping software#crawly web scraper

0 notes

Text

Los 30 Mejores Software de Web Scraping Gratis en 2020

El Web scraping (también denominado extracción de datos web, web crawler, captura de pantalla o recolección web) es una técnica web para extraer datos de los sitios web. Convierte datos no estructurados en datos estructurados que pueden almacenarse en su computadora local o en una base de datos.

Puede ser difícil crear un web scraping para personas que no saben nada sobre codificación. Afortunadamente, hay herramientas disponibles tanto para personas que tienen o no habilidades de programación. Aquí está nuestra lista de las 30 herramientas de web scraping más populares, desde bibliotecas de código abierto hasta extensiones de navegador y software de escritorio.

1. Beautiful Soup

¿Para quién es esto?: desarrolladores que dominan la programación para crear un web scraping/web crawler para rastrear los sitios web.

Por qué deberías usarlo:Beautiful Soup es una biblioteca de Python de código abierto diseñada para scrape archivos HTML y XML. Son los principales analizadores de Python que se han utilizado ampliamente. Si tiene habilidades de programación, funciona mejor cuando combina esta biblioteca con Python.

2. Octoparse

¿Cómo hacer web scraping?: Las empresas o las personas tienen la necesidad de extraer datos de la web: comercio electrónico, inversión, criptomoneda, marketing, bienes raíces, etc. Este software no requiere habilidades de programación y codificación.

Por qué debería usarlo: Octoparse es una plataforma de datos web SaaS gratuita de por vida. Puede usar para raspar datos web y convertir datos no estructurados o semiestructurados de sitios web en un conjunto de datos estructurados sin codificación. También proporciona task templates para usar, como eBay, Twitter, BestBuy y muchas otras. Octoparse también proporciona servicio de datos web. Puede personalizar el tarea scraper según sus necesidades de raspado.

3. Import.io

Para quién es esto: Empresa que busca una solución de integración en datos web.

Por qué debería usarlo: Import.io es una plataforma de datos web SaaS. Proporciona un software de web scraping que le permite raspar datos de sitios web y organizarlos en conjuntos de datos. Pueden integrar los datos web en herramientas analíticas para ventas y marketing para obtener información.

4. Mozenda

Para quién es esto: Empresas y negocios hay necesidades de fluctuantes de datos/datos en tiempo real.

Por qué debería usarlo: Mozenda proporciona una herramienta de extracción de datos que facilita la captura de contenido de la web. También proporcionan servicios de visualización de datos. Elimina la necesidad de contratar a un analista de datos.

5. Parsehub

Para quién es esto: analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: ParseHub es un software visual de web scrapinng que puede usar para obtener datos de la web. Puede extraer los datos haciendo clic en cualquier campo del sitio web. También tiene una rotación de IP que ayudaría a cambiar su dirección IP cuando se encuentre con sitios web agresivos con una técnica anti-raspado.

6. Crawlmonster

Para quién es esto: SEO y especialistas en marketing

Por qué deberías usarlo: CrawlMonster es un software gratuito de web scraping. Le permite escanear sitios web y analizar el contenido de su sitio web, el código fuente, el estado de la página y muchos otros.

7. Connotate

Para quién es esto: Empresa que busca una solución de integración en datos web.

Por qué debería usarlo: Connotate ha estado trabajando junto con Import.IO, que proporciona una solución para automatizar el scraping de datos web. Proporciona un servicio de datos web que puede ayudarlo a raspar, recopilar y manejar los datos.

8. Common Crawl

Para quién es esto: Investigador, estudiantes y profesores.

Por qué deberías usarlo: Common Crawl se basa en la idea del código abierto en la era digital. Proporciona conjuntos de datos abiertos de sitios web rastreados. Contiene datos sin procesar de la página web, metadatos extraídos y extracciones de texto.

9. Crawly

Para quién es esto: Personas con requisitos de datos básicos sin hababilidad de codificación.

Por qué debería usarlo: Crawly proporciona un servicio automático que raspa un sitio web y lo convierte en datos estructurados en forma de JSON o CSV. Pueden extraer elementos limitados en segundos, lo que incluye: Texto del título. HTML, comentarios, etiquetas de fecha y entidad, autor, URL de imágenes, videos, editor y país.

10. Content Grabber

Para quién es esto: Desarrolladores de Python que son expertos en programación.

Por qué debería usarlo: Content Grabber es un software de web scraping dirigido a empresas. Puede crear sus propios agentes de web scraping con sus herramientas integradas de terceros. Es muy flexible en el manejo de sitios web complejos y extracción de datos.

11. Diffbot

Para quién es esto: Desarrolladores y empresas.

Por qué debería usarlo: Diffbot es una herramienta de web scraping que utiliza aprendizaje automático y algoritmos y API públicas para extraer datos de páginas web (web scraping). Puede usar Diffbot para el análisis de la competencia, el monitoreo de precios, analizar el comportamiento del consumidor y muchos más.

12. Dexi.io

Para quién es esto: Personas con habilidades de programación y cotificación.

Por qué deberías usarlo: Dexi.io es un rastreador web basado en navegador. Proporciona tres tipos de robots: extractor, rastreador y tuberías. PIPES tiene una función de robot maestro donde 1 robot puede controlar múltiples tareas. Admite muchos servicios de terceros (solucionadores de captcha, almacenamiento en la nube, etc.) que puede integrar fácilmente en sus robots.

13. DataScraping.co

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: Data Scraping Studio es un software gratuito de raspado web para recolectar datos de páginas web, HTML, XML y pdf. Actualmente, el cliente de escritorio solo está disponible para Windows.

14. Easy Web Extract

Para quién es esto: Negocios con necesidades limitadas de datos, especialistas en marketing e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: Easy Web Extract es un software visual de raspado web para fines comerciales. Puede extraer el contenido (texto, URL, imagen, archivos) de las páginas web y transformar los resultados en múltiples formatos.

15. FMiner

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: FMiner es un software de web scraping con un diseñador de diagramas visuales, y le permite construir un proyecto con una grabadora de macros sin codificación. La característica avanzada le permite raspar desde sitios web dinámicos usando Ajax y Javascript.

16. Scrapy

Para quién es esto: Desarrollador de Python con habilidades de programación y scraping

Por qué deberías usarlo: Scrapy se usa para desarrollar y construir una araña web. Lo bueno de este producto es que tiene una biblioteca de red asincrónica que le permitirá avanzar en la siguiente tarea antes de que finalice.

17. Helium Scrape

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: Helium Scraper es un software visual de scraping de datos web que funciona bastante bien, especialmente eficaz para elementos pequeños en el sitio web. Tiene una interfaz fácil de apuntar y hacer clic, lo que facilita su uso.

18. Scrape.it

Para quién es esto: Personas que necesitan datos escalables sin codificación.

Por qué deberías usarlo: Permite que los datos raspados se almacenen en tu disco local que autorizas. Puede crear un Scraper utilizando su lenguaje de web scraping (WSL), que tiene una curva de aprendizaje baja y no tiene que estudiar codificación. Es una buena opción y vale la pena intentarlo si está buscando una herramienta de web scraping segura.

19. ScraperWiki

Para quién es esto: Un entorno de análisis de datos Python y R, ideal para economistas, estadísticos y administradores de datos que son nuevos en la codificación.

Por qué deberías usarlo: Tiene dos partes dentro de la empresa. Uno es QuickCode, que está diseñado para economistas, estadísticos y administradores de datos con conocimiento del lenguaje Python y R. La segunda parte es The Sensible Code Company, que proporciona un servicio de datos web para convertir información desordenada en datos estructurados.

20. Scrapinghub

¿Para quién es esto?: Python/Desarrolladores de web scraping

Por qué debería usarlo: Scraping Hub es una plataforma web basada en la nube. Tiene cuatro tipos diferentes de herramientas: Scrapy Cloud, Portia, Crawlera y Splash. Es genial que Scrapinghub ofrezca una colección de direcciones IP cubiertas en más de 50 países, que es una solución para los problemas de prohibición de IP.

21. Screen-Scraper

Para quién es esto: Para los negocios se relaciona con la industria automotriz, médica, financiera y de comercio electrónico.

Por qué debería usarlo: Screen Scraper puede proporcionar servicios de datos web para las industrias automotriz, médica, financiera y de comercio electrónico. Es más conveniente y básico en comparación con otras herramientas de web scraping como Octoparse. También tiene un ciclo de aprendizaje corto para las personas que no tienen experiencia en el web scraping.

22. Salestools.io

Para quién es esto: Comercializador y ventas.

Por qué debería usarlo: Salestools.io proporciona un software de web scraping que ayuda a los vendedores a recopilar datos en redes profesionales como LinkedIn, Angellist, Viadeo.

23. ScrapeHero

¿Quién es este: Para inversores, Hedge Funds, Market Analyst es muy útil.

Por qué debería usarlo: ScrapeHero como proveedor de API le permite convertir sitios web en datos. Proporciona servicios de datos web personalizados para empresas y empresas.

24. UniPath

Para quién es esto: Negocios con todos los tamaños

Por qué debería usarlo: UiPath es un software de automatización de procesos robótico para el web scraping gratuito. Permite a los usuarios crear, implementar y administrar la automatización en los procesos comerciales. Es una gran opción para los usuarios de negocios, ya que te hace crear reglas para la gestión de datos.

25. Web Content Extractor

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: Web Content Extractor es un software de web scraping fácil de usar para fines privados o empresariales. Es muy fácil de aprender y dominar. Tiene una prueba gratuita de 14 días

26. Webharvy

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: WebHarvy es un software de web scraping de apuntar y hacer clic. Está diseñado para no programadores. El extractor no le permite programar. Tienen tutoriales de web scraping que son muy útiles para la mayoría de los usuarios principiantes.

27. Web Scraper.io

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: Web Scraper es una extensión de navegador Chrome creada para extraer datos de sitios web. Es un software gratuito de web scraping para raspar páginas web dinámicas.

28. Web Sundew

Para quién es esto: Empresas, comercializadores e investigadores.

Por qué debería usarlo: WebSundew es una herramienta de raspado visual que funciona para el raspado estructurado de datos web. La edición Enterprise le permite ejecutar el scraping en un servidor remoto y publicar los datos recopilados a través de FTP.

29. Winautomation

Para quién es esto: Desarrolladores, líderes de operaciones comerciales, profesionales de IT

Por qué debería usarlo: Winautomation es una herramienta de web scraping de Windows que le permite automatizar tareas de escritorio y basadas en la web.

30. Web Robots

Para quién es esto: Analista de datos, comercializadores e investigadores que carecen de habilidades de programación.

Por qué debería usarlo: Web Robots es una plataforma de web scraping basada en la nube para raspar sitios web dinámicos con mucho Javascript. Tiene una extensión de navegador web, así como un software de escritorio que es fácil para las personas para extraer datos de los sitios web.

#web scraping precios#cómo hhacer web scraping python#scraping mensaje#web scraping legal#web scraping javascript#scraper idealista#extraer datos de una web#scrab in linkedin

0 notes

Text

Scrapes v1.4.1 - Contenido web automático

New Post on http://wp.pulsing.org/es/scrapes-v1-4-1/

Scrapes v1.4.1 - Contenido web automático

Robot automático para el contenido web, y un plugin para WordPress mensajes automáticos Plugin que automáticamente copia el contenido de un sitio web a su sitio una o más veces en los intervalos de tiempo seleccionados. Es muy simple de usar, no requiere ningún conocimiento de programación y...

#AliExpress#Amazon#auto Amazon#autoblog#Automáticamente#Automático robot#Envato Auto objetos#plug-in#plugin#plugin gratuito#plugin nulled#Respuestas automáticas Facebook#Twitter#WooCommerce#wordpress#wordpress plugin

0 notes