#ReLU

Explore tagged Tumblr posts

Text

Merkara and Relu are in Stardew Valley now. I found this character creator and couldn't resist. Already decided that Merkara is a rogue magician, she's here to cause mischief and steal some artifacts. And Relu is a doctor, he used to work in a war zone and escaped to a small town to heal from his traumatizing experience

58 notes

·

View notes

Text

youtube

Dream-Colored Magician by Relu feat. IA

9 notes

·

View notes

Text

New profile pic! I can't remember if I ever shared this lovely @moosopp-art commission here but this is my darling Relu

#dnd character#dnd oc#retiring oneki because the campaign is over and she's retiring to wander the world with a drow#a baby#and a de-godified demi god#Do not be concerned about the beaker in her hand#She is a healer#Mostly#relu

2 notes

·

View notes

Text

Activation function progress in deep learning, Relu, Elu, Selu, Geli , mish, etc - include table and graphs - day 24

Activation Function Formula Comparison Why (Problem and Solution) Mathematical Explanation and Proof Sigmoid \(\sigma(z) = \frac{1}{1 + e^{-z}}\) – Non-zero-centered output – Saturates for large values, leading to vanishing gradients Problem: Vanishing gradients for large positive or negative inputs, slowing down learning in deep networks. Solution: ReLU was introduced to avoid the saturation…

#activation function#activation function types#Elu#gelu activation function#mish activation function#relu#Selu activation function

0 notes

Text

ReLU Activation Function: A Powerful Tool in Deep Learning

Introduction

In the vast field of deep learning, activation functions play a crucial role in determining the output of a neural network. One popular activation function is the Rectified Linear Unit (ReLU). In this article, we will delve into the details of the ReLU activation function, its benefits, and its applications in the realm of artificial intelligence.

Table of Contents

What is an Activation Function?

Understanding ReLU Activation

2.1 Definition of ReLU

2.2 How ReLU Works

2.3 Mathematical Representation

Advantages of ReLU

3.1 Simplicity and Efficiency

3.2 Addressing the Vanishing Gradient Problem

3.3 Non-linear Transformation

ReLU in Practice

4.1 ReLU in Convolutional Neural Networks

4.2 ReLU in Recurrent Neural Networks

4.3 ReLU in Generative Adversarial Networks

Limitations of ReLU

5.1 Dead ReLU Problem

5.2 Gradient Descent Variants

Conclusion

FAQs

7.1 How does ReLU differ from other activation functions?

7.2 Can ReLU be used in all layers of a neural network?

7.3 What are the alternatives to ReLU?

7.4 Does ReLU have any impact on model performance?

7.5 Can ReLU be used in regression tasks?

1. What is an Activation Function?

Before diving into the specifics of ReLU, it's essential to understand the concept of an activation function. An activation function introduces non-linearity into the output of a neuron, enabling neural networks to learn complex patterns and make accurate predictions. It determines whether a neuron should be activated or not based on the input it receives.

2. Understanding ReLU Activation

2.1 Definition of ReLU

ReLU, short for Rectified Linear Unit, is an activation function that maps any negative input value to zero and passes positive input values as they are. In other words, ReLU outputs zero if the input is negative and the input value itself if it is positive.

2.2 How ReLU Works

ReLU is a simple yet powerful activation function that contributes to the success of deep learning models. It acts as a threshold function, allowing the network to activate specific neurons and discard others. By discarding negative values, ReLU introduces sparsity, which helps the network focus on relevant features and enhances computational efficiency.

2.3 Mathematical Representation

Mathematically, ReLU can be defined as follows:

scssCopy code

f(x) = max(0, x)

where x represents the input to the activation function, and max(0, x) returns the maximum value between zero and x.

3. Advantages of ReLU

ReLU offers several advantages that contribute to its widespread use in deep learning models. Let's explore some of these benefits:

3.1 Simplicity and Efficiency

ReLU's simplicity makes it computationally efficient, allowing neural networks to process large amounts of data quickly. The function only involves a simple threshold operation, making it easy to implement and compute.

3.2 Addressing the Vanishing Gradient Problem

One significant challenge in training deep neural networks is the vanishing gradient problem. Activation functions such as sigmoid and tanh tend to saturate, resulting in gradients close to zero. ReLU helps alleviate this issue by preserving gradients for positive inputs, enabling effective backpropagation and faster convergence.

3.3 Non-linear Transformation

ReLU introduces non-linearity, enabling the network to learn complex relationships between inputs and outputs. Its ability to model non-linear transformations makes it suitable for a wide range of tasks, including image and speech recognition, natural language processing, and more.

4. ReLU in Practice

ReLU finds applications in various deep learning architectures. Let's explore how ReLU is used in different types of neural networks:

4.1 ReLU in Convolutional Neural Networks

Convolutional Neural Networks (CNNs) excel in image classification tasks. ReLU is commonly used as the activation function in CNNs because of its ability to capture and enhance relevant features within images.

4.2 ReLU in Recurrent Neural Networks

Recurrent Neural Networks (RNNs) are widely used in sequential data processing, such as language modeling and speech recognition. ReLU's non-linearity helps RNNs learn long-term dependencies in sequential data, leading to improved performance.

4.3 ReLU in Generative Adversarial Networks

Generative Adversarial Networks (GANs) are used for tasks such as image synthesis and style transfer. ReLU activation is often employed in the generator network of GANs to introduce non-linearity and improve the quality of generated samples.

5. Limitations of ReLU

While ReLU offers significant advantages, it also has some limitations that researchers and practitioners should be aware of:

5.1 Dead ReLU Problem

In certain scenarios, ReLU neurons can become "dead" and cease to activate. When a neuron's weights and biases are set in such a way that the output is always negative, the gradient during backpropagation becomes zero, rendering the neuron inactive. This issue can be addressed by using variants of ReLU, such as Leaky ReLU or Parametric ReLU.

5.2 Gradient Descent Variants

Some variants of gradient descent, such as the second-order methods, may not perform well with ReLU activation due to its non-differentiability at zero. Proper initialization techniques and learning rate schedules should be employed to mitigate these issues.

6. Conclusion

ReLU has emerged as a fundamental building block in deep learning models, offering simplicity, efficiency, and non-linearity. Its ability to address the vanishing gradient problem and its successful application across various neural network architectures make it an indispensable tool in the field of artificial intelligence.

FAQs

7.1 How does ReLU differ from other activation functions?

ReLU differs from other activation functions by transforming negative inputs to zero, while allowing positive inputs to pass unchanged. This characteristic enables ReLU to introduce sparsity and preserve gradients during backpropagation.

7.2 Can ReLU be used in all layers of a neural network?

ReLU can be used in most layers of a neural network. However, it is advisable to avoid ReLU in the output layer for tasks that involve predicting negative values. In such cases, alternative activation functions like sigmoid or softmax are typically used.

7.3 What are the alternatives to ReLU?

Some popular alternatives to ReLU include Leaky ReLU, Parametric ReLU (PReLU), and Exponential Linear Unit (ELU). These variants address the dead ReLU problem and introduce improvements in terms of the overall performance of the neural network.

7.4 Does ReLU have any impact on model performance?

ReLU can have a significant impact on model performance. By promoting sparsity and non-linearity, ReLU aids in capturing complex patterns and improving the network's ability to learn and generalize.

7.5 Can ReLU be used in regression tasks?

ReLU can be used in regression tasks; however, it is crucial to consider the nature of the target variable. If the target variable includes negative values, ReLU might not be suitable, and alternative activation functions should be explored.

0 notes

Text

i drew red x blue for a friend OH YEAHF!!!

#alan becker#animator vs animation#stickman#drawing#art#animation vs minecraft#my art#relue#red x blue#blue x red

22 notes

·

View notes

Text

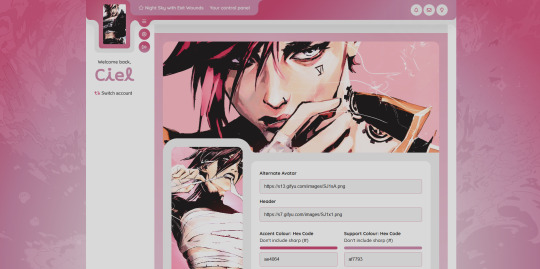

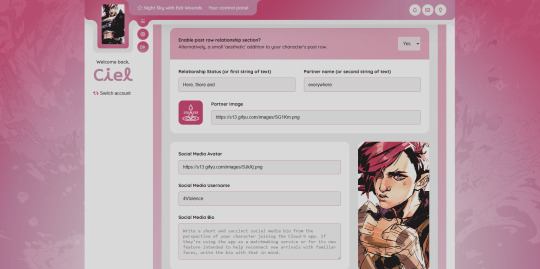

Updated preview of the UCP rework (featuring the 'post row' section, spanning across the three custom post rows I've created for the overall board, social media row, and stationary/written letters row).

The only image a member needs for the skin to be functional is their uploaded avatar, everything else has been designed to be 100% optional.

#The scripts here are a combination of Relu's and things I've hack/slashed together#and are definitely not optimized. I have a vague idea of what I'd like to do differently for release.#jcink skin

34 notes

·

View notes

Text

La Prophétie de l'Ambre (tome 1), Carina Rozenfeld

Dans l'Empire d'Iyastraïa, chaque individu reçoit dès la naissance un sceau qui guidera son existence. Seuls les empereurs de la lignée du Phénix peuvent le transmettre à leurs successeurs, qui héritent ainsi du savoir – et des tourments – des générations passées.

Les soeurs du Secret Fécond qui ont appris à Ashaïa à maîtriser les sceaux ont toutes été massacrées sur ordre de l'empereur. Unique rescapée, la jeune fille n'a alors plus qu'une raison de vivre : tuer cet assassin. Mais celui-ci meurt avant qu'elle n'y parvienne. Ce sera donc son héritier, le prince Zaa'hir, qui subira sa vengeance. Celui qui n'a jamais désiré régner vient en effet de recevoir le sceau impérial, à travers lequel les voix de ses ancêtres lui soufflent une prophétie annonçant la fin de sa lignée maudite. Se pourrait-il qu'Ashaïa soit l'instrument d'une destinée implacable qui fera de Zaa'hir le dernier Phénix ?

Attention, j'espère que vous avez de l'eau pas loin parce que ça va être très salé :

Alors déjà, le résumé est hyper mensonger. Si Ashaïa pense à tuer Zaa'hir pendant plus d'une ligne c'est le bout du monde. Dès qu'elle apprend que son père est mort elle se dit qu'elle va pas faire payer au fils les fautes du père, même si elle a aucune affection ni aucun respect pour lui. Du coup j'ai été extrêmement déçue

Elle décide de se rendre à la capitale et d'entrer au palais en tant que servante parce qu'elle pense qu'elle va fouiner et trouver pourquoi l'empereur a fait massacrer ses deux familles (de sang et adoptive). Sauf qu'en fait elle le mentionne une fois, et qu'à côté on passe des pages et des pages à nous rappeler que tous les gens qu'elle aimait sont morts dans d'atroces souffrances etc etc, qu'elle est triste et en colère. Du coup au bout d'un moment j'avais oublié pourquoi elle allait au palais si elle avait aucune envie de croiser le fils de l'empereur décédé. C'était vraiment un gros point noir de ce livre, on nous répète TOUT LE TEMPS les choses en BOUCLE. Y'avait des fois où sur une seule page y'avait deux paragraphes sur "ouin ouin les soldats ont tué ma famille et j'ai tout vu". Alors, oui, c'est affreux. Mais putain ça fait 100 fois que tu nous le dis, tais toi et fais avancer l'intrigue stp. En plus c'est même pas comme si c'était une narration à la 1e personne, NON, c'est 3e personne !!!!!! J'ai souffert comme ça pour rien !!!!!!!

Un autre truc qui est extrêmement dommage et qui a renforcé ce sentiment de "l'autrice pense que son public est trop stupide pour comprendre ce qu'il se passe", c'est le fait qu'on a absolument TOUS les points de vue. TOUS. On a Saa'hir avant qu'il meurre, Ashaïa, Zaa'hir une fois son père décédé, et MÊME LE MÉCHANT. C'EST QUOI L'INTÉRÊT. ÇA ENLÈVE TOUT LE SUSPENSE ET LA TENSION QU'ON AURAIT PU AVOIR DANS LE LIVRE. Si l'autrice se sentait pas d'écrire des intrigues de cour, fallait pas écrire ce livre en fait ? Parce que du coup y'a aucun mystère sur l'identité du traître, aucune tension entre Zaa'hir et Ashaïa, rien, vu qu'on sait que c'est le méchant et pas le père de Zaa'hir qui a ordonné les massacres. On nous met toutes les informations dans la bouche comme si on était des oisillons qui ont besoin qu'on leur prémache la nourriture. C'était vraiment anticlimaque pour faire un bel anglicisme, parce que "décevant" c'est pas assez fort. Surtout que, même si on nous a répété 1663838292020863 fois la backstory des deux personnages principaux et les pouvoirs des sœurs du secret fécond, c'est qu'une fois qu'on arrive à la moitié du bouquin qu'on nous donne des infos sur ce que sont censés être les pouvoirs d'Ashaïa en tant qu'unique survivant du culte des confidents de l'ambre et c'est hyper cryptique ? Puis on nous explique enfin, et c'est un truc tout pété (c'est négatif)

Les motivations du méchant sont vachement floues jusqu'à la fin, où elles sont juste floues, parce que le livre s'appelle La Prophétie de l'Ambre sauf que... Ben, on nous donne pas la prophétie. On nous dit que la clé est dans la prophétie, oui. Mais pas ce que c'est la prophétie....

Y'a aussi un gros problème de rythme, qui je pense est aggravé par le fait qu'on ait 3 points de vue (même si celui du méchant reste occasionnel, comparé à Ashaïa et Zaa'hir qui alternent à chaque chapitre). Genre je me suis traîné jusqu'à la moitié du livre en geignant, puis la deuxième moitié je l'ai flinguée (toujours en geignant) parce qu'il se passait ENFIN des choses, les deux personnages s'étaient enfin rencontrés et les choses s'accéléraient. Sauf que du coup ça se fini en cul parce qu'on est pas plus avancés : on a pas de prophétie, et pas de motivations pour le méchant. On a pas résolu de conflit, vu qu'y en avait juste pas. Je pense qu'il aurait fallu avoir moins de points de vue. Soit avoir que Ashaïa ou que Zaa'hir, ou alors alterner moins souvent. Ça aurait aidé à créer du suspense, de la tension, une vraie intrigue quoi. Et ça aurait expliqué pourquoi on a pas vraiment les motivations du méchant. Parce que du coup j'ai l'impression d'avoir lu la première partie d'un seul roman, au lieu d'avoir lu le tome 1 d'une série de romans

Maintenant passons au plus gros problème de ce roman (oui, y'a pire que les pavés d'avant)...... L'écriture. C'est LE point noir du livre. Outre la construction du scénario, qui est assez bancale comme vous avez pu le constater dans mon pavé précédent, la construction des phrases et des expressions était bancale aussi. Je dirai pas combien de messages enragés j'ai envoyé à mon amie pour m'en plaindre. Au bout d'un moment j'ai arrêté parce que c'était quasiment à chaque page. Même sur la construction des chapitres j'étais perplexe, parce que au moins 8 chapitres sur 10 finissent par des points de suspension. Encore une fois, il existe d'autres moyen de créer du suspense et de la tension.............. J'ai l'impression d'avoir lu une épreuve non corrigée alors que j'avais la version finale entre les mains, c'était insupportable. C'est à se demander à quoi ont servi la correctrice et l'éditeur. Je comprends vraiment pas. Comme a dit mon amie, si j'étais correctrice, j'aurais jamais accepté que mon nom soit associé à un truc pareil. C'est comme si personne avait rien fait dessus. Genre l'autrice a envoyé son premier jet et on lui a dit "banco, on y va !". Et le PIRE. Le pire. C'est qu'elle a gagné des prix ?! Au pluriel !!!!! Plein de prix !!!! Mais qui sont les gens qui ont récompensé ça ? À moins que ses autres livres soient totalement différents, mais putain dans ce cas pourquoi celui-là est si mal écrit ?

Enfin bref, grosse déception parce que l'univers un peu inspiration "Asie traditionnelle" c'est toujours une bonne esthétique et dans la romance ça crée des trucs cool, surtout chez les Coréens vu que l'autrice admet à la fin que c'est l'inspiration de l'univers (confucian law etc etc). Sauf que l'autrice utilise pas du tout ça. Juste l'esthétique. L'éthiquette de la cour est vaguement utilisée, mais on a aucune tension. Je dis pas de créer un truc à la Carnets de l'Apothicaire où y'a des machinations dans tous les coins (surtout qu'on est pas dans la cour intérieure avec les concubines là, juste la cour normale), mais y'a un favoritisme assez évident envers Ashaïa et personne autour d'elle ne réagit autrement que de manière ultra positive et bienveillante ? Ça me paraît pas logique mais bon, c'est peut-être parce que j'ai trop regardé Les Carnets de l'Apothicaire récemment. Ah si pardon, le seul qui a une réaction à peu près normale c'est le confident de Zaa'hir, son meilleur ami qui a grandi avec lui et qui se méfie un peu de Ashaïa (ce qui est normal, même si elle a sauvé la vie de Zaa'hir ils ne la connaissent pas et elle pourrait très bien être dans le coup, on sait pas). Sauf que c'est présenté comme de la jalousie parce qu'il est amoureux de Zaa'hir........ Breeeeeeeefffff..............

#la prophétie de l'ambre#carina rozenfeld#books#booklr#livres francais#french books#sorry i don't feel like translating it but#tldr; it's shit#je me suis à peine relue mdr vous avez qu'à faire avec tant pis

2 notes

·

View notes

Text

26 notes

·

View notes

Note

The Jedi enclave Corellan was brought up on was basically on its own small island topped off with a mountain. As a result, he knows how to fish, swim, hike and camp very skillfully.

Relu loves exploring the wilderness, but he sucks at camping so bad. Ask him to set a campfire and watch him fumble like a baby. He had a pretty sheltered childhood with zero reasons to learn survival skills. And when he tries to learn on his own, he doesn't get far – his daily schedule is always packed even as a youngling. I imagine he would ask Corellan to teach him, but would he even have the time for lessons?

8 notes

·

View notes

Text

youtube

Astrology by Relu feat. Kagamine Len

3 notes

·

View notes

Text

Lihle Relu (@ amzo.xx)

8 notes

·

View notes

Text

Le ministre de l'enseignement supérieur et de la recherche il a envoyé une circulaire condamnant les manifs propalestiennes dans les universités parce que "elles ne respectent pas le principe de laïcité" c'est une dinguerie

Vraiment la haine ça fout la rage de lire ce genre de dingueries

Source pour celleux intéressé.e.s : https://www.enseignementsup-recherche.gouv.fr/fr/manifestations-etudiantes-en-lien-avec-le-conflit-israelo-palestinien-97541

#et quand on sait comment ca se passe dans les ministeres et le nombre de gens qui ont relu ça et personne a bloqué#faire genre que le soutien à la palestine c'est un engagement religieux ptn qu'ils aillent se faire foutre au ministere#aussi les etudiant.e.s ont le droit d'avoir des convictions c'est quoi cette dinguerie#genre y'a des putains de chorales catholiques et des missions etudiantes dans les facs ok??? les etudiant.e.s font ce qu'iels veulent#french politics

3 notes

·

View notes

Text

SWTOR Headcanon: I Ship Jaymizu Poh and Achitan

For those who don't remember, these two were involved in the "Reclaiming What's Ours" mission in Republic-side Taris.

Jaymizu Poh

Achitan

Jaymizu and her blustering brother, Relus, are looking to reclaim their family's lands (from 300 years ago) on Taris. When they can't get the Republic military to help, they turn to the player for help.

Of course, the player discovers that the squatters are a group of non-human's led by Achitan whose ancestors had an even older claim. Their land had been repossessed by the Senate at some point, apparently due to anti-non-human bigotry.

(Mind you, that would have been long before KOTOR1, much less SWTOR. There are VERY few examples of Republic anti-alien bigotry in the SWTOR stories.)

In my Halcyon Legacy, Ulannium Kaarz, my Barsen'thor, enountered these two and brokered a settlement.

And... i'm shipping them. I headcanon that both of them evacuate Taris when the Empire attacks, with Relus and most of Achitan's friends not making it.

And they find comfort with each other, eventually forming an organization to help refugees.

Anyone like this?

#swtorpadawan talks#swtor talks#swtorpadawan headcanons#swtor headcanon#jaymizu poh#achitan#taris#Reclaiming What's Ours#oc: ulannium kaarz#relus poh

18 notes

·

View notes

Text

Heads up, Seven up !

Tagged by @tales-from-nocturnaliss :)

Tagging : @isabellebissonrouthier and OPEN TAG i never actually tagged 7 people in this.

Rules (which exist, apparently) : post 7 lines (or so) from a WIP then tag 7 people (or 6 with an open tag)

Let's go, with... Well, the last bits I wrote for Hélianthe and Atropa. Which are, you guessed it, in french.

-

L'autre resta silencieuse quelques instants. Puis Atropa l'entendit se lever et s'éloigner et crut enfin être tranquille, jusqu'à ce qu'elle ajoute :

– J'espère ne pas avoir tué autant de gens que vous à cet âge-là.

– T'as choisi le mauvais travail pour ça, gardienne. Ton taf c'est le même que le mien, sauf que tu choisis pas ton employeur et la majorité des gens que tu butes sont innocents. Moi des fois j'ai de la chance et je me débarrasse de connards.

Margot détala, le bruit de sa course comme une chanson aux oreilles d'Atropa.

#heads up seven up#tag games#writing games#my writing#ok real talk. first time i was tagged in a heads up seven up i just assumed it was a 7 last linesyou wrote thing and that's#how i've been doing it ever since#i don't KNOW 7 people i can consistently tag anyway#bref#hélianthe et atropa#encore une fois c'est un premier jet non relu et non édité voilààà

9 notes

·

View notes