Don't wanna be here? Send us removal request.

Text

El Internet de las Cosas y Cómputo en la Nube

¿Qué es el internet de las cosas o IOT?

En esencia, es cualquier dispositivo de uso cotidiano que tiene la capacidad de transmitir datos a través de la red sin necesidad de interacción humana.

Algunos retos que enfrenta:

La escalabilidad: porque el número de dispositivos que se encuentran conectados crece de manera rápida y con ellos, también el volumen de datos que se acumulan y requieren ser clasificados y limpiados para poder aprovecharse.

El rápido crecimiento: por presión a innovar

El ambiente: aún no cuenta con protocolos de seguridad y estándares que permitan proteger la privacidad de sus usuarios. De hecho son los principales medios por los que se filtran datos.

Cómputo en la nube o Cloud Computing

Las soluciones de cómputo en la nube permiten gestionar, almacenar y acceder a tus datos y aplicaciones sin necesidad de adquirir la infraestructura física o llevar a cabo un proceso de mantenimiento continuo que implique altos costos. Además, su implementación es mucho más sencilla y la seguridad queda a cargo del proveedor.

On premise vs cómputo en la nube

El software on-premise se encuentra instalado en los servidores y dispositivos locales de la empresa.

Costo

Los sistemas en la nube son accesibles para las pequeñas y medianas pues no requieren costos iniciales y todo es bajo demanda, se hacen pagos mensuales por lo que uses.

Aplication Service Providers: son las empresas encargadas de entregar estos servicios a través de un sistema de renta o pago por uso en internet.

Tipos de cómputo en la nube

Nube privada: los servicios informáticos que se ofrecen a través de Internet o de una red interna privada solo a algunos usuarios y no al público general.

IaaS o Infraestructura como Servicio: ofrece recursos esenciales de proceso, almacenamiento y redes a petición que son de pago por uso.

Paas o Plataforma como Servicio: servicios para el desarrollo y mantenimiento de una aplicación sin necesidad de un equipo con alta capacidad

SaaS o software como servicio: un proveedor de servicio permite el uso de aplicaciones a través del internet sin necesidad de instalación

Principales proveedores de cloud computing a nivel mundial:

Amazon Web Services

Azure Cloud Services

Google Cloud Services

Etapas del cómputo en la nube

1.- Experimentación: los diferentes departamentos de una organización o ingenieros en software diseñan nuevas soluciones

2.- Migración: el portafolio de IT se muda a la nube

3.- Transformación: las aplicaciones seleccionadas

Big Data

Es un término que describe un gran conjunto de datos estructurados y no estructurados que rodean a un negocio o mercado. Son datos que pueden ser explotados para mejorar la toma de decisiones dentro de ese contexto.

Los datos de este tipo cuentan con 3 características principales:

1.- volumen: una gran cantidad de datos. Se estima que en 2020 se han superado los 40 billones de GB en datos en el mundo

2.- velocidad: se refiere a la rapidez con que los datos son creados, accedidos, almacenados y procesados

3.- variedad: provienen de muchas fuentes como archivos, bases de datos, sensores, dispositivos inteligentes, etc.

Las bases de datos tradicionales

Una base de datos es un sistema que convierte un conjunto de datos de gran tamaño en una herramienta que permite a los usuarios extraer más fácilmente la información

Fundamentos de bases de datos

Esquema: es la descripción de la estructura de la base de datos

Subesquema es la descripción de una parte de la BD especial para un usuario

Capa de aplicación: es la más cercana al usuario final. Como se muestra en la ilustración, es la capa que proporciona la interfaz entre las aplicaciones que utilizamos para comunicarnos y la red subyacente en la cual se transmiten los mensajes.

Capa de gestión: la más cercana al sistema o las reglas del negocio

Sistema administrador de bases de datos o DBMS: es un sistema que permite la manipulación de la base de datos

Modelo relacional

Es una forma intuitiva y directa de representar datos en tablas. En una base de datos relacional, cada fila de la tabla es una tupla o registro con un ID único llamado clave. Las columnas de la tabla contienen atributos de los datos, y cada registro generalmente tiene un valor para cada atributo, lo que facilita el establecimiento de las relaciones entre los puntos de datos.

Minería de datos

Es un conjunto de técnicas que permiten descubrir patrones dentro de un conjunto de datos para poder explotarlos.

Diferentes formatos dentro de la minería de datos

Descripción de clases: Trata de identificar propiedades que caractericen a un grupo dado de elementos de datos.

Discriminación de clases: identificar propiedades en grupos

Análisis de agrupamiento: búsqueda de clases en los datos

Análisis de asociaciones: búsqueda de enlaces entre los datos

Análisis de excepciones: identificar elementos que no se ajustan a la norma de datos.

Análisis de patrones secuenciales: identificar patrones de comportamiento a lo largo del tiempo

Inteligencia artificial

Es la rama que estudia cómo lograr que una máquina sea capaz de resolver problemas de la misma manera como lo haría una persona.

Machine Learning

Es una rama de la inteligencia artificial que permite que las máquinas aprendan sin ser expresamente programadas para ello. Lo que busca es hacer sistemas capaces de identificar patrones entre los datos para hacer predicciones.

1 note

·

View note

Text

Redes

La necesidad de compartir información entre computadoras nos condujo a la creación de redes.

Fundamentos

Clasificación de las redes

De acuerdo a su extensión:

Redes de área local o LAN (generalmente son computadoras situadas en el mismo edificio o complejo)

La red de área local más popular es Ethernet, desarrollada en 1970 en Xerox Park.

Esta compuesta por computadores conectados a un cable de ethernet común

Cuando una computadora quiere enviar un mensaje la transmite en forma de electricidad a lo largo del cable.

Cada computadora recibe la transmisión pero sólo se la queda la que tenga la dirección MAC (Media Access Control) correspondiente al destinatario.

Utiliza el protocolo CSMA

Cada computadora en el mundo cuenta con una dirección MAC para Internet y Wi-Fi.

Redes de área metropolitana o MAN (abarcan territorios pequeños como pueblos)

Redes de área extensa o WAN (se encargan de la comunicación entre ciudades y continentes)

De acuerdo a su apertura:

Abierta: pública

Cerrada: es propiedad de una entidad

De acuerdo a topología o el patrón con el que se conectan:

En bus: todas conectadas a una línea común de comunicaciones

En estrella: están conectadas por medio de una máquina que sirve como punto central

Protocolos

Para que una red funcione todos los procesos tienen que ajustarse a unas reglas estandarizadas llamadas protocolos; estos permiten que los dispositivos se puedan comunicar entre sí independientemente del fabricante de cada uno. Algunos protocolos comunes son:

CSMA/CD

Este difunde todos los mensajes a todas las máquinas del bus pero la máquina solo se queda con aquellos dirigidos a ella

Para transmitir un mensaje, la máquina espera que el bus este en silencio

Si el bus está transmitiendo y se detecta una colisión, espera un tiempo aleatorio e intenta de nuevo.

No es compatible con redes inalámbricas

CSMA/CA

Este protocolo en vez de detectar las colisiones las evita dando ventaja a aquellas máquinas que están esperando para transmitir. Cuando una máquina transmite espera un corto periodo de tiempo y envía la información sólo si el canal ha estado en silencio durante ese periodo.

No es compatible con redes inalámbricas en estrella porque la máquina central no es capaz de detectar que las transmisiones están colisionando.

Wi-Fi

Combinación de redes

A veces es necesario conectar redes existentes para formar un sistema de comunicaciones más amplio. En el caso de redes con bus basadas en protocolos Ethernet es posible conectar los buses para formar uno.

Para hacerlo contamos con diferentes dispositivos:

Repetidores: une dos buses

Puentes: une dos buses pero divide la red en dos lados y sólo permite el paso de información si el destinatario se encuentra del otro lado. Nos ayuda a reducir colisiones.

Conmutadores: es un puente con múltiples conexiones para conectar varios buses.

En ocasiones las redes tienen características incompatibles, lo que se soluciona con una red de redes o interred. Las conexiones de la interred se gestionan mediante dispositivos llamados routers, que son computadoras utilizadas para el reenvío de mensajes y permiten a las redes mantener sus características internas.

Este reenvío es posible gracias a que cada máquina contiene dos direcciones: su dirección dentro de la red rocal y la de interred. Para hacer llegar el mensaje cada router contiene una tabla de reenvío que de acuerdo a la dirección decide el siguiente destino dentro de la ruta del mensaje. Un mensaje puede tener varias “paradas” en diversos puntos antes de llegar a su destino.

El internet

El ejemplo más notable de interred es Internet. Desarrollado a principios de 1960 por la Agencia de Proyectos Avanzados de Investigación para la Defensa, su objetivo era conectar redes a través de un medio no sensible a desastres naturales.

Inicialmente esta red usaba una tecnología llamada “packet-switching”, que dividía los datos en paquetes pequeños para poder enviarlos a través de la red rápidamente y solo conectaba la Universidad de Utah con 3 centros de investigación.

Si te interesa la historia del Internet te dejo este hilo de twitter: https://twitter.com/nisara2201/status/1361540403976155139

Poco a poco se fue expandiendo para abarcar más universidades en diferentes estados hasta que finalmente en 1973 se volvió un proyecto internacional que conectaba Estados Unidos con Noruega y Londres. Eventualmente, los operadores de red deciden descentralizar esta red para que sea controlada por diversas organizaciones pero permita la comunicación entre ellas a través de protocolos estándar (TCP/IP) formando una red común: el Internet.

En 1994 se privatizaron las conexiones principales; se permitió la entrada de firmas con fines comerciales bajo supervisión del gobierno de Estados Unidos que garantizó un mercado competitivo. De esta manera surgieron proveedores importantes como AT&T y Sprint.

Arquitectura de Internet

Estas redes son construidas y mantenidas por organizaciones denominadas Proveedores de Servicios de Internet o ISP. Básicamente son redes de routers generalmente manejadas por compañías de comunicaciones. Pueden ser de varios tipos:

Nivel 1: formado por redes WAN internaciones

Nivel 2: generalmente operan dentro de una región

ISP de acceso o intranet: es una interred independiente operada por una única autoridad que suministra acceso a Internet a los usuarios individuales. Generalmente son las empresas locales de telefonía y cable.

Los dispositivos con los que los usuarios se conectan a los ISP de acceso se conocen como sistemas terminales o hosts. La tecnología mediante la cual estos se conectan es muy variable:

Por Wi-Fi

Por cable o satélite para lograr una conexión directa a través de módems, que convierte los datos a un formato compatible con el medio de transmisión como DSL.

Por línea telefónica: solución antigua barata y de alta disponibilidad pero cuya tasa de trasferencia es muy lenta para los servicios actuales

Banda ancha

Cables de fibra óptica

Direccionamiento

Una interred requiere de un sistema de direccionamiento que identifique a cada computadora de la red. Dentro de Internet estas direcciones se conocen como las direcciones IP (Internet Protocol); son asignadas por la ICANN o Corporación de Internet para la asignación de nombres y números y tienen una longitud de 32 bits. Tradicionalmente se escriben en notación decimal con puntos.

La información a lo largo de internet se envía en paquetes compuestos por dos partes: la carga de datos y un encabezado que contiene la dirección IP. La dirección IP indica a qué computadora se debe enviar la información, pero no a qué aplicación, por esta razón contamos con protocolos adicionales como UDP o User Datagram Protocol. Este protocolo divide la carga de datos en un encabezado y los datos en sí. El encabezado contiene un número de puerto que indica a qué aplicación se le darán los datos y una suma que contiene el número de bits que debe tener el paquete. Si la suma de los datos y la suma en el encabezado no coinciden, esto implica que se perdieron datos y el archivo está correcto.

Para asegurarnos de que la información llegue completa contamos con el TCP o Transmission Control Protocol. A los paquetes con este protocolo se les asignan números consecutivos para asegurarnos que a pesar de que lleguen en desorden el sistema operativo pueda ordenarlos.

Además, la computadora que recibe el mensaje debe enviar una señal que indique que el paquete se ha recibido con éxito y puede enviar el siguiente. En dado caso de que no reciba la confirmación vuelve a enviar el mensaje.

Como estas direcciones son difíciles de manipular para los seres humanos, internet cuenta con un sistema alternativo en que las máquinas se identifican con nombres mnemónicos. A cada nombre se le llama dominio y estos tienen que estar registrados ante el ICANN.

Estos nombres de dominios son convertidos por nuestros buscadores en direcciones IP mediante las búsquedas DNS, las cuales traducen estos nombres usando servidores de nombres a los que colectivamente se les llama Sistema de Nombres de Dominio o DNS.

Generalmente los nombres de dominio reflejan la clasificación del dominio (como el giro de la organización o el país en que se encuentra el servidor). A estos sufijos les llamamos dominios de nivel superior o TLD’s. Los nombres de dominio se amplían hacia la izquierda y las ampliaciones se deparan mediante un punto. En algunos casos se emplean varias extensiones conocidas como subdominios.

Aplicaciones de Internet

Correo electrónico

Cuando un usuario envía un correo, este se transmite primero al servidor de correo del usuario para después reenviarse al servidor de correo de destino donde se almacena hasta que el receptor pida ver sus mensajes.

Protocolos usados

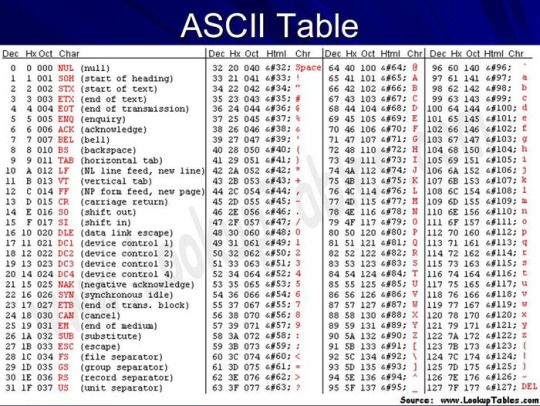

El protocolo para transferir correo entre servidores es SMTP, diseñado especialmente para transferir mensajes de texto codificados con ASCII de una máquina local a un servidor.

MIME es un protocolo adicional para convertir datos no ASCII a un formato compatible SMTP

POP3 es utilizado por el usuario para transferir los mensajes a su computadora local, manipularlos y leerlos.

IMAP permite almacenar y manipular los correos dentro del mismo servidor de correo para que el usuario tenga acceso desde cualquier computadora remota.

NTP Network Time Protocol

FTP o File Transfer Protocol: sirve para transferir archivos a través de internet. Se necesita colocar el archivo en una máquina con servidor FTP y proteger el acceso mediante contraseña.

FTP Anonymous: proporciona acceso no restringido a archivos.

Estructura de una dirección de correo

The World Wide Web

Es una aplicación de Internet compuesta por una red de documentos de alcance mundial.

Los documentos que contiene son de hipertexto, lo que significa que contienen enlaces a otros documentos y generalmente tienen terminación .html. A esos enlaces les llamamos hipervínculos.

A un documento de hipertexto se le da el nombre de página web, mientras que a un conjunto de páginas se les conoce como sitio web.

Normalmente accedemos a ellos a través de software que se conecta al servidor en el que se encuentra el documento y nos presenta la información de forma organizada, denominados navegadores. Los documentos se transfieren entre los navegadores y los servidores usando un protocolo especial llamado HTTP. Para poder localizar los documentos contamos con un URL o Uniform Resource Locator que contiene la información necesaria para conectar con el servidor.

Está formado por 4 secciones:

Como los textos en ASCCI no son capaces de identificar qué es un link y qué no, como debe aparecer el documento en pantalla y qué recursos multimedia se deben ocupar, fue necesario desarrollar un nuevo lenguaje para construir las páginas web: HTML.

motores de búsqueda (sitios web que ayudan a los usuarios a localizar material web relacionado con un tema de su interés)

Capas de software de Internet

El software que nos ayuda a transmitir mensajes en Internet cuenta con varias capas:

Capa de aplicación: en esta se crea el mensaje y proporciona la dirección

Capa de transporte: acepta el mensaje, lo divide en paquetes y se asegura de un correcto formado

Capa de red

Capa de enlace: situada en el destino

0 notes

Text

Las enseñanzas con expertos en TI que no te puedes perder y temas complementarios

Nada mejor que aprender a través de la experiencia. De acuerdo con algunas conferencias en las que estuve presente, les comparto lo siguiente:

Manuel Aragonés (fundador de deep_dive)

Habilidades esenciales dentro de Ciencias de Datos

Tener domain specific knowledge

Administración de proyectos

Minería de datos avanzada

A diferencia de lo que se cree: habilidades de comunicación que te permitan interpretar lo que el cliente quiere y los problemas que enfrenta para ganar su confianza

¿Cómo ayudará el Machine Learning a la ciberseguridad?

A través de la detección de anomalías: por ejemplo, cuando corres un proceso que está ocupando más memoria de la que debería o registrando las actividades normales de un usuario dentro de un equipo.

Luis Guillot (CTO at Huawei Technologies)

Retos de la implementación de sistemas gubernamentales en México

La inversión tan grande que se requiere hace que las expectativas del funcionamiento sean muy altas

Son proyectos sujetos a la opinión pública

Muchas veces los encargados en tecnología no toman en cuenta la accesibilidad del sistema: se trata de llegar a la mayor cantidad de personas y llevarles el servicio, no de acrecentar con él la desigualdad social

Datos curiosos sobre Huawei: 1 de cada 2 llamadas en México corren por infraestructura Huawei, la sección de devices es solo una pequeña parte de la empresa.

Alfonso Yáñez (Vicepresidente de Tecnología en Walmart México)

El acierto de Walmart durante la pandemia

Walmart cuenta con un centro de análisis que le permitió detectar características anormales de esparcimiento del Covid-19. A partir de ello, se prepararon para un nuevo modelo de trabajo a distancia, sin esperar a que se impusieran las restricciones, demostrando las ventajas de la planeación y anticipación de riesgos. La ventaja que no había notado y que distingue a Walmart es que persigue una estrategia multicanal que posterior a la contingencia le ayudó a mantenerse a flote. Su presencia no se limita solo a sus aplicaciones.

Ivan Zavala (Business Development and Public Affairs at Cognizant Mexico)

El covid no dañó a las escuelas: la falta de inversión en tecnología lo hizo. En México tenemos un gran problema para entender la tecnología pues ahora queremos adaptar nuestro modelo actual a las plataformas online en vez de crear nuevas estrategias

Carlos Piña (Ph.D. en Computer Science)

Sobre el astroturfing

Las redes sociales se han transformado en una herramienta de reclamo para los gobiernos. En México se hace uso de las campañas coordinadas conocidas como astroturfing. Los primeros minutos dentro de una tendencia en twitter son los que determinan si es manipulada o si surgió de manera natural.

OTROS TEMAS CLAVES DE TECNOLOGÍA: HABLEMOS DE TECNOLOGÍA CON NICTÉ Y MARITRINI

OPEN SOURCE

El código fuente que indica el comportamiento de un software puede ser de dos tipos: abierto (modificable por el público) o privado.

El software open source es un código diseñado de manera que sea accesible al público en el que es posible modificar y distribuir el código. Su desarrollo es descentralizado y colaborativo, depende de una comunidad que constantemente le dé mantenimiento.

Este tipo de software destaca como una alternativa al software propietario desde su aparición en la década de 1980 y la fundación por Richard Stallman de la Free Software Foundation para impulsar el uso de este tipo de código como una alternativa flexible y de menor costo para cumplir con las necesidades de diversas organizaciones. Un ejemplo de ello está en el sistema operativo Linux creado por Linus Torvalds. Muchos dispositivos de uso diario como los teléfonos Android o algunos automóviles se ejecutan a través de este sistema.

Dentro sus ventajas encontramos:

Menores costos en hardware

Evita el pago de licencias (aunque su implementación y mantenimiento no es gratis)

Permite crear una solución específica para cada organización

Varias alternativas accesibles de soporte

Fácil de escalar

A pesar de todas sus bondades, este tipo de software enfrenta diversas barreras, las cuales resumimos en el video.

https://www.youtube.com/watch?v=6Y225BIaAIE

¿Sabes en dónde están tus datos?

En este video te contamos conceptos como qué son las cookies, sus tipos y cómo es que las empresas de tecnología recolectan y explotan tus datos en la web.

https://www.youtube.com/watch?v=-V49BqwRcGY

¿Qué necesita un líder de tecnología?

Te lo contamos con este video basado en el libro.

https://www.youtube.com/watch?v=YOf8xS2oaLU

El Consumer Electronics Show en Las Vegas

Si te perdiste este evento en este video rescatamos los productos que nos parecieron más relevantes:

https://www.youtube.com/watch?v=9WpYNcD09C0&t=1s

¿La tecnología reemplazará a los seres humanos dentro del mercado laboral?

Humans need not aply¨

https://www.youtube.com/watch?v=sqpmCpHRSk0&t=1s

IT doesn’t matter

¿Invertir menos en vez de más en tecnología en plena pandemia? Te contamos por qué no suena tan alocado como parece.

https://www.youtube.com/watch?v=qJznKZtY3oo&t=94s

PC Computing- Dvorak on Innovation

https://www.youtube.com/watch?v=v9QGCI_JLMY

0 notes

Text

Propiedad intelectual y Green IT

Propiedad intelectual

El software y su protección legal

La importancia económica del software como motor de la economía mundial no queda en duda, sin embargo, su protección jurídica es difícil establecer. Es complicado darle una sola clasificación por la cantidad de elementos que lo conforman, no se sabe si clasificarlo como derechos de patentes, de autor o dentro de otro sistema.

Desde un punto de vista social se argumenta que las patentes de software privatizan el conocimiento, acentuando las desigualdades sociales y geográficas mediante la exclusión de la mayoría de la población como productores e incluso como consumidores de los objetos de dichas patentes.

Sin embargo, el proceso creativo merece protección.

¿Cómo se protege el software?

Existen 2 líneas de análisis

A través de la regulación de contenido

Problema Youtube y la Unión Europea

El artículo 13 (vigilancia de contenidos protegidos por parte de proveedores) es una normativa que obliga a las plataformas de contenidos a monitorizar lo que los usuarios suben para comprobar si se violan o no los derechos de autor. Cada servicio tendría que crear un sistema tipo Content ID de YouTube que permitiría detectar violaciones de los derechos de autor.

A través de la regulación del software

El problema de la piratería en el mundo y México

Dentro de sus consecuencias más importantes tenemos:

Freno a la competitividad e innovación, pues reduce la inversión en la industria

Genera un aumento en los precios de los productos

Estudio de Piratería BSA

Métodos para la protección de software

1.-DERECHOS DE AUTOR

La ley generalmente protege el código fuente y los elementos únicos de una interfaz de usuario

El propietario gana derechos especiales como el derecho a modificarlo, copiarlo y distribuirlo por licencia o venta.

Ley Federal del Derecho de Autor es la que protege estos productos en México

Se pueden hacer excepciones a esta con base en 4 factores de USO JUSTO:

Uso no comercial o con fines educativos del producto

La naturaleza del trabajo protegido

La cantidad de trabajo usado tomando en cuenta la versión original o completa

El efecto que tenga en el valor del trabajo protegido posterior a su utilización

2.-SISTEMAS DE PROTECCIÓN TÉCNICOS o TPS

A través de este se corre el riesgo de promover el uso justo. Sin embargo se han vuelto más seguros con el tiempo.

Un ejemplo de esto está en los CD’s o DVD’s, que usan de encriptación CSS para proteger el contenido.

3.- MODELO DE NEGOCIO

Business Software Alliance

Es una organización sin fines de lucro creada para promover los objetivos de la industria del software y sus socios del hardware. Es la organización más importante dedicada al desarrollo de un mundo digital seguro y legal.

Patentes de software

Se pueden obtener por ideas, sistemas, métodos, algoritmos y funciones dentro de un producto de software.

¿Cómo podemos evitar la piratería dentro de una organización?

A través de la gestión del software

El no conocer a fondo las necesidades del negocio y de los usuarios de software nos conduce a tener productos que no utilizamos y es un factor que incrementa el riesgo de su uso ilegal.

Medidas a tomar:

Implementar políticas y procedimientos

Auditoría

Determinar lo legal y lo ilegal

0 notes

Text

Fintech

Es la abreviatura de Financial Technology, los aucles son productos, tecnologías y modelos de negocios que están transformando la industria de servicios financieros.

Dentro de sus puntos clave de digitalización encontramos:

Medios de pago y transferencias

Crear infraestructura para servicios financieros

Productos de crédito

Soluciones financieras para empresas

Finanzas personales

Crowdfunding

Criptomonedas y blockchain

Las fintech permiten al sector financiero expandirse de manera sostenible a la vez que incrementa la utilidad por la flexibilidad en la manera de realizar transacciones.

Impacto alrededor del Mundo

En Reino Unido

Cada hora se crea una nueva startup FinTech

Se está trabajando para regular el mercado de criptomonedas

Blockchain fue creada en el 2011 y sus oficinas corporativas se encuentran en Londres. Ha levantado capital por 70 millones de dólares de uno de los VCs (Venture Capitalists) más prestigiados de Silicon Valley, convirtiéndose hoy en uno de los monederos de Bitcoin más grandes de Reino Unido. La compañía se describe como la plataforma global de software para activos digitales y soporta casi 23 millones de monederos de criptomonedas.

Singapur

Es el potencial centro mundial de Fintech dada la salida de Reino Unido de la Unión Europea

Cuenta con una fuerte política pública con incentivos tributarios efectivos

Durante el 2017 este sector recibió la mayor cantidad de fondos como inversión, alcanzando los US$229.10 millones

La industria en México

El crecimiento anualizado para México se registra en un 40% desde 2018

La estructura del mercado FinTech en México se caracteriza por una mayor participación del segmento de pagos y remesas, el cual con 75 startups abarca el 23% del total de las startups que existen

El ecosistema fintech

Está conformado por varias organizaciones:

Fondos de capital y aceleradoras

Startups

Desarrolladores

Consumidores

Instituciones tradicionales financieras

Gobierno

Ley fintech en México

La Ley Fintech es la ley establecida para regular las instituciones de tecnología financiera. Esta ley se publicó el 9 de marzo de 2018 y tiene como objetivo, incrementar el nivel de inclusión financiera y mejorar las condiciones de competencia que hay en el sistema financiero del país.

La ley va dirigida a las instituciones de tecnología financiera, las cuales se entienden como aquellas plataformas en las que se facilitan la celebración de operaciones y servicios financieros, esto de acuerdo a la Comisión Nacional Bancaria y de Valores (CNBV).

Las Instituciones de este ramo que busquen cumplir con la normatividad, deberán:

Solicitar la autorización ante la CNBV para poder operar.

Deben presentar a sus accionistas y administradores el aviso de sus operaciones.

También requieren contar con capital mínimo para sus operaciones y por activos sujetos a riesgo.

Por último, deben constituirse legalmente como sociedades anónimas (S.A.).

Criptomonedas

Las criptomonedas son un medio de pago que se almacena de manera electrónica. Son activos almacenados digitalmente a través de una base de datos pública descentralizada, la cual mantiene un registro de las transacciones. A esta tecnología la denominamos blockchain.

En México a través de la Ley Fintech los activos virtuales son autorizados por Banxico, sin embargo, no son reconocidos como una moneda de curso legal y por lo tanto no están respaldados por el gobierno del país.

Blockchain

Es una manera de registrar información de manera que sea casi imposible de cambiar. Esencialmente consiste en un libro mayor digital de transacciones que se duplica y distribuye a lo largo de toda una red de sistemas computacionales. Cada bloque contiene cierta cantidad de transacciones y cada vez que una nueva ocurre, un registro de esa transacción se copia a cada libro de cada participante.

Este sistema es muy seguro, pues si alguien quisiera corromperlo tendría que cambiar cada uno de los bloques en una cadena a través de todas las versiones distribuidas. Además, las transacciones se firman a través de una técnica de criptografía denominada hash.

Gracias a este sistema es que las monedas digitales no requieren de una institución que sirva como intermediaria. Es descentralizado.

Minería de bitcoin

En enero 2009, Satoshi Nakamoto publicó y realizó los cálculos matemáticos para generar los primeros 50 bitcoins. La recompensa por dichos cálculos no cambió mientras se generaban (minaban) los siguientes 109,999 bitcoins. Con el tiempo se hizo más costoso este proceso y actualmente no hay una computadora comercial capaz de generar bitcoins.

Algunos aspectos a tomar en cuenta

No cuentan con respaldo de una institución financiera, el riesgo de su inversión es de medio a alto

La caída del sistema es frecuente por muchas transacciones pequeñas

Puede ser usada para el financiamiento de actividades ilícitas

Green IT y cómputo verde

La industria tecnológica es uno de los principales contribuyentes a la emisión de dióxido de carbono a nuestra atmósfera por el uso de equipos informáticos y los gastos energéticos realizados para mantener los grandes centros de datos que cada vez aumentan su capacidad.

El Green IT es un conjunto de buenas prácticas que tienen como objetivo usar de manera eficiente los recursos IT para minimizar el impacto ambiental de la actividad y reducir el consumo energético. Se trata de realizar una gestión eficiente de los recursos e infraestructuras para garantizar que se maximiza su uso y ocupación y se evita el consumo de energía cuando no estamos ocupando nuestros sistemas.

Las principales razones para guiarnos por las prácticas verdes:

Las empresas tienden a omitir el hecho de que su impacto ambiental también modifica su ambiente competitivo de manera negativa y que estas nuevas prácticas les pueden dar ese diferenciador en el mercado, además de mitigar amenazas gubernamentales por las nuevas leyes destinadas a regular este impacto.

El enfoque holístico que busca el Green IT

La basura digital

Los dispositivos electrónicos que utilizamos también contribuyen a la contaminación durante su producción y disposición al final de su vida útil.

La mayor parte del reciclaje electrónico se realiza en Pakistán, India y China.

Elementos que podemos reciclar de los dispositivos electrónicos:

Las pantallas de los monitores

Su carcasa

Bocinas

Cables

Discos duros

Acciones que podemos tomar

Apagar las computadoras cuando no están en uso

Usar screensavers

Activar el modo ahorro de batería en nuestros dispositivos

Asegurarnos que no tengamos equipos en las organizaciones con capacidad no utilizada para evitar el desperdicio

Hacer uso de los servicios de virtualización que permiten que en un solo servidor físico se puedan alojar varios servidores virtuales

0 notes

Text

Implicaciones de las TI

A NIVEL PERSONAL

El desarrollo de la tecnología a pesar de todas sus bondades, es un arma de doble filo. Actualmente provoca problemas psicológicos y físicos como la fatiga visual, atrofia de la atención, depresión y ansiedad, así como el aumento de trastornos psicosociales como el autismo por la falta de interacción social directa.

El impacto del multitasking en nuestra atención

Esta necesidad de responder inmediatamente y realizar múltiples actividades realmente lastima nuestros procesos cognitivos y nuestro pensamiento crítico. Realmente estamos perdiendo la habilidad de concentrarnos, pues recibimos múltiples estímulos de diferentes fuentes en nuestro uso de dispositivos electrónicos.

Policronicidad: mide qué tanto prefieren las personas trabajar en varias actividades a una sola

¿Realmente podemos trabajar en dos cosas a la vez?

No, la computadora no nos permite esto y no incrementa nuestra productividad por ello. La Neurología ha probado que el cerebro humano no se concentra en dos cosas a la vez, sino que cambia de manera rápida entre una actividad y otra, fragmentando los tiempos de atención. Lo que hacemos es prestar atención parcial continua.

A NIVEL SOCIAL

La paradoja de la elección (basado en la TED TALK de Barry Schwartz)

El problema comienza con el dogma de las sociedades occidentales sociales que plantean la necesidad de aumentar la libertad de elección del individuo para aumentar su bienestar.

Esta libertad al final resulta paralizante para los individuos y les trae preocupación e insatisfacciones.

Los teléfonos inteligentes y en general los dispositivos electrónicos cuentan con un exceso de funcionalidades entre las cuales los individuos se ven obligados a elegir, preocupándose por ser siempre productivos, pero a la vez paralizados por esta preocupación y variedad de opciones con las que cuentan.

Implicaciones en el consumo de bienes de este cambio en la tecnología: el tener más bienes entre los cuales escoger hace que nunca estemos satisfechos con nuestras decisiones de consumo.

El costo de oportunidad ahora se resta a la utilidad que obtenemos del consumo del bien aún cuando tomamos la mejor decisión.

Cada vez nuestras expectativas son más altas de los productos y por lo tanto nuestra insatisfacción es menor.

Otros temas interesantes sobre el impacto de la tecnología

El reto de la neutralidad en Internet

La neutralidad de la red es el principio de garantizar que todos los usuarios accedan libremente a todos los contenidos, aplicaciones y servicios de Internet. Asimismo, consiste en asegurar que los prestadores de servicios o ISP’s no hagan distinciones en el tráfico generado por sus usuarios. Esto evita que no se discrimine alguna aplicación sobre otra y se entorpezca la experiencia.

Deep Fakes

Es una técnica de inteligencia artificial que permite editar vídeos falsos de personas que aparentemente son reales, utilizando para ello algoritmos de aprendizaje no supervisados, conocidos en español como RGAs (Red generativa antagónica), y vídeos o imágenes ya existentes.

El resultado final de dicha técnica es un vídeo muy realista, aunque ficticio. Aunque puede ser usado con buenas intenciones, como para recrear a la fallecida Carrie Fisher en SW, también puede ser usado para dañar la imagen de una persona y hacer más fácil el esparcimiento de noticias falsas.

Vigilancia en Internet

Muchos gobiernos han establecido sistemas de vigilancia por motivos de seguridad nacional, para recopilar datos sobre posibles delincuentes y para prevenir actos terroristas. Si bien esas son causas valiosas, también pueden dar lugar a la invasión de la privacidad de los usuarios en línea. Los gobiernos utilizan las principales empresas de tecnología para facilitar su acceso a la información privada.

False positives

Es una expresión comúnmente usada en ciberseguridad para denominar un archivo que se ha marcado o detectado como malicioso cuando no lo es.

Estas alertas falsas/no maliciosas (eventos SIEM) aumentan el ruido para los equipos de seguridad que ya están sobrecargados de trabajo y pueden incluir errores de software, software mal escrito o tráfico de red no reconocido.

Por defecto, la mayoría de los equipos de seguridad están condicionados a ignorar los falsos positivos. Desafortunadamente, esta práctica de ignorar las alertas de seguridad puede crear fatiga de alerta y hacer que su equipo pierda alertas reales e importantes relacionadas con una amenaza cibernética real o maliciosa

Internet Health Report

¿Qué podemos hacer para hacer del internet un lugar más sano?

Cada año la Fundación Mozilla publica un reporte que recopila los principales historias y publicaciones de lo que significa lograr un internet seguro a lo largo de 5 puntos clave: descentralización, seguridad y privacidad, apertura, alfabetización web e inclusión digital.En 2020 el internet nos ayudó y lastimó como nunca. La rápida expansión digital vino acompañada de un incremento en la desigualdad social, violaciones a las políticas de privacidad, aumento en ataques de seguridad, deterioro de la salud mental e incremento de vigilancia gubernamental.Dentro de las ACCIONES CLAVE mencionadas en el reporte para lograr un internet más saludable tenemos las siguientes:Y tú… ¿has identificado como usuario algunos puntos clave dentro de tu país?

Te recomiendo visites el reporte aquí: https://2020.internethealthreport.org/ . Esta organización constantemente recopila historias de todas las regiones del mundo.

0 notes

Text

Cómputo ubicuo y geolocalizado

Las olas de la computación

Primera etapa: varias personas requieren usar una computadora

Segunda etapa: cada persona puede usar su propia computadora

Tercera etapa o de cómputo ubicuo: la estructura física ya no es completamente necesaria para acceder a todas las funciones de la tecnología y es posible que varias personas ocupen una sola computadora a través de la división de recursos e Internet.

Los teléfonos inteligentes o smartphones y su uso

A partir de la primera llamada por teléfono móvil realizada en los años 80 por Martin Cooper, ingeniero de Motorola y la integración de la cámara fotográfica y los mensajes instantáneos en los años 2000, los celulares han integrado cada vez más características que los hacen indispensables en la vida cotidiana.

A partir de 2010 los conocidos como smartphones o teléfonos inteligentes, ya con pantalla táctil, conectividad a internet (3G y ahora 4G) y modelos y marcas para todos los gustos, abarrotan el mercado. El primer teléfono inteligente fue diseñado por IBM en 1992, sin embargo, el lanzamiento del iPhone en 2007 por parte de Apple disparó la venta de estos de manera exponencial, con la venta de 1.4 billones de celulares en la primera década del siglo.

Participación de mercado de smartphones

Actualmente hay mucha más competencia en esta industria, los líderes dentro del mercado son:

Penetración de smartphones

El futuro de la industria móvil

El celular seguirá teniendo un papel central dentro de la vida cotidiana de los consumidores

Tendencias clave de acuerdo con Deloitte:

Al final de 2023 la penetración de smartphones entre adultos de países desarrollados será de casi 90%

Las ventas alcanzarán en 2023 1.85 billones de dólares

Penetrarán un 10% más en el segmento de adultos mayores.

Sus aplicaciones continuarán desarrollándose con base en inteligencia artificial

Uso de las apps (algunas estadísticas)

El usuario promedio en 2021 gasta alrededor de 5 horas diarias en su teléfono a nivel mundial y más del 50% de ese tiempo lo ocupa en las aplicaciones.

Aplicaciones con más usuarios al mes

Uso de apps dentro del ámbito empresarial

Las apps móviles se han posicionado como unas de las herramientas más eficaces para las empresas, especialmente en el campo del e-commerce. Estas facilitan la vida de los usuarios, promueven la interconectividad y mejoran la experiencia en la adquisición de productos y servicios.

Consejos para mejorar la estrategia de mercadeo de una app:

Transmitir el valor de la aplicación a los usuarios

Uso de notificaciones push y mensajes dentro de la app para aumentar la interacción

Individualizar las interacciones con los usuarios

Uso de análisis predictivo para generar interacciones con los usuarios que más la necesitan

Remarketing

A/B testing (consiste en desarrollar y lanzar dos versiones de un mismo elemento y medir cuál funciona mejor)

Experiencia multicanal

Aplicaciones progresivas

Las aplicaciones web progresivas (PWA) son una nueva generación de aplicaciones que aprovechan las principales tecnologías web (HTML, CSS y JavaScript) para crear interfaces para los servicios de Internet. A diferencia de las aplicaciones móviles o las de escritorio, estas PWA pueden ejecutarse en cualquier navegador compatible con los estándares, además de otras ventajas como las notificaciones push, el rendimiento o el incremento de su funcionalidad según las capacidades del dispositivo y de ahí su denominación,

El impacto de la banda ancha

El internet de alta velocidad o de banda ancha se ha vuelto un componente esencial para el desarrollo económico, pues permite el desarrollo de nuevos servicios digitales y el aumento de la competitividad.

Penetración de internet

Durante 2019, de acuerdo con Deloitte, el internet reemplazó a la televisión como el principal medio masivo de información. El uso promedio de la web fue de 170 minutos (2 horas con 50 minutos) diarios por persona, mientras que el de la pantalla chica fue de 167 minutos.

Algunos datos interesantes Statista 2021:

Número de usuarios de internet a nivel mundial: 3.97 billones

País con mayor número de usuarios: China

Región con la penetración de internet más alta: Europa del Norte

Principales retos que enfrenta la sociedad con estos cambios:

Manejo de datos

Seguridad

Accesibilidad

Saturación de la capacidad: más del 36% de las estaciones base en Estados Unidos están a una utilización de más del 80%

0 notes

Text

Redes sociales

Definición

Las redes sociales son un conjunto de aplicaciones y sitios web que están diseñados para permitir a las personas compartir contenido en tiempo real y de manera eficiente. Aunque actualmente se usan principalmente en dispositivos móviles su uso comenzó dentro de los ordenadores comunes.

Utilidad a nivel individual

Ventajas de su uso:

Crean un espacio para compartir información sin censura (mayor visibilidad a problemáticas sociales aunque aparece el problema de las fake news)

Comunicación a nivel internacional e instantánea

Mayor visibilidad profesional

Comunicación con personas alrededor del mundo con intereses comunes

Desventajas:

Sustituir el contacto presencial necesario por ellas

Riesgos a la imagen personal

Riesgos de privacidad y seguridad con la posible exposición de tu información privada por parte de los proveedores de servicios o un tercero con malas intenciones

Cyberbullying

Categorías de las redes sociales

Sitios de networking (LinkedIn)

Sitios de reseñas

Para compartir imágenes y otro contenido multimedia

Foros de debate

Redes de consumo colaborativo

De compra

Empresariales

Su uso alrededor del mundo

Las redes sociales más usadas a nivel mundial en 2021 son:

Fuente: statista

Número de usuarios a nivel mundial en millones

Utilidad a nivel empresarial

Estas plataformas se han vuelto un factor clave para generar ingresos, teniendo mayor relevancia dentro del área de marketing para darle visibilidad a un producto o servicio, aunque apoyan en todas las áreas, pues incluso se pueden ocupar para crear un espacio favorable de atención al cliente o para hacer investigaciones de mercado.

Las estrategias de mercadeo digital

Tenemos las siguientes etapas principales dentro de una estrategia de MKT:

1.- Atracción de prospectos

2.- Maduración de prospectos o leads

Necesitamos ayudar a los prospectos a entender nuestra oferta, generar un diálogo con ellos y recopilar información que nos permita priorizar posteriormente

3.- Priorización

En esta etapa nos debemos a acercar a aquellos leads que nos generaron mayor número de interacciones

4.- Ventas

5.- Medición de resultados

Algunos indicadores que nos permiten evaluar las campañas de mercadotecnia:

Tiempo de conversión de venta (semanas que nos tardamos en cerrar una venta con leads calificados)

ROI de las campañas

Visitas por mes de una página web

Maduración de leads

Factores a tomar en cuenta para definir el presupuesto de una campaña de MKT

Ciclo de vida de la marca o producto (Según datos de la agencia de asesoramiento para PYMES del gobierno de los Estados Unidos, US Small Business Administration, cuando un producto/servicio sale al mercado por primera vez requiere de una inversión en publicidad de, al menos, un 25% sobre el volumen de ingresos, mientras que una empresa madura requiere de menos del 10% de sus ingresos anuales)

Tiempo en que queremos ver resultados

Competencia del sector

Público objetivo

Porcentaje sobre ventas

Basado en la inversión de la competencia

La importancia de tener un equipo interdisciplinario de manejo de redes sociales o de SOCIAL CARE dentro de una empresa

Los consumidores actuales esperan que toda la información sobre una empresa esté disponible en una sola cuenta y que cuente con buena atención a través de las redes sociales. Los managers de MKT no están preparados para esta diversidad de preguntas sobre quejas o uso del producto.

Para construir una mejor relación con los consumidores online las compañías necesitan un equipo multidisciplinario que asesoren antes, durante y después de la compra de un producto o servicio.

Las responsabilidades de un social care team

Organizar responsabilidades y roles departamentales

Asignar tareas específicas de redes sociales a diferentes departamentos

Crear guías de marca para estándares, tono y estilo

Control a través de diferentes KPI’s

Impacto redes sociales

En la sociedad

Efectos en la política moderna

Aunque las redes permiten que los diferentes partidos puedan publicar sus propuestas a bajo costo y estas tengan un mayor alcance, por la falta de regulación las redes se usan para modificar nuestras preferencias de manera poco ética, con información falsa y haciendo uso de los datos de compañías privadas. Un caso muy conocido es el de Cambridge Analytica.

El surgimiento de la pseudo política y pseudo activismo

En vez de que las discusiones políticas incrementen la participación ciudadana en asuntos públicos, los usuarios han caído en el error y la técnica de manipulación de creer que sus acciones online como campañas o firma de peticiones tienen un impacto real. Contrario a lo que se cree, no hay un diálogo entre gobierno y ciudadanos, sino un cúmulo de mensajes unidireccionales.

A nivel individual

Publicidad en redes sociales y privacidad

Las noticias falsas

Las redes hacen muy fácil hacer información viral en minutos. El problema es que esta es un arma de doble filo y la mayoría de los usuarios no verifican la veracidad de la información antes de compartirla. Estas noticias falsas pueden dañar casi cada aspecto de una comunidad (salud, política, etc.).

¿Cómo distinguir una noticia falsa?

Verificar si la fuente es fidedigna

Estar atentos a títulos poco objetivos

Redacción poco formal

Que tenga un autor anónimo y no cuente con datos de publicación

Prestar atención a las imágenes que acompañan a la publicación

0 notes

Text

Sistemas Empresariales

Aplicaciones empresariales

Es aquella que integra las operaciones de distintos departamentos de una empresa dentro de un solo sistema.

Tipos de aplicaciones empresariales

Correo electrónico: como principal línea de comunicación empresarial

Servicios de directorio: almacena y organiza la información sobre los usuarios de una red de ordenadores

Sistemas de planeación de recursos (ERP y GRP)

ERP

Es una categoría de sistemas administrativos de aplicaciones integradas usadas para obtener, almacenar, administrar e interpretar datos de las actividades de un negocio.

Otros sistemas empresariales

SCM (SUPPLY CHAIN MANAGEMENT)

Una cadena de suministro es una red de individuos, organizaciones, recursos y actividades conectadas involucradas en la entrega de un producto o servicio hasta el consumidor final.

Estos sistemas vinculan todo el ciclo de la producción y nos ayudan a reducir costos y aumentar valor a través de un mejor manejo de estos recursos.

CRM (CUSTOMER RELATIONSHIP MANAGEMENT)

Es una herramienta que nos permite monitorear y analizar la relación con clientes actuales, potenciales y socios de negocios. Permite anticipar necesidades, aumentar las ventas y personalizar campañas de captación de nuevos clientes.

Líderes en el mercado de CRM

Salesforce

Microsoft Dynamics

HubSpot

Comparación por años anteriores (los cambios se debieron al costo creciente de las licencias de los líderes anteriores, insostenibles para pequeñas empresas)

KMS (KNOWLEDGE MANAGEMENT SYSTEM)

Apoyan en la recolección, consulta y presentación de conocimiento corporativo

0 notes

Text

Ingeniería del Software

La ingeniería del software es la rama de las Ciencias de la computación que proporciona principios, métodos, herramientas y técnicas para desarrollar programas informáticos complejos de calidad.

Diferencias de la ingeniería del software

Dentro de lo que diferencia a este campo de otras ingenierías podemos encontrar que esta muchas veces no es capaz de construir sus sistemas con componentes prefabricados pues estos se actualizan constantemente y se vuelven obsoletos. Otra diferencia es que no cuenta con métricas apropiadas para software y es difícil evaluar los sistemas.

El concepto más fundamental dentro de esta rama es el ciclo de vida del software.

El ciclo de vida del software

El ciclo de vida del software contempla las fases necesarias para validar el desarrollo del software, garantizar que cumpla con los requisitos y verificar que los métodos usados sean los correctos.

Consta principalmente de 3 fases: desarrollo uso y mantenimiento (en la que se detectan errores y se generan correcciones).

La fase de desarrollo tradicional en cascada consiste en los siguientes pasos:

Análisis de requerimientos: en esta se especifica la funcionalidad del sistema de acuerdo a las necesidades del usuario

Diseño: implica crear un plan para la construcción de ese sistema, se desarrolla una solución a los problemas identificados en la fase anterior. Durante esta se especifica la arquitectura.

Implementación: escritura de programas y creación de archivos

Pruebas

Liberación

Aunque este método en cascada es fácil de entender y estima de manera fácil el costo del proyecto, este no permite implementar cambios durante el desarrollo, por lo que el producto final corre el riesgo de no ser compatible con los deseos o necesidades de los usuarios finales y aumenta sus posibilidades de fracaso.

Para contamos con metodologías ágiles, que nos permiten realizar cambios a lo largo del proyecto y gestionar la incertidumbre.

Los métodos ágiles

Son metodologías diseñadas para manejar las expectativas de los desarrolladores y del cliente. Permiten hacer cambios y aumentar las probabilidades de éxito del proyecto.

Principios de los métodos ágiles

Buscar la satisfacción del cliente

Permitir los cambios aún en fases tardías

Que las entregas al cliente se hagan en un periodo de tiempo corto

Desarrolladores y negociadores deben trabajar en conjunto

Buscar la comunicación en persona

La meta es entregar módulos funcionales como medida de progreso

Scrum

Es un marco de trabajo que establece buenas prácticas para trabajar en equipo en ambientes altamente complejos y cambiantes que requieren obtención pronta de resultados.

Cuenta con tres tipos de roles:

1.- Dueño del producto: quien define requisitos, prioridades y maximiza el valor del producto

2.- Scrum master: responsable de quitar los obstáculos del proyecto y de que todos entiendan las metas, alcance y objetivos

3.- Equipo de desarrollo: los responsables de codificar el proyecto

Asimismo cuenta con los siguientes elementos:

1.- artefactos que son elementos físicos que se producen como resultado de la aplicación de scrum (product backlog, sprint backlog y el incremento)

2.- eventos que nos ayudan a distribuir el trabajo a lo largo del tiempo (sprint, sprint review, scrum diario)

Recolección de requerimientos en Scrum

Para esta fase scrum utiliza un artefacto llamado product backlog que es una lista de todos los requerimientos del producto. Este backlog está compuesto por historias de usuario (requerimientos expresados de manera simple desde el punto de vista de los usuarios).

Trabajo en Scrum

Durante todo el periodo de desarrollo el trabajo se divide en sprints, que es el periodo de tiempo en el que un producto funcional es producido (generalmente de máximo un mes o dos).

Cada sprint cuenta con metas del product backlog que hay que cumplir y una duración predefinida. Estos elementos del backlog y la duración se definen dentro de una junta que debe ser de aproximadamente ocho horas para planear el trabajo de un mes.

Una vez definido el sprint, se subdivide el trabajo de acuerdo a días, en el que cada día se realiza una junta de aproximadamente 15 minutos para sincronizar el trabajo de ese día, sin que en ningún caso exceda las ocho horas de desarrollo.

Al final del sprint se hace un sprint review, en que se revisa el incremento del producto, qué metas se cumplieron del backlog y con qué presupuesto se trabajó para realizar cambios y mejoras.

Scrum puede complementarse con otras metodologías de manera fácil, entre ellas, Kanban.

Kanban

Inventado por Toyota en 1940 para su proceso de ensamblado, basado en la operación de supermercados, es un enfoque que nos sirve de apoyo para el manejo de proyectos complejos.

Nos permite visualizar la manera en que el trabajo fluye a través del sistema clasificando las tareas en: no hechas, hechas y WIP (Work in Progress o trabajo en proceso).

Otras metodologías de desarrollo

Además de las ya mencionadas que pueden combinarse dentro de un mismo proyecto, contamos con:

Modelo incremental: en que el primer sistema es una versión simplificada del producto final

Modelo iterativo: el primer sistema es una versión incompleta del sistema

Proceso unificado racional

Prototipado rápido: el objetivo no es una versión funcional del producto, sino conseguir una herramienta de demostración para aclarar los requerimientos

Ejemplo de una práctica en Minecraft para Scrum:

https://twitter.com/nisara2201/status/1377044508655951874

0 notes

Text

Seguridad

Cuando una computadora se encuentra dentro de la red, pasa a ser objetivo de accesos no autorizados. Un riesgo informático es la capacidad de que una vulnerabilidad informática pueda ser explotada con éxito y esto cause pérdida, robo o alteración de los activos de la empresa u organización. Es la probabilidad de que un incidente ocurra.

Una de las tareas más importantes de un sistema operativo es proteger los recursos de la computadora y detectar accesos no autorizados o actividades irregulares. En caso de que varias personas utilicen la misma computadora, la solución propuesta comúnmente por el sistema operativo es el establecimiento de dos tipos de usuarios: un administrador y un usuario normal, cada uno con cuentas separadas y protegidas por contraseñas El administrador define los privilegios que se le otorgan al resto de los usuarios y es el que puede alterar las configuraciones del sistema operativo, además de modificar software crítico.

Ataques comunes

Ataques desde el interior

Acceder a las celdas de memoria fuera del área asignada a un proceso, tomando el control del sistema operativo.

Este ataque se controla:

gestionando el control de privilegios a cada proceso

Poner un límite superior e inferior de memoria al proceso

Como apoyo para tener un equipo seguro se ha desarrollado el software de auditoría; este registra series de intentos de inicios de sesión con contraseñas incorrectas, actividades inusuales y la presencia de software espía, conocido como sniffer, que registra las actividades realizadas en el dispositivo.

Ataques desde el exterior

Acceso autorizado: Una cuenta — un registro con el nombre de usuario, contraseña y privilegios

Acceso de administrador: el super usuario puede alterar configuraciones dentro del sistema operativo, modificar los paquetes críticos, ajustar privilegios, y realizar tareas de mantenimiento.

Muchas veces se usa el software malicioso o malware que puede ser transferido a la propia computadora y ejecutado en ella o puede atacar a distancia.

Tipos de malware

Virus: se inserta en los programas de la máquina y cuando se ejecutan también se ejecuta el virus. Pueden corromper al sistema operativo y borrar datos o programas.

Gusano: genera copias de sí mismo para transmitirlas en la red a las computadoras conectadas. Tiene la capacidad de sobrecargar la red con estas copias.

Caballo de Troya: se hace pasar por un programa legítimo y permanecer inactivo hasta que recibe una señal

Spyware: reúne información de la actividad de una computadora

Phishing: permite bloquear el pc desde una ubicación remota y encriptar nuestros archivos. Funciona mediante cebos que piden información con fines supuestamente legítimos

RAT: permite el control remoto del equipo el acceso a llaveros de contraseñas

Otros peligros informáticos

Una computadora también puede ser atacada por software que se esté ejecutando en otras computadoras.

Como ejemplo tenemos el ataque DoS o de negación de servicio en el cual se introduce software malicioso en computadoras para que inunden a la computadora objetivo de mensajes, se sobrecargue y se paralice la actividad.

Spam: es la proliferación de mensajes de correo no deseados

Establecimiento de un servidor clandestino en la computadora objetivo para extraer información.

Protección contra estos ataques

1.- Cortafuegos

Es un programa que filtra el tráfico en un punto de la red para bloquear los mensajes salientes o entrantes con orígenes sospechosos.

2.- Filtros de correo basura

3.- Servidores proxy

software que actúa como intermediario entre un cliente y un servidor con el fin de proteger al cliente de las potenciales acciones adversas llevadas a cabo por el servidor

el cliente será puesto en contacto, en realidad, con el servidor proxy.

el servidor real no tiene manera de saber que el servidor proxy no es el verdadero cliente

4.- Software antivirus

Que tiene que ser constantemente actualizado

Cifrado

El método tradicional para proteger la información es cifrarlo mediante contraseñas. Como estas muchas veces son fácilmente adivinadas, necesitamos mecanismos de cifrado adicionales que permitan esconder la información aunque esté en posesión de las manos equivocadas. Con este fin las aplicaciones tradicionales han establecido protocolos seguros como HTTPS, FTPS, SSL entre otras medidas como la criptografía y las firmas digitales que garantizan que podamos intercambiar información con un sitio de internet de manera segura.

SSL o Secure Sockets Protocol

Es un sistema de protocolos desarrollado originalmente por Net-Scape para proporcionar enlaces de comunicación seguros entre clientes y servidores web.

La criptografía de clave pública nos permite que aunque sepamos cómo están cifrados los mensajes no podamos acceder a ellos, pues se descifran con una clave diferente que es privada.

Firmas digitales

Autoridades de certificación: certificado es un paquete que contiene el nombre de un interlocutor y su clave pública.

¿Qué es la seguridad informática?

Es el conjunto de reglas, mecanismos y acciones que aseguran la información dentro de un sistema de cómputo. Para que un sistema sea considerado seguro debe cumplir con la Tríada de Seguridad:

1.- Confidencialidad: el acceso a la información debe estar restringido

2.- Integridad: la información no debe ser modificada

3.- Disponibilidad: la información debe ser accesible al usuario cuando la requiera

Las brechas de información

Además de fallos al cumplir con la Tríada de Seguridad, las organizaciones lidian con brechas de información por las siguientes causas:

Por no actualizar sus sistemas

Por errores humanos (compartir contraseñas o no cifrar bases de datos)

Malware

Abuso por parte de algún usuario dentro de la organización

Por robo físico de un dispositivo

Hilo de twitter sobre el reporte de PWC y Ciberseguridad:

https://twitter.com/nisara2201/status/1367475191870345218

¿Conoces todas las capas de la web?

En el siguiente video te informamos un poco sobre ellas y qué es la Dark Web.

Hilo de twitter sobre Tor: https://twitter.com/nisara2201/status/1368789620478074882

youtube

Una recomendación extra: Mr. Robot

https://twitter.com/nisara2201/status/1363707262028500996

0 notes

Text

Tratamiento de datos

El procesador o CPU

Es la unidad que controla el tratamiento de los datos

Actualmente mide aprox. 2.5x2.5 cm y se coloca sobre la tarjeta madre

Está compuesto por 3 partes:

1.- Unidad aritmético-lógica o ALU: realiza las operaciones con los datos 2.- Unidad de control: que coordina las actividades de la máquina

¿Cuáles son las funciones de la unidad de control?

Nos ayuda a realizar una operación con datos de la memoria RAM; esta unidad transfiere los datos de la memoria hasta los registros de uso general.

También informa a ALU qué registros contienen los datos y en qué registro debe guardar el resultado

3.- Unidad de registros: nos sirve para almacenar temporalmente la información dentro del procesador. Esta cuenta con registros de uso general.

Registros de uso general

Sirven como almacenamiento temporal para las entradas y resultados de ALU.

¿Cómo se conectan el CPU y la memoria?

A través de hilos de conexión denominados bus. A través del bus el procesador lee los datos de la memoria principal y suministra la dirección de la celda de memoria con una señal que le indica a los circuitos de memoria que deben extraer los datos contenidos en la celda indicada. La función del procesador es indicar la dirección de recuperación de los datos y la dirección de guardado.

Concepto de programa almacenado

Las primeras computadoras eran poco flexibles en cuanto a las operaciones que realizaban, pues sus capacidades estaban integradas en la propia unidad de control.

John Von Neumann cambió esta tendencia, pues propuso que un programa también podía codificarse y almacenarse en la memoria principal como cualquier otro dato. Se puede modificar las capacidades de una computadora simplemente cambiando el contenido de la memoria.

Además de los registros usados para almacenar los datos de las operaciones en proceso y la memoria principal, las computadoras actuales cuentan con un nivel de memoria adicional denominado memoria caché.

Memoria caché: una parte de memoria de alta velocidad dentro del propio procesador; su función es pasar los datos a los registros en vez de que se los pase la RAM. Esta hace que el ciclo de máquina para ejecutar los procesos sea mucho más corto.

LENGUAJE MÁQUINA

Una instrucción a nivel máquina es un comando, un patrón de bits que son capaces de ser reconocidos por el CPU

El lenguaje máquina es el grupo de todas las instrucciones que pueden ser leídas.

Existen dos filosofías de arquitecturas de procesador para poder ejecutar estas instrucciones de lenguaje máquina

RISC (REDUCED INSTRUCTION SET COMPUTER)

Basados en la idea de que un procesador debe ejecutar un conjunto mínimo de instrucciones

Ej: PowerPC (IBM, Motorola, Macintosh) ARM

CISC (COMPLEX INSTRUCTION SET COMPUTER)

Deben ejecutar gran número de instrucciones aun cuando sean redundantes

AMD e INTEL

Problema que tienen estos procesadores: gastan más energía

CLASIFICACIÓN DE LAS INSTRUCCIONES DE LA MÁQUINA

1.- Instrucciones de transferencia de datos: de una ubicación a otra, es más hacer una copia

Se encargan de entradas y salidas de registros a celdas de memoria

2.- Aritmético Lógico: instrucciones que le dicen a la unidad de control que solicite cierta actividad a ALU

3.- Instrucciones de control: dirigen la ejecución del programa, instrucciones JUMP O BRANCH

EJECUCIÓN DE PROGRAMAS

Las computadoras ejecutan un programa almacenado en su memoria en 3 fases conocidas como el ciclo de máquina:

1.-fetch: las instrucciones pasan de la memoria al procesador 2.- decode: cada instrucción se decodifica y evalúa 3.- execute: la instrucción se ejecuta

El reloj es un componente que usa señal eléctrica regular y le dice a la unidad de control cuándo pasar de instrucción. Su velocidad corresponde a la velocidad con la que se ejecuta el ciclo de máquina y se mide en Hertz.

1 Hertz: un ciclo por segundo

Giga Hertz: mil millones de Hertz

Comunicación de la computadora con otros dispositivos

La comunicación entre una computadora y otros dispositivos se gestiona mediante un aparato intermedio denominado controladora.

Esta puede constar de circuitos montados de manera permanente en la placa base de la computadora o puede adoptar la forma de una tarjeta de circuito que se inserta en una de las ranuras de la placa madre.

La controladora se conecta mediante cables a dispositivos periféricos situados dentro de la carcasa de la computadora o a un conector llamado puerto al que se conectan dispositivos externos.

La controladora traduce los mensajes y los datos entre un formato compatible con las características internas de la computadora y el formato compatible con el dispositivo periférico al que está conectada. Los datos se reciben directamente de la controladora en vez de la memoria principal. Este sistema de comunicación se denomina E/S mapeada en memoria. En este, el CPU se comunica con los dispositivos como si fueran celdas de memoria.

Para mejorar la comunicación se han desarrollado una serie de estándares:

El bus serie universal o USB

Firewire

Medios de comunicación populares

La comunicación entre dispositivos es posible gracias a dos tipos de enlaces:

1.- Paralelos: varias señales se transfieren al mismo tiempo a través de una línea separada

2.- En serie: se transfieren señales una detrás de otra a través de una única línea

La transferencia de datos en estas líneas se realiza convirtiendo los patrones de bits en tonos audibles por medio de un módem (modulador-demodulador) que transfiere los tonos al sistema telefónico y luego los convierte a bits en otro módem situado en el destino.

Para comunicaciones a larga distancia las compañías telefónicas ocupan un servicio llamado DSL (Digital Suscriber Line).

DSL usa las frecuencias por encima del rango audible para transferir datos.

Velocidades de comunicación

Se mide normalmente en bits por segundo, Kbps (1000 bps), Mbps (1 millón de bps) y Gbps (mil millones de bps).

A esta velocidad le llamamos tasa de transferencia y es diferente en cada sistema de comunicación.

La tasa máxima disponible en cada sistema se conoce como ancho de banda.

Ejemplos:

DSL ofrece tasas de transferencia de 54 Mbps

La fibra óptica, el cual es un medio de transmisión de datos a través de un hilo en vidrio o plástico por el que pasa una señal luminosa generada mediante un láser o un LED, alcanza velocidades de más de 10 Gbps.

0 notes

Text

Representación de la información

La información de una computadora se codifica y almacena como patrones de bits.

La representación binaria

El uso de dos estados para representar información, encendido y apagado.

Las computadoras pueden representar con el sistema binario números, pero también texto.

Representación de texto

La información en forma de texto se representa por medio de un código en el que se asigna un patrón de bits a cada símbolo que aparece en el texto. Durante la década de 1940 se diseñaron esos códigos para diferentes equipos, lo cual generaba problemas de comunicación entre dispositivos.

Debido a la gran cantidad de letras, símbolos, mayúsculas, minúsculas, dígitos y signos de puntuación fue necesario crear un estándar para la representación de texto, este se llama ASCII.

ASCII fue inventado en 1963 por el instituto ANSI como un código de 7 bits que permitía almacenar 128 valores diferentes. Este hecho permitió que diferentes computadoras producidas por diferentes compañías pudieran intercambiar datos. Esta habilidad para intercambiar información de manera universal se llama interoperabilidad.

Este sistema permitía representar la mayoría de los caracteres necesarios dentro del alfabeto latino, mas otros países como Japón o China contaban con problemas de compatibilidad por las miles de letras que conformaban su idioma.

Para resolver este problema se crea UNICODE en 1192, que llega a reemplazar los diferentes esquemas de codificación que había en cada país. La versión más común de UNICODE usa 16 bits y permite representar todos los caracteres de todos los idiomas.

De la misma manera que UNICODE usa el sistema binario para representar texto, otros formatos de archivo lo usan para representar sonido e imágenes.

Representación de imágenes

Una imagen está formada por una colección de pixeles codificados de acuerdo a la apariencia deseada. A esta colección se le conoce como mapa de bits. Una desventaja de representar las imágenes en mapa de bits es que no puede cambiarse la escala de la imagen sin distorsionarla.

El método mediante el que se codifican varía de una aplicación a otra.

Imágenes a blanco y negro: cada pixel se le asigna un bit

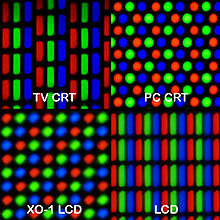

A color: se usa la codificación RGB que requiere de 3 bytes de almacenamiento para representar una imagen o un componente de brillo y 2 de color (luz azul o roja del pixel).

Una forma alternativa de representar imágenes y que no se distorsionen es describir la imagen como una colección de estructuras geométricas

Representación de sonidos

El método más genérico para codificar información de audio consiste en muestrear la amplitud de la onda de sonido a intervalos regulares y grabar la serie de valores obtenidos. Con una serie de números se obtiene la representación de una onda sonora cuya amplitud cambia a lo largo de la canción o sonido.

Tasa de muestreo: muestras por segundo, define la calidad del audio

8000 muestras por segundo basta para llamar por teléfono

44100 muestras por segundo son necesarias para obtener canciones de calidad en un CD

Cada segundo de música requiere de más de un millón de bits, pues los datos obtenidos para cada muestra se presentan mediante 16 bits.

Un sistema de codificación alternativo es MIDI, usado en sintetizadores, se codifican las instrucciones para la generación de música en vez de codificar el sonido.

Representación de números

El sistema más popular para la representación de enteros es la notación en complemento a dos, el cual utiliza un número fijo de bits para representar los valores del sistema, generalmente 32.

En este sistema el bit de la izquierda de cada patrón de bits indica el signo del valor representado; es el bit de signo. Positivo es cero y negativo es 1.

Este sistema cuenta con un límite para el tamaño de los valores que se pueden representar, lo cual nos lleva a un problema de desbordamiento, el cual se produce cuando un cálculo genera un valor que cae fuera del rango de valores que puede representarse. Lo podemos identificar cuando la suma de dos valores positivos da como resultado un patrón que corresponde a un valor negativo o si la suma de dos valores negativos da como resultado un valor positivo.

Números decimales o notación en punto flotante

Para representar números decimales utilizamos un punto de separación que cumple el mismo papel que el punto decimal. Los dígitos situados a la izquierda representan la parte entera del valor y los de la derecha representar la parte decimal.

Métodos: IEEE 754 estándar que los almacena en notación científica usando 32 bits. Este formato utiliza 1 bit para el signo, 8 bits para el exponente (con notación en exceso) y 23 bits para la mantisa.

COMPRESIÓN DE DATOS

Frecuentemente es útil reducir el tamaño de los datos a manipular a la vez que se conserva la información subyacente.

Los esquemas de compresión se clasifican en: con pérdidas y sin pérdidas, dependiendo de si se pierde o no información.

Algunas técnicas usadas para comprimir datos sin pérdidas

Codificación por longitud de secuencia: sustituir secuencias de elementos de datos con un código que indica el elemento repetido y el número de veces que aparece dentro de la secuencia.

Codificación relativa: cada unidad se expresa en términos de su relación con la unidad anterior, se almacenan las diferencias entre unidades de datos consecutivas, en vez de almacenar las unidades completas.

Codificación por diccionario

Algunos formatos sin pérdidas son:

GIF, PNG, PDF, ZIP, TIFF

WAV, FLAG

Técnicas con pérdidas

Estas técnicas generalmente se usan para representar sonido o imágenes jugando con la percepción humana, pues en algunos casos es incapaz de distinguir la diferencia.

En sonido uno de los estándares más utilizados para la codificación y compresión de audio es MP3. Esto reduce el tamaño del archivo casi 10 veces a través del enmascaramiento de frecuencia (un sonido fuerte tiende a enmascarar unos débiles después)

En imágenes el más popular es JPEG: toma imágenes en bloques de 8x8 pixeles, generalmente reduce una tercera parte

En video: MPEG-4, el cual cuando hay pocas diferencias entre frames (por ejemplo un mismo escenario o paisaje) comprime

0 notes

Text

Almacenamiento de datos

Actualmente, la información dentro de una computadora se codifica y se almacena en forma de patrones de 0’s y 1’s, que representan dos estados, gracias a la implementación del sistema binario. A cada uno de estos dígitos se le denominan binary digits o bits. Estos patrones no solo sirven para representar números, sino sonidos e imágenes.

La manipulación de bits se realiza a través de operaciones booleanas; las más básicas son xor, and y or que corresponden a operaciones lógicas para combinar un par de valores y generar una salida o resultado. En este tipo de operaciones los valores que pueden introducir corresponden solamente a dos: verdadero y falso que, dentro de una computadora, corresponden a 0’s y 1's.

Un dispositivo que representa una operación booleana se denomina puerta lógica. Actualmente estas puertas se implementan con circuitos electrónicos en que los dígitos 0 y 1 representan niveles de tensión.

Los biestables son circuitos compuestos por puertas lógicas que generan un valor de salida igual a 0 o 1, que permanece constante hasta que un pulso generado por otro circuito hace que el biestable conmute a otro valor.

Gracias a los biestables podemos almacenar bits dentro de una computadora, haciendo que el valor de salida sea 0 o 1. Otros circuitos pueden ajustar este valor introduciendo al biestable nuevos valores u ocupar su valor actual como de entrada; con estos se construyen a través de la tecnología VLSI (Very large-scale Integration), que permite construir millones de componentes eléctricos en una oblea, los chips.

Si ponemos 8 biestables, podemos guardar 8 bits de información o un byte.

Un grupo de biestables funcionando de esta manera es un registro y el número de bits en un registro es ancho.

Actualmente se ponen en forma de matriz. La dirección se define por la intersección dentro de esta matriz, la dirección es un número de 4 bits.

¿Qué significa que tu computadora sea de 32 o 64 bits?

Que operan en pedazos de 32 o 64 bits

El número más grande que se puede representar con 32 bits es 4.3 billon

Notación hexadecimal

Para simplificar la representación de patrones de bits usamos la notación hexadecimal, aprovechando que estos patrones tienen una longitud que es múltiplo de cuatro. Esta ocupa un único símbolo para representar un patrón de 4 bits.

MEMORIA PRINCIPAL

Una computadora está compuesta por un gran conjunto de circuitos, al que denominamos, memoria principal, que almacena cada uno un único bit.