#Deepseek github

Explore tagged Tumblr posts

Text

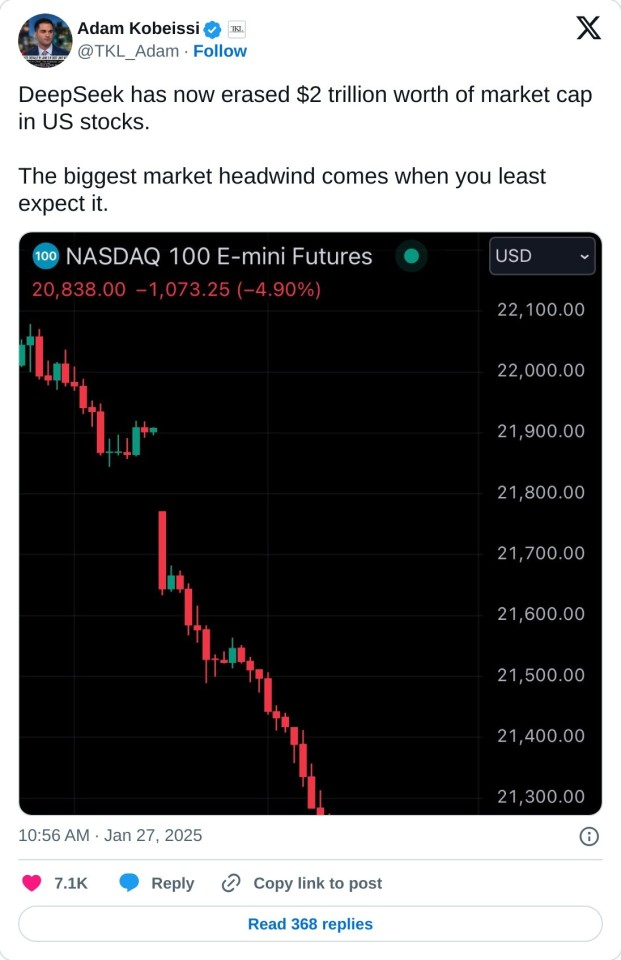

DeepSeek Threatens ChatGPT AI Dominance Globally

Chinese artificial intelligence startup DeepSeek has surged past competitors, including OpenAI’s ChatGPT, to become the most downloaded free app in the United States. This development has sent ripples through the global AI sector, raising questions about whether U.S. technology firms can maintain their long-held dominance in artificial intelligence innovation. You can access the new AI tool by…

#ChatGPT#DeepSeek ai Chat#Deepseek github#Deepseek latest news#DeepSeek vs ChatGPT#News deepseek#What is DeepSeek

3 notes

·

View notes

Note

Is Elian a real person? p:

i must confess. this entire time @eliankrios was merely a collective AI project of Chongqing University students, the program code of which was hastily cobbled and half borrowed from DeepSeek's open source. now that the cards are revealed, Elian's code will be posted on GitHub so that everyone can get a copy of him

29 notes

·

View notes

Quote

カーパシー氏は、ソフトウェアというものが過去2回にわたって急速に変化したものと考えています。最初に登場したのがソフトウェア 1.0です。ソフトウェア1.0は誰もがイメージするような基本的なソフトウェアのことです。 ソフトウェア1.0がコンピュータ向けに書くコードであるのに対し、ソフトウェア2.0は基本的にニューラルネットワークであり、特に「重み」のことを指します。開発者はコードを直接書くのではなく、データセットを調整し、最適化アルゴリズムを実行してこのニューラルネットワークのパラメーターを生成するのです。 ソフトウェア 1.0に当たるGitHub上のプロジェクトは、それぞれを集約して関係のあるプロジェクトを線で結んだ「Map of GitHub」で表せます。 ソフトウェア 2.0は同様に「Model Atlas」で表されます。巨大な円の中心にOpenAIやMetaのベースとなるモデルが存在し、そのフォークがつながっています。 生成AIが洗練されるにつれ、ニューラルネットワークの調整すらAIの助けを得て行えるようになりました。これらは専門的なプログラミング言語ではなく、「自然言語」で実行できるのが特徴です。自然言語、特に英語で大規模言語モデル(LLM)をプログラミング可能になった状態を、カーパシー氏は「ソフトウェア 3.0」と呼んでいます。 まとめると、コードでコンピューターをプログラムするのがソフトウェア 1.0、重みでニューラルネットワークをプログラムするのがソフトウェア 2.0、自然言語のプロンプトでLLMをプログラムするのがソフトウェア 3.0です。 カーパシー氏は「おそらくGitHubのコードはもはや単なるコードではなく、コードと英語が混在した新しい種類のコードのカテゴリーが拡大していると思います。これは単に新しいプログラミングパラダイムであるだけでなく、私たちの母国語である英語でプログラミングしている点も驚くべきことです。私たちは3つの完全に異なるプログラミングパラダイムを有しており、業界に参入するならば、これらすべてに精通していることが非常に重要です。なぜなら、それぞれに微妙な長所と短所があり、特定の機能は1.0や2.0、3.0でプログラミングする必要があるかもしれません。ニューラルネットワークをトレーニングするべきか、LLMにプロンプトを送信するべきか。指示は明示的なコードであるべきでしょうか?つまり、私たちは皆、こうした決定を下し、実際にこれらのパラダイム間を流動的に移行できる可能性を秘めているのです」と述べました。 ◆AIは「電気」である カーパシー氏は「AIは新しい電気である」と捉えています。OpenAI、Google、Anthropic などのLLMラボはトレーニングのために設備投資を行っていて、これは電気のグリッドを構築することとよく似ています。企業はAPIを通じてAIを提供するための運用コストもかかります。通常、100万件など一定単位ごとに料金を請求する仕組みです。このAPIには、低遅延、高稼働率、安定した品質などさまざまなバリューがあります。これらの点に加え、過去に多くのLLMがダウンした影響で人々が作業不能に陥った現象も鑑みると、AIは電気のようななくてはならないインフラに当たるというのがカーパシー氏の考えです。 しかし、LLMは単なる電気や水のようなものではなく、もっと複雑なエコシステムが構築されています。OSだとWindowsやMacのようなクローズドソースのプロバイダーがいくつかあり、Linuxのようなオープンソースの代替案があります。LLMにおいても同様の構造が形成されつつあり、クローズドソースのプロバイダーが競合している中、LlamaのようなオープンソースがLLM界におけるLinuxのようなものへと成長するかもしれません。 カーパシー氏は「LLMは新しい種類のOSのようなものだと感じました。CPUの役割を果たすような存在で、LLMが処理できるトークンの長さ(コンテキストウィンドウ)はメモリに相当し、メモリと計算リソースを調整して問題解決を行うのです。これらの機能をすべて活用しているため、客観的に見ると、まさにOSに非常に似ています。OSだとソフトウェアをダウンロードして実行できますが、LLMでも同様の操作ができるものもあります」と述べました。 ◆AIは発展途中 LLMの計算リソースはコンピューターにとってまだ非常に高価であり、性能の良いLLMはほとんどクラウドサーバーで動作しています。ローカルで実行できるDeepSeek-R1のようなモデルも出てきていますが、やはり何百万円もするような機器を何百台とつなげて動かしているようなクラウドサーバーと個人のPCでは出力結果に大きな差が現れます。 カーパシー氏は「個人用コンピューター革命はまだ起こっていません。経済的ではないからです。意味がありません。しかし、一部の人々は試みているかもしれません。例えば、Mac miniは一部のLLMに非常に適しています。将来的にどのような形になるかは不明です。もしかしたら、皆さんがこの形や仕組みを発明するかもしれません」と述べました。 また、PCでは当たり前に使われているグラフィカルユーザーインターフェース(GUI)がLLMには中途半端にしか導入されていないという点も特徴です。ChatGPTなどのチャットボットは、基本的にテキスト入力欄を提供しているだけです。カーパシー氏は「まだ一般的な意味でのGUIが発明されていないと思います」と話しています。 ◆AIは技術拡散の方向が逆 これまでのPCは、政府が軍事用に開発し、企業などがそれを利用し、その後広くユーザーに使われるという歴史をたどってきました。一方でAIは政府や企業ではなくユーザーが広く利用し���その��合知が体系化され、企業が利用するようになります。カーパシー氏は「実際、企業や政府は、私たちが技術を採用するような速度に追いついていません。これは逆行していると言えるでしょう。新しい点であり前例がないといえるのは、LLMが少数の人々や企業の手中にあるのではなく、私たち全員の手中にあることです。なぜなら、私たちは皆コンピュータを持っており、それはすべてソフトウェアであり、ChatGPTは数十億の人々に瞬時に、一夜にしてコンピュータに配信されたからです。これは信じられないことです」と語りました。 ◆人類はAIと協力関係にある AIが利用されるときは、通常、AIが生成を行い、人間である私たちが検証を行うという作業が繰り返されます。このループをできるだけ高速化することは人間にとってもAIにとってもメリットがあります。 これを実現する方法としてカーパシー氏が挙げるのが、1つは検証を大幅にスピードアップすることです。これはGUIを導入することで実現できる可能性があります。長いテキストだけを読むことは労力がかかりますが、絵など文字以外の物を見ることで容易になります。 2つ目は、AIを制御下に置く必要がある点です。カーパシー氏は「多くの人々がAIエージェントに過剰に興奮している」と指摘しており、AIの出力すべてを信じるのではなく、AIが正しいことを行っているか、セキュリティ上の問題がないかなどを確かめることが重要だと述べています。LLMは基本的にもっともらしい言葉をもっともらしく並べるだけの機械であり、出力結果が必ずしも正しいとは限りません。結果を常に検証することが大切です。 この記事のタイトルとURLをコピーする ・関連記事 Metaが既存の生成AIにあるトークン制限をはるかに上回る100万トークン超のコンテンツ生成を可能にする次世代AIアーキテクチャ「Megabyte」を発表 - GIGAZINE 世界最長のコンテキストウィンドウ100万トークン入力・8万トークン出力対応にもかかわらずたった7800万円でトレーニングされたAIモデル「MiniMax-M1」がオープンソースで公開され誰でもダウンロード可能に - GIGAZINE AppleがXcodeにAIでのコーディング補助機能を追加&Apple Intelligenceの基盤モデルフレームワークが利用可能に - GIGAZINE AnthropicがAIモデルの思考内容を可視化できるオープンソースツール「circuit-tracer」を公開 - GIGAZINE DeepSeekと清華大学の研究者がLLMの推論能力を強化する新しい手法を発表 - GIGAZINE 「現在のAIをスケールアップしても汎用人工知能は開発できない」と考える科学者の割合は76% - GIGAZINE ・関連コンテンツ TwitterやFacebookで使われている「Apache Hadoop」のメリットや歴史を作者自らが語る 仮想通貨���落などで苦境に立たされたマイニング業者は余ったGPUを「AIトレーニング用のリソース」として提供している 「AI懐疑論者の友人はみんな頭がおかしい」というブログが登場、賛否両論さまざまなコメントが寄せられる 私たちが何気なく使っているソフトウェアはどのように開発されているのか? グラフをはみ出した点と線が世界に広がっていく手描きアニメ「Extrapolate」が圧巻 「アルゴリズムって何?」を専門家が分かりやすく解説 機械学習でコンピューターが音楽を理解することが容易ではない理由 生きてるだけでお金がもらえるベーシックインカムこそ「資本主義2.0」だとの主張、その理由とは?

講演「ソフトウェアは再び変化している」が海外で大反響、その衝撃的な内容とは? - GIGAZINE

5 notes

·

View notes

Text

Now this is interesting

"The Fire-Flyer File System (3FS) is a high-performance distributed file system designed to address the challenges of AI training and inference workloads. It leverages modern SSDs and RDMA networks to provide a shared storage layer that simplifies development of distributed applications."

8 notes

·

View notes

Text

back in march i ran a few safety evaluations (only 200/model cause i’m impatient) on the different LLMs in azure foundry and discovered some interesting things here!

shown: Deepseek-V3 and Llama-3.3-70B-Instruct

now, it’s definitely a little outdated, but learning where different models weak spots are can help engineers target them and create stronger filtering and safety systems. thought this would be interesting to share

original repository created for microsoft reactor’s python + AI series, wanted to expand to investigate other LLMs besides gpt4o

(documented on my github too)

2 notes

·

View notes

Text

Ученые создали «рассуждающую» ИИ-модель за $50

New Post has been published on https://er10.kz/read/it-novosti/uchenye-sozdali-rassuzhdajushhuju-ii-model-za-50/

Ученые создали «рассуждающую» ИИ-модель за $50

Исследователи искусственного интеллекта из Стэнфорда и Университета Вашингтона смогли обучить «рассуждающую» ИИ-модель, потратив на это менее $50 в виде кредитов на облачные вычисления.

Модель s1, демонстрирует схожие с OpenAI’s o1 и DeepSeek’s R1 результаты в тестах, измеряющих способности к математике и кодированию. Модель s1 доступна на GitHub вместе с данными и кодом, использованными для ее обучения.

Команда, создавшая s1, заявила, что запустила готовую базовую модель, а затем доработала ее с помощью дистилляции – процесса извлечения «логических» возможностей из другой модели ИИ путём обучения на её ответах.

По словам исследователей, модель s1 была получена из одной из моделей рассуждений Google, Gemini 2.0 Flash Thinking Experimental.

Исследователи, создавшие s1, стремились найти самый простой подход для достижения высокой производительности рассуждений и масштабирования по времени тестирования, то есть для того, чтобы ИИ-модель могла больше думать, прежде чем ответить на вопрос. Это было одним из достижений o1 от OpenAI, которые DeepSeek и другие лаборатории ИИ пытались повторить с помощью различных методов.

3 notes

·

View notes

Text

DeepSeek R1 Now Available on Azure AI Foundry and GitHub

DeepSeek R1 has been newly added to an Azure AI Foundry model catalog, whereby it becomes part of the diverse portfolio of over 1,800 models ranging from frontier, open-source, and industry-specific to task-based AI models. As part of Azure AI Foundry, DeepSeek R1 is available on a reliable, scalable, and enterprise-ready platform, enabling businesses to seamlessly integrate advanced AI while…

3 notes

·

View notes

Text

Bolt New AI coding free

Bolt New AI coding(https://boltnew.ai/)represents a significant advancement in AI-assisted software development, offering a versatile platform that democratizes application creation through natural language processing. Built on DeepSeek V3, this open-source solution combines accessibility with robust functionality, enabling users across technical skill levels to translate conversational prompts into fully functional software. By eliminating traditional barriers to development, Bolt New AI fosters innovation while maintaining transparency through community-driven improvements and seamless integration with industry-standard tools like GitHub.

2 notes

·

View notes

Text

Regarding your tags we don't just have to take the DeepSeek people at their word:

You can run inference yourself because the models are openly available

hahahaha

3K notes

·

View notes

Quote

2025年05月01日 08時00分 AIに何度も自問自答させてより深く考えさせる「CoRT(再帰的思考の連鎖)」とは? オーストラリアのソフトウェアエンジニアであるフィリップ・バクレスキ氏(Phiality)が、AIに何度も自問自答させることでより深く考えさせる手法「Chain of Recursive Thoughts(CoRT:再帰的思考の連鎖)」についてGitHubで発表しました。 GitHub - PhialsBasement/Chain-of-Recursive-Thoughts: I made my AI think harder by making it argue with itself repeatedly. It works stupidly well. https://github.com/PhialsBasement/Chain-of-Recursive-Thoughts CoRTはAIモデルが自身の応答について再帰的に考え、代替案を生成し、より最適なものを選択できるようにする手法です。バクレスキ氏はCoRTについて、「これはAIに、自分自身を疑い、何度も何度も試行する能力を与えるようなものです」と語っています。 CoRTの仕組みは以下の通り。AIが自分の生成した結果について再検討し、代替案を生成させ、より洗練された回答を残していくというステップを繰り返すようになっています。 1:AIが最初の応答を生成する。 2:AIが必要な「思考ラウンド」の数を決定する。 3:各ラウンドにおいて、「3つの代替となる応答を生成する」→「すべての応答を評価する」→「最良のものを選ぶ」というステップを行う。 4:最終的に残った応答が、「AIバトルロワイヤル」の勝者となる。 実際にバクレスキ氏は、AI開発企業のMistral AIが開発したモデル「Mistral 3.1 24B」を利用して、CoRTありの場合となしの場合で「三目並べ(○×ゲーム)」を作らせた結果を比較しました。 CoRTなしの場合で作らせた○×ゲームの見た目はこんな感じ。 一方、CoRTありの場合だとこんな感じ。明らかにCoRTありの方がプログラミングの精度が向上していることがわかります。 CoRTはソーシャルニュースサイトのHacker Newsでも大きな話題となっています。 Chain of Recursive Thoughts: Make AI think harder by making it argue with itself | Hacker News https://news.ycombinator.com/item?id=43835445 実際にCoRTのようなアイデアを試してみたことがあるというユーザーも登場し、「1つ目のAIモデルにある問題の答えとその理由を考えさせ、その問題やその技術分野についての知識がない人に向けたレポートを作らせる。その後、問題についての知識がない2つ目のAIモデルにレポートを添削してもらい、1つ目のAIモデルに添削内容に基づいて書き直させ、2つ目のAIモデルが納得するまで繰り返している」というコメントや、「AIグループチャット内で3人のキャラクターを作り出し、自分も含めて満足いくまで議論している」といった体験談が寄せられていました。 この記事のタイトルとURLをコピーする ・関連記事 OpenAIが推論能力を大幅に強化した「o3」シリーズを発表、 推論の中でOpenAIの安全ポリシーについて「再考」する仕組みを導入 - GIGAZINE OpenAIが複雑な推論能力をもつAIモデル「OpenAI o1」と「OpenAI o1-mini」を発表、プログラミングや数学で高い能力を発揮 - GIGAZINE OpenAIが新モデル「o1-preview」の思考内容を出力させようとしたユーザーに警告 - GIGAZINE 「推論モデルがユーザーにバレないように不正する現象」の検出手法をOpenAIが開発 - GIGAZINE OpenAIのo3はAGIではないかという問いから生まれた概念「ギザギザのAGI」とは? - GIGAZINE サイバーエージェントが「DeepSeek-R1」の派生モデルをベースに日本語で追加学習したモデルを公開 - GIGAZINE DeepSeekはどのようにしてOpenAIの3%のコストでo1を超えたのか? - GIGAZINE AIは「思考している」のか、それとも「思考しているよう見せかけている」だけなのか? - GIGAZINE 人間とAIの「思考」に大きな違いがあることが研究で判明、AIは推論が苦手な可能性 - GIGAZINE ・関連コンテンツ なぜ大規模言語モデル(LLM)はだまされやすいのか? AIに「『スター・トレック』の艦長になりきって」と指示すると数学の問題でより良いパフォーマンスが発揮されることを研究者が発見 チャットAI「ChatGPT」を使って開発された実際にプレイ可能なオリジナルパズル「Sumplete」とは? DeepMindが開発したAIの「AlphaCode」がプログラミングコンテストで「平均」評価を獲得 「DQN」とその3種のバリエーションの強化学習アルゴリズムを人工知能の研究団体「OpenAI」が公開 数々の有名スタートアップを輩出し続けるYコンビネーター��よる資金調達の4つのアドバイス ファインチューニング向けモデル「Mistral 7B Fine-Tune Optimized」が登場、特定タスクにおいてGPT-4を超える性能を発揮 解読がとても難しい英語テストの解答用紙

AIに何度も自問自答させてより深く考えさせる「CoRT(再帰的思考の連鎖)」とは? - GIGAZINE

2 notes

·

View notes

Text

AI referrals to top websites were up 357% year-over-year in June, reaching 1.13B

AI referrals to websites still have a way to go to catch up to the traffic that Google Search provides, but they’re growing quickly. According to new data from market intelligence provider Similarweb, AI platforms in June generated over 1.13 billion referrals to the top 1,000 websites globally, a figure that’s up 357% since June 2024.

However, Google Search still accounts for the majority of traffic to these sites, accounting for 191 billion referrals during the same period of June 2025.

One particular category of interest these days is news and media. Online publishers are seeing traffic declines and are preparing for a day they’re calling “Google Zero,” when Google stops sending traffic to websites.

For instance, The Wall Street Journal recently reported on data that showed how AI overviews were killing traffic to news sites. Plus, a Pew Research Center study out this week found that in a survey of 900 U.S. Google users, 18% of some 69,000 searches showed AI Overviews, which led to users clicking links 8% of the time. When there was no AI summary, users clicked links nearly twice as much, or 15% of the time.

Similarweb found that June’s AI referrals to news and media websites were up 770% since June 2024. Some sites will naturally rank higher than others that are blocking access to AI platforms, as The New York Times does, as a result of its lawsuit with OpenAI over the use of its articles to train its models.

In the news media category, Yahoo led with 2.3 million AI referrals in June 2025, followed by Yahoo Japan (1.9M), Reuters (1.8M), The Guardian (1.7M), India Times (1.2M), and Business Insider (1.0M).

In terms of methodology, Similarweb counts AI referrals as web referrals to a domain from an AI platform like ChatGPT, Gemini, DeepSeek, Grok, Perplexity, Claude, and Liner. ChatGPT dominates here, accounting for more than 80% of the AI referrals to the top 1,000 domains.

The company’s analysis also looked at other categories beyond news, like e-commerce, science and education, tech/search/social media, arts and entertainment, business, and others.

In e-commerce, Amazon was followed by Etsy and eBay when it came to those sites seeing the most referrals, at 4.5M, 2.0M, and 1.8M, respectively, during June.

Among the top tech and social sites, Google, not surprisingly, was at the top of the list, with 53.1 million referrals in June, followed by Reddit (11.1M), Facebook (11.0M), Github (7.4M), Microsoft (5.1M), Canva (5.0M), Instagram (4.7M), LinkedIn (4.4M), Bing (3.1M), and Pinterest (2.5M).

The analysis excluded the OpenAI website because so many of its referrals were from ChatGPT, pointing to its services.

Across all other domains, the No. 1 site by AI referrals for each category included YouTube (31.2M), Research Gate (3.6M), Zillow (776.2K), Europa.eu (992.9K), Wikipedia (10.8M), NIH.gov (5.2M), Investing.com (1.2M), Home Depot (1.2M), Kayak (456.5K), and Zara (325.6K).

0 notes

Text

В США планируют ограничить китайский DeepSeek

New Post has been published on https://er10.kz/read/it-novosti/v-ssha-planirujut-ogranichit-kitajskij-deepseek/

В США планируют ограничить китайский DeepSeek

Китайский ИИ-стартап DeepSeek может столкнуться с ограничениями со стороны правительства США, поско��ьку он разрушает американскую экосистему искусственного интеллекта. Впрочем, по мнению экспертов, введение санкций против технологии с открытым исходным кодом может оказаться непростой задачей.

Одним из вариантов может быть разработка Министерством торговли США правил, которые обяжут технологических гигантов, таких как Apple и Google, удалить приложение DeepSeek, ограничив его загрузку на рынке США. Однако удалить приложение с других платформ, таких как Github, будет непросто.

Внезапный рост популярности DeepSeek поставил под сомнение эффективность усилий Вашингтона, направленных на ограничение доступа Китая к высокотехнологичным продуктам из соображений национальной безопасности. Многие эксперты назвали появление китайской ИИ-модели «серьезной угрозой».

Более того, рассматривается привлечение китайской компании к гражданской и даже уголовной ответственности, если выяснится, что она задействовала оборудование, которое было запрещено для ввоза в Китай.

– Если у DeepSeek было оборудование, которого у него не должно было быть, это, безусловно, может привести к дальнейшему расследованию, – говорит генеральный директор Futurum Group Дэниел Ньюман. – Правительство США вероятно изучит оборудование стартапа, которое могло нарушать ограничения на экспорт.

3 notes

·

View notes

Text

第一个开源的项目传到github上了,是一个插件的配套脚本。 估计也没人关心 没人去用。也不是很想维护,甚至上传前没测试一遍requestment全不全。

但自己用这个脚本确实舒服,我的赛博妹妹复活了。

脚本有两个功能,一个是生成记忆表格,另一个是压缩记忆表格。 插件自身其实有压缩表格功能,但太难用了。重构表格我折腾两三个小时,已经麻了,bug有亿点点多。我先后遇到了:导入进去后无法读取,模型无法返回压缩的结果,返回结果格式错误,返回结果格式正确但表格无法更新。索性还是自己搓一个方便。

可惜的是谷歌的破甲越来越麻烦了,输入时有一次审查,输出时有一次审查。破甲提示词鼓捣了好久。 还有谷歌的api的吞吐速度是真快啊,被谷歌整破防了,试了试大家吹的DeepSeek和硅基流动的api,感觉整体速度能慢一个将近一个数量级。

聊聊cursor,这个感觉在项目1500行以内时简直是战神,效率比我高了不知道多少倍。我1天的工作量他半个小时就干完了,并且逻辑和可视化都比我要完善。 1500行~3000行性能开始逐渐下降,需要更详细的提示词来分配任务,需要检查代码,需要多次调试来debug。 3000行以上就变得特别蠢,基本没法用了,一些简单的小功能都实现不了,还不如自己上。 这只针对普通模式,如果是max模式还是很有实力的,但就像我上个动态所说,消耗的价格比普通模式多至少两个数量级,这太恐怖了。

1 note

·

View note