#Architecture monolithique

Explore tagged Tumblr posts

Text

Ellora : Le Plus Grand Temple Monolithique du Monde et Ses Secrets

Les grottes d'Ellora et Ajanta vous transportent à travers le temps, dévoilant les trésors artistiques et spirituels de l'Inde ancienne. Découvrez ces merveilles lors de votre prochain voyage solo ! ✨🌏 #GrottesEllora #VoyageEnInde #PatrimoineUNESCO

À la Découverte des grottes d’Ellora : Un Trésor Spirituel et Architectural Aujoud´hui nous largons les amares et commençons un tour du monde anciens et le mystère de ses mégastructures. comme celles qu’on peut trouver dans les grottes de Ellora y Ajanta de le Maharashtra. Maharashtra : Sur les Traces du Monde Ancien avec les Grottes d’Ellora Voyager en solo en Inde est une aventure en soi,…

#365JoursDeVoyage#Architecture monolithique#Art indien ancien#Aventure en Inde#Découverte#Découverte spirituelle#Exploration Inde#Grottes Ellora#Histoire ancienne Inde#Inde#Inspiration de Voyage#Méga structures#Monuments anciens#Noirenvoyage#Patrimoine mondial#Patrimoine UNESCO#Sites historiques Inde#Spiritualité indienne#Tourisme culturel Inde#Tourisme durable#Trésors cachés Inde#Unesco#Voyage culturel#Voyage hors des sentiers battus#Voyage solo

1 note

·

View note

Text

Les Bases [Saint-Denis-sur-Richelieu] par Écorce architecture écologique

- -

« La conception architecturale des volumes s’inspire des anciennes maisons environnantes, en privilégiant la sobriété par la symétrie et la séparation fonctionnelle. Un volume bas et délicat accueille les espaces de nuit, tandis qu’un volume plus haut et prédominant démarque les espaces de vie.

Nous avons également incorporé et réinterprété des éléments singuliers et représentatifs de ce contexte, tels que les cheminées au toit et les jeux de volumes.

Le projet a été conceptualisé selon les principes de passivhaus, atteignant un taux de changement d’air à l’heure de 0.27 CAH@50Pa et en tirant parti des avantages bioclimatiques tels que l’orientation solaire et la ventilation naturelle. Les ouvertures ont été soigneusement conçues pour optimiser la luminosité naturelle sans provoquer de surchauffe.

L’aspect écologique a été mis de l’avant par la construction d’une enveloppe hautement performante, avec une isolation supérieure de 30 % par rapport au code de construction, ce qui permet d’atteindre un score de 47 sur l’échelle du Home Energy Rating System. Cela signifie que Les Bases est 53 % plus efficace sur le plan énergétique qu’une habitation standard neuve. De plus, des principes tels que la charpente avancée, qui réduit la quantité de structure nécessaire à la construction tout en maximisant l’isolation, et l’utilisation d’une dalle monolithique sur le sol, permettent de réduire l’empreinte carbone du projet, son impact environnemental et de garantir sa durabilité et sa résilience pour les années à venir. La résidence est en voie de certification LEED de niveau platine. »

- -

Architecte : Emerick Duquette

Photographe : Maxime Brouillet

Constructeur : Noveco Entrepreneur Général

2 notes

·

View notes

Text

Néo concept dataweb: "datamarts"

Journal du Net > Solutions > "Nous sommes prêts pour le concept du dataweb"

http://www.journaldunet.com/solutions/0105/010503_it_cognos_lutge.shtml

1"Nous sommes prêts pour le concept du dataweb"

En parallèle avec d'autres éditeurs comme Informatica (voir interview du 25/04/2001), Cognos s'est engagé dans le packaging métier de son offre décisionnelle de bout en bout derrière le terme e-Apps.

Son secret de fabrication : des datamarts, sortes d'entrepôts de données fonctionnels, verticaux et pré-paramétrés.

Sans se soucier de la mauvaise passade boursière, l'éditeur déclare un chiffre d'affaires en hausse qui passe à plus de 495 millions de dollars en 2000-2001 (385,6 millions de dollars pour l'exercice précédent). Afin d'approfondir le thème des nouvelles architectures décisionnelles, nous avons rencontré Patrick Lutgé, directeur général France et vice-président Europe du Sud de Cognos.

JDNet Solutions : Cognos est souvent vu comme un éditeurs d'outils de reporting. Dans les faits, quelles parties de la chaîne décisionnelle recouvrez-vous ?

Nous sommes le n°1 mondial en terme de CA du marché de la business intelligence. Nous avons près de 750 développeurs à Ottawa, qui ont développé un ensemble d'outils qui couvrent la totalité de la chaîne en rapport avec la business intelligence. Et nous sommes les seuls à proposer une telle couverture.

Qu'apportez-vous aujourd'hui de plus avec votre nouvel outil d'ETL, ✓Decision Stream ?

Nous savons prendre n'importe quelle donnée dans n'importe quel ERP. Ensuite, Decision Stream permet de fabriquer des datamarts coordonnés qui peuvent être lus à partir d'un portail.

Ces marts sont élaborés en fonction du profil d'usage de l'utilisateur. Decision Stream, qui s'occupe de les coordonner, comprend des fonctions d'ETL mais ne s'occupe pas que de consolidation des données. L'utilisateur peut également vouloir modifier la façon dont les marts sont coordonnés.

Des "datamarts coordonnés" : de quoi s'agit-il exactement ? Et en quoi est-ce important de modifier cette coordination ?

Dossier: business

intelligence Artificielle

> Comprendre la chaine du décisionnel

> Questions-réponses

> Comment Marsh France décide sans complexe avec Brio Dans une société, la première dimension de coordination est le temps. Or, cette dimension doit être coordonnée dans un sens identique pour chacun.

Lorsque Decision Stream fabrique des ∆cubes de données, il connaît les aggrégats et les indicateurs, ainsi que les axes de dimensionnement en fonction desquels ils sont exprimés, qui devront être produits en bout de chaîne par les outils de reporting. Or, un axe de dimensionnement donné correspond à un axe de l'entreprise. Par conséquent, à chaque fois que Decision Stream fabrique un datamart, il organise ses dimensions en prenant en compte directement celles de l'entreprise, qui peuvent être des axes temps, produits, chiffre d'affaires, etc. Et ce faisant, les marts sont coordonnés selon ces axes. Car le datamart comprend des axes propres à un département, mais aussi des axes en commun.

Pourquoi ne pas rester dans une logique de datawarehouse (entrepôt de données) centralisé ?

Lorsque l'entreprise dispose d'un seul et énorme datawarehouse, chaque utilisateur récupère pour son département des données qui ne l'intéressent pas forcément.

De plus, la modélisation globalisante entraînée par la centralisation oblige à créer une structure monolithique. Ce qui pose toute une série de problèmes, aussi bien en terme de maintenance et de mise à jour, que d'accès aux données. Et enfin, aujourd'hui, les évolutions rapides que connaissent les entreprises les obligent à changer souvent leurs structures monolithiques complexes.

Par rapport à cela, la première réponse consiste à couper le datawarehouse en rondelles, avec une partie commerciale pour les forces de vente, etc. Mais là, l'entreprise perd la synchronisation et la cohérence de ses modèles de données. Peut-être existe-t-il des axes communs, mais pas de façon automatique. En réponse, nous proposons donc un datawarehouse coordonné entre plusieurs datamarts. Et nous obtenons le meilleur des deux mondes : la coordination des marts au moment de leur construction, et la facilité de maintenance.

Comment un datamart se conçoit-il ?

Tout d'abord, nous élaborons une table avec des indexes différents pour accéder aux informations. Cette table représente le modèle physique pour implémenter le modèle logarythmique de l'hypercube, qui est un schéma en étoile. Par exemple, nous pouvons figurer un cube à plusieurs dimensions, comme le temps ou le chiffre d'affaires, qui sera divisé ensuite en cubes plus détaillés, pouvant chacun correspondre aux différentes régions.

Ici aussi, notre modèle présente un avantage avec ses trois niveaux d'indépendance : entre les structures de cubes, entre les lieux où les différents cubes sont situés pour la synchronisation, et entre les autorités en charge des droits d'accès.

Comment l'idée de commercialiser des solutions pré-packagées vous est-elle venue ?

Il y a quelque temps, nous avons sorti un livre intitulé "The 24 Ways" qui donnait les "best practices", c'est à dire les indicateurs les plus significatifs pour les entreprises. Pour cela, nous nous sommes associé avec une société qui nous a aidé à extraire les 24 cubes de base. Et derrière, nous nous sommes dits que nous allions l'implémenter dans notre offre.

C'est pourquoi nous avons fabriqué les e-Apps, qui définissent à la fois d'où les données doivent être extraites, et la façon dont les marts doivent être conçus en fonction des indicateurs de performance clefs.

Quel degré de packaging proposez-vous ?

Quand l'entreprise achète une solution e-Apps, elle reçoit un CD-Rom prêt à l'emploi avec des icônes sur lesquelles l'utilisateur n'a plus qu'à cliquer. Tout est pré-câblé, pré-modélisé, et il reste facile ensuite d'y apporter des modifications. Nous ne proposons pas un ERP, où en cas de modification, il faut répercuter celle-ci en dur dans le code. Si une entreprise tient à son propre indicateur de performance clef secrêt, nous le fabriquons pour elle dans les meilleurs délais. Pour cela, nous le déclarons à Decision Stream et nous l'ouvrons comme les autres dans le portail.

En fait, les e-Apps aboutissent au développement d'un mart interactif avec l'utilisateur final, qui dispose d'outils graphiques de modélisation. Mais pour déclarer un nouveau KPI (Indicateur de performance clef), la seule contrainte que nous lui imposons est de le faire au niveau de Decision Stream. Car s'il le réalise dans son coin au niveau de son propre mart, la cohérence des données ne sera pas assurée.

Quelles est , selon vous, la principale évolution des architectures décisionnelles aujourd'hui ?

Je crois qu'il existe deux types d'évolutions majeures. La première consiste à fabriquer des applications analytiques tenant compte des best practices. Et après, d'être capable de livrer des cubes en accord avec la structure d'exploitation conforme à ces indicateurs clefs, et nous le faisons.

Ensuite, il faut aussi apporter une chaîne logicielle complète entre les données issues du progiciel (ERP, CRM, SCM...) et l'information disponible sur le portail d'entreprise. Or, à présent, nous y sommes avec notre dernier produit Enterprise Portal 7. Aujourd'hui, nous nous sommes aussi renforcés sur un point majeur qui est l'exploration des données. Nous fournissons le logiciel Impromptu dans une logique de reporting, mais notre produit phare est PowerPlay. Avec celui-ci, il est possible de constituer des rapports comprenant des dizaines de milliers de pages.

Mais au final, ce que veut l'utilisateur, c'est pouvoir imprimer seulement la face du cube qui l'intéresse. Or, nous avons rendu possible le fait de prendre cette vue et de la déclarer directement comme une page Excel. A partir de là, la face en question n'est plus du PowerPlay même si celui-ci continue de la gérer. Et il suffit de prendre Excel et de le plaquer sur le jeu de données.

Faites-vous une différence entre les termes "business intelligence" et "technologies décisionnelles" ?

Pour moi, les mots clefs importants sont plutôt datawarehouse ou datamart. Car il est déjà très important d'être d'accord sur une structure de données indépendante de l'ERP, et aussi indépendante de la décision elle-même. Et n'oublions pas les outils de restitution qui produisent des vues différentes selon les profils. Pour cela, il faut au travers du web un outil de loupe dans le PC qui retraduise l'architecture client/serveur.

Justement, comment parvenez-vous à résoudre les problèmes de montée en charge liés au déploiement ?

En effet, quand un parc de 1 000 PC est concerné par le téléchargement d'un applicatif Java, le responsable informatique devient fou car l'opération risque de faire tomber son réseau. De plus, aujourd'hui, de très nombreuses entreprises disposent d'un firewall et interdisent les téléchargements. Pour la restitution et l'accès aux données, le programme peut être installé sur le poste client ou être situé sur le serveur. Or, notre optique consiste à générer des pages HTML directement côté serveur. Du coup, le trafic réseau reste limité aux autres flux sans détruire l'organisation de l'infrastructure.

Vous disiez pouvoir prendre n'importe quelle donnée dans n'importe quel ERP. Qu'en est-il exactement ?

Cela dépend des accords que nous avons signé. Nous fournissons des connecteurs vers certains ERP comme J.D.Edwards dont le modèle de données est complexe. En revanche, sur d'autres comme Oracle Applications, nous employons le modèle SQL. Comme il n'existe pas de colle universelle, il faut se normaliser sur le type de données et prévoir des parties spécifiques selon le modèle d'accès.

Quel est l'apport des technologies web au décisionnel dans l'entreprise, sur le plan de son organisation ?

Je dirais qu'il s'agit de l'évolution vers des indicateurs temps réel au travers du web. Et celle-ci ne provient pas d'une idée informatique mais d'une idée organisationnelle. En fait, quand nous nous engageons dans la mise en place d'un système décisionnel complet basé sur les e-Apps, nous donnons un avantage concurrentiel à notre client par rapport aux entreprises qui regardent leur ERP. Mais si aujourd'hui les systèmes décisionnels ne sont pas si répandus que cela, à un moment donné toutes les entreprises en auront. Dès lors, la société plus concurrentielle devient celle qui décide plus vite que les autres. Il faut donc avoir les outils nécessaires, comme les nôtres, et que ceux-ci soient aussi capables de produire des données plus fines.

Bref, nous voyons que le raccourcissement du temps de décision implique aussi une accélération des procédures d'information en amont. Et nous arrivons à la notion des indicateurs temps réel. Aujourd'hui, nous en parlons encore plus car le web raccourcit les délais des échanges. Il s'agit du concept de dataweb et nous y sommes prêts. Si nous éditions un datawarehouse monolithique, les processus seraient plus longs. En même temps, avec nos datamarts coordonnées, nous supprimons toute redondance. Le modèle en étoile le permet et pas les autres. Et c'est Decision Stream qui assure le rôle de méta-datamart. Chez Sara Lee, par exemple, nous mettons à jour les données toutes les nuits, et ce sont 20 gigaoctets qui sont rafraîchis en 20 minutes.

Vers quelles orientations allez-vous vous tourner à présent ?

Nous allons étendre les capacités d'accès des e-Apps à d'autres sources de données. Avec J.D.Edwards, par exemple, nous fournissons en standard près de 600 rapports dont les sources sont extraites de leur ERP. Aujourd'hui, notre objectif est de livrer le même jeu d'indicateurs de performance clefs pour les autres ERP dont les modèles de données sont différents.

Avant d'être nommé son directeur général France et vice-président Europe du Sud en mai 1999, Patrick Lutgé a occupé successivement plusieurs postes chez l'éditeur canadien Cognos depuis son arrivée en 1989. Entré comme responsable des ventes, il devient son directeur général pour la France, la Suisse Romande et l'Afrique du Nord en 1992. Auparavant, de 1975 à 1989, il a occupé divers postes commerciaux chez plusieurs sociétés informatiques telles que Data General, Cullinet et le distributeur de composants électroniques Tekelec. Patrick Lutgé est titulaire d'un dea info

1 note

·

View note

Text

Caffettiera Montréal Caffé Bar

Caffettiera Montréal Caffé Bar, Québec Restaurant, Interior Architecture Photos

Caffettiera Caffé Bar, Montreal, Quebec

30 Oct 2020

Caffettiera Caffé Bar in Montréal

Design: Ménard Dworkind Architecture & Design – MRDK

Location: 2055 rue Stanley, Montréal, Québec, Canada – Golden Square Mile

English text (scroll down for French):

In Italy, going to the coffee bar is not just about the coffee. It’s about taking a break from the day, meeting up with friends or taking the time to contemplate life. Caffettiera Caffé Bar aims to bring that culture to North America at its 745-square-foot commercial space in the heart of downtown Montreal.

The café’s design was inspired by the 1990s. Andreas, the café owner, fondly remembers this as a better time in Italy, when it still had its own currency, a less turbulent political climate and the best soccer team. Caffettiera offers a relaxed atmosphere where you can stop by and stand at the counter for a quick espresso before work, or lounge on the tan leather banquettes for an aperitif and a bite to eat.

A black monolithic terrazzo bar snakes its way through the space, integrating a series of sandwich, pastry and retail displays that are bookended by two points of sale. Signs slide on an orange painted steel beam above the bar and indicate where to pay and order depending on the daily traffic. A cove at the base of the counter creates a seamless transition to the checkerboard mosaic floor. Italian products are proudly displayed on a large shelf that runs the length of the space behind the bar.

The walls are covered in faux-wood plastic laminate panels, a material key to the nostalgia of the café owner. Above, an up lit stepped bulkhead curves around the bathroom block. Two symmetrical banquettes converge at a customer service station backed by a lush planter. Curved mirrors, divided by concrete columns, give a sense of spaciousness to the otherwise tight café. Vintage chairs found in the classified ads were reupholstered with tan leather to match the banquettes. Covering the tables, a mix of five different coloured laminates gives a graphic dimension to the project. Pushing the 90s theme even further, pendant lights fabricated by Lambert & Fils were designed using yellow telephone wire.

In designing Caffettiera, the goal was to highlight the customer experience and was planned in such a way to encourage social encounters while discovering the Italian way of life. An emphasis was put on nostalgia with the help of a scattered array of vintage books, stickers, toys, and photographs from the 1990s. The relaxed environment allows customers to appropriate the space and slowly become an obligatory stop at any hour of the day.

FRANÇAIS

Situé dans le centre-ville de Montréal, Caffettiera est un café bar inspiré de l’Italie des années 90 où les Italiens avaient encore leur propre devise, la meilleure équipe de foot et du temps où le climat politique était un peu moins mouvementé. Caffettiera propose une ambiance décontractée où l’on peut s’y arrêter avant sa journée de travail pour un espresso rapide accoudé au comptoir monolithique de terrazzo ou pour un apéro prolongé dans les banquettes de cuir tan.

Le long comptoir de terrazzo noir intègre le bar, le présentoir à sandwich, l’étalage de produit pour emporter ainsi que la caisse. Il est surplombé d’une structure d’acier de couleur orange muni d’un système d’affichage sur roues permettant de modifier les informations en fonction du temps de la journée et de l’achalandage. La base du comptoir est arrondie éliminant la jonction avec le plancher de mosaïque en damier. Derrière le comptoir, des étagères ont été pensées pour mettre en valeur une variété de produit typiquement italien.

En saillie des murs du fond surplombe une retombée en estrade courbée qui vient couronner les murs recouverts de panneaux de formica imitant le noyer noir, matière très typique des années 90 pouvant éveiller la nostalgie chez certain. Des bandes de DEL y ont été dissimulées pour souligner ce détail architectural.

Les tables et le comptoir debout sont un assemblage de 5 différentes couleurs de formica ajoutant un aspect graphique à l’espace. Les chaises vintages trouvées sur les petites annonces ont été recouvertes de cuir tan pour s’harmoniser aux banquettes. Derrière trois miroirs encadrés se rejoignent au centre des colonnes de béton existantes laissées à nues. Les luminaires suspendus dessinés par MRDK ont été fabriqués par la firme montréalaise Lambert & Fils.

Le processus de design de Caffettiera a été de mettre de l’avant l’expérience client. L’objectif étant de provoquer des rencontres, faire découvrir des produits et donnant l’occasion aux clients de s’approprier le lieu, devenant peu à peu un arrêt obligatoire à toute heure du jour.

Caffettiera Montréal Caffé Bar- Building Information

DESIGNER/ARCHITECT: Ménard Dworkind architecture & design WEBSITE : https://ift.tt/3kH8kmh INSTAGRAM : https://ift.tt/2HLHrzq

PROJECT ADRESS : 2055 rue Stanley, Montréal, Québec H3A 1R7 AREA: 745 SQFT DATE: July 2020 MATERIAL: Mosaic tile, black terrazzo, powder coated steel, Formica laminate, mirror

PHOTOGRAPHY: David Dworkind

Caffettiera Caffé Bar Downtown Montréal, Québec images / information received 301020 from MRDK

Address: 2055 rue Stanley, Montréal, Québec H3A 1R7, Canada

Montreal Architecture

Contemporary Architecture in Montréal

Montreal Architecture Designs – chronological list

Montreal Architecture News

Montreal Restaurants, Cafés & Bar Lounges

Heirloom pizzeria, 30 Saint-Catherine St W Architects: Ménard Dworkind Architecture & Design – MRDK photograph : David Dworkind Heirloom pizzeria

Bar VinVinVin, 1290 Rue Beaubien E, Montréal Architects: Ménard Dworkind architecture & design photography : David Dworkind Bar VinVinVin in Montreal

Ryù Restaurant, 1474 Peel St, Montreal, QC H3A 1S8 Architect: Guillaume Ménard and David Dworkind (MRDK) photo © David Dworkind Ryu sushi restaurant Peel Street, downtown Montreal

Miss Wong Chinese Restaurant, Avenue Pierre-Péladeau, Laval, Quebec Architect: Guillaume Ménard and David Dworkind (MRDK) photo : David Dworkind architect Miss Wong Laval Restaurant

Montreal Architecture Walking Tours

Canadian Architecture

Canadian Architecture Offices

Comments / photos for the Caffettiera Montréal Caffé Bar, Québec page welcome

Website: Montreal, QC, Canada

The post Caffettiera Montréal Caffé Bar appeared first on e-architect.

0 notes

Photo

A UNESCO site and architecture that deserves your presence...The ancient 12th century rock hewn churches@Lalibela,Ethiopia. . . Architecture et site de l UNESCO qui se mérite a être visiter et incontournable du pays... Les anciens èglises rupestres monolithiques et semi-monolithiques de Lalibela qui date du 12eme siècle Èthiopie. . . #voyages #voyageuses #voyage #voyageur #travelers #travels #travelgram #paradisiaque #travelholiday #travelholic #instavoyage #instatravel #likelike #vacation #vacations #vacance #churches #traveling #vacances #traveler #voyager #voyageuse #tonrevetourandtravel #tourisme #tourism #travelholiday #architecturephotography #churches #liketime #like4follow #orthodoxchurch #visit (à Lalibela, Ethiopia) https://www.instagram.com/p/B-dLHxAn_oz/?igshid=17loc3yscrm4g

#voyages#voyageuses#voyage#voyageur#travelers#travels#travelgram#paradisiaque#travelholiday#travelholic#instavoyage#instatravel#likelike#vacation#vacations#vacance#churches#traveling#vacances#traveler#voyager#voyageuse#tonrevetourandtravel#tourisme#tourism#architecturephotography#liketime#like4follow#orthodoxchurch#visit

0 notes

Photo

A Shravanabelagola, le plus important centre religieux du Jaïnisme, la statue de Gomateshvara (ou Bahubali), 19 m de haut, la plus grande statue monolithique au monde ... qui ne sera pas le souvenir architectural du voyage. On dit qu'il est resté à méditer, immobile, pendant un an dans une posture debout et que pendant ce temps, des plantes grimpantes ont poussé autour de ses jambes. Après son année de méditation, Bahubali aurait atteint l'omniscience. Il est vénéré comme une âme libérée (Siddha) par les Jains. Effectivement beaucoup de dévotion en haut de la colline d’Indra, à laquelle on accède en gravissant courageusement et sous une chaleur de plomb (614 marches taillées dans la roche) ou en chaise à porteurs.

nota: j’ai eu quelques billets censurés (provisoirement) par tumblr, car jugés trop suggestifs ou érotiques, il n’y avait pourtant pas de quoi, comme ces éléphants de mer se faisant un bisou dans l’eau en Patagonie. Je crains le pire avec ce zizi au repos de près de 50 cm ... et encore je n’ai pas osé photographier les Indien(ne)s, qui après avoir vénéré Bahubali, se prenaient en selfie “dans le bon axe”.

0 notes

Text

Trois essais

Gefallenes Laub de Kadishman à Berlin

Dans un appendice architectural du Judisches museum, la lumière zénithale d’une raie tombe. Au sol du couloir sombre, cul de sac, un tapis de pièces de bronze, oxydées? La rouille. Les parois resserrées, béton brut, patiné. Monument souterrain, intérieur. La venue exprès. Le recueillement d’une chapelle, des catacombes.

Le monument n’est pas en érection, il est en retrait au fonds du musée, dans un couloir sombre et les éléments rasent le sol. Pas de bloc, de monolithe. Disparate contenu. La multitude de faces-écus est en tas, bougent sous les pas. Déplacement du monument incessant.

De grandes médailles aux visages dessinés par trois trous irréguliers: yeux, bouches. Bouches bées. Expressions horrifiées, cri. Le visiteur marche sur les médailles rouillées. Craquement, grincement. Il marche avec difficulté sur les faces grimaçantes qui du fond de l’enfer crient vers le ciel. Le couloir est l’enfer, la fausse commune, la tirelire. Les écus crient de leurs bouches bées, douleur permanente. La découpe irrégulière, manuelle de leur pourtour et leurs dimensions variées les individualise. Les faces-écus perforées d’un regard et d’un cri, à l’expression faciale de douleur individuée par irrégularité de la découpe. Écoute du crissement des écus. Frottement entre eux.

Les morts tombent au fond de la fosse, les cadavres sont poussés au bulldozer. Les écus de bronze y restent, les commémorant. Cadavres, morts, feuilles tombées. Soldat dans le ruisseau, pièces de monnaie à la fontaine. Face toujours vers le ciel (pile ou face identiques). En marchant dessus, du rite. Les faces souffrent, les pas crissent. La marche difficile: plage de galet, tas de feuilles, jeu de boules. Attention à chaque pas, lenteur de la progression. Gêne à l’entente du son de ses propres pas. L’expérience proposée au visiteur est de traverser ce couloir tapissé d’un lit de feuilles, écus, damnés. Souvenir de tas de feuilles rousses à l’automne. En marchant sur les damnés. Refaire l’histoire, rejouer le massacre dédramatisé, sur un mode mineur, symbolique majeur. Non forcément conscient, non discursif : sensation politique.

Dans Schalechet, il y a chute. Accumulation de tombés. L’Automne. Hauteur vue sur le ciel. Le visiteur est dans un cul de sac, les damnés bloqués au fond du trou. Ces damnés sont tombés pour la monnaie, et médailliformes au fonds de l’enfer ils s’accumulent comme des feuilles mortes qui bruissent, feuilles rousses, médailles oxydées. La permanence du bronze et la caducité des organismes vivants, des feuilles, vies humaines.

La représentation de l’enfer, en sous le niveau du sol avec raie de lumière au plafond. Cris silencieux de damnés, couloir de la mort.

Gefallenes Laub est une œuvre commémorative violente qui amène le visiteur à piétiner symboliquement les assassinés, victimes? Le visiteur refait symboliquement l’expérience de l’histoire du massacre. Et quand bien même il opterait pour une attitude misérabiliste, entretenant une pitié distanciée, il participe. Piétine ces visages. S’il baisse la tête, et il doit l’avoir baissée, passer lentement par la difficulté à marcher; il voit cette multitude disparates, tas figé dans son cri muet. S’il la hausse, raie de lumière signifiant la surface terrestre. Aurait la position de celui qui empêche les damnés de remonter vers la lumière? Qui piétine ces visages ayant été frappés en écus. Les écus grincent et grimacent sous les pressions des pas des visiteurs, venus commémorer ?

Les raisons économiques du massacre et leur représentation en forme d’écus percés de trous. (Écus, médailles, monnaie - les portraits de la gravure sur médaille antique). Les morts réduits à des faces-écus? anonymes mais individués (tailles, expressions de douleurs) et non monolithiques, indépendants.

Critique de l’histoire, pérennisation de l’ignominie ?

Mur érigé de noms, fosse où repose les raisons (les écus). Un monument aux morts peut être un mur érigé pour y recevoir les noms gravés des « tombés pour », des tumuli, les cimetières de guerre avec tombes génériques. Lorsque les soldats d’une patrie sont morts au front, des murs gravés sont dressés pour les morts pour la patrie. Toute la surface est couverte de listes uniformes de noms et dates de naissance et mort. État civil. Stelles, blocs, noms. Organisés en listes, en quadrillages… comémorent la mort en fausse, collective. Des unités individuées forment des groupes uniformes? Un mur de marbre listé de noms c’est recouvrir la violence historique. Le soldat était dans la boue. Commémore des personnes parquées, enfermées, dépossédées, déportées, enfermées, assassinées. Torturées et poussées à l’extrémité physique et mentale, puis massacrées et mises en fosses communes. Le massacre, la shoah. Ghetto, camps, fosses communes, chambre à gaz, monuments aux morts. Devant un mur listé, l’expérience du commémorant consiste à lire, dressé devant le dressé, déroulement de noms et dates. L’idée étant que chaque état civil des individus y apparaissent, et inconnus.Les familles, habitants, voyageurs, viennent s’y recueillir, déchiffrent, cherchent.

Gefallenes Laub ne présente pas l’état civil des massacrés mais l’individuation du cri et les conditions de leurs mort. Des anonymes individués. Du vivant figé dans son cri qui perdure à l’ouïe par les crissements des morceaux produits par le piétinement, dans la pénombre d’une annexe de musée. Comme les buissons de l’Enfer de Dante.

Notes annexes :

Destruction, ruine, abandon (côté Est de la ville de Berlin). Reconstruction, restauration.

Monuments : camp d’Auschwitz intouchable ( projet pour Auschwitz d’Hansen était de ne pas toucher les lieux, laisser tel quel. Une passerelle jetée au dessus qui aurait permis de traverser la zone en voiture), des faces-écus au fond d’un couloir souterrain, un labyrinthe de blocs noirs dans un jardin (Moabit?). À Berlin (Tiergarten?) il y a un monument constitué de blocs noirs entre lesquels circule le visiteur. Labyrinthe. Impressions spatiale et sonore, isolation. Dans Berlin encore des pavés de bronze devant les immeubles où des familles ont été déportées... Les monuments aux morts liés au pouvoir, à une idéologie guerrière.

Allégorie de la reconstruction, bâtiment page d’histoire (cf. VH Ceci tuera cela). Art funéraire, monuments commémoratifs des morts à la guerre (des murs, des cimetières à croix anonymes)... Préparant sa publicité en érigeant des héros, gravés sur les murs. Lacune de l’œuvre: cri de douleur, souffrance, nature de leurs sépultures. Cimetière, murs, tumulis, obélisques, arcs de triomphes. Croix: symbolique religieuse. Les tumulis sont des monts de terre artificiels où sont ensevelis le souverain et tous ses sujets, chef et sa suite en vies et richesses. Gamla Uppsala.

La restauration du Neues museum selon la charte de Venise expose l’état antécédent de ruine du bâtiment. Ce musée à l’architecture néoclassique de Stüler est un monument de l’idéologie impériale, des expéditions coloniales de l’Empire. Atteint par les bombardements sur Berlin 2GM. Histoire de l’Empire, de la guerre. Les morceaux et débris (cf. fragmentarium) sont remontés en murs, fissures visibles sur les parois des fresques. Murs criblés de balles. Matière murale historique telle qu’elle a vécu, subit les bombardement et guerre. La moindre pièce du puzzle est réintégrée à l’ensemble. Des fresques coloniales criblées de balles. Pans de bâtiments mis en poussière remontés en béton brut différent.

Entre 2 guerres et raconter… Les soldats rampent dans la boue des berges du ruisseau, une mitraillette au dos, visage souillé. L’industrie allemande nous envoie au front. Acte et conscience de la chair à canon qui rampe. Stratégie d’attaque et énoncé des causalités industrielles de la guerre. La montée du nazisme n’est pas montrée dans Entre deux guerres. La guerre de 16, un front fiction, où la représentation du soldat dans un film non belligérant ni anti-soldats. Les soldats sont humains pensants. Ils évoquent l’industrie allemande, traînent dans la boue du ruisseau.

Le Massacre des innocents de Poussin à Chantilly

La scène du massacre sur la terrasse de la place publique. Le meurtre systématique (épisode de l’ancien testament) est représenté par les différentes étapes du massacre comme simultanément vécu par trois couples mère-enfant. Séparation en 3 étapes. Celle dont on abat le fils devant elle est tirée par les cheveux. L’autre, mère effigie, calmée dans son geste: statuaire de la pleureuse. Porté à l’épaule, séparé, à bras le corps. La mère du fond est en deuil, chant de mort. Celle en devant assiste à l’exécution de son bébé.

Le drame est montré par l’instantané, moment du crime, au premier plan - à trois figures. Au coin du tableau, à l’angle du temple sur la place publique. Un soldat, une femme et un bébé. Trois figures rapprochent le tableau de la Sainte famille: Père, mère et enfant. Père, mère, enfant, espace potentiel de l’expérience (*). Le soldat écrase le bébé renversé sur le dos, en brandissant son épée d’une main quand de l’autre il retient par les cheveux la mère élancée vers son fils. Son double geste assassine et empêche de défendre... repoussant la mère en assassinant le fils. Le soldat brandit son épée, prêt à l’abattre sur le bébé criant qu’il piétine d’un pied pendant que de l’autre bras il retient la mère épouvanté par les cheveux. Entre ses jambes la mer (et un plus ancien crime). Par dessus sa tête l’épée. L’enfant est nu... un petit drapé est sous le bébé, la femme drapé de convention, l’homme armé. La cible est l’enfant, à tuer ou sauver: les deux regardent vers le sol d’où cri gisant le bébé aveugle. Le bébé piétiné, sur lequel l’épée va s’abattre, est énorme et lumineux. La chevelure de la femme retenue est défaite, son ruban tombe dans l’image. Les pieds nus, les drapés défaits. D’autres femmes ont des enfants vivants dans les bras? Regardent ou se détournent

Le nourrisson gras est à terre, la nuque contre un degré du temple au pied d’un fut de colonne; sous le pied du soldat saigne un peu, vivant. Bras en l’air, il cri. La colonne est énorme. La pierre anguleuse, polie par le travail humain. Le dallage est sombre, le corps du bébé est baigné de lumière et il perd un filet de sang. Le couple mère-enfant illuminé d’une même lumière. Le ciel est bleu. La masse du pied de colonne, bloc de pierre cannelé, sévérité polie et immuable, non vulnérable à la violence de la scène. Les cannelures sombres tombent verticales, imperturbées. La lumière n’y vibre pas, fût sombre. Éclairement sur le nourrisson gras, le bras de sa mère. Le bébé (l’innocent) aux yeux fermés est choqué, aveugle. La mère épouvanté le regarde. Lumière sur la bouche. Les bras, mains, bouches, sont ouvertes. Bouches ouvertes, boule de tête; boule de pierre. Tête renversée vue de dessus. Bras ballant.

Ce bébé projeté au coin bas du tableau est proche du regardeur, au premier plan... vivant dans sa chute s’élève, par son mouvement de bras, il demande: élan de vie. Enfants que la pâleur de mort prend, qu’un rayon éclaire comme halo, partie sanguine, rose. Plein de sang. Le sang écoulé est giclure, tache. Filet? La variété des carnations montre la vie, la mort et l’entre deux. Ce bébé entre la vie et la mort est surabondance de vie, éclair lumineux, filet de sang, cri et rose de carnation.

Le sang versé est une giclure sur la pierre grise. Le tableau au niveau du sol, où l’enfant chu est animé. Un corps tendre et rose, un autre musclé et rouge/brun. Un blanc. Un nez rose, auréole charnel, carnassier et chair, sanguin. Bronzé. Le rose aux extrémités (bout de nez, doigt, pieds - et bourrelets).

L’enfant vit, l’instant capturé est celui de sa chute baigné de lumière. De l’instantané. Dramatisme clair-obscur. Il cri, saigne, dans un dernier élan de vie - survit. La lumière de vie, éclat solaire couvrant sa peau encore rose, sang de la chair, carnation rose entre ses bourrelets, doigts et cuisses. Contraste avec la sévérité de l’inerte manufacturé.

Peau contre peau. Effrayé contre enragé. L’ensanglanté, le meurtri, le mort, le fou de tuer. Enfant mort contre mère endolorie. Corps à corps au niveau du sol. L’homme est rouge, la femme jaune et verte de colère, l’enfant blanc perd du sang - au fond gris gicle rouge. L’emportement au crime fait rougir le soldat et la douleur du meurtre pétrifie la mère du cadavre. Les pieds abîmés du soldats, corps basané de soleil et visage rouge de rage. Femmes exsangues aux bras blancs.

Derrière l’action, au second plan une femme marche le raccourci du corps mort de son fils au bras... la mère ayant récupéré son enfant mort cri vers le ciel, yeux fermés et se bouchant les oreilles. Cercle de sa manche. Tête ronde de son fils que la mort rapproche du minéral, peau grise et raideur - tête, boule, bras, quille. Cris simultanés de la mère et l’enfant dans l’instantané du crime, puis chant de la mère. Implore, prie. La mère implore pour l’enfant, l’enfant aveugle cri pour sa vie, tend les bras à sa mère. Bras ballant raide comme un fut de colonne. la femme bleue de Et in Arcadio. Cet autre bébé est terne mort, raccourci de son bras tombant à la verticale, sans mouvement, tel fut de colonne (ellipse et boudin). Pâleur de mort de ce couple fantomatique mère-enfant, la femme n’est plus mère, chant de douleur au visage versé vers le ciel silencieux, bouche ouverte - son cadavre de bébé est raccourci en ellipse et boudin.

La femme du second plan porte son bébé cadavre d’un bras. Traverse la scène, aveugle, de profil. Une pleureuse pétrifiée. De profil, la tête renversée sous le ciel, bouche ouverte criant de douleur. Tête versée vers le ciel. Son portrait de profil se découpe sur un fond de ciel uniformément bleu, juste au dessus de la ligne horizontale du toit. Elle appartient au ciel. Son enfant mort pend sous elle. Contre-plongée, déifiée. Statues de déesse dans les temples. Le cadavre raccourci, mort sur fonds d’ornements corynthiens. Le bras mort pend. La colonne en bloc érigé, support, dite jetée - à la gloire de. Tombe. La mort comme métamorphose, la différence entre l’inerte, le mort, le juste mort, à la frontière de. Statufié, pétrification. Écho et narcisse, Moïse sauvé des eaux. Au fond, une autre tête d’enfant, par dessus l’épaule de sa mère, de dos.

Les mères emportent leurs enfants morts.

Désert de pierre. Aucune végétation, aucune eau. Les ornements des chapiteaux corynthiens sont végétaux. Le filet de sang liquide. La mer au loin plan dur. Le chant de mort induit des pleurs.

Deux forces : fût de colonne immuable (pierre dans l’ombre) ; et enragement du soldat. Le rapport d’échelle entre la jambe du soldat, son mollet massif et son pied qui écrase le thorax de l’enfant ; avec le marche-pied où se cogne la tête de l’enfant. Entre la colonne et l’enfant : la colonne au bord du tableau supporte la scène, cadre. L’esplanade est la scène du massacre. La ligne irrégulière du tibia du soldat en face de celle droite de la colonne. Le bout des doigts du soldat touche la ligne de la colonne. La découpure du bout des doigts de la mère.

Au loin une fabrique. ... Seule l’épée est de métal. Peau, pierre, tissus colorés, ciel uniforme. Au fond une tour rose au bout rond. Sol lisse, poli, à motif varié de dallages de terre rouge - encastrés. Différentes pierres et couleurs de drapés. Poussin peint l’enfance de Bacchus, des bébés tout gras, enfance à terre - entourée d’animaux, de fruits. Un tableau, un rapport de rapport.

Ekphrasis, thèmes et variations de L’Objet Invisible (Mains tenant le vide), bronze, 153x29x26 cm, 1934, par Giacometti

La figure verticale comme pendant à un fil de plomb est encadrée et soutenue par un portique ajusté et suivant ses contours. Le corps mou est dressé par le portique sévère et rehaussée d’un piédestal. Les bras épousent l’armature, comme un tuteur et son plan de vigne. Indifférence du portique : une armature sévère où se fond, se moule la figure molle, dont seuls les avant-bras seuls apparaissent animés, dans le geste du maintien d’une objet invisible. Statuère (sévère) – dérivé du mot stare, se tenir debout, condition d’une statue. Pédestre. Texture, surface lisse. Brun du bronze et légère patine balayée.

Seules les avant-bras et mains semblent animés. Bras-boudins longilignes, tronçons mous, corps regroupé sur lui-même. Insolence du vertical avec son air d’entre la vie et la mort ; stupeur du corps sans musculature, sans anatomie, tête inclinée vers le haut, bouche bée de sa face-masque (masque adrian à visière dont le récit de la trouvaille est rendu dans l’Amour fou d’André Breton). Quelque chose du sommeil, de la mort dressée.

Jambes fléchies. Pesanteur de ses seins bas, repos du bassin. Deux plans inclinés accolés au corps : l’un oblique accolé à ses tibias, apesanteur, comme aimanté, n’est soutenu ni ne soutien. Plaque fonctionne comme un cache, souligne la flexion des jambes. Deux plans inclinés accolés à son bassin ? Hanches étroites.

Les avant-bras qui se soulèvent s’émancipent du portique ou sont coulés les bras-saucisses, corps de reptile. Les mains flottent ouvertes aux doigts légers. Vide formé pour un objet invisible. La statue nommée par le vide qu’elle réserve. Objet. Don d’invisible, de vide sensible, rendu visible. La sculpture se joue du plein et du vide. Celle-ci présente le vide, elle le tient selon le titre qui ignore le corps. Ce corps insoutenable par lui-même. Les mains donnent du vide à voir, celui d’entre ses deux mains quasi jointes. Ce vide, cadeau perdu, inspiré peut-être de l’accessoire perdu des sculptures ayant traversé le temps : soldat sans épée… Rembrandt à la toque, à la chaîne d’or. Au bouquet. Ce vide est positif, formé. C’est l’énigme qu’elle tient. Vide plein de son énigme.

Cela tient : pondération, équilibre. Les conditions de l’équilibre de la matière qui est mise en œuvre. Les soutiens nommés tenons – excroissances. Les masses, le balancement, contrepoids. Le geste est le langage de la statuaire – le mouvement et le geste. La figure humaine élevée par la statuaire.

La muse momie au visage-masque est sortie du tombeau et redressée par un squelette-portique, don invisible. On pense aux statues qui avec le temps ont perdu leurs excroissances.

Le sculpteur l’a relevée au Louvre (esquisses à la plume) et lui a trouvé un visage aux puces de Saint-Ouen (le casque adrian discuté dans l’Amour fou). Le lever de la mort rigide horizontale et allongée des momies. La sortie du tombeau. Entre le musée du Louvre, la souffrance de l’atelier et la distraction du marché de Saint-Ouen. L’élaboration de cette œuvre est processus de transposition d’un élan vers un reste de vielle morte, transcription d’une chose vue à une vision. Un point de départ de la genèse de l’œuvre sont les croquis de Giaccometti au Louvre, d’après l’Égypte antique: un reine égyptienne momifiée, couchée au tombeau. Sortie de son sarcophage par le dessin qui relève la morte en la faisant passer de l’horizontalité à la verticalité. Du concret de la page esquissée, avec ses traits de construction qui encadre le corps couché (relevé au Louvre)… Ses traits de construction matérialisés en portique de bronze. Horizontalité du tombeau, verticalité humaine. Passage du dessin de sculpture (corps mort), �� la sculpture. De l’esquisse des restes de cette reine ayant traversé les âges. Le redressement ; relevée à sa suite, lever de la morte, l’éveil. Le sculpteur le lève, la hausse et l’encadre. Du vu, transcription et production de forme.

Les sculptures idoles : Les momies, kouros et Corè. Modernes : Princesse X et Cariatide de Brancusi, Oviri de Gauguin. Les figures féminines de Giaccometti qui succèdent : femme qui marche, la texture rugueuse, les énormes pieds encrées. Le penseur de Rodin de Waldemarsmudd, tas de muscles regroupé sur lui-même, sans dons, supportant le poids de sa propre pensée musculeuse par la main appuyée sous le menton. Sa patine réussie. La figure courante parmi les 3 dans le Luxe de Matisse, don de bouquet.

Les muses mortes de Nerval virvoltent autour d’elle :

‘Aimez qui vous aima du berceau dans la bière,

Celle que j’aime seul m’aime encore tendrement ;

C’est la Mort ! Ou la Morte, hélas, la rose qu’elle tient,

C’est la Rose Trémière’

(Die Dinge sind unmittelbar da vor unsern Augen, keine Schleier mit unter ihnen. Hier trennen sich Religion und Kunst.)

Janvier 2013 (œuvre vue en novembre 2017)

0 notes

Text

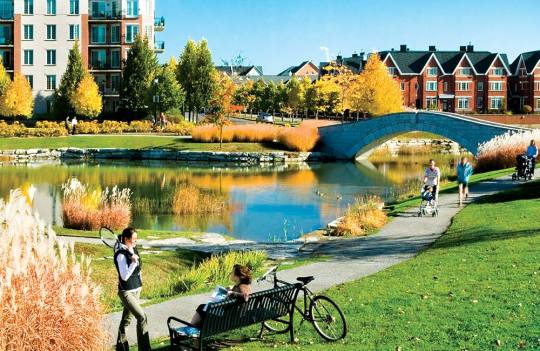

Smart Growth and New Urbanism: Literature Review and Brief Look at the Canadian context

Link

On a beaucoup écrit au sujet du smart growth et du nouvel urbanisme, deux mouvements majeurs aujourd’hui en aménagement. Il se dégage de la consultation de cette littérature que les positions prises par les auteurs participent le plus souvent à un débat fortement polarisé entre ceux qui idéalisent ces mouvements et ceux qui les rejettent complètement. La présente étude vise d’abord à mettre en perspective une appréciation du smart growth et du nouvel urbanisme à travers une revue de la littérature récente. Cela nous amènera, après avoir défini les mouvements en question et relevé tant leurs similitudes que leurs distinctions, à évoquer les principales critiques qui leur sont adressées et questionner leur légitimité. Nous présenterons ensuite un bref aperçu de la progression des deux mouvements au Canada, notamment au sein des organismes publics. Pour terminer, nous préciserons les enjeux majeurs et les conditions nécessaires à un développement urbain plus viable.

Smart growth et nouvel urbanisme : définitions et origines

Le smart growth est avant tout un concept dont la définition courante est si proche du concept de développement urbain durable qu’il s’agit ni plus ni moins d’une appellation ou d’une version nord-américaine de ce dernier (Lewis et al., 2002 ; O’Neil, 1999 ; Smart Growth Network, 2005). Le smart growth tire son origine des théories de la gestion de l’urbanisation des années 1960 et a évolué vers sa forme actuelle dans la foulée du paradigme du développement durable à la fin des années 1980 (Gillham, 2002).

D’ailleurs, à l’instar de l’idée de développement durable, celle de smart growth a reçu un accueil favorable au sein de nombreuses organisations qui, il est vrai, l’interprètent souvent différemment (Gillham, 2002 ; O’Neil, 1999). Malgré cette situation qui peut malheureusement rendre le concept ambigu et même le dénaturer, le smart growth, dans son acceptation et sa définition les plus courantes, peut être identifié à une série de principes d’aménagement et de développement qui visent essentiellement la préservation des ressources (naturelles et financières) ainsi que la réduction de la ségrégation spatiale sous ses diverses formes (fonctionnelles, sociales, etc.) par la priorité donnée au redéveloppement urbain ; il s’oppose ainsi fondamentalement à l’étalement urbain (Gillham, 2002 ; Lewis et al., 2002 ; Smart Growth Network, 2005).

De concept, le smart growth est devenu un véritable mouvement, car il connaît une popularité grandissante et une diffusion rapide en Amérique du Nord, particulièrement aux États-Unis. Un réseau national, le Smart Growth Network (SGN), fut créé en 1996 par l’Agence fédérale de la protection de l’environnement (EPA) et ses partenaires, et un nombre croissant d’acteurs publics, de tous les paliers, mettent désormais de l’avant des politiques basées sur le smart growth (Garde, 2004 ; O’Neil, 1999). Au Canada, le smart growth gagne également en popularité (New Urban News, 2001 ; Tomalty, 2003). Le premier groupe du genre à avoir vu le jour est Smart Growth BC, et une première coalition nationale comprenant principalement des organismes non gouvernementaux existe depuis 2003.

Tout comme le smart growth, le nouvel urbanisme est fondamentalement opposé au type de développement périurbain prédominant en Amérique du Nord depuis la fin de la Seconde Guerre mondiale, développement qui favorise l’étalement urbain. Il s’inscrit lui aussi, en théorie, dans le paradigme global du développement urbain durable et cherche à réformer notre mode actuel de planification et de développement de la ville.

Les définitions du nouvel urbanisme peuvent varier. On parle parfois, au sens large, d’une approche en urbanisme ou d’une « philosophie d’aménagement » (Falconer Al-Hindi et Till, 2001 ; Marshall, 2000). Mais la définition de loin la plus courante le désigne comme étant avant tout un mouvement en aménagement et en design urbain ; mouvement qui est le plus souvent associé à un groupe de professionnels réuni au sein du Congress for the New Urbanism, basé aux États-Unis et fondé au début des années 1990. On parle aussi du nouvel urbanisme comme étant le plus important mouvement en urbanisme actuellement (et depuis longtemps), mouvement qui a à tout le moins contribué à alimenter et à réactualiser les débats autour de la question de l’étalement et de notre modèle de développement urbain. Il est à noter que les principaux chefs de file du mouvement, sur lesquels nous reviendrons plus loin, ont eux-mêmes grandement contribué à la diffusion et à la popularisation de leurs idées en publiant un nombre important d’articles et d’ouvrages, dont certains peuvent être considérés comme de véritables références pour le mouvement (par exemple: Calthorpe, 1993 ; Calthorpe et Fulton, 2001 ; Duany et Plater-Zyberk, 1991 ; Duany et al., 2000 ; Katz, 1994 ; Leccese et McCormick, 2000).

Le nouvel urbanisme est en fait l’appellation la plus récente du néotraditionalisme. Cette approche en architecture et urbanisme, initiée au début des années 1980, vise à recréer les qualités et les attributs des types de développement urbain traditionnels qui prévalaient encore en Amérique du Nord au début du XXe siècle. Le néotraditionalisme serait lui-même issu du mouvement de la préservation du patrimoine bâti des années 1970 (Falconer Al-Hindi et Till, 2001). Certains associent également le nouvel urbanisme à des mouvements plus anciens, particulièrement ceux qui ont voulu réformer les développements en périphérie des agglomérations : les mouvements américains des villes nouvelles des années 1960 et 1970 et des cités-jardins des années 1920 et 1930 (Fulton, 1996 ; Marshall, 2000).

Globalement, deux grands objectifs pourraient être associés au nouvel urbanisme selon Fulton (1996): (re)créer des collectivités qui offrent non seulement convivialité, interaction sociale et sentiment d’appartenance (sense of community), mais aussi des environnements plus favorables à la marche et aux transports en commun. Pour ce faire, le mouvement s’appuie sur une série de principes de design urbain que l’on peut regrouper en trois points :

des développements plus compacts et planifiés selon l’échelle humaine, c’est-à-dire ayant une distance entre leur centre et leur périphérie qui soit praticable à pied (environ un quart de mille ou 400 mètres, l’équivalent de plus ou moins cinq minutes de marche) ;

une nette préférence pour le transport en commun ;

une plus grande intégration de fonctions urbaines diverses (habitations, commerces et services, emplois, écoles et équipements communautaires, espaces publics) au sein de chaque quartier.

Mais, comme le souligne Marshall (2000 : 34), le nouvel urbanisme ne forme pas un bloc monolithique : « New Urbanism is plural, with many different adherents, thinkers, and streams of thought within it ». En effet, plusieurs tendances coexistent à l’intérieur du mouvement, comme le traditional neighbourhood design (TND) et le transit-oriented development (TOD), avec leurs spécificités et leurs priorités. Le nouvel urbanisme est donc un forum d’idées et des divergences existent entre les membres. Par exemple, il y aurait une certaine division entre le nouvel urbanisme de la Côte ouest et celui de la Côte est. Le mouvement de l’Ouest, dont l’une des figures de proue est l’urbaniste et architecte californien Peter Calthorpe, serait plus proche du mouvement environnementaliste, mettant l’accent sur l’importance du transport en commun et adoptant une perspective plutôt régionaliste du design urbain. Le mouvement de l’Est, mené par les architectes et designers urbains floridiens Andres Duany et Elizabeth Plater-Zyberk, mettrait d’abord l’accent sur le formalisme et l’esthétisme du design urbain (Fulton, 1996 ; Marshall, 2000).

Selon Marshall, les promoteurs du nouvel urbanisme seraient écoutés et appréciés en proportion inverse de la profondeur de leurs idées, dans la mesure où leur doctrine est souvent réduite à des considérations esthétiques : « To most city councils and zoning boards, New Urbanism represents the option of solving serious urban problems of sprawl and center-city decline by the application of front porches, alleyways, and other devices in new developments far out of town » (Marshall, 2000 : 35). On néglige ainsi, par exemple, que la priorité à donner au redéveloppement urbain est, au sein même du mouvement, une source de divergences importantes entre, d’une part, les régionalistes et environnementalistes et, d’autre part, les formalistes. Vers la fin des années 1990, on pouvait lire à ce sujet : « Even within the movement, some New Urbanists fear that the focus on reinventing suburban neighborhoods won’t solve broad metropolitan problems but will simply replace “suburban sprawl” with “New Urban sprawl” » (Fulton, 1996 : 3). Mais récemment, selon plusieurs, le nouvel urbanisme aurait opéré un virage et de plus en plus de projets viseraient le redéveloppement de secteurs urbains et périurbains existants (Falconer Al-Hindi et Till, 2001 ; Gordon, 2003 ; Marshall, 2000).

Enfin, un des aspects particuliers du nouvel urbanisme concerne le recours au design participatif. Essentiellement, il s’agit d’associer divers acteurs (promoteurs, représentants du secteur public, mais aussi citoyens et groupes d’intérêt) dans l’élaboration des lignes directrices d’un projet de développement, ceci dans le cadre de sessions intensives de remue-méninges (brainstorming). Plusieurs y voient une contribution intéressante du mouvement dans le domaine des procédures de planification urbaine ou, du moins, un effort louable pour la promotion de la participation publique et pour l’atteinte de plus grands consensus.

Smart growth et nouvel urbanisme : similitudes et distinctions

Le smart growth et le nouvel urbanisme partagent la même vision de base en ce qui a trait aux principes généraux d’aménagement. D’ailleurs, on compte le Congress for the New Urbanism parmi les fondateurs du Smart Growth Network. Cette compatibilité s’exprime, dans les faits, par une complémentarité entre les politiques et les initiatives publiques de smart growth (menées à l’échelle des États et des régions) et les projets de développement urbain de type nouvel urbanisme menés sur le terrain. En 2002, un recensement de ces projets aux États-Unis montra que les trois quarts d’entre eux avaient eu lieu dans des États et des régions ayant adopté des mesures de smart growth (Garde, 2004).

Si le smart growth et le nouvel urbanisme sont très proches et s’inscrivent, globalement, dans le paradigme du développement urbain durable et de la lutte à l’étalement urbain, certaines distinctions doivent cependant être soulignées. D’abord, le smart growth revêt un caractère beaucoup plus global que le nouvel urbanisme. Cela tient au fait que le smart growth est avant tout un concept de développement. Quant au nouvel urbanisme, il constitue davantage un mouvement exclusif ou corporatiste, en ce sens qu’il est généralement associé à des membres et des représentants officiels, à une organisation porte-parole (le Congress for the New Urbanism), voire à une certification de projets par cette même organisation.

Une distinction peut-être encore plus claire concerne les échelles d’intervention et les acteurs directement concernés. Le smart growth englobe généralement plusieurs échelles géographiques (locales, régionales et nationales) et comprend habituellement un ensemble de mesures variées, allant de la gestion du développement urbain et territorial à l’élaboration de lois, d’outils fiscaux et d’incitations économiques à incidence territoriale. Il concerne donc essentiellement et en premier lieu les politiques, les investissements ainsi que les programmes des acteurs publics de tous les niveaux. En revanche, l’échelle d’intervention du nouvel urbanisme est davantage locale, voire infra-locale, en se concentrant sur des projets et des opérations de développement et de design urbains (Garde, 2004). Les acteurs concernés sont donc davantage ceux du secteur privé, soit les designers urbains, les architectes et les promoteurs.

Enfin, comme le smart growth est avant tout concerné par la gestion de l’urbanisation plutôt que par des questions de design, il met l’accent sur la lutte à l’étalement urbain. Pour sa part, le nouvel urbanisme est plus enclin aux nouveaux développements urbains en périphérie, visant peut-être davantage à changer le visage de la croissance urbaine qu’à véritablement la contrôler. Comme nous l’avons vu, il reste que le nouvel urbanisme semble de plus en plus conscient de l’importance du redéveloppement urbain. Ce qui fait dire à certains, dont Marshall (2000), qu’il se rapproche peut-être encore un peu plus du smart growth.

Au-delà des principes

On s’entend pour dire que l’aménagement et le développement de nos agglomérations selon les principes du smarth growth constituent un très grand défi, surtout dans le contexte nord-américain actuel où il existe plusieurs obstacles, notamment du côté des organisations et des pouvoirs publics, à une réelle mise en oeuvre du processus : faible consensus politique (ou carrément son absence), peu d’importance accordée à ces questions (comparativement à celles relatives à la croissance économique), grande fragmentation des pouvoirs publics à l’échelle des métropoles, etc.

Certains font aussi remarquer que même en présence d’un consensus politique, à l’échelle d’une province ou d’un État par exemple, il s’agit souvent d’apparences trompeuses, les lois étant tellement vagues que personne ne peut (ni ne veut) vraiment s’y opposer (Ben-Zadok, 2003 ; Garde, 2004). Ceci constitue en fait la critique majeure faite au smart growth, à savoir qu’il débouche sur un ensemble de lois qui apparaissent cohérentes et louables en soi, mais qui sont dans bien des cas trop vagues ou trop permissives pour amener des changements significatifs à l’échelle locale.

Au sujet du nouvel urbanisme, les critiques ne manquent pas non plus. Elles sont même plus nombreuses et elles sont assurément plus acerbes que celles adressées au smart growth. Mais il ne faut pas s’y tromper, car cela tient au fait que le nouvel urbanisme est justement plus concret que le smart growth et, en ce sens, qu’il doit se commettre davantage en allant au-delà des considérations et des politiques générales : il a en effet un visage, celui des nombreux projets hétéroclites réalisés un peu partout dans les nouveaux quartiers.

Une critique parmi les plus courantes faites au nouvel urbanisme concerne son appellation elle-même (plus précisément son qualificatif de nouveau), parce qu’elle serait tantôt paradoxale, tantôt prétentieuse. Il s’agit en effet davantage d’un réarrangement et d’une réappropriation de principes qui existent depuis fort longtemps en urbanisme (Robbins, 2004 ; Robinson, 1997 ; Wight, 1995). Ainsi, les tenants du nouvel urbanisme auraient emprunté plusieurs notions comme celle de l’unité de voisinage, de Clarence Perry et de Clarence Stein (années 1920), ainsi que celles de la revalorisation de la rue en tant qu’espace public, de la diversité et de la mixité des fonctions, idées défendues notamment par Jane Jacobs dans les années 1960. De plus, certains trouvent ironique que le nouvel urbanisme, qui se dit en rupture avec les méfaits et les abus de l’urbanisme moderne, ait plusieurs éléments et méthodes en commun avec le Congrès international d’architecture moderne (CIAM), dont Le Corbusier fut l’une des âmes dirigeantes : le nom même du Congress for the New Urbanism ; la tentative de réformer l’industrie du bâtiment et du développement urbain et le travail assidu de promotion des idées auprès des organisations gouvernementales ; la confiance en l’efficacité des codes et des conventions écrites pour régir le développement (ce qui dénoterait un certain autoritarisme) ; l’existence, enfin, d’une charte avec ses objectifs et ses prétentions à remédier au chaos des villes existantes et à favoriser le bien commun à travers le design (Robbins, 2004).

C’est pourquoi plusieurs auteurs préfèrent parler du nouvel urbanisme d’une façon plus modeste, soulignant qu’il défend des principes issus d’un urbanisme intemporel ou du bon sens, tout simplement. Peter Robinson, dans un article de 1997 dont le titre exprime clairement la réticence dont il est question ici (New Urbanism, Old Urbanism… What’s New Under the Sun?), soulignait par exemple que le concept du transit-oriented development est remarquablement similaire à l’approche préconisée par la planification urbaine néerlandaise, fortement intégrée à la planification des transports, et que les responsables ne considèrent en rien nouvelle. On pourrait aussi mentionner la planification métropolitaine à Copenhague et à Stockholm, largement intégrées aux transports en commun depuis au moins le milieu du XXe siècle.

Une autre critique récurrente, peut-être la plus fondamentale, est que le nouvel urbanisme ne livre tout simplement pas la marchandise, qu’il s’agisse de l’efficacité urbanistique de ses projets ou de la nature des changements que ceux-ci apportent aux agglomérations. En effet, on l’accuse d’être superficiel, faisant passer les considérations autour de l’ambiance issue du design urbain et de l’architecture (bref de l’image) avant les considérations métropolitaines plus fondamentales comme la lutte à l’étalement urbain et à la dépendance automobile. Par exemple, selon Hall (2000), les projets du nouvel urbanisme sont, en favorisant l’architecture nostalgique (nostalgic architecture), une tentative pour recréer l’ambiance des premières banlieues cossues du XIXe siècle et du début du XXe, mais sans en recréer la structure. Aujourd’hui, contrairement aux premières railroad suburbs (prenant notamment exemple sur Forest Hills Gardens à New York, 1909), la plupart des projets du nouvel urbanisme sont, selon l’auteur, carrément dépendants de l’automobile. À l’instar de Hall, Southworth (1997) considère que les projets du nouvel urbanisme n’ont tout simplement pas les caractéristiques et les qualités urbanistiques des modèles desquels ils sont supposés s’inspirer. À cet égard, une critique de Marshall à l’endroit du projet Celebration de Disney, en Floride, est percutante :

Where New Urbanism errs is treating the design of a neighborhood as something done on the level of individual streets and buildings. In reality, a neighborhood is designed within the context of its larger transportation system, which, in the case of Celebration, is the network of freeways and large suburban boulevards. What Celebration is trying to do is re-create an urban neighborhood without creating the transportation network that spawned such neighborhoods. Which is not possible. So what you get is a peculiar thing, an automobile-oriented subdivision dressed up to look like a small pre-car-centered town.

En d’autres mots, si on critique autant le nouvel urbanisme à l’effet qu’il ne constitue pas une solution à l’étalement urbain, c’est principalement en raison de son manque généralisé de densité [1] et de sa forte tendance, en réalité, à favoriser l’automobile et la périurbanisation (Leung, 1995 ; Marshall, 2000). On lui reproche aussi de ne pas intégrer suffisamment les préoccupations écologiques (énergétiques ou autres) ; bref, de ne pas avoir tous les éléments nécessaires pour être considéré comme durable (Beatley, 2000).

Une autre critique importante à l’endroit du nouvel urbanisme est qu’il serait un mouvement élitiste qui ne crée ni ne recherche une véritable mixité sociale (Leung, 1995), se contentant d’une mixité sélective réservée aux couches sociales plus élevées (Marshall, 2000). À la défense du nouvel urbanisme, cependant, de récents projets de redéveloppement urbain aux États-Unis intégreraient davantage, tel que déjà mentionné, la question du logement abordable. Il n’en demeure pas moins qu’une étude récente, qui sondait les opinions et les perceptions des designers, des urbanistes du secteur public ainsi que des promoteurs engagés dans plusieurs projets américains du nouvel urbanisme, n’est pas très encourageante à ce sujet : « Results suggest that principles that focus on neighborhood design but are likely to be contentious – such as provision of affordable housing and accommodation of ethnic diversity – may be compromised in New Urbanist developments » (Garde, 2004 : 158).

On dit aussi du nouvel urbanisme qu’il adopte une attitude déterministe, c’est-à-dire aussi naïve qu’erronée vis-à-vis des rapports entre l’environnement construit et les comportements des gens (Leung, 1995 ; Robbins, 2004). Ceci concerne surtout les comportements individuels attendus en matière de transport et la recherche du (fameux !) sentiment d’appartenance (ou sentiment de communauté). Sur ce dernier point, une étude récente (Lund, 2003) tend toutefois à montrer que certains principes du nouvel urbanisme peuvent effectivement favoriser la marche à pied et une plus grande interaction entre les individus d’un même quartier.

Enfin, d’aucuns questionnent le réalisme de certains principes du nouvel urbanisme face aux préférences et aux attitudes actuelles des individus et des marchés en général en matière d’habitation, de mobilité et plus largement de mode de vie (Fulton, 1996 ; Marshall, 2000 ; Wight, 1995). On vise plus particulièrement en l’occurrence la capacité à développer et à opérer des commerces de proximité économiquement viables, face à un phénomène comme les commerces à grande surface, ainsi que la capacité à mieux intégrer (à rapprocher) les lieux de résidence et les lieux d’emploi.

Si diverses réalités d’aujourd’hui (ménages dont les deux adultes travaillent, mobilité et précarité des emplois, etc.) peuvent convaincre assez aisément de la difficulté à rapprocher emplois et résidences, une étude dont il a été question précédemment (Lund, 2003) indique que les environnements conviviaux pour les piétons favorisent effectivement la marche pour se rendre aux commerces de proximité. De plus, les changements démographiques des sociétés occidentales (vieillissement des populations et diversification des types de ménages) seraient favorables à des développements urbains plus compacts et mixtes (Gordon et Vipond, 2005 ; Myers et Gearin, 2001). Enfin, les services et commerces de proximité auraient une part de marché non pas dans une logique de concurrence avec les commerces régionaux (de type big-box, par exemple), mais plutôt dans une logique de complémentarité avec ces derniers. Une récente étude de Heitmeyer et Kind (2004) tend en effet à valider l’existence d’une demande à cet égard dans les secteurs établis selon les principes du nouvel urbanisme, particulièrement pour des commerces spécialisés destinés au marché de proximité.

Toujours sur cette question importante, d’autres regards sont posés. Kaufmann, dans une étude sur les aspirations et les choix résidentiels de ménages français vivant en banlieue, a montré qu’une partie significative d’entre eux ne choisissaient pas la banlieue pavillonnaire standard et sa dépendance automobile, mais étaient plutôt contraints d’y résider : « l’habitat périurbain apparaît ainsi fréquemment en France être un choix par défaut, faute d’alternatives économiquement et socialement attractives pour les familles » (Kaufmann, 2002 : 129). Dans le même esprit, Bohl (2003) et Levine et Inam (2004) soutiennent que les règles du marché et les règlements d’urbanisme actuels font en sorte de réduire considérablement les choix offerts aux consommateurs, en matière de milieux de vie, en n’offrant pas d’alternatives valables au modèle de la banlieue standard.

On peut constater que le débat et surtout les questions qu’il soulève ne sont pas simples. Avec à propos, plusieurs auteurs reprochent à de nombreux critiques du smart growth et du nouvel urbanisme de manquer de nuances et de rejeter catégoriquement la possibilité de tout changement dans le développement urbain actuel et futur.

Au-delà des critiques

On peut noter une certaine évolution dans les critiques qui sont adressées au smart growth et au nouvel urbanisme. Les commentateurs des années 1990 semblaient beaucoup plus méfiants et négatifs comparativement à ceux d’aujourd’hui, en apparence plus favorables aux deux mouvements (sinon plus nuancés et moins catégoriques envers eux). Cela est sans doute lié à l’évolution même du nouvel urbanisme et à certains changements qu’il aurait réalisés dans la pratique. Cela est peut-être également dû au fait que de nombreuses études récentes appuient, d’une certaine façon, le nouvel urbanisme et le smart growth en revalorisant un urbanisme davantage normatif et ses principes de bonne forme urbaine et de forme urbaine viable, que ce soit pour leurs avantages globaux (Filion, 2004 ; Lewis et al., 2002 ; Talen, 2003b ; Talen et Ellis, 2002 ; Southworth, 2003) ou leurs avantages pour les transports urbains et l’accessibilité (Rajamani et al., 2003 ; Rodriguez et Joo, 2004 ; Srinivasan, 2002 ; Zhang, 2004), ou encore pour la mixité fonctionnelle mise de l’avant dans les développements urbains (Heitmeyer et Kind, 2004 ; Lund, 2003 ; Myers et Gearin, 2001).

D’autres auteurs s’efforcent de mettre en perspective les critiques adressées au smart growth et au nouvel urbanisme et même à retourner la critique. On reproche alors aux tenants de ces critiques d’adopter une position passive (voire défaitiste) et de ne rien proposer en retour. On leur reproche aussi de manquer de nuances et de chercher à caricaturer le mouvement (plus particulièrement le nouvel urbanisme) en le considérant comme un bloc monolithique et en lui prêtant des objectifs démesurés (Dunham-Jones, 2000 ; Ellis, 2002). Ainsi, défendant la position du nouvel urbanisme en matière de mobilité urbaine, Ellis (2002) soutient que celui-ci ne vise pas nécessairement à enrayer la congestion routière, mais poursuit un objectif plus modeste qui est de créer des formes urbaines offrant davantage de choix viables sur le plan du transport. Cet impératif d’offrir davantage de choix, de diversité et de flexibilité par des formes urbaines et métropolitaines plus viables est un argument récurrent qui légitimerait, presque à lui seul, le smart growth et le nouvel urbanisme (Handy, 1996 ; Cervero, 2002 ; Levine et Inam, 2004). Car, comme le souligne Ford, si des formes urbaines différentes ne changent pas automatiquement les comportements des individus par rapport à l’utilisation de l’automobile, il est possible que les gens, s’ils en avaient la chance, pourraient bien agir autrement : « it is possible that people just might behave differently if given the chance » (Ford, 1999 : 254).

Enfin, devant la complexité d’un phénomène comme le nouvel urbanisme, un consensus semble émerger à l’effet qu’il est impératif d’alimenter le débat d’une manière plus éclairée en adoptant des approches d’analyse neutres, du moins davantage pragmatiques, centrées sur les résultats concrets et les impacts réels qu’a tel projet ou telle initiative d’aménagement (Ellis, 2002 ; Falconer Al-Hindi et Till, 2001 ; Ford, 1999). Un apport important, à ce niveau, viendrait du développement de nouvelles méthodologies et de nouveaux outils d’analyse de la forme urbaine qui viseraient notamment à opérationnaliser les concepts et les principes du développement urbain durable, ce qui les rendrait à la fois plus précis et plus efficaces pour rendre compte de la structure métropolitaine. Pour ce faire, on pourrait prendre avantage des dernières avancées et les possibilités offertes par les logiciels spécialisés en système d’information géographique (Avin et Holden, 2000 ; Hess et al., 2001 ; Southworth, 2003 ; Talen, 2003a ; Vernez Moudon, 2000).

La nécessité de faire preuve de pragmatisme et de plus d’objectivité dans l’évaluation du smart growth et du nouvel urbanisme, de même que la légitimité de rechercher une meilleure forme d’urbanisation, plus en accord avec les principes du développement urbain durable, sont deux éléments qui ressortent de notre revue de littérature. D’ailleurs, il existe aujourd’hui dans cette littérature un remarquable consensus (pour ne pas dire une redondance) autour des grands principes urbanistiques susceptibles de favoriser un développement urbain plus durable : un développement qui soit davantage mixte (tant au niveau social qu’au niveau des fonctions), mieux intégré aux transports urbains durables (avec, en tête de liste, le transport en commun et la marche) et, enfin, plus tourné vers la conservation des ressources (financières, écologiques, énergétiques et territoriales). Il s’agit donc d’un plaidoyer et d’une action en faveur d’une urbanisation foncièrement opposée à l’étalement urbain à faible densité et monofonctionnel, qui est considéré comme étant l’antithèse du développement urbain durable.

Le Canada emboîte le pas

Les idées propres au développement urbain durable sont de plus en plus reprises et intégrées, à divers degrés, dans les discours et les documents de planification des gouvernements et des autorités publiques responsables de l’aménagement du territoire et du développement urbain à travers le monde. En Europe, où il existe une longue tradition de planification urbaine, des agglomérations comme Stockholm et Copenhague ont depuis longtemps veillé à intégrer développement urbain et développement des transports publics (Cervero, 1998). Aussi, il n’est pas surprenant qu’une campagne européenne sur le développement urbain durable ait été lancée et qu’une charte (Charte d’Aalborg) ait été signée en 1994 par plusieurs collectivités (Vivre en Ville, 2004 ; Beatley, 2000). En 1998, un rapport du Groupe d’experts sur l’environnement urbain de la Commission européenne, contenant plusieurs recommandations en faveur de la ville durable, était publié. Aujourd’hui, une véritable compétition concernant les plans et les projets de développement urbain les plus durables est ni plus ni moins engagée entre les collectivités de plusieurs nations du nord-ouest européen (Beatley, 2000).

Aux États-Unis, pays symbole de l’étalement urbain s’il en est un, un vif débat a lieu sur le sujet (Downs, 1999 ; Ewing, 1997 ; Gillham, 2002 ; Gordon et Richardson, 1997) et plusieurs États, tels l’Orégon et le Maryland, ont adopté officiellement des initiatives de smart growth. Le gouvernement fédéral, surtout sous la gouverne des démocrates de Bill Clinton et d’Al Gore, avait débuté la promotion de ces principes d’une façon active durant les années 1990. Pour leur part, des organismes fédéraux importants comme le US Department of Energy (États-Unis, 2005a) et la US Environmental Protection Agency (États-Unis, 2005b) professent aussi l’idée de villes plus durables et ciblent l’étalement urbain comme étant un phénomène à maîtriser, alors que le US Department of Transportation a mis davantage de fonds pour les transports urbains durables à la disposition des organisations métropolitaines de planification (Gillham, 2002). Enfin, certaines agglomérations se démarquent par leurs efforts pour la mise en oeuvre de ces principes. Portland, en Oregon, en est le chef de file (Portney, 2003 ; Gibson et Abbott, 2002). Il n’en demeure pas moins que les agglomérations américaines partent évidemment de très loin en matière de lutte à l’étalement urbain.

Au Canada, plusieurs acteurs publics nationaux ont récemment souligné l’importance croissante d’un développement urbain plus durable et ont proposé un nouveau cadre d’action pour le gouvernement fédéral en matière urbaine (Table ronde nationale sur l’environnement et l’économie, 2003 ; Groupe de travail du Premier ministre sur les questions urbaines, 2002). Si bien que selon l’ex-ministre du ministère des Infrastructures et des Collectivités, il existe désormais au Canada « un nouvel urbanisme […] appuyé par tous les ordres de gouvernement » (Godfrey, 2004). Au plan de l’information, la Société canadienne d’hypothèques et de logement (SCHL) a un volet spécifique consacré aux collectivités viables et produit des rapports de recherche sur le sujet depuis déjà plusieurs années (SCHL, 2005). Au Canada, cependant, une question importante, délicate et sans doute non résolue, concerne le rôle que doit et peut jouer le gouvernement fédéral en matière d’aménagement et de développement urbains sans empiéter sur les juridictions provinciales.