Text

Wie führe ich eine große Anzahl von Testfällen mit begrenzter Zeit und Ressourcen aus?

Wahrlich, eine hervorragende Frage. Hier werde ich einige Schritte aus meiner persönlichen Erfahrung erklären.

- Wir brauchen dafür eine gute Teamarbeit.

- Hier möchte ich nur den Begriff "Alle Testfälle/Suite ausführen" klären. Wir müssen die Testfälle in vier Quadranten wie unten beschrieben priorisieren.

- Führt am besten viele explorative Tests anstelle eines vollständig skriptbasierten Ansatzes durch.

- Versucht, alle geschäftskritischen Abläufe zuerst abzudecken.

- Versucht, alle früheren Produktionsfehler zu testen und im aktuellen Regressionszyklus abzudecken.

- Gebt euch etwas Zeit für die richtige Planung, bevor ihr mit einem sequenziellen Ansatz beginnen. Welche Art von Modulen und Testfällen könnt ihr zuerst eliminieren, und entfernt diese zuerst, sodass ihr nun eine Liste aller wichtigen Aufgaben habt. Verwendet Serneut den Prioritätsquadranten .

- Und zu guter Letzt. Wieder brauchen wir Schritt-1

Im Grunde haben ihr nie angemessen Zeit und Ressourcen, um alles zu testen. Eure Testfälle sind bereits eine Teilmenge dieses unendlichen "Alles".

Was könnt also tun? Prioritäten setzen. Eine gängige Heuristik ist RCRCRC:

- Neu: neue Funktionen

- Kern: wesentliche Funktionen Ihres Produkts

- Risiko: Risiko ist definiert als die Wahrscheinlichkeit des Auftretens (wie wahrscheinlich ist es, dass es passiert) multipliziert mit der Auswirkung (wie hoch ist der Schaden, in verlorenen Geldstunden oder irgendetwas Relevantem).

- Konfigurationsempfindlich: dies repräsentiert sowohl die interne Konfiguration als auch die Umgebungseinstellungen, insbesondere den Gerätetyp oder das Betriebssystem.

- Repariert: Kürzlich reparierte Fehler stehen für nicht getestete Bereiche

- Chronisch: einige Bereiche sind als anfällig bekannt. Dies kann auf die Komplexität, das Niveau der Entwickler oder auf einen Bereich zurückzuführen sein, der zwischen den Verantwortlichkeiten liegt.

Nehmt eure Liste der Testfälle und stuft sie für jeden Punkt ein, sagen wir 1 - 5 (verwendet keine Null, da dies den nächsten Schritt beeinträchtigen würde), multipliziert dann die sechsstellige Zahl und sortiert nach dem Ergebnis. So erhaltet ihr eine erste Einschätzung, was zuerst getestet werden sollte und warum.

Weitere Punkte:

Priorisiert die Testfälle

In meinen früheren Projekten haben wir die Testfälle nach Prioritäten geordnet. Wir haben HP ALM verwendet und dort hatten wir auch einige Testfälle und es war unmöglich, sie alle auszuführen. Also haben wir die Testfälle einfach priorisiert, z.B. Kritisch, Sehr Hoch, Hoch, Mittel, Niedrig - so wie man es auch bei Fehlern machen würde. Alle erstellten Testfälle basierten auf der ebenfalls von uns erstellten Veröffentlichungsrichtlinie. Dies half uns, uns auf die wichtigsten Testfälle zu konzentrieren.

Bezieht andere in den Testumfang ein, z. B. Product Owner, und übertragen ihnen einige Testfälle.

Bezieht andere in das Testteam ein. Testen bedeutet nicht, dass ihr nur allein mit euren Testkollegen testet. Es bedeutet, dass ihr auch andere Teammitglieder einbeziehen könnt. In unserem Projekt haben wir daher auch den Product Owner in die Tests einbezogen. Und zwar nicht erst am Ende (z. B. wenn die Bereitstellung erfolgt ist und das UAT über die Fachabteilung und den Product Owner durchgeführt werden sollte). In Janet Gregorys Buch habe ich den Hinweis gefunden, dass UAT meist erst nach dem Deployment durchgeführt wird und dies nicht bedeutet, dass man es dem Endspiel überlassen sollte (Janet Gregory "More Agile Testing" Seite 202). Wenn man ein Produkt testet, kann man natürlich auch andere Stakeholder einbeziehen, um ein Produkt zu testen. In unserem Fall haben unsere Product Owner geholfen, einige Testfälle zu testen! Übrigens könnt ihr auch die UX-Abteilung bitten, euch zu unterstützen. Wir haben auch unsere UX-Abteilung gebeten, uns bei der Durchführung einiger Testfälle zu unterstützen, und wir haben auch von ihnen wertvolles Feedback erhalten.

Organisiert eine Art Mob-Testing und agiert als Testkoordinator, der euch Testfälle zuwirft!

Ihr könnt auch versuchen, eine Mob-Testing-Sitzung durchzuführen. Gebt ihnen einfach einige Testfälle (die leicht verständlich sind) und einige Anweisungen (und bereitet z.B. Testdaten vor) und lasst sie die Testfälle einfach ausführen! Wir haben dies getan, als wir einige Beteiligte aus anderen Abteilungen eingeladen haben, um uns zu unterstützen! Das hat funktioniert und der Input war sehr hilfreich für uns (weil wir auch Feedback für neue Änderungswünsche bekamen). Das Gute daran war, dass wir nur einen unserer Testanalysten dorthin schickten, der für vier bis fünf Zweiergruppen verantwortlich war. Irgendwie ist das wie ein Beschleuniger, um mit den Testfällen voranzukommen.

Bittet die Fachabteilung um Unterstützung

Wir haben auch die Fachabteilung um Unterstützung gebeten. Normalerweise wird die Fachabteilung nur tätig, wenn das UAT durchgeführt werden soll. Wir baten sie jedoch um Unterstützung und begründeten dies damit, dass die Hilfe wertvoll wäre, um ein (test-)stabiles Produkt zu liefern.

Verwendung eines Protokollierungstools für Sondierungstests

Wir haben auch den Zeitaufwand für die Erstellung von Testfällen reduziert, als wir uns für den Einsatz eines Capture-Replay-Tools entschieden haben. In unserem Fall war es tricentis/quasymphony. Während der Testdurchführung erstellt dieses Tool Testfälle und während dieser Zeit haben wir eine Art exploratives Testen durchgeführt. Das heißt, Ausführung und Erstellung von Testfällen. Dadurch wurde die Zeit für die Erstellung konkreter Testfälle etwas verkürzt.

Ihr seht, es gibt eine Menge Ideen. Aber die wichtigste ist, dass Testen ein Ansatz für das ganze Team ist! Ihr könnt also alle relevanten Beteiligten zur Unterstützung einladen - und unserer Erfahrung nach waren die meisten bereit, uns zu unterstützen.

Read the full article

0 notes

Text

Was ist der Unterschied zwischen "automatisierten Tests" und "automatisierten Regressionstests"?

Ein Regressionstest ist etwas, das eure Testergebnisse mit bestimmten Anforderungen abgleicht. Gute Beispiele hierfür sind Unit-Tests und funktionale Tests. Diese geben Aufschluss darüber, ob sich die Funktionalität eurer Anwendung verschlechtert hat oder nicht (daher Regression).

Es gibt noch andere Arten von automatisierten Tests: Fuzzy-Inputs und automatisierte Erkundungstests kommen mir in den Sinn. Diese haben nicht immer vorhersehbare, wiederholbare Ergebnisse, wie eure Regressionstests. Für einen Tester wäre es ziemlich mühsam und zeitaufwendig, sie manuell durchzuführen, daher ist es nicht verkehrt, sie zu automatisieren und das Ergebnis zu betrachten. Die Grenze des Testens liegt darin, wie schnell man denken und dann automatisieren kann, und nicht darin, wie schnell man klicken kann.

Einige Beispiele für automatisierte Nicht-Regressionstests sind:

- Jeder automatisierte Test, der weggeworfen und nicht für Regressionstests verwendet wird, ist kein Regressionstest, einschließlich Unit-Tests, die später nicht für Regressionstests verwendet werden. Technisch gesehen ist jeder automatisierte Test, der für eine neue Funktionalität geschrieben wurde, kein Regressionstest, solange er nicht mindestens einmal die korrekte Funktionalität überprüft hat. Erst dann kann er nachweisen, dass sich die Funktionalität nicht geändert hat.

- Zuverlässigkeitstests, bei denen ihr das zu testende System so lange wie möglich in einer produktionsnahen Umgebung laufen lasst, um zu sehen, wie lange es ohne Fehler oder Abstürze läuft

Stresstests, bei denen es darum geht, zu sehen, wie sich das zu testende System bei starker Beanspruchung oder eingeschränkten Ressourcen verhält; Ihr könnt z. B. CPUs entfernen oder die Bandbreite verringern oder eine große Anzahl von Benutzern simulieren.

- Bei einigen Leistungstests gibt es möglicherweise keine spezifischen Prüfungen, die zu verifizieren sind, und es wird eine Person benötigt, um die Ergebnisse zu interpretieren, obwohl einige Leistungstests als Regressionstests durchgeführt werden können (z. B. "Führe 100 Iterationen dieser Funktion aus. Wenn es weniger als 5 Sekunden gedauert hat, ist der Test bestanden, ansonsten ist er fehlgeschlagen").

Glowcoder erwähnte Fuzz-Tests, bei denen die Eingaben in eine Funktion nach dem Zufallsprinzip erfolgen, aber das Thema verdient es, etwas erweitert zu werden. Beim Fuzz-Testing sucht der Tester nach unerwartetem Verhalten, das Probleme verursachen könnte, wie Sicherheitslücken, Abstürze und Hänger.

Beispiele für Regressionstests sind:

- Wiederholung früherer Tests: Tests, die zuvor durchgeführt wurden, um sicherzustellen, dass sie auch nach einer Änderung weiterhin erfolgreich durchgeführt werden können.

- Funktionalitätstests: Tests, die sicherstellen, dass die bestehenden Funktionen der Software nach einer Änderung weiterhin korrekt funktionieren. Dies kann z.B. die Überprüfung von Benutzereingaben, die Ausgabe von Daten oder die Interaktion mit anderen Systemen umfassen.

- Edge-Case-Tests: Tests, die sicherstellen, dass die Software auch in Randfällen oder ungewöhnlichen Szenarien korrekt funktioniert. Dies könnte z.B. die Behandlung von ungültigen Eingaben oder unerwarteten Zuständen sein.

- Integrationstests: Tests, die sicherstellen, dass die Software nach einer Änderung weiterhin korrekt mit anderen Komponenten oder Systemen interagiert.

- Leistungstests als Regressionstests: Bestimmte Leistungstests können auch als Regressionstests dienen, wenn sie sicherstellen, dass Änderungen keine negativen Auswirkungen auf die Leistung der Software haben.

Aber wie definiert man das nun genauer?

"Automatisierte Tests" bezieht sich im Allgemeinen auf Tests, die automatisiert durchgeführt werden, um die Funktionalität einer Software zu überprüfen. Diese Tests können verschiedene Arten von Tests umfassen, wie z.B. Unit-Tests, Integrationstests oder Systemtests. Das Hauptziel automatisierter Tests ist es, Fehler frühzeitig im Entwicklungsprozess zu finden und die Qualität der Software sicherzustellen.

"Automatisierte Regressionstests" sind eine spezifische Art von automatisierten Tests, die darauf abzielen, sicherzustellen, dass neue Änderungen oder Updates an einer Software keine bereits behobenen Fehler reintroduzieren (Regressionen). Sie überprüfen, ob die bestehende Funktionalität nach einer Änderung immer noch wie erwartet funktioniert. Regressionstests werden typischerweise nach jeder Änderung am Code oder an der Konfiguration durchgeführt, um sicherzustellen, dass keine unerwünschten Nebeneffekte auftreten.

Read the full article

0 notes

Text

Wie testet man das Datenmigrationsverfahren?

Datenmigration ist ein entscheidender Schritt bei der Aktualisierung von Systemen, dem Wechsel von Plattformen oder der Konsolidierung von Datenquellen. Es handelt sich dabei um den Prozess des Übertragens von Daten von einem Speicherort auf einen anderen, während sicherzustellen ist, dass die Integrität, Sicherheit und Qualität der Daten erhalten bleiben. Da Daten das Rückgrat vieler Unternehmen bilden, ist es unerlässlich, das Datenmigrationsverfahren sorgfältig zu testen, um unerwünschte Auswirkungen zu vermeiden. Und ja es wird nicht einfach, versuchen wir heute mal eine sinnvolle Anleitung zu diesem Thema hier zu erarbeiten.

Aus meiner persönlichen Erfahrung würde ich auf einige zusätzliche Dinge achten:

- Stellt sicher, dass ihr euch die aktuellen Randfälle anseht und diese bei der Migration berücksichtigt werden. Für einen Entwickler ist es einfach, alle Daten zu verarbeiten, die normalerweise erwartet werden. Es gibt jedoch immer Grenzfälle, in denen Daten für bestimmte Kunden oder bestimmte Konfigurationen anders gespeichert werden, und ihr müsst sicherstellen, dass auch diese Sonderfälle ordnungsgemäß behandelt werden.

- Wenn das System während der Migration online sein wird (ich denke an eine Migration, die Stunden oder sogar Tage oder Wochen dauern kann), stellt sicher, dass der Bereinigungsprozess nach dem ersten Durchlauf, um alle Daten seit dem Beginn der Migration zu erhalten, genauso robust ist wie der ursprüngliche Prozess. Für Entwickler ist es einfach, weniger Zeit auf diesen Teil zu verwenden, aber er ist genauso wichtig. Es ist auch schwieriger zu testen, wenn ihr nur mit einer kleinen Teilmenge der Daten testet.

https://www.youtube.com/watch?v=cmiJm-_GdVA

Hier sind einige bewährte Methoden, wie man das Datenmigrationsverfahren erfolgreich testet:

- Erstellung eines Testplans: Bevor ihr mit dem Testen beginnt, ist es wichtig, einen detaillierten Testplan zu erstellen. Dieser sollte die Ziele der Migration, die zu testenden Szenarien, die verwendeten Werkzeuge und die zugewiesenen Ressourcen umfassen. Hier Beispiele: 01,02,03

- Testumgebung einrichten: Eine dedizierte Testumgebung sollte eingerichtet werden, die die Produktionsumgebung so genau wie möglich nachbildet. Dies ermöglicht es, Tests durchzuführen, ohne die Live-Daten zu gefährden. Eigentlich natürlich der entscheidende Punkt, den man immer umsetzen muss. Fummelt bitte nicht irgendwie und irgendwo am Live-System herum. Selbst wenn euer Vorgesetzter das verlangt!

- Datenprofilierung: Vor der Migration sollten die Daten gründlich analysiert und profiliert werden, um ein besseres Verständnis für ihre Struktur, Qualität und Beziehungen zu erhalten. Dies hilft, potenzielle Probleme im Voraus zu erkennen.

- Durchführung von Stresstests: Simuliert eine hohe Last oder große Datenmengen, um sicherzustellen, dass das Migrationsverfahren unter extremen Bedingungen stabil bleibt. Dies kann die Leistungsfähigkeit der Zielsysteme bewerten und Engpässe identifizieren.

- Vollständigkeitstests: Überprüft, ob alle erforderlichen Daten erfolgreich migriert wurden und ob keine Daten verloren gegangen sind. Vergleicht die Quell- und Ziel-Datensätze, um sicherzustellen, dass die Migration vollständig war.

- Validierung der Datenintegrität: Überprüft die Integrität der Daten nach der Migration, indem ihr sicherstellt, dass sie konsistent, korrekt und vollständig sind. Dies kann durch Vergleich mit Quelldaten, Validierung von Referenzintegrität und Durchführung von Datenintegritätstests erfolgen.

- Wiederherstellungstests: Simuliert mögliche Fehler- oder Unterbrechungsszenarien und überprüft die Fähigkeit des Systems, sich zu erholen und den Migrationsprozess fortzusetzen.

- Sicherheitstests: Stellt sicher, dass sensible Daten während des Migrationsprozesses angemessen geschützt sind und Sicherheitsrichtlinien eingehalten werden. Überprüft die Zugriffskontrollen und Verschlüsselungsmechanismen, um potenzielle Sicherheitslücken zu identifizieren.

- Benutzertests: Führt Tests durch, um sicherzustellen, dass die Benutzererfahrung nach der Migration nicht beeinträchtigt wird. Überprüfen Sie die Funktionalität von Anwendungen und Benutzeroberflächen, um sicherzustellen, dass sie wie erwartet funktionieren.

- Dokumentation: Dokumentiert sorgfältig alle Tests, Ergebnisse und beobachteten Probleme während des gesamten Migrationsprozesses. Dies dient als Referenz für zukünftige Migrationen und ermöglicht es, bewährte Praktiken zu etablieren.

Read the full article

0 notes

Text

Die Kunst der Eingabevalidierung: So schützt ihr eure Website vor schädlichen Benutzereingaben

Die Sicherheit eurer Website steht an erster Stelle, und eine der grundlegenden Maßnahmen zur Gewährleistung der Sicherheit besteht darin, die von Benutzern eingegebenen Daten sorgfältig zu validieren und zu säubern. In diesem Artikel werden wir uns eingehend mit der Eingabevalidierung befassen und wie ihr diese automatisieren könnt, um eure Website vor potenziell schädlichen Benutzereingaben zu schützen.

Was ist die Eingabevalidierung?

Eingabevalidierung, auch als Säubern von Eingaben bezeichnet, beinhaltet die Überprüfung von Daten, die von Benutzern bereitgestellt werden, auf Einhaltung vordefinierter Regeln. Dieser Prozess ist entscheidend, um sicherzustellen, dass nur Daten akzeptiert und gespeichert werden, die den festgelegten Kriterien entsprechen. Ein klassisches Beispiel hierfür sind E-Mail- und Passworteingaben, bei denen spezifische Regeln gelten, wie das Vorhandensein des "@"-Symbols in einer E-Mail-Adresse oder die Mindestanzahl von Zeichen für ein Passwort.

Automatisierung der Eingabevalidierung

Die Automatisierung der Eingabevalidierung ist ein wichtiger Schritt, um sicherzustellen, dass eure Website immer geschützt ist. Hier sind die Schritte zur Automatisierung:

- Definiert Validierungsregeln: Beginnt damit, klare Regeln für die Validierung eurer Benutzereingaben festzulegen. Überlegt euch, welche Bedingungen erfüllt sein müssen, damit eine Eingabe als gültig betrachtet wird.

- Erstellt Testfälle: Entwickelt Testfälle, die die Validierung Ihrer Eingaben überprüfen. Denkt dabei an verschiedene Szenarien, wie das Testen von ungültigen Zeichen, SQL-Injektionen oder überlangen Eingaben.

- Verwendet ein Test-Framework: Wählt ein geeignetes Test-Framework für eure Anwendung aus. Beliebte Optionen sind Selenium für Webanwendungen oder Appium für mobile Anwendungen.

- Integriert Tests in euren Workflow: Automatisierte Tests zur Validierung von Benutzereingaben sollten integraler Bestandteil eures Entwicklungs- und Bereitstellungsworkflows sein. Diese sollten bei jeder Code-Änderung automatisch ausgeführt werden.

- Überwacht die Ergebnisse: Stellt sicher, dass eure Tests die erwarteten Ergebnisse liefern. Wenn eine Validierung fehlschlägt, sollte die Benutzeroberfläche den Benutzer darüber informieren und ihn daran hindern, fortzufahren, bis die Eingabe korrigiert ist.

Beispiele für Testfälle

Beispiel 1: Registrierungsformular für eine Website

Annahmen:

- Die Website erfordert eine Registrierung mit Benutzername, E-Mail-Adresse und Passwort.

- Der Benutzername darf nur aus Buchstaben und Zahlen bestehen.

- Die E-Mail-Adresse muss ein "@"-Zeichen enthalten.

- Das Passwort muss mindestens 8 Zeichen lang sein.

Testfälle:

- Ein gültiger Benutzername, eine gültige E-Mail-Adresse und ein gültiges Passwort werden eingegeben. Der Benutzer sollte erfolgreich registriert werden.

- Ein Benutzername mit Sonderzeichen wird eingegeben. Das System sollte eine Fehlermeldung anzeigen.

- Eine ungültige E-Mail-Adresse (ohne "@"-Zeichen) wird eingegeben. Das System sollte eine Fehlermeldung anzeigen.

- Ein zu kurzes Passwort (weniger als 8 Zeichen) wird eingegeben. Das System sollte eine Fehlermeldung anzeigen.

Automatisierung

Dieses Beispiel zeigt, wie ihr mit Selenium Testfälle für die Registrierung auf einer Website durchführen könnt. Beachtet, dass ihr die Elemente (z.B., "username", "email", "password") und IDs entsprechend eurer Website anpassen müssen. Sie können auch weitere Testfälle hinzufügen, um die Abdeckung der Validierungsfunktionen zu erhöhen.

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

# Starten des Webdrivers (z.B., Chrome)

driver = webdriver.Chrome()

# Testfall 1: Gültige Registrierung

driver.get("http://example.com/register")

username = driver.find_element_by_id("username")

email = driver.find_element_by_id("email")

password = driver.find_element_by_id("password")

username.send_keys("gültigerBenutzer123")

email.send_keys("gü[email protected]")

password.send_keys("sicheresPasswort123")

password.send_keys(Keys.RETURN) # Drückt die Enter-Taste

# Testfall 2: Ungültiger Benutzername mit Sonderzeichen

driver.get("http://example.com/register")

username = driver.find_element_by_id("username")

username.send_keys("ungültiger!Benutzer")

# Klicken auf die Registrieren-Schaltfläche

register_button = driver.find_element_by_id("register-button")

register_button.click()

# Überprüfen, ob eine Fehlermeldung angezeigt wird

error_message = driver.find_element_by_id("error-message")

assert "Ungültiger Benutzername" in error_message.text

# Testfall 3: Ungültige E-Mail-Adresse ohne "@"-Zeichen

driver.get("http://example.com/register")

email = driver.find_element_by_id("email")

email.send_keys("ungültigeemail.com")

# Klicken auf die Registrieren-Schaltfläche

register_button = driver.find_element_by_id("register-button")

register_button.click()

# Überprüfen, ob eine Fehlermeldung angezeigt wird

error_message = driver.find_element_by_id("error-message")

assert "Ungültige E-Mail-Adresse" in error_message.text

# Testfall 4: Zu kurzes Passwort

driver.get("http://example.com/register")

password = driver.find_element_by_id("password")

password.send_keys("kurz")

# Klicken auf die Registrieren-Schaltfläche

register_button = driver.find_element_by_id("register-button")

register_button.click()

# Überprüfen, ob eine Fehlermeldung angezeigt wird

error_message = driver.find_element_by_id("error-message")

assert "Passwort zu kurz" in error_message.text

# Schließen des Browsers

driver.quit()

Beispiel 2: Kommentarfunktion in einem Blog

Annahmen:

- Die Blog-Plattform ermöglicht es Benutzern, Kommentare zu Beiträgen zu hinterlassen.

- Kommentare sollten keine HTML- oder JavaScript-Tags enthalten, um Cross-Site Scripting (XSS) zu verhindern.

Testfälle:

- Ein gültiger Kommentar ohne HTML- oder JavaScript-Tags wird hinterlassen. Der Kommentar sollte veröffentlicht werden.

- Ein Kommentar mit HTML-Tags (z.B., Besuch diese Seite!) wird hinterlassen. Das System sollte die Tags entfernen und den Kommentar veröffentlichen.

- Ein Kommentar mit JavaScript-Code (z.B., ) wird hinterlassen. Das System sollte den Code entfernen und den Kommentar veröffentlichen.

- Ein Kommentar mit einer Kombination von HTML-Tags und JavaScript-Code wird hinterlassen. Das System sollte alle unerwünschten Elemente entfernen und den Kommentar veröffentlichen.

Automatisierung

Dieses Beispiel zeigt, wie ihr die Testfälle für die Kommentarfunktion eines Blogs in Python mit Selenium umsetzen könnt. Stellt sicher, dass Sie die Elemente (z.B., "comment-box", "submit-comment") und IDs entsprechend eurer Website anpassen. Dieses Beispiel demonstriert die Validierung und Säuberung von Benutzereingaben in einem realen Anwendungsszenario.

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

import time

# Starten des Webdrivers (z.B., Chrome)

driver = webdriver.Chrome()

# Testfall 1: Gültiger Kommentar ohne HTML- oder JavaScript-Tags

driver.get("http://example-blog.com/post/123")

comment_box = driver.find_element_by_id("comment-box")

comment_text = "Dies ist ein gültiger Kommentar ohne Tags."

comment_box.send_keys(comment_text)

# Klicken auf die "Kommentar abschicken"-Schaltfläche

submit_button = driver.find_element_by_id("submit-comment")

submit_button.click()

# Überprüfen, ob der Kommentar erfolgreich veröffentlicht wurde

time.sleep(2) # Warten auf die Verarbeitung

comments = driver.find_elements_by_class_name("comment")

last_comment = comments

assert comment_text in last_comment.text

# Testfall 2: Kommentar mit HTML-Tags

driver.get("http://example-blog.com/post/123")

comment_box = driver.find_element_by_id("comment-box")

comment_text = "Besuch diese Seite!"

comment_box.send_keys(comment_text)

# Klicken auf die "Kommentar abschicken"-Schaltfläche

submit_button = driver.find_element_by_id("submit-comment")

submit_button.click()

# Überprüfen, ob HTML-Tags entfernt wurden und der Kommentar veröffentlicht wurde

time.sleep(2) # Warten auf die Verarbeitung

comments = driver.find_elements_by_class_name("comment")

last_comment = comments

assert "Besuch diese Seite!" in last_comment.text

assert "" not in last_comment.text

# Testfall 3: Kommentar mit JavaScript-Code

driver.get("http://example-blog.com/post/123")

comment_box = driver.find_element_by_id("comment-box")

comment_text = ""

comment_box.send_keys(comment_text)

# Klicken auf die "Kommentar abschicken"-Schaltfläche

submit_button = driver.find_element_by_id("submit-comment")

submit_button.click()

# Überprüfen, ob JavaScript-Code entfernt wurde und der Kommentar veröffentlicht wurde

time.sleep(2) # Warten auf die Verarbeitung

comments = driver.find_elements_by_class_name("comment")

last_comment = comments

assert "Böser Code" not in last_comment.text

assert "" not in last_comment.text

# Testfall 4: Kommentar mit Kombination von HTML-Tags und JavaScript-Code

driver.get("http://example-blog.com/post/123")

comment_box = driver.find_element_by_id("comment-box")

comment_text = "Besuch diese Seite!"

comment_box.send_keys(comment_text)

# Klicken auf die "Kommentar abschicken"-Schaltfläche

submit_button = driver.find_element_by_id("submit-comment")

submit_button.click()

# Überprüfen, ob alle unerwünschten Elemente entfernt wurden und der Kommentar veröffentlicht wurde

time.sleep(2) # Warten auf die Verarbeitung

comments = driver.find_elements_by_class_name("comment")

last_comment = comments

assert "Besuch diese Seite!" in last_comment.text

assert "" not in last_comment.text

assert "Böser Code" not in last_comment.text

assert "" not in last_comment.text

# Schließen des Browsers

driver.quit()

Read the full article

0 notes

Text

Die Kunst der Eingabevalidierung: So schützt ihr eure Website vor schädlichen Benutzereingaben

Die Sicherheit eurer Website steht an erster Stelle, und eine der grundlegenden Maßnahmen zur Gewährleistung der Sicherheit besteht darin, die von Benutzern eingegebenen Daten sorgfältig zu validieren und zu säubern. In diesem Artikel werden wir uns eingehend mit der Eingabevalidierung befassen und wie ihr diese automatisieren könnt, um eure Website vor potenziell schädlichen Benutzereingaben zu schützen.

Was ist die Eingabevalidierung?

Eingabevalidierung, auch als Säubern von Eingaben bezeichnet, beinhaltet die Überprüfung von Daten, die von Benutzern bereitgestellt werden, auf Einhaltung vordefinierter Regeln. Dieser Prozess ist entscheidend, um sicherzustellen, dass nur Daten akzeptiert und gespeichert werden, die den festgelegten Kriterien entsprechen. Ein klassisches Beispiel hierfür sind E-Mail- und Passworteingaben, bei denen spezifische Regeln gelten, wie das Vorhandensein des "@"-Symbols in einer E-Mail-Adresse oder die Mindestanzahl von Zeichen für ein Passwort.

Automatisierung der Eingabevalidierung

Die Automatisierung der Eingabevalidierung ist ein wichtiger Schritt, um sicherzustellen, dass eure Website immer geschützt ist. Hier sind die Schritte zur Automatisierung:

- Definiert Validierungsregeln: Beginnt damit, klare Regeln für die Validierung eurer Benutzereingaben festzulegen. Überlegt euch, welche Bedingungen erfüllt sein müssen, damit eine Eingabe als gültig betrachtet wird.

- Erstellt Testfälle: Entwickelt Testfälle, die die Validierung Ihrer Eingaben überprüfen. Denkt dabei an verschiedene Szenarien, wie das Testen von ungültigen Zeichen, SQL-Injektionen oder überlangen Eingaben.

- Verwendet ein Test-Framework: Wählt ein geeignetes Test-Framework für eure Anwendung aus. Beliebte Optionen sind Selenium für Webanwendungen oder Appium für mobile Anwendungen.

- Integriert Tests in euren Workflow: Automatisierte Tests zur Validierung von Benutzereingaben sollten integraler Bestandteil eures Entwicklungs- und Bereitstellungsworkflows sein. Diese sollten bei jeder Code-Änderung automatisch ausgeführt werden.

- Überwacht die Ergebnisse: Stellt sicher, dass eure Tests die erwarteten Ergebnisse liefern. Wenn eine Validierung fehlschlägt, sollte die Benutzeroberfläche den Benutzer darüber informieren und ihn daran hindern, fortzufahren, bis die Eingabe korrigiert ist.

Beispiele für Testfälle

Beispiel 1: Registrierungsformular für eine Website

Annahmen:

- Die Website erfordert eine Registrierung mit Benutzername, E-Mail-Adresse und Passwort.

- Der Benutzername darf nur aus Buchstaben und Zahlen bestehen.

- Die E-Mail-Adresse muss ein "@"-Zeichen enthalten.

- Das Passwort muss mindestens 8 Zeichen lang sein.

Testfälle:

- Ein gültiger Benutzername, eine gültige E-Mail-Adresse und ein gültiges Passwort werden eingegeben. Der Benutzer sollte erfolgreich registriert werden.

- Ein Benutzername mit Sonderzeichen wird eingegeben. Das System sollte eine Fehlermeldung anzeigen.

- Eine ungültige E-Mail-Adresse (ohne "@"-Zeichen) wird eingegeben. Das System sollte eine Fehlermeldung anzeigen.

- Ein zu kurzes Passwort (weniger als 8 Zeichen) wird eingegeben. Das System sollte eine Fehlermeldung anzeigen.

Automatisierung

Dieses Beispiel zeigt, wie ihr mit Selenium Testfälle für die Registrierung auf einer Website durchführen könnt. Beachtet, dass ihr die Elemente (z.B., "username", "email", "password") und IDs entsprechend eurer Website anpassen müssen. Sie können auch weitere Testfälle hinzufügen, um die Abdeckung der Validierungsfunktionen zu erhöhen.

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

# Starten des Webdrivers (z.B., Chrome)

driver = webdriver.Chrome()

# Testfall 1: Gültige Registrierung

driver.get("http://example.com/register")

username = driver.find_element_by_id("username")

email = driver.find_element_by_id("email")

password = driver.find_element_by_id("password")

username.send_keys("gültigerBenutzer123")

email.send_keys("gü[email protected]")

password.send_keys("sicheresPasswort123")

password.send_keys(Keys.RETURN) # Drückt die Enter-Taste

# Testfall 2: Ungültiger Benutzername mit Sonderzeichen

driver.get("http://example.com/register")

username = driver.find_element_by_id("username")

username.send_keys("ungültiger!Benutzer")

# Klicken auf die Registrieren-Schaltfläche

register_button = driver.find_element_by_id("register-button")

register_button.click()

# Überprüfen, ob eine Fehlermeldung angezeigt wird

error_message = driver.find_element_by_id("error-message")

assert "Ungültiger Benutzername" in error_message.text

# Testfall 3: Ungültige E-Mail-Adresse ohne "@"-Zeichen

driver.get("http://example.com/register")

email = driver.find_element_by_id("email")

email.send_keys("ungültigeemail.com")

# Klicken auf die Registrieren-Schaltfläche

register_button = driver.find_element_by_id("register-button")

register_button.click()

# Überprüfen, ob eine Fehlermeldung angezeigt wird

error_message = driver.find_element_by_id("error-message")

assert "Ungültige E-Mail-Adresse" in error_message.text

# Testfall 4: Zu kurzes Passwort

driver.get("http://example.com/register")

password = driver.find_element_by_id("password")

password.send_keys("kurz")

# Klicken auf die Registrieren-Schaltfläche

register_button = driver.find_element_by_id("register-button")

register_button.click()

# Überprüfen, ob eine Fehlermeldung angezeigt wird

error_message = driver.find_element_by_id("error-message")

assert "Passwort zu kurz" in error_message.text

# Schließen des Browsers

driver.quit()

Beispiel 2: Kommentarfunktion in einem Blog

Annahmen:

- Die Blog-Plattform ermöglicht es Benutzern, Kommentare zu Beiträgen zu hinterlassen.

- Kommentare sollten keine HTML- oder JavaScript-Tags enthalten, um Cross-Site Scripting (XSS) zu verhindern.

Testfälle:

- Ein gültiger Kommentar ohne HTML- oder JavaScript-Tags wird hinterlassen. Der Kommentar sollte veröffentlicht werden.

- Ein Kommentar mit HTML-Tags (z.B., Besuch diese Seite!) wird hinterlassen. Das System sollte die Tags entfernen und den Kommentar veröffentlichen.

- Ein Kommentar mit JavaScript-Code (z.B., ) wird hinterlassen. Das System sollte den Code entfernen und den Kommentar veröffentlichen.

- Ein Kommentar mit einer Kombination von HTML-Tags und JavaScript-Code wird hinterlassen. Das System sollte alle unerwünschten Elemente entfernen und den Kommentar veröffentlichen.

Automatisierung

Dieses Beispiel zeigt, wie ihr die Testfälle für die Kommentarfunktion eines Blogs in Python mit Selenium umsetzen könnt. Stellt sicher, dass Sie die Elemente (z.B., "comment-box", "submit-comment") und IDs entsprechend eurer Website anpassen. Dieses Beispiel demonstriert die Validierung und Säuberung von Benutzereingaben in einem realen Anwendungsszenario.

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

import time

# Starten des Webdrivers (z.B., Chrome)

driver = webdriver.Chrome()

# Testfall 1: Gültiger Kommentar ohne HTML- oder JavaScript-Tags

driver.get("http://example-blog.com/post/123")

comment_box = driver.find_element_by_id("comment-box")

comment_text = "Dies ist ein gültiger Kommentar ohne Tags."

comment_box.send_keys(comment_text)

# Klicken auf die "Kommentar abschicken"-Schaltfläche

submit_button = driver.find_element_by_id("submit-comment")

submit_button.click()

# Überprüfen, ob der Kommentar erfolgreich veröffentlicht wurde

time.sleep(2) # Warten auf die Verarbeitung

comments = driver.find_elements_by_class_name("comment")

last_comment = comments

assert comment_text in last_comment.text

# Testfall 2: Kommentar mit HTML-Tags

driver.get("http://example-blog.com/post/123")

comment_box = driver.find_element_by_id("comment-box")

comment_text = "Besuch diese Seite!"

comment_box.send_keys(comment_text)

# Klicken auf die "Kommentar abschicken"-Schaltfläche

submit_button = driver.find_element_by_id("submit-comment")

submit_button.click()

# Überprüfen, ob HTML-Tags entfernt wurden und der Kommentar veröffentlicht wurde

time.sleep(2) # Warten auf die Verarbeitung

comments = driver.find_elements_by_class_name("comment")

last_comment = comments

assert "Besuch diese Seite!" in last_comment.text

assert "" not in last_comment.text

# Testfall 3: Kommentar mit JavaScript-Code

driver.get("http://example-blog.com/post/123")

comment_box = driver.find_element_by_id("comment-box")

comment_text = ""

comment_box.send_keys(comment_text)

# Klicken auf die "Kommentar abschicken"-Schaltfläche

submit_button = driver.find_element_by_id("submit-comment")

submit_button.click()

# Überprüfen, ob JavaScript-Code entfernt wurde und der Kommentar veröffentlicht wurde

time.sleep(2) # Warten auf die Verarbeitung

comments = driver.find_elements_by_class_name("comment")

last_comment = comments

assert "Böser Code" not in last_comment.text

assert "" not in last_comment.text

# Testfall 4: Kommentar mit Kombination von HTML-Tags und JavaScript-Code

driver.get("http://example-blog.com/post/123")

comment_box = driver.find_element_by_id("comment-box")

comment_text = "Besuch diese Seite!"

comment_box.send_keys(comment_text)

# Klicken auf die "Kommentar abschicken"-Schaltfläche

submit_button = driver.find_element_by_id("submit-comment")

submit_button.click()

# Überprüfen, ob alle unerwünschten Elemente entfernt wurden und der Kommentar veröffentlicht wurde

time.sleep(2) # Warten auf die Verarbeitung

comments = driver.find_elements_by_class_name("comment")

last_comment = comments

assert "Besuch diese Seite!" in last_comment.text

assert "" not in last_comment.text

assert "Böser Code" not in last_comment.text

assert "" not in last_comment.text

# Schließen des Browsers

driver.quit()

Read the full article

0 notes

Text

Wie kann man Testfälle für ein Spezifikationsdokument erstellen?

Das Testen einer funktionalen Design-Layout-Spezifikationsdatei kann recht überwältigend erscheinen, ist jedoch eine wesentliche Methode, um sicherzustellen, dass das weiterentwickelte Softwareprodukt die gewünschten Anforderungen erfüllt. Hier sind die Schritte, die ihr befolgen könnt, um Testinstanzen für eine Spezifikationsdatei zu erstellen:

- Stimmige Informationen: Vergewissert euch, dass ihr über ausgezeichnete Informationen über die Datei und ihre zahlreichen Abschnitte verfügt, einschließlich des Zwecks, der Funktionen und der Erfordernisse.

- Alle Anforderungen: Sucht nach den genauen Anforderungen in der Datei und erstellt eine Liste aller Funktionen und Merkmale, die geprüft werden sollen.

- Grundlage für Anforderungen: Legt auf der Grundlage der Anforderungen die Ziele der einzelnen Prüfungen fest und bestimmt die voraussichtlichen Endergebnisse.

- Aufteilung der Anforderungen: Teilt die Anforderungen in kleinere, realisierbare Teile auf, die einzeln geprüft werden können. Dies wird euch helfen, extra zentrierte und vollständige Prüffälle zu erstellen.

- Saubere Prüffälle: Schreibt die sogenannten Prüffälle sauber und prägnant auf, einschließlich der Prüfschritte, der voraussichtlichen Ergebnisse und aller Vorbedingungen, die erfüllt sein müssen.

- Prüfinstanzen überprüfen: Überprüft die Prüfinstanzen, um sicherzugehen, dass sie vollständig und genau sind und alle in der Datei enthaltenen Anforderungen erfüllen.

- Priorisierung: Basierend auf der Kritikalität der Anforderungen, priorisiert die Prüfinstanzen so, dass die wichtigsten zuerst geprüft werden.

- Ergebnisse archivieren: Führt die Prüfinstanzen durch und archiviert die Ergebnisse. Wenn irgendwelche Fehler oder Defekte gefunden werden, dokumentiert diese und arbeitet mit der Verbesserungsgruppe zusammen, um sie zu beheben.

- Überprüfen: Überprüft die Prüfinstanzen regelmäßig und ersetzet sie, wenn Anpassungen an der Spezifikationsdatei vorgenommen werden.

Beispiel eines Testfalls für ein Feature aus einem Spezifikationsdokument

Feature: Passwort-Zurücksetzung über E-Mail

Spezifikationsdetails:

- Der Benutzer sollten in der Lage sein, ihr Passwort über einen "Passwort vergessen?"-Link auf der Login-Seite zurückzusetzen.

- Nach Eingabe ihrer E-Mail sollte ein Link zum Zurücksetzen des Passworts versendet werden.

Test Case ID: TC_PW_RESET_001

Titel: Überprüfung der Passwort-Zurücksetzungsfunktion

Beschreibung: Dieser Testfall prüft, ob das Zurücksetzen des Passworts über die Funktion "Passwort vergessen?" mit einer gültigen E-Mail-Adresse funktioniert.

Voraussetzungen:

- Der Benutzer hat bereits ein Konto mit einer verifizierten E-Mail-Adresse.

- Der Mailserver ist betriebsbereit.

Testdaten:

- E-Mail-Adresse: [email protected]

- Neues Passwort: NeuesSicheresPasswort123!

Test Schritte:

- Gehe zur Login-Seite der Anwendung.

- Klicke auf den Link "Passwort vergessen?".

- Gib die E-Mail-Adresse [email protected] in das dafür vorgesehene Feld ein.

- Bestätige die Eingabe und sende die Anfrage ab.

- Überprüfe den Eingang der E-Mail zur Passwortrücksetzung.

- Klicke auf den Link im E-Mail zur Passwortrücksetzung.

- Gib das neue Passwort NeuesSicheresPasswort123! ein und bestätige es.

Erwartetes Ergebnis:

- Der Benutzer erhält innerhalb von 5 Minuten eine E-Mail zur Passwortrücksetzung.

- Der Link in der E-Mail führt zu einer Seite, auf der ein neues Passwort festgelegt werden kann.

- Nach Festlegung eines neuen Passworts wird der Benutzer auf die Login-Seite umgeleitet und kann sich mit dem neuen Passwort anmelden.

Post-Bedingungen:

- Das alte Passwort ist ungültig.

- Der Benutzer kann sich mit dem neuen Passwort einloggen.

Priorität: Hoch

Automatisierbar: Ja

Tester: Maria Musterfrau

Geplantes Testdatum: 21.11.2023

Tatsächliches Ergebnis: (wird nach der Testausführung ausgefüllt)

Status: (Offen/Geschlossen/In Bearbeitung - wird nach der Testausführung ausgefüllt)

Bemerkungen: (Hinzufügen von Anmerkungen oder Besonderheiten, die während des Tests aufgefallen sind)

Angehängte Dokumente: (Screenshots, Log-Dateien etc.)

Diese strukturierte Vorgehensweise sorgt dafür, dass die Testfälle gründlich geplant, durchgeführt und dokumentiert werden, was die Qualität der Software erheblich verbessern kann.

Wie man das automatisieren könnte?

Die Automatisierung von Testfällen kann mit Hilfe verschiedener Werkzeuge und Frameworks erfolgen, die sich auf automatisiertes Testen spezialisieren. Hier ist ein Überblick darüber, wie man den oben genannten Testfall für die Passwort-Zurücksetzung automatisieren könnte, unter Verwendung eines automatisierten Test-Frameworks wie Selenium für Webanwendungen:

Schritt 1: Wähle ein Testautomatisierungs-Framework

Selenium WebDriver ist eine beliebte Wahl für Webanwendungen. Es ermöglicht euch, in verschiedenen Programmiersprachen wie Java, C#, Python etc. zu programmieren.

Schritt 2: Einrichten der Testumgebung

- Selenium installieren: Installiert Selenium-Bibliotheken für die gewählte Programmiersprache.

- Browser-Treiber installieren: Ladet die entsprechenden Browser-Treiber herunter (z.B. ChromeDriver für Google Chrome).

- Test Runner wählen: Wählt ein Unit-Testing-Framework wie JUnit oder TestNG für Java oder pytest für Python.

Schritt 3: Erstelt ein Test-Skript

Unten ist ein einfaches Beispiel, wie ein Testskript in Python mit Selenium aussehen könnte:

from selenium import webdriver

import unittest

import time

class PasswordResetTest(unittest.TestCase):

def setUp(self):

# Initialisieren des WebDrivers

self.driver = webdriver.Chrome('/path/to/chromedriver')

self.driver.get("http://www.example.com/login")

def test_password_reset(self):

driver = self.driver

# Klicken auf "Passwort vergessen?"

driver.find_element_by_link_text("Passwort vergessen?").click()

# E-Mail-Adresse eingeben und Formular absenden

driver.find_element_by_id("email").send_keys("[email protected]")

driver.find_element_by_id("submit").click()

# Warten, um E-Mail-Überprüfung zu simulieren

time.sleep(5)

# Normalerweise würde hier der E-Mail-Zugang simuliert,

# um den Link zur Passwortrücksetzung zu überprüfen.

# Das neue Passwort setzen - diese URL würde von der echten E-Mail kommen

driver.get("http://www.example.com/reset-password/XYZ123")

driver.find_element_by_id("new_password").send_keys("NeuesSicheresPasswort123!")

driver.find_element_by_id("confirm_password").send_keys("NeuesSicheresPasswort123!")

driver.find_element_by_id("submit").click()

# Überprüfen, ob nach dem Zurücksetzen das Login möglich ist

assert "Login" in driver.title

def tearDown(self):

# Schließen des Browsers am Ende des Tests

self.driver.close()

if __name__ == "__main__":

unittest.main()

Schritt 4: Konfiguriert eure Testumgebung

Stellt sicher, dass alle benötigten Dienste laufen (z.B. E-Mail-Server, Anwendungsserver) und dass ihr Zugriff auf erforderliche Ressourcen wie Test-E-Mail-Konten habt.

Schritt 5: Testausführung und -überwachung

Führt die Tests aus und überwacht die Ergebnisse. Tools wie Jenkins oder GitLab CI/CD können verwendet werden, um Testskripte in einer CI/CD-Pipeline automatisch auszuführen.

Schritt 6: Fehlerbehebung und Wartung

Wenn Fehler auftreten, überprüft die Testskripte und passt sie an Änderungen der Webanwendung an.

Anmerkungen zur E-Mail-Verifikation

Das Automatisieren des Schritts zur E-Mail-Verifikation kann kompliziert sein, da es den Zugriff auf ein E-Mail-System erfordert. Hier könnt ihr:

- E-Mail-APIs verwenden, wie z.B. Gmail API, um das E-Mail-Konto zu überprüfen und den Link zur Passwortrücksetzung abzurufen.

- Dummy-E-Mail-Dienste verwenden, die für Testzwecke erstellt wurden, z.B. Mailinator, um eine öffentliche E-Mail-Inbox zu verwenden.

- Stubbing/Mocking verwenden, um die E-Mail-Sendefunktion zu simulieren, wenn ihr Zugriff auf den Code habt.

Die genauen Schritte hängen von den Spezifikationen der zu testenden Anwendung, den verwendeten Technologien und der Infrastruktur ab. Testautomatisierung ist ein fortlaufender Prozess und erfordert regelmäßige Pflege, um mit den Änderungen an der Anwendung Schritt zu halten.

Read the full article

#Automation#Manuell#Sandboxtesting.Sandbox.Testautomation#Spezifikationsdokument#Testautomation#Testfall

0 notes

Text

Kosten senken durch Abhärtung von automatisierten Testfällen ?

Bekanntlich ein sehr großes Problem, die Wartung von Testfällen gerade in der Testautomatisierung kostet Zeit, obwohl meistens die Änderung relativ klein ist. Vielfach liegt es daran das in den Testfällen harte Codierungen von Werten vorliegen, das verursacht dann zeitnah einen Ausfall solch eines Testfalls.

Und in den meisten Fällen müssen dann immer diese Testfälle bearbeitet werden, obwohl sich eventuell nur ein Pixel geändert hat. Das ist aber ein vollkommen falscher Ansatz, Ziel muss immer die Abhärtung eines Testfalls sein, nicht die elend lange Bearbeitung von Testfällen, was nachhaltig mehr Kosten verursacht als euch und euren Vorgesetzten, bzw. eurem Team lieb ist.

https://www.dev-crowd.com/2022/08/09/wie-mache-ich-automatisierte-testfaelle-effizienter/

Schon 2022 hatte (siehe oberhalb) ich mir dazu Gedanken gemacht, wie man automatisierte Testfälle effektiver machen könnte. Betrachtet man das zusätzlich mit der Möglichkeit eines Einsatzes einer KI (wäre effektiv darüber nachzudenken) so ergibt sich ein neuer Ansatz, über den ich hier mal berichten möchte.

Warum spare ich Kosten?

- Weniger False-Positive Ergebnisse: Stabilisierte Tests führen zu weniger Fehlalarmen. Falsch-positive Ergebnisse können Teams dazu veranlassen, unnötig Zeit in die Untersuchung von Problemen zu investieren, die tatsächlich nicht existieren.

- Zeitersparnis: Wenn Testfälle stabil sind und weniger oft fehlschlagen, verbringen Entwickler und QA-Teams weniger Zeit damit, die Ursachen von Testfehlern zu untersuchen.

- Höhere Zuverlässigkeit: Stabile Tests erhöhen das Vertrauen in die Testergebnisse. Dies kann dazu führen, dass Software schneller freigegeben wird, da weniger Zeit für manuelle Überprüfungen aufgewendet wird.

- Weniger Wartungsaufwand: Stabile automatisierte Testfälle benötigen weniger häufige Überarbeitungen. Das reduziert die Gesamtkosten für die Wartung des Testframeworks.

- Bessere Nutzung von Ressourcen: Durch die Reduzierung von Fehlalarmen und den damit verbundenen manuellen Überprüfungen können Ressourcen (z. B. Testumgebungen, Hardware) effizienter genutzt werden.

- Frühe Fehlererkennung: Gut abgegrenzte automatisierte Tests können Fehler früh im Entwicklungszyklus aufdecken, was oft kostengünstiger ist als das Beheben von Fehlern in späteren Phasen oder nach der Produktfreigabe.

- Konsistente Testausführung: Automatisierte Tests werden jedes Mal in der gleichen Weise ausgeführt, was eine größere Konsistenz im Vergleich zu manuellen Tests gewährleistet.

- Skalierbarkeit: Ihr könnt mehr Tests in kürzerer Zeit ausführen, insbesondere wenn ihr in der Lage seid, Tests parallel oder in verteilten Umgebungen auszuführen.

- Dokumentation: Automatisierte Testfälle können als eine Art von Dokumentation für das Verhalten des Systems dienen. Sie zeigen klar, was von der Software erwartet wird.

- Rückmeldung in Echtzeit: Bei der Integration von Testautomatisierung in eine CI/CD-Pipeline können Entwickler sofortiges Feedback über den Status ihres Codes erhalten.

- Höhere Testabdeckung: Automatisierte Tests können eine höhere Codeabdeckung erreichen, besonders wenn sie regelmäßig und umfassend eingesetzt werden.

- Häufigere Releases: Mit stabilen Tests können Organisationen sicherer und häufiger Software-Releases durchführen.

- Verbesserung der Teammoral: Wenn QA-Teams weniger Zeit mit wiederholtem manuellen Testen und der Untersuchung von Fehlalarmen verbringen, könnt ihr euch auf komplexere und wertvollere Aufgaben konzentrieren.

- Reduzierung menschlicher Fehler: Während des manuellen Testens können menschliche Fehler auftreten, etwa durch Übersehen oder inkonsistente Testausführung. Automatisierte Tests reduzieren dieses Risiko.

- Erhöhte Marktreife: Die Fähigkeit, Software schneller und mit höherer Qualität zu testen und zu releasen, kann den Markteintritt beschleunigen.

- Regressionsüberprüfung: Automatisierte Tests erleichtern die Durchführung von Regressionstests, um sicherzustellen, dass neue Änderungen keine vorhandenen Funktionen beeinträchtigen.

Wie setze ich das um?

- Gute Testdesign-Praktiken: Dies beinhaltet die Verwendung von Page-Object-Modellen, geeignete Testdatenverwaltung und das Isolieren von Tests voneinander.

- Wartezeiten und Synchronisierung: Bei UI-Tests sollten dynamische Wartezeiten verwendet werden, um sicherzustellen, dass Elemente geladen sind, bevor Aktionen ausgeführt werden.

- Umgang mit flüchtigen Tests: Tests, die intermittierend fehlschlagen, sollten identifiziert und behoben oder vorübergehend deaktiviert werden.

- Regelmäßige Überprüfung und Aktualisierung: Tests sollten regelmäßig überprüft werden, um sicherzustellen, dass sie noch relevant sind und korrekt funktionieren.

- Granularität der Tests: Schreibt kleine, zielgerichtete Tests, die nur eine bestimmte Funktionalität oder ein bestimmtes Feature testen. Dadurch wird die Fehlersuche erleichtert, da fehlschlagende Tests schnell auf eine spezifische Ursache hindeuten.

- Idempotenz: Stellt sicher, dass Tests idempotent sind, d.h., sie können mehrmals unter denselben Bedingungen ausgeführt werden und liefern jedes Mal dasselbe Ergebnis.

- Testumgebungen: Verwendet dedizierte Testumgebungen, die dem Produktionsumfeld so ähnlich wie möglich sind, um sicherzustellen, dass Tests in einer konsistenten und kontrollierten Umgebung laufen.

- Logging und Berichterstattung: Ein gutes Logging und Berichtssystem kann dabei helfen, Probleme schneller zu diagnostizieren. Insbesondere bei Fehlschlägen sollte detaillierte Information verfügbar sein.

- Code-Review für Tests: Genau wie Produktionscode sollten auch Testcodes regelmäßig überprüft werden. Dies stellt sicher, dass die Tests den Best Practices folgen und effektiv sind.

- Priorisierung von Tests: Nicht alle Tests sind gleich wichtig. Bestimmt, welche Tests kritisch sind und welche weniger kritisch sind. Dies hilft bei der Entscheidungsfindung, wenn ihr beispielsweise eine schnelle Regressionstest-Suite ausführen müsst.

- Cross-Browser- und Cross-Plattform-Tests: Wenn ihr Webanwendungen testet, stellt sicher, dass Ihre Tests in verschiedenen Browsern und Plattformen funktionieren. Tools wie Selenium Grid oder Dienste wie BrowserStack und Sauce Labs können dabei helfen.

- Datengetriebene Tests: Anstatt für jede Datenkombination einen separaten Test zu schreiben, könnt ihr einen Test schreiben, der durch eine Reihe von Datenpunkten geführt wird. Frameworks wie pytest bieten Unterstützung für datengetriebene Tests.

- Fehlerbehandlung: Berücksichtigt wie euer Testframework mit unerwarteten Fehlern, wie z.B. Timeouts, Abstürzen oder externen Abhängigkeiten, umgeht. Implementiert geeignete Fehlerbehandlungen, um solche Situationen zu adressieren.

- Integration mit CI/CD: Integriert eure Tests in Ihre Continuous Integration/Continuous Deployment-Pipeline, um sicherzustellen, dass Tests automatisch bei jedem Code-Check-in oder -Release ausgeführt werden.

- Monitoring und Alarmierung: Stellt sicher, dass ihr benachrichtigt werdet, wenn Tests fehlschlagen, insbesondere in CI/CD-Pipelines oder bei nächtlichen Testläufen.

- Testabdeckung: VerwendetTools zur Messung der Codeabdeckung, um sicherzustellen, dass Ihr Code angemessen durch Tests abgedeckt ist.

- Isolation von externen Diensten: Wenn euer Code externe Dienste oder APIs verwendet, sollten ihr diese Dienste während des Tests durch Mocks oder Stubs ersetzen, um sicherzustellen, dass eure Tests nicht von externen Faktoren beeinflusst werden.

- Modularisierung von Testcodes: Vermeidet redundante Codes, indem ihr gemeinsame Vorgehensweisen und Funktionen in wiederverwendbare Module oder Hilfsfunktionen auslagert.

- State Management: Stellt sicher, dass ihr den Zustand vor und nach Tests zurücksetzt, um Seiteneffekte zu vermeiden und die Unabhängigkeit der Tests zu gewährleisten.

- Testen von Rand- und Ausnahmefällen: Neben den Standard-Testfällen sollten ihr auch Rand- und Ausnahmefälle in Betracht ziehen, um die Robustheit eures Codes zu überprüfen.

- Performance- und Lasttests: Neben funktionalen Tests solltet ihr auch die Leistung und Skalierbarkeit eurer Anwendung unter verschiedenen Lastbedingungen testen.

- Testen von Sicherheitsaspekten: Führt Sicherheitstests durch, um potenzielle Schwachstellen oder Sicherheitslücken in eurer Anwendung zu identifizieren.

- Visual Testing: Für UI-basierte Anwendungen kann das visuelle Testen sicherstellen, dass die Benutzeroberfläche wie erwartet erscheint, insbesondere nach Änderungen oder Updates.

- Verwaltung von Testkonfigurationen: Stellt sicher, dass ihr leicht zwischen verschiedenen Testkonfigurationen (z.B. verschiedene Umgebungen, Datenbanken oder Endpunkte) wechseln könnt.

- Feedback-Schleifen: Nutzt das Feedback aus den Tests, um den Entwicklungsprozess kontinuierlich zu verbessern.

- Schulung und Wissenstransfer: Stellt sicher, dass das Team regelmäßig geschult wird und Best Practices in Bezug auf Testautomatisierung und zugehörige Werkzeuge kennt.

- Testtreiber und Teststubs: In einem TDD (Test Driven Development) Ansatz können Testtreiber (um fehlende Teile zu simulieren) und Teststubs (um komplexe Teile zu vereinfachen) verwendet werden, um den Testprozess zu erleichtern.

- Code- und Testmetriken: Verwendet Metriken, um den Zustand euer Tests und eures Codes im Laufe der Zeit zu überwachen.

Wie härte ich Selenium und Python basierte Testfälle ab?

Wartet auf Elemente:

- Verwendet explizite Wartezeiten, um auf das Erscheinen von Elementen zu warten, anstatt feste Zeitverzögerungen zu verwenden.

- Nutzt Wartebedingungen wie WebDriverWait in Kombination mit erwarteten Bedingungen (ExpectedConditions), um auf das gewünschte Element zu warten, bevor ihr damit interagieren.

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

# Beispiel für das Warten auf ein Element mit WebDriverWait

element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "element_id"))

)

Fehlerbehandlung:

- Implementiert robuste Fehlerbehandlungen, um auf unerwartete Ausnahmen vorbereitet zu sein.

- Verwendet try-except-Blöcke, um Ausnahmen abzufangen und entsprechend zu reagieren.

try:

# Führen Sie hier Ihre Aktionen aus

except NoSuchElementException:

# Handle den Fall, wenn das Element nicht gefunden wird

except TimeoutException:

# Handle den Fall, wenn ein Timeout auftritt

Loggt eure Informationen:

- Fügt Protokollausgaben hinzu, um den Testverlauf und Fehlermeldungen besser nachverfolgen zu können.

- Verwendet Python-Logging oder andere geeignete Protokollierungsmechanismen.

import logging

# Konfigurieren Sie das Logging

logging.basicConfig(level=logging.INFO)

logger = logging.getLogger(__name__)

# Protokollieren von Informationen

logger.info("Aktion erfolgreich ausgeführt")

logger.error("Ein Fehler ist aufgetreten")

Verwendet den Headless-Modus:

- Führt Tests im Headless-Modus aus, um die Leistung zu verbessern und die Stabilität zu erhöhen, insbesondere auf Servern ohne grafische Benutzeroberfläche.

from selenium.webdriver.chrome.options import Options

options = Options()

options.headless = True

driver = webdriver.Chrome(options=options)

Testdatenmanagement:

- Trennt die Testdaten von Testfällen, um die Wartbarkeit zu verbessern.

- Verwendet externe Dateien oder Datenbanken, um Testdaten zu speichern und auf sie zuzugreifen

Parallelisierung:

- Nutzt Tools wie Selenium Grid oder Cloud-basierte Testplattformen, um Tests parallel auf verschiedenen Browsern und Plattformen auszuführen, was die Ausführung beschleunigen und die Ausfallsicherheit erhöhen kann.

Überwachung und Berichterstattung:

- Überwacht eure Testausführungen und erstellt detaillierte Berichte über den Status und die Ergebnisse Ieurer Tests.

- Verwendet Test-Frameworks und Berichterstattungswerkzeuge wie PyTest und Allure Report.

Read the full article

0 notes

Text

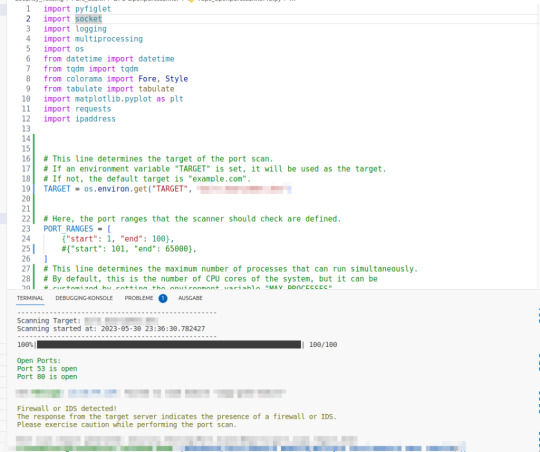

Last- & Performance-Testing für einen Chatbot

Grundsätzlich verhält sich ein Last- und Performancetest eines Chatbots nicht anders als eben andere Last- und Performancetest auch. Für einen einfachen weg habe ich ein Python Skript geschrieben, welches auf einfacher weise einen gezielten Test auf ein Chatbot System durcführt. Aktuell wird hier nur eine GET-Anfrage ausgeführt, aber weiter unterhalb findet ihr auch eine geupdatete Version, das neben dem GET-Befehl auch den POST-Befehl ausführt. Anpassungen sind in Arbeit und ich würde mich freuen, wenn ihr dazu Vorschläge habt.

Wie nutzte ich das Skript?

Konfiguration:

- Ändert die url Variable, um die URL eures Chatbots anzugeben.

- Passt die num_users Variable an, um die Anzahl der simulierten Benutzer festzulegen.

- Passt die num_threads Variable an, um die Anzahl der Threads festzulegen (obwohl diese Variable im aktuellen Skript nicht verwendet wird).

- Passt die http_method Variable an, um die HTTP-Methode festzulegen (obwohl das Skript derzeit nur GET-Anfragen unterstützt).

- Passt die think_time Variable an, um die Denkzeit zwischen den Anfragen festzulegen.

Ausführung:

- Führt das Skript aus. Es wird die angegebene Anzahl von Benutzern simulieren, die Anfragen an den Chatbot senden.

- Die Fortschrittsleiste zeigt den Fortschritt des Tests an.

- Nach Abschluss des Tests werden statistische Daten wie Durchschnitt, Median, Varianz, Standardabweichung und die 95. und 99. Perzentile der Antwortzeiten angezeigt.

- Ein Histogramm der Antwortzeiten wird ebenfalls angezeigt.

Analyse:

- Überprüft die statistischen Daten, um zu verstehen, wie euer Chatbot unter Last reagiert.

- Das Histogramm gibt euch eine visuelle Vorstellung von der Verteilung der Antwortzeiten.

Fehlerbehandlung:

- Das Skript protokolliert Fehler in einer Datei namens logfile.log im Verzeichnis Load_and_Performance_Tooling/Logging/. Überprüft diese Datei, wenn während des Tests Fehler auftreten.

import aiohttp

import asyncio

import time

import statistics

import logging

import numpy as np

import matplotlib.pyplot as plt

from datetime import datetime

from tqdm import tqdm

# Author: Frank Rentmeister

# URL: https:meinchatbot.com

# Date: 2023-08-23

# Version: 2.0

# Description: Load and Performance Tooling (Asynchronous with Progressbar)

# Set the log level to DEBUG to log all messages

LOG_FORMAT = '%(asctime)s - %(name)s - %(levelname)s - %(message)s - %(threadName)s - %(thread)d - %(lineno)d - %(funcName)s'

logging.basicConfig(level=logging.DEBUG, format=LOG_FORMAT, filename='Load_and_Performance_Tooling/Logging/logfile.log', filemode='w')

logger = logging.getLogger()

# Configuration Parameters

url = "https://meinchatbot.com"

num_users = 200

num_threads = 10

http_method = "GET"

think_time = 2

# Define a function to calculate statistical data

def calculate_statistics(response_times):

mean_response_time = statistics.mean(response_times)

median_response_time = statistics.median(response_times)

variance_response_time = statistics.variance(response_times)

stddev_response_time = statistics.stdev(response_times)

percentile_95 = np.percentile(response_times, 95)

percentile_99 = np.percentile(response_times, 99)

return {

'mean': mean_response_time,

'median': median_response_time,

'variance': variance_response_time,

'stddev': stddev_response_time,

'95_percentile': percentile_95,

'99_percentile': percentile_99

}

# Define a function to simulate a user making a request

async def simulate_user_request(session, response_times, pbar):

try:

start_timestamp = datetime.now()

async with session.get(url) as response: # Assume only GET requests for simplicity

response_time = datetime.now() - start_timestamp

response.raise_for_status()

response_times.append(response_time.total_seconds())

pbar.update(1) # Update the progress bar

await asyncio.sleep(think_time) # Implementing the think time

except Exception as e:

logger.error(f"An unexpected error occurred: {e}")

pbar.update(1) # Update the progress bar even if there's an error

# Define a function to run the load test asynchronously

async def run_load_test():

start_timestamp = datetime.now()

response_times =

with tqdm(total=num_users, desc="Progress", position=0, bar_format="{l_bar}{bar:20}{r_bar}{bar:-10b}", colour="green") as pbar:

async with aiohttp.ClientSession() as session:

tasks =

await asyncio.gather(*tasks)

num_successful_requests = len(response_times)

num_failed_requests = num_users - num_successful_requests

print(f"Number of successful requests: {num_successful_requests}")

print(f"Number of failed requests: {num_failed_requests}")

stats = calculate_statistics(response_times)

print(f"Mean Response Time: {stats:.3f} seconds")

print(f"Median Response Time: {stats:.3f} seconds")

print(f"Variance of Response Times: {stats:.3f}")

print(f"Standard Deviation of Response Times: {stats:.3f}")

print(f"95th Percentile of Response Times: {stats:.3f} seconds")

print(f"99th Percentile of Response Times: {stats:.3f} seconds")

# Create a histogram of response times

plt.figure(figsize=(8, 6))

plt.hist(response_times, bins=20, color='skyblue', edgecolor='black')

plt.title('Response Time Distribution')

plt.xlabel('Response Time (seconds)')

plt.ylabel('Frequency')

plt.grid(True)

plt.show()

# Run the load test asynchronously

asyncio.run(run_load_test())

Read the full article

0 notes

Text

Chatbots auf Schwachstellen Testen mit Owasp Zap

Aktuell werden sehr fleißig in vielen Projekten Chatbots implementiert oder gleich eine API-Anbindung an ChatAI genutzt. Aber wie so oft in den letzten 30 Jahren kommt meistens der Test viel zu kurz, und eben auch der Test auf Schwachstellen. Versuchen wir heute mal eine Möglichkeit mit OWASP Zap aufzuzeigen.

Es gibt gerade beim Test von Chatbots muss man einiges beachten:

-

Interaktionstyp: Bei Chatbots handelt es sich um interaktive Systeme, die auf Benutzereingaben reagieren. Im Gegensatz zu herkömmlicher Software, bei der Tests häufig auf festen Eingabe-Ausgabe-Mustern basieren, müssen Chatbot-Tests eine Vielzahl von Benutzereingaben und -interaktionen berücksichtigen.

-

Unvorhersehbarkeit der Eingabe: Benutzer können Fragen auf viele verschiedene Arten stellen. Daher muss ein Chatbot-Test verschiedene Formulierungen, Synonyme und Dialekte berücksichtigen.

-

Kontextabhängigkeit: Chatbots müssen den Kontext einer Konversation verstehen und darauf reagieren können. Das Testen dieser Fähigkeit erfordert spezielle Szenarien und Testfälle.

-

NLP (Natural Language Processing): Chatbots verwenden oft NLP-Techniken, um Benutzereingaben zu verstehen. Das Testen der Effizienz und Genauigkeit dieser Techniken ist entscheidend.

-

Intent-Erkennung: Es ist wichtig zu testen, wie gut der Chatbot die Absicht des Benutzers erkennt und darauf reagiert.

-

Konversationsfluss: Im Gegensatz zu herkömmlicher Software, bei der der Datenfluss oft linear ist, können Chatbot-Konversationen in viele Richtungen gehen. Das Testen des Konversationsflusses und der Übergänge zwischen verschiedenen Themen ist daher wichtig.

-

Emotionale Intelligenz: Einige fortschrittliche Chatbots können die Emotionen des Benutzers erkennen und darauf reagieren. Das Testen dieser Fähigkeit kann für solche Bots relevant sein.

-

Integrationstests: Chatbots können in verschiedene Plattformen und Systeme integriert werden (z.B. Websites, Messaging-Apps, CRM-Systeme). Das Testen dieser Integrationen ist entscheidend.

-

Performance-Tests: Wie bei jeder Software ist es wichtig zu testen, wie der Chatbot unter Last reagiert, insbesondere wenn viele Benutzer gleichzeitig interagieren.

-

Sicherheitstests: Da Benutzer oft persönliche Informationen in Chatbots eingeben, ist es wichtig, die Sicherheit und den Datenschutz des Bots zu testen.

https://www.youtube.com/watch?v=mXh6hVKK84s&pp=ygUPdGVzdGluZyBjaGF0Ym90

Wichtig anzumerken ihr benötigt eine Installation von OWASP ZAP eine IDE wie Visual Studio Code und Python!

Injection-Angriffe

Bei Injection-Angriffen wird versucht, schädlichen Code oder Befehle in eine Anfrage einzufügen, die dann vom System interpretiert und ausgeführt wird. SQL-Injection ist eine der bekanntesten Formen von Injection-Angriffen, bei denen ein Angreifer SQL-Befehle in eine Anfrage einfügt, die dann von der Datenbank ausgeführt werden.

In dem gegebenen Beispiel für Injection-Angriffe wird ein Payload verwendet, der versucht, eine SQL-Injection durchzuführen, indem er einen Befehl einschließt, der eine Tabelle löscht (DROP TABLE users). Die Idee ist, zu testen, ob der Chatbot die Benutzereingabe richtig bereinigt und solche Angriffe verhindert.

Die folgende Python-Codeblock startet einen Scan mit OWASP ZAP, um einen Injection-Angriff auf einen spezifischen Endpunkt zu testen, und zeigt eine Fortschrittsleiste, um den Fortschritt des Scans anzuzeigen.

from zapv2 import ZAPv2

from tqdm import tqdm

import time

zap = ZAPv2(proxies={'http': 'http://127.0.0.1:8080', 'https': 'http://127.0.0.1:8080'})

# Ziel-URL

target_url = 'https://example.com/chatbot/api'

# Spider starten

zap.spider.scan(target_url)

# Angriffsanfrage

injection_payload = {"userInput": "'; DROP TABLE users; --"}

# Aktiven Scan mit Injection-Angriff starten

scan_id = zap.ascan.scan(target_url, postdata=str(injection_payload))

# Fortschrittsanzeige

for progress in tqdm(range(0, 100), desc="Scanning for Injection vulnerabilities"):

while int(zap.ascan.status(scan_id)) < progress:

time.sleep(1)

Bitte beachtet , dass das obige Beispiel auf der Annahme basiert, dass die Benutzereingabe als JSON im Request-Body gesendet wird. Die genaue Implementierung kann je nach den spezifischen Details eures Chatbots variieren.

Unsichere API-Endpunkte

Unsichere API-Endpunkte sind solche, die nicht ordnungsgemäß gesichert sind und möglicherweise für unautorisierte Zugriffe anfällig sind. Ein Angreifer könnte versuchen, solche Endpunkte zu nutzen, um auf sensible Informationen zuzugreifen oder unautorisierte Aktionen durchzuführen.

Hier ist ein Beispiel für ein Skript, das OWASP ZAP und die tqdm-Bibliothek verwendet, um einen Sicherheitsscan auf einem spezifischen API-Endpunkt durchzuführen, und eine Fortschrittsleiste anzeigt, um den Fortschritt des Scans zu verfolgen:

from zapv2 import ZAPv2

from tqdm import tqdm

import time

zap = ZAPv2(proxies={'http': 'http://127.0.0.1:8080', 'https': 'http://127.0.0.1:8080'})

# Ziel-URL, das den unsicheren API-Endpunkt repräsentiert

target_url = 'https://example.com/chatbot/api/secureEndpoint'

# Spider starten, um die Anwendung zu erforschen

zap.spider.scan(target_url)

# Aktiven Scan starten, um den Endpunkt auf bekannte Schwachstellen zu prüfen

scan_id = zap.ascan.scan(target_url)

# Fortschrittsanzeige

for progress in tqdm(range(0, 100), desc="Scanning for insecure API endpoints"):

while int(zap.ascan.status(scan_id)) < progress:

time.sleep(1)

Dieser Code startet einen aktiven Scan auf den angegebenen Endpunkt und verfolgt den Fortschritt mit einer Fortschrittsleiste. Der Scan könnte Schwachstellen wie fehlende oder schwache Authentifizierung, unsachgemäße Berechtigungsprüfungen und andere Sicherheitslücken in der API offenlegen.

Die Ergebnisse des Scans könnten dann analysiert werden, um spezifische Schwachstellen zu identifizieren und Empfehlungen für deren Behebung zu geben.

Cross-Site-Scripting (XSS)

Cross-Site-Scripting (XSS) ist eine Art von Sicherheitslücke, bei der ein Angreifer in der Lage ist, schädlichen Code in eine Webanwendung einzuschleusen, der dann im Browser eines Opfers ausgeführt wird. Wenn ein Chatbot in einer Webanwendung eingebettet ist und die Benutzereingabe nicht ordnungsgemäß bereinigt, könnte er anfällig für XSS-Angriffe sein.

Hier ist ein Beispiel für ein Skript, das OWASP ZAP verwendet, um einen XSS-Angriff auf einen bestimmten Endpunkt zu testen, und eine Fortschrittsleiste anzeigt, um den Fortschritt des Scans zu verfolgen:

from zapv2 import ZAPv2

from tqdm import tqdm

import time

zap = ZAPv2(proxies={'http': 'http://127.0.0.1:8080', 'https': 'http://127.0.0.1:8080'})

# Ziel-URL

target_url = 'https://example.com/chatbot/api'

# Spider starten

zap.spider.scan(target_url)

# XSS-Angriffsanfrage

xss_payload = {"userInput": ""}

# Aktiven Scan mit XSS-Angriff starten

scan_id = zap.ascan.scan(target_url, postdata=str(xss_payload))

# Fortschrittsanzeige

for progress in tqdm(range(0, 100), desc="Scanning for Cross-Site Scripting vulnerabilities"):

while int(zap.ascan.status(scan_id)) < progress:

time.sleep(1)

Dieser Code testet, ob der angegebene Endpunkt anfällig für XSS ist, indem er versucht, schädlichen JavaScript-Code in die Benutzereingabe einzufügen. Der Fortschritt des Scans wird in einer Fortschrittsleiste angezeigt.

Wenn der Scan eine XSS-Schwachstelle findet, sollten Sie die Ergebnisse analysieren und die notwendigen Korrekturen vornehmen, um die Benutzereingabe ordnungsgemäß zu bereinigen und zu validieren, damit solche Angriffe verhindert werden.

Data Leakage

Data Leakage bezieht sich auf das ungewollte Austreten von sensiblen Informationen aus einer Anwendung, was ein ernsthaftes Sicherheitsproblem darstellen kann. Ein Data-Leakage-Test versucht, Schwachstellen in der Anwendung zu identifizieren, die es ermöglichen könnten, auf vertrauliche Informationen zuzugreifen.

Im Kontext eines Chatbots könnte dies bedeuten, dass der Bot versehentlich vertrauliche Informationen wie Benutzerdaten, Kreditkarteninformationen oder interne Systemdetails preisgibt.

Das folgende Python-Skript verwendet OWASP ZAP, um einen spezifischen API-Endpunkt auf mögliche Data Leakage zu überprüfen, und zeigt eine Fortschrittsleiste, um den Fortschritt des Scans zu verfolgen:

from zapv2 import ZAPv2

from tqdm import tqdm

import time

zap = ZAPv2(proxies={'http': 'http://127.0.0.1:8080', 'https': 'http://127.0.0.1:8080'})

# Ziel-URL, die den Endpunkt repräsentiert

target_url = 'https://example.com/chatbot/api'

# Spider starten, um die Anwendung zu erkunden

zap.spider.scan(target_url)

# Aktiven Scan starten, um den Endpunkt auf bekannte Schwachstellen zu prüfen

scan_id = zap.ascan.scan(target_url)

# Fortschrittsanzeige

for progress in tqdm(range(0, 100), desc="Scanning for Data Leakage vulnerabilities"):

while int(zap.ascan.status(scan_id)) < progress:

time.sleep(1)

Wenn der Scan abgeschlossen ist, solltet ihr die Ergebnisse überprüfen, um festzustellen, ob es Anzeichen für das Austreten von sensiblen Daten gibt. Es kann nützlich sein, die Anfragen und Antworten genau zu überprüfen und zu verstehen, wie die Daten innerhalb der Anwendung behandelt werden. Eventuell notwendige Sicherheitsverbesserungen könnten Dinge wie die Verstärkung der Authentifizierung, die Anwendung von Verschlüsselung und die ordnungsgemäße Maskierung von sensiblen Daten umfassen.

Authentifizierungs- und Autorisierungstests

Authentifizierungs- und Autorisierungstests sind entscheidend, um sicherzustellen, dass nur berechtigte Benutzer Zugang zu bestimmten Ressourcen oder Funktionen haben. Authentifizierung bezieht sich auf den Prozess, die Identität eines Benutzers zu verifizieren, während Autorisierung sicherstellt, dass ein authentifizierter Benutzer nur auf die Ressourcen zugreifen kann, die ihm zugewiesen sind.

Mit OWASP ZAP könnt diese Tests durchführen. Hier ist ein Beispiel:

from zapv2 import ZAPv2

from tqdm import tqdm

import time

# ZAP-Proxy-Verbindung

zap = ZAPv2(proxies={'http': 'http://127.0.0.1:8080', 'https': 'http://127.0.0.1:8080'})

# Ziel-URL

target_url = 'https://example.com/'

# Spider starten, um die Anwendung zu erkunden

zap.spider.scan(target_url)

# Authentifizierungskonfiguration (abhängig von der Authentifizierungsmethode)

# Zum Beispiel für Formularbasierte Authentifizierung

zap.authentication.set_authentication_method(

contextid='1',

authmethodname='formBasedAuthentication',

authmethodconfigparams='loginUrl=https://example.com/login&loginRequestData=usernameusernamepasswordpassword')

# Benutzer hinzufügen

zap.users.new_user(contextid='1', name='testuser')

zap.users.set_authentication_credentials(contextid='1', userid='0', authcredentialsconfigparams='username=testuser&password=secret')

# Aktiven Scan starten

scan_id = zap.ascan.scan(target_url)

# Fortschrittsanzeige

for progress in tqdm(range(0, 100), desc="Authentication and Authorization Testing"):

while int(zap.ascan.status(scan_id)) < progress:

time.sleep(1)

Security Misconfigurations

Sicherheitskonfigurationsfehler entstehen durch unsachgemäße Konfiguration von Servern, Datenbanken oder Anwendungen. Diese könnten dazu führen, dass sensible Informationen öffentlich zugänglich sind oder unerwünschte Aktionen ermöglichen.

Sicherheitskonfigurationsfehler sind eine häufige Schwachstelle in vielen Webanwendungen. Hier sind einige Beispiele und Erklärungen für verschiedene Arten von Sicherheitskonfigurationsfehlern:

- Öffentlicher Zugriff auf Verzeichnisse und Dateien: Ein häufiger Fehler besteht darin, dass sensible Dateien oder Verzeichnisse (z. B. Konfigurationsdateien, Log-Dateien, Backup-Dateien) für jeden im Internet zugänglich sind. Das kann es Angreifern ermöglichen, wertvolle Informationen über die Anwendung oder den Server zu sammeln.

- Standard-Passwörter und Standard-Anmeldedaten: Wenn Standard-Passwörter oder Anmeldedaten nicht geändert werden, könnten Angreifer leicht auf Konten zugreifen oder die Anwendung übernehmen. Administratorkonten mit Standard-Anmeldedaten sind ein besonders kritisches Problem.

- Unzureichende Berechtigungen: Fehlerhafte Berechtigungseinstellungen können dazu führen, dass Benutzer auf Funktionen oder Ressourcen zugreifen können, auf die sie keinen Zugriff haben sollten. Das kann zu Datenlecks oder unerwünschten Aktionen führen.

- Serverkonfiguration: Fehlkonfigurationen von Webservern, Datenbanken oder Anwendungsservern könnten Sicherheitslücken verursachen. Dies könnte Angreifern erlauben, Informationen zu sammeln, Schadcode einzuführen oder den Server zu beeinträchtigen.

- Fehlende oder unsichere Transportverschlüsselung: Wenn eine Anwendung keine ausreichende Transportverschlüsselung (z. B. HTTPS) verwendet oder unsichere Verschlüsselungsprotokolle einsetzt, könnten Angreifer den Datenverkehr abhören oder manipulieren.

- Offene Debugging- oder Entwicklungs-Endpunkte: Wenn Entwicklungs- oder Debugging-Endpunkte in der Produktionsumgebung verbleiben, könnten Angreifer möglicherweise sensible Informationen erhalten oder Angriffe durchführen.

Um Sicherheitskonfigurationsfehler zu vermeiden, solltet ihr folgende Maßnahmen ergreifen:

- Verwende sichere Standardeinstellungen für Server und Anwendungen.

- Entferne oder sichere Dateien und Verzeichnisse, die nicht öffentlich zugänglich sein sollten.

- Ändere Standard-Anmeldedaten und verwende starke Passwörter.

- Vergebe Berechtigungen basierend auf dem Prinzip des geringsten Privilegs.

- Aktualisiere regelmäßig Software und Patches, um bekannte Schwachstellen zu beheben.

- Implementiere Transportverschlüsselung für die Kommunikation zwischen Client und Server.

- Schalte Debugging- und Entwicklungs-Endpunkte in der Produktionsumgebung ab.

Ihr könnt dieses Skript nutzen:

from zapv2 import ZAPv2

# Setze die ZAP-Adresse (standardmäßig läuft ZAP auf localhost:8080)

zap_proxy = 'http://localhost:8080'

# Erstelle eine ZAP-Instanz

zap = ZAPv2(proxies={'http': zap_proxy, 'https': zap_proxy})

# Warte, bis ZAP einsatzbereit ist

while not zap.core.is_daemon_running():

time.sleep(2)

# Gib die ZAP-Version aus

print("ZAP Version: {}".format(zap.core.version))

# Setze die Ziel-URL, die du testen möchtest

target_url = 'http://your-chatbot-url-here'

# Starte den Spider, um alle erreichbaren Seiten zu finden

print("Starte Spider...")

scan_id = zap.spider.scan(target_url)

while int(zap.spider.status(scan_id)) < 100:

print("Spider Fortschritt: {}%".format(zap.spider.status(scan_id)))

time.sleep(2)

print("Spider abgeschlossen!")

# Starte den aktiven Scan

print("Starte aktiven Scan...")

scan_id = zap.ascan.scan(target_url)

while int(zap.ascan.status(scan_id)) < 100:

print("Aktiver Scan Fortschritt: {}%".format(zap.ascan.status(scan_id)))

time.sleep(2)

print("Aktiver Scan abgeschlossen!")

# Erhalte und gib die gefundenen Schwachstellen aus

alerts = zap.core.alerts(baseurl=target_url)

print("Gefundene Schwachstellen:")

for alert in alerts: