#sqlstatement

Explore tagged Tumblr posts

Photo

Attend for #freedemo on #msbi plus #sqlserver course on 15th August @8AM. Register for a free demo: http://bit.ly/2KKDgEO #kosmiktechnologies #training #sql #sqldeveloper #sqlstatement #plsqldeveloper #plsql #sqldeveloper #sqlserverdba #sqlserver #traininginstitutesinhyderabad #haryana #Hyderabad #mumbai #Chandanagar #manikonda #haryana #ncr #newdelhi #newyorkcity #usa #usastudents #maharashtra https://www.instagram.com/p/CDtRKVWHqgH/?igshid=slpkd7ptkrzx

#freedemo#msbi#sqlserver#kosmiktechnologies#training#sql#sqldeveloper#sqlstatement#plsqldeveloper#plsql#sqlserverdba#traininginstitutesinhyderabad#haryana#hyderabad#mumbai#chandanagar#manikonda#ncr#newdelhi#newyorkcity#usa#usastudents#maharashtra

0 notes

Photo

Creating and using SQL Views Views are one of the what I consider as wizardry magic touch to the back end developer. SQL views are just virtual tables.Tables that are created just from SQL statements.They don't exist in the database. But they have the power to offer you an extra layer of providing added security by simply allowing the API developer access to the columns (fields) you want them and hide the sensitive ones. In this slides set,I will give you the introductory part of how you create Views in SQL data bases using a practical example. In a later post,we will dive deeper by building an even complex application that will query multiple tables and provide us interesting result sets. So, you had better hang around. And enjoy the reading #sql #sqlstatements #databasedevelooment #sqlviews #creatingsqlviews (at Lilongwe, Malawi) https://www.instagram.com/p/CAGfuw7BQ87/?igshid=1nqynrhva6byq

0 notes

Text

Find top CPU consuming SQL Queries in SQL Server

Find top CPU consuming SQL Queries in SQL Server

Check top CPU consuming in SQL Queries in SQL Server ;WITH eqs AS ( SELECT [execution_count] ,[total_worker_time]/1000 AS [TotalCPUTime_ms] ,[total_elapsed_time]/1000 AS [TotalDuration_ms] ,query_hash ,plan_handle ,[sql_handle] FROM sys.dm_exec_query_stats ) SELECT TOP 10 est.[text], eqp.query_plan AS SQLStatement ,eqs.* FROM eqs OUTER APPLY sys.dm_exec_query_plan(eqs.plan_handle) eqp OUTER…

View On WordPress

0 notes

Text

Raspberry PI Tutorial #8: Daten eines DHT11 Sensors in eine MySQL Datenbank speichern

In diesem Beitrag möchte ich dir zeigen wie du die Daten eines DHT11 Sensors in einer MySQL Datenbank mit Python am Raspberry Pi speichern kannst.

Im Beitrag Python mit MySQL Datenbank verbinden habe ich dir bereits gezeigt wie man eine Verbindung zu einer MySQL Datenbank unter Python aufbauen kannst. Hier soll es nun darum gehen wie du die Daten des DHT11 Sensors in einer Tabelle speichern und abrufen kannst.

benötigte Bauteile für dieses Projekt

Für dieses Projekt benötigst du: - einen Raspberry Pi,- ein USB Stromadapter, (je nach Pi muss die entsprechende Stromstärke beachtet werden) - eine SD Karte (mit vorinstalliertem Raspian OS oder vergleichbar) - ein Netzwerkkabel oder WiFi Adapter - ein 170 Pin Breadboard, - einen DHT11 Sensor, - diverse Breadboardkabel

Schaltung & Aufbau

Den Aufbau der Schaltung habe ich bereits im Beitrag Raspberry PI Tutorial #4: DHT11 Sensor ansteuern (Teil1) erläutert.

Schaltung - Raspberry PI Model B mit DHT11 Sensor Es gibt den DHT11 Sensor als einzelnen Baustein oder aber auch bequem auf einer Platine, somit erspart man sich einen "komplizierten" Aufbau auf einem Breadboard.

Varianten des DHT11 Sensors

MySQL Datenbank vorbereiten

Bevor wir Daten in eine MySQL Datenbank speichern können, müssen wir diese zuvor erstellen und min. eine Tabelle erzeugen. SQL Statements Hier nun die SQL Statements zum - erstellen der Datenbank, - erstellen eines Benutzers für die DB, - zuweisen der Privilegien des Benutzers zur DB, - erstellen der Tabelle, - einfügen von Daten, und - abfragen der Daten erstellen der Datenbank Als erstes benötigen wir eine Datenbank diese erstellen wir mit dem Befehl "CREATE DATABASE". create database sensorTestDb; erstellen eines Benutzers für die DB Damit wir auf der Datenbank arbeiten können, benötigen wir einen Benutzer. Die Benutzer sind in MySQL Global d.h. ein Benutzer kann für mehrere Datenbanken berechtigt werden (dazu im nächsten Abschnitt mehr). INSERT INTO mysql.user (User,Host,authentication_string,ssl_cipher,x509_issuer,x509_subject) VALUES('pydbuser','localhost',PASSWORD('pydbpw'),'','',''); zuweisen der Privilegien des Benutzers zur Datenbank Wenn der Benutzer & die Datenbank angelegt wurde, muss nun der Benutzer für die Datenbank berechtigt werden. In meinem Fall gebe ich dem Benutzer "pydbuser" alle Rechte auf der Datenbank. GRANT ALL PRIVILEGES ON sensorTestDb.* to pydbuser@localhost; Nachdem das obrige Statement ausgeführt wurde, muss nur noch die privilegien geschrieben und dem Server mitgeteilt werden das dieser die Tabellen mit den Rechten neu einließt. FLUSH PRIVILEGES; erstellen der Tabelle Zunächst erstellen wir eine Tabelle mit vier Spalten - ID - ganzahlig, aufsteigend - zeitstempel - DateTime - temperatur - Float - Gleitkommazahl - luftfeuchtigkeit - Float - Gleitkommazahl CREATE TABLE `sensorTestDb`.`sensorvalues` (`ID` INT NOT NULL AUTO_INCREMENT, `zeitstempel` DATETIME NOT NULL, `temperatur` FLOAT NOT NULL, `luftfeuchtigkeit` FLOAT NOT NULL, PRIMARY KEY (`ID`)) ENGINE = InnoDB; einfügen von Daten Das einfügen von Daten in eine SQL Tabelle erfolgt mit dem "INSERT INTO" Befehl. Hier nun ein Beispiel wie der Befehl in unserem Fall aussieht: INSERT INTO `sensorvalues` (`ID`, `zeitstempel`, `temperatur`, `luftfeuchtigkeit`) VALUES (NULL, CURRENT_TIME(), 23.56, 57.6); Wichtig ist dass, die Gleitkommazahlen mit einem Punkt getrennt sind. Sollte als Trenner ein Komma (deutsches Format) gewählt werden, so wird die Nachkommastelle entfernt. abfragen der Daten aus der Tabelle Mit dem SQL Befehl "BETWEEN" können wir Werte aus der Tabelle lesen welche zwischen zwei Datumsbereichen liegen. Dabei ist das Datumsformat YYYY-MM-TT HH:mm:SS. SELECT * FROM `sensorvalues` WHERE zeitstempel between '2021-01-01 00:00:00' and '2021-12-31 23:59:59'

Python-Skript erstellen

Das passende Python-Skript erstelle ich in zwei Schritte - installieren des MySQL Connectors für Python, - aufbauen der Datenbankverbindung, - Abfragen der Sensordaten, - einfügen der Sensordaten in die Tabelle Dieses Python-Skript wird im Anschluss per CronJob Zeitgesteuert am Raspberry Pi gestartet. installieren des MySQL Connectors für Python Bevor wir mit dem Skripten beginnen können, müssen wir den passenden MySQL-Connector installieren. sudo pip install mysql-connector-python Auf meinem betagten Raspberry Pi dauert diese Installation etwas und kommt zwischendurch auch etwas ins Stocken. Hier muss man etwas warten und nicht gleich diverse Tastenkombinationen betätigen. pi@raspberrypi:~/dht11db $ sudo pip install mysql-connector-python Looking in indexes: https://pypi.org/simple, https://www.piwheels.org/simple Collecting mysql-connector-python Downloading https://files.pythonhosted.org/packages/2a/8a/428d6be58fab7106ab1cacfde3076162cd3621ef7fc6871da54da15d857d/my sql_connector_python-8.0.25-py2.py3-none-any.whl (319kB) |████████████████████████████████| 327kB 575kB/s Collecting protobuf>=3.0.0 Downloading https://files.pythonhosted.org/packages/d5/e0/20ba06eb42155cdb4c741e5c af9946e4569e26d71165abaecada18c58603/protobuf-3.17.3-py2.py3-none-any.whl (173kB) |████████████████████████████████| 174kB 878kB/s Collecting six>=1.9 Downloading https://files.pythonhosted.org/packages/d9/5a/e7c31adbe875f2abbb91bd84 cf2dc52d792b5a01506781dbcf25c91daf11/six-1.16.0-py2.py3-none-any.whl Installing collected packages: six, protobuf, mysql-connector-python Successfully installed mysql-connector-python-8.0.25 protobuf-3.17.3 six-1.16.0 WARNING: You are using pip version 19.3; however, version 21.1.3 is available. You should consider upgrading via the 'pip install --upgrade pip' command. pi@raspberrypi:~/dht11db $ aufbauen der Datenbankverbindung Zunächst müssen wir die Datenbankverbindung aufbauen. Dazu benötigen wir: - Servername, - Benutzername, - Passwort, - Datenbankname import mysql.connector #Aufbau einer Verbindung db = mysql.connector.connect( host="localhost", # Servername user="pydbuser", # Benutzername password="pydbpw", # Passwort database="sensorTestDb" ) # Ausgabe des Hashwertes des initialisierten Objektes print(db) sqlStmt = "SHOW TABLES;" cursor = db.cursor() cursor.execute(sqlStmt) for table in cursor: print(table) Die Ausgabe auf der Bash sieht in diesem Fall wie folgt aus: pi@raspberrypi:~/dht11db $ sudo python3 writeToDb.py ('sensorvalues',) pi@raspberrypi:~/dht11db $ Abfragen der Daten des DHT11 Sensors Wie bereits erwähnt habe ich den DHT11 Sensor am Raspberry PI schon ein paar Beiträge auf meinem Blog gewidmet. Ich möchte hier nur darauf eingehen wie du diese Werte in eine Datenbank speichern kannst und somit möchte ich dir im nachfolgenden lediglich das kleine Skript zeigen, welches die Daten des DHT11 Sensors mit der Adafruit Bibliothek ausliest. import Adafruit_DHT #Adafruit Bibliothek für den Zugriff auf den DHT Sensor #Instanz eines DHT11 Sensor erstellen #für einen # DHT22 Sensor bitte Adafruit_DHT.DHT22 # AM2302 Sensor bitte Adafruit_DHT.AM2302 #verwenden sensor = Adafruit_DHT.DHT11 #Der Sensor ist am GPIO Pin 4 angeschlossen pin = 4 #Variablen deklarieren und gleichzeitig die Werte vom Sensor empfangen. humidity, temperature = Adafruit_DHT.read_retry(sensor, pin) #Wenn die Werte erfolgreich gelesen werden konnten dann... if humidity is not None and temperature is not None: #formatierte Ausgabe der Werte auf der Kommandozeile print('Temperatur={0:0.1f}*C Luftfeuchtigkeit={1:0.1f}%'.format(temperature, humidity)) else: #ansonsten #Ausgabe einer Fehlermeldung auf der Kommandozeile print('Fehler beim empfangen der Daten. Bitte versuche es erneut!') Speichern der Daten in die MySQL Datenbank Die bereits abgefragten Daten des DHT11 Sensors, möchten wir nun in die Tabelle "sensorvalues" der Datenbank "sensorTestDb" speichern. import mysql.connector #Connector für den Aufbau der Datenbankverbindung import Adafruit_DHT #Adafruit Bibliothek für den Zugriff auf den DHT Sensor #Aufbau einer Verbindung db = mysql.connector.connect( host="localhost", # Servername user="pydbuser", # Benutzername password="pydbpw", # Passwort database="sensorTestDb" ) # Ausgabe des Hashwertes des initialisierten Objektes print(db) sensor = Adafruit_DHT.DHT11 #Der Sensor ist am GPIO Pin 4 angeschlossen pin = 4 #Variablen deklarieren und gleichzeitig die Werte vom Sensor empfangen. humidity, temperature = Adafruit_DHT.read_retry(sensor, pin) #Wenn die Werte erfolgreich gelesen werden konnten dann... if humidity is not None and temperature is not None: #formatierte Ausgabe der Werte auf der Kommandozeile print('Temperatur={0:0.1f}*C Luftfeuchtigkeit={1:0.1f}%'.format(temperature, humidity)) sqlStatement = "INSERT INTO `sensorvalues` (`ID`, `zeitstempel`, `temperatur`, `luftfeuchtigkei$ cursor = db.cursor() # einen Cursor von der Datenbankconnection holen # ausführen des SQL Statements, es werden an den Platzhaltern "temp" & "hum" die jeweiligen Sensorwerte # formatiert und eingesetzt cursor.execute(sqlStatement.format(temp = temperature, hum = humidity)) # der Commit dient dazu die Daten in die Datenbank zu speichern cursor.execute("COMMIT;") else: #ansonsten #Ausgabe einer Fehlermeldung auf der Kommandozeile print('Fehler beim empfangen der Daten.')

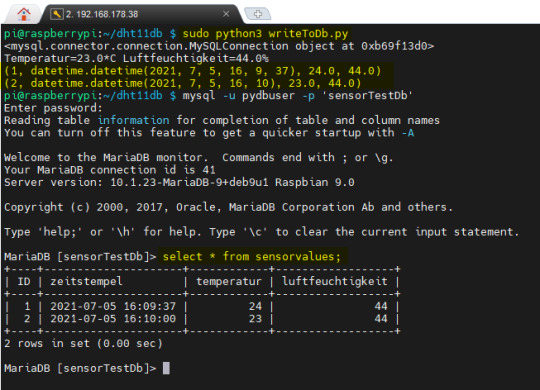

Abfragen der Daten aus der Datenbank

Die gespeicherten Daten können wir nun mit einem weiteren kleinen Python-Skript aus der Datenbank lesen: import mysql.connector db = mysql.connector.connect( host="localhost", # Servername user="pydbuser", # Benutzername password="pydbpw", # Passwort database="sensorTestDb" ) cursor = db.cursor() cursor.execute("SELECT * FROM sensorvalues;") for row in cursor: print(row) Oder aber, man verbindet sich mit der Datenbank und führt das SELECT Statement manuell aus.

ausführen des SELECT Statements auf der Konsole

fertiges Python-Skript

import mysql.connector import Adafruit_DHT #Adafruit Bibliothek für den Zugriff auf den DHT Sensor #Aufbau einer Verbindung db = mysql.connector.connect( host="localhost", # Servername user="pydbuser", # Benutzername password="pydbpw", # Passwort database="sensorTestDb" ) # Ausgabe des Hashwertes des initialisierten Objektes print(db) sensor = Adafruit_DHT.DHT11 #Der Sensor ist am GPIO Pin 4 angeschlossen pin = 4 #Variablen deklarieren und gleichzeitig die Werte vom Sensor empfangen. humidity, temperature = Adafruit_DHT.read_retry(sensor, pin) #Wenn die Werte erfolgreich gelesen werden konnten dann... if humidity is not None and temperature is not None: #formatierte Ausgabe der Werte auf der Kommandozeile print('Temperatur={0:0.1f}*C Luftfeuchtigkeit={1:0.1f}%'.format(temperature, humidity)) sqlStatement = "INSERT INTO `sensorvalues` (`ID`, `zeitstempel`, `temperatur`, `luftfeuchtigkeit`) VALUES (NULL, CURRENT_TIME(), {temp:000.2f}, {hum:000.2f});" cursor = db.cursor() cursor.execute(sqlStatement.format(temp = temperature, hum = humidity)) cursor.execute("COMMIT;") else: #ansonsten #Ausgabe einer Fehlermeldung auf der Kommandozeile print('Fehler beim empfangen der Daten.') cursor = db.cursor() cursor.execute("SELECT * FROM sensorvalues;") for row in cursor: print(row) Hier nun der Download des Python-Skriptes zum bequemen download :

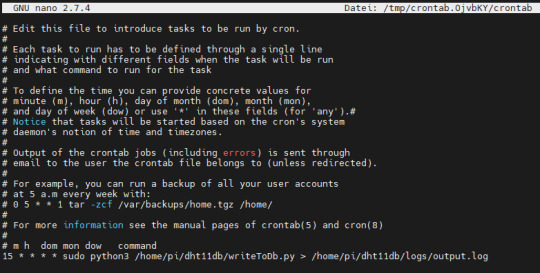

CronJob zum zeitgesteuerten Starten des Skriptes

Der Vorteil eines CronJobs ist dass, das Skript vom Betriebssystem gesteuert und gestartet wird. Vor allem, wenn einmal der Pi Hard- / Softreset erfährt, muss man das gewollte Skript nicht erneut starten, sondern das System übernimmt dieses für einen. Die Syntax für einen CronJob ist für ungeübte recht schwierig zu lesen bzw. zu erstellen, aber auch hier gibt es einige gute Seiten, welche einen Generator erstellt haben und somit zumindest diese Arbeit etwas leichter wird. In meinem Fall möchte ich alle 15 min. einen neuen Wert einlesen und abspeichern, somit ist der Befehl wie folgt: 15 * * * * sudo python3 /home/pi/dht11db/writeToDb.py > /home/pi/dht11db/logs/output.log Die Ausgabe des Skriptes wird nach "/home/pi/dht11db/logs/output.log" geschrieben, d.h. die Ausgabe mit dem Befehl "print" aus dem Skript werden in diese Datei geschrieben, des Weiteren werden auch eventuelle Exceptions / Ausnahmen in diese Datei geschrieben. Den CronJob legen wir mit dem Befehl "crontab -e" an.

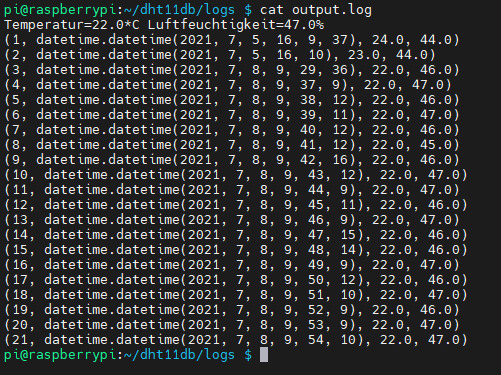

CronTab im Editor - Nano Die Ausgabe erfolgt wie bereits erwähnt in die Datei "output.log", welche die eingefügten Zeilen enthält.

Ausgabe der Einträge des Logfiles Read the full article

0 notes

Text

Saving arrays in Postgres using JDBI

Last time I wrote about JDBI I spoke to you about creating flexible binders for the JDBI Object API so you could bind fields from custom objects into Postgres table columns.

Today I want to show you how to save a collection to a Postgres column using JDBI. You may think this should be totally trivial, but for anything other than a totally basic use case it isn’t. For example, if you were using the Object API and wanted to save a list of tags to a Posts table, you can’t just do:

The problem is that @Bind operates on the JDBI SQLStatement, which does not accept collections that way. Behind the scenes, JDBI has to map the java collection to a database specific SQL collection. In this case, a SQL Array is needed since Postgres works with that. To accommodate for this, JDBI provides you with bindBySqlType

In our example, name is “tags”, value is a SQL Array that we need to create:

and sqlType is the SQL Array data type from the java.sql package. However, I've skipped telling you about a detail. You don’t have access to SQLStatement in your DAO so you will have to do things differently. Create a binder factory like I showed you in the previous blogpost. Here’s an example:

Now that you have a mechanism to bind a java Post object to its corresponding posts table in Postgres update your DAO:

There you have it! You’ve been able to bind an array from a java object to a postgres column using JDBI. Feel free to ask me questions or drop a comment below.

0 notes

Photo

Monsoon Special Offer Rs.6000/- Only (Online Training) Oracle Online Training Demo on 13th August @ 07.00 PM (IST) By Real-Time Expert. Demo link: https://zoom.us/j/84594761815 📧: [email protected] 📲: +91-8179191999 Chat With Our Team: https://bit.ly/chatwithGuide 💥Features of Online Training: ☑ Real-Time Oriented Training ☑ Live Training Sessions ☑ Soft copy of Materials ☑ Interview Preparation Tips ☑ FAQ's #oracle #online #training #course #education #software #learning #study #students #engineering #knowledge #classes #nareshit #learnfromhome #learnsafe #plsqldeveloper #sqlstatement #sql #sqldeveloper #gurgaon #noida #kerala #maharashtra #newdelhi #newyorkcity #hyderabad #amaravathi #ameerpet #vijayawada #vishakapatnam https://www.instagram.com/p/CDoJCp_nolZ/?igshid=1lswukt508dhg

#oracle#online#training#course#education#software#learning#study#students#engineering#knowledge#classes#nareshit#learnfromhome#learnsafe#plsqldeveloper#sqlstatement#sql#sqldeveloper#gurgaon#noida#kerala#maharashtra#newdelhi#newyorkcity#hyderabad#amaravathi#ameerpet#vijayawada#vishakapatnam

0 notes

Photo

Enroll Now: https://bit.ly/3a2X53j Attend Free Demo on Oracle Online Training by Mr.Murali Demo on: 12th August @ 9.00 AM (IST) For More Details: Visit: https://nareshit.com/new-batches-hyderabad/ Call: +91-9000994007, 9000994008, 9121104164 [email protected] Chat With Our TEAM : https://bit.ly/chatwithGuide Stay at Home, Stay Safe & Update Your Skills from Home #oracle #Onlinetraining #Course #education #software #plsql #sqldeveloper #sqlserver #plsqldeveloper #sqldeveloper #storedprocedure #triggers #exceptionhandling #tables #columns #rows #sqlstatement #starschema #dml #ddl #commands #oracledeveloper #oracleengineer #kerala #hyderabad #america #ameerpet https://www.instagram.com/p/CDmCPzWnpwT/?igshid=1aj2yl2bawpg6

#oracle#onlinetraining#course#education#software#plsql#sqldeveloper#sqlserver#plsqldeveloper#storedprocedure#triggers#exceptionhandling#tables#columns#rows#sqlstatement#starschema#dml#ddl#commands#oracledeveloper#oracleengineer#kerala#hyderabad#america#ameerpet

0 notes