#DataOps

Text

What sets Konnect Insights apart from other data orchestration and analysis tools available in the market for improving customer experiences in the aviation industry?

I can highlight some general factors that may set Konnect Insights apart from other data orchestration and analysis tools available in the market for improving customer experiences in the aviation industry. Keep in mind that the competitive landscape and product offerings may have evolved since my last knowledge update. Here are some potential differentiators:

Aviation Industry Expertise: Konnect Insights may offer specialized features and expertise tailored to the unique needs and challenges of the aviation industry, including airports, airlines, and related businesses.

Multi-Channel Data Integration: Konnect Insights may excel in its ability to integrate data from a wide range of sources, including social media, online platforms, offline locations within airports, and more. This comprehensive data collection can provide a holistic view of the customer journey.

Real-Time Monitoring: The platform may provide real-time monitoring and alerting capabilities, allowing airports to respond swiftly to emerging issues or trends and enhance customer satisfaction.

Customization: Konnect Insights may offer extensive customization options, allowing airports to tailor the solution to their specific needs, adapt to unique workflows, and focus on the most relevant KPIs.

Actionable Insights: The platform may be designed to provide actionable insights and recommendations, guiding airports on concrete steps to improve the customer experience and operational efficiency.

Competitor Benchmarking: Konnect Insights may offer benchmarking capabilities that allow airports to compare their performance to industry peers or competitors, helping them identify areas for differentiation.

Security and Compliance: Given the sensitive nature of data in the aviation industry, Konnect Insights may include robust security features and compliance measures to ensure data protection and adherence to industry regulations.

Scalability: The platform may be designed to scale effectively to accommodate the data needs of large and busy airports, ensuring it can handle high volumes of data and interactions.

Customer Support and Training: Konnect Insights may offer strong customer support, training, and consulting services to help airports maximize the value of the platform and implement best practices for customer experience improvement.

Integration Capabilities: It may provide seamless integration with existing airport systems, such as CRM, ERP, and database systems, to ensure data interoperability and process efficiency.

Historical Analysis: The platform may enable airports to conduct historical analysis to track the impact of improvements and initiatives over time, helping measure progress and refine strategies.

User-Friendly Interface: Konnect Insights may prioritize a user-friendly and intuitive interface, making it accessible to a wide range of airport staff without requiring extensive technical expertise.

It's important for airports and organizations in the aviation industry to thoroughly evaluate their specific needs and conduct a comparative analysis of available solutions to determine which one aligns best with their goals and requirements. Additionally, staying updated with the latest developments and customer feedback regarding Konnect Insights and other similar tools can provide valuable insights when making a decision.

#DataOrchestration#DataManagement#DataOps#DataIntegration#DataEngineering#DataPipeline#DataAutomation#DataWorkflow#ETL (Extract#Transform#Load)#DataIntegrationPlatform#BigData#CloudComputing#Analytics#DataScience#AI (Artificial Intelligence)#MachineLearning#IoT (Internet of Things)#DataGovernance#DataQuality#DataSecurity

2 notes

·

View notes

Text

Rancher Fundamental Tutorials 2023 | Session 2 | Part- 1 Out 3

Debug.school is a top institute specializing in IT training, certifications, and consulting services. We provide training, certifications, support and consulting for DevOps, Big Data, Cloud, dataops, AiOps, MLOps, DevSecOps, GitOps, DataOps, ITOps, SysOps, SecOps, ModelOps, NoOps, FinOps, XOps, BizDevOps, CloudOps, SRE and PlatformOps.

🔔 Don't Miss Out! Hit Subscribe and Ring the Bell! 🔔

👉 Subscribe Now

0 notes

Text

Siloed data can hinder your journey to becoming a truly data-driven business. DataOps accelerates this process by bringing Data and Ops teams together on a unified platform. This collaboration streamlines workflows, enabling data to flow through the pipeline faster and continuously delivering actionable insights and measurable value to your business. Take a look at this infographic for a quick introduction to DataOps.

0 notes

Text

Creole Studios Launches Comprehensive Data Engineering Services with Azure Databricks Partnership

Creole Studios introduces its cutting-edge Data Engineering Services, aimed at empowering organizations to extract actionable insights from their data. Backed by certified experts and a strategic partnership with Azure Databricks, we offer comprehensive solutions spanning data strategy, advanced analytics, and secure data warehousing. Unlock the full potential of your data with Creole Studios' tailored data engineering services, designed to drive innovation and efficiency across industries.

#DataEngineering#BigDataAnalytics#DataStrategy#DataOps#DataQuality#AzureDatabricks#DataWarehousing#MachineLearning#DataAnalytics#BusinessIntelligence

0 notes

Text

Why Big Data needs DevOps

#BigDataDevOps#DataOps#TechIntegration#DataEngineering#DevOpsCulture#DataScience#ContinuousIntegration#DataManagement

0 notes

Text

Estrategia para licencias PowerBi - Fabric

La popularidad de Fabric no para de extenderse y eso hace que cada vez más aparezcan confusiones y dudas sobre licencias. Cada día llegan más dudas sobre el formato de licencias y como encaja lo nuevo en lo viejo. Dentro de esas dudas aparecen muchas alternativas para manejo de licencias.

En este artículo vamos a hablar de puntos medios y grises para optimizar costos de nuestras licencias encontrando el mejor balance con los nuevos planes que nos ofrece Fabric.

Primero vamos con conocimientos básicos de licencias en este antiguo artículo que escribí. En el mismo vamos a conocer detalles de las licencias disponibles en julio 2024.

Si ya conocen las de PowerBi, lo nuevo es Fabric. Una licencia por capacidad que viene a expandir los artefactos o contenidos que podemos crear dentro de un área de trabajo. Sus planes inician con valores más económicos que las capacidades anteriores, lo que permiten que todo tipo de organización pueda acceder al uso de éstos artefactos. Sin embargo, el uso de los tradicionales contenidos de PowerBi siguen bajo el mismo esquema.

La estrategía de optimización se base específicamente en los usuarios. Si tenemos capacidades dedicadas... ¿Por qué pagamos licencias por usuarios? esta es la pregunta que trae el principal contexto y razón del artículo. A las organizaciones les cuesta este concepto, más aún viendo que los contenidos de Fabric no necesitan licencias de usuario. No necesitamos una licencia PRO para desarrollar un notebook, escribir en Onelake o consultar un warehouse con SQL. Para resolver esta paradoja vamos a dividir nuestro enfoque en los dos tipos de usuarios, desarrolladores y visores.

Enfoque de Visores

Algo que suele trae mucho dolor a organizaciones que usan PowerBi es que los visores en entornos de capacidad compartida (pro o ppu), tengan que pagar licencia. Uno puede pensar que pagando una "Capacidad Dedicada" como premium lo soluciona, sin embargo premium va a desaparecer y quedará Fabric. Muchos podrán pensar que esta es la solución definitiva, puesto que Fabric comienza con planes muy económicos, pero no es cierto. La característica de compartir con usuarios gratuitos comienza en un plan F64, cuyo costo ronda entre 5000 y 8000 dolares (dependiendo el tipo de pago). Lo que nos hace pensar que valdría la pena si nuestra operación interna cuenta con más de 500 usuarios visores de PowerBi (puesto que una licencia pro sale 10 dolares). Ciertamente, un número que solo grandes empresas pueden considerar.

Entonces, ¿Qué hacemos cuando no podemos pagar ese monto? Si podemos comprar capacidades dedicadas más chicas, ¿Cómo podríamos compartir a usuarios visores sin pagarles licencias Pro? La respuesta es una característica bastante olvidada en el entorno de analytics. Estoy hablando de la feature de "Embedded". PowerBi cuenta con una compleja pero poderosa posibilidad de embeber informes en aplicaciones web con grandes posibilidades. Una de esas posibilidades es delegar la seguridad y loguear a la aplicación que refleja los informes. De ese modo, podríamos compartir a todos los usuarios visores que querramos sin pagar licencias. Sin embargo, no es tan simple puesto que necesitaríamos un potente equipo de desarrollo que construya esta web app aprendiendo todos los enfoques de power bi con especial atención a la seguridad, dado que ahora es responsabilidad nuestra (nos la delega microsoft al usar embedded).

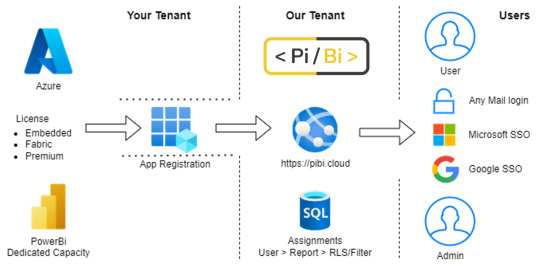

Si no tenemos equipo de desarrollo y queremos aprovechar esa capacidad. ¿Cómo lo resolvemos?. La opción más viable sería comprando un producto de un tercero. Varias instituciones proveen este tipo de software. Por ejemplo, una que conozco en español es PiBi. PiBi es una plataforma web como servicio (SaaS) que usa la característica de Power Bi Embedded. Una construcción que interactúa con tu entorno de Azure y te permite distribuir informes de PowerBi de manera segura, simple y eficiente.

¿Qué ventajas encontramos si nos embarcamos en este camino?

Operación de informes en un solo lugar

Más sencillo de usar que Fabric/PowerBi Service

Compartir con usuarios externos a la organización

Logins SSO Google/Microsoft

Mantener seguridad y privacidad

El requerimiento para usar Embedded es tener una licencia por capacidad. Herramientas como ésts pueden partir de valores como 450 dolares por mes, que junto a una licencia básica de Fabric con pago anual de 150 dolares son 600 dolares. Si nuestra operación de usuarios internos ronda entre 60 y 500 usuarios, encaja perfectamente para optimizar nuestra estrategia de Power Bi. Por supuesto, que habría detalles como si tenemos modelos y mucho volumen de datos, puede que necesitemos un Fabric un poco más elevado, pero deberíamos pensar a ese como costo de almacenamiento y no de distribución de contenido a los usuarios.

Enfoque de desarrolladores

En la mayoría de los casos, lo primero que normalmente tendería a evolucionar, son los visores. Una vez encontrado un punto de madurez en ellos, seguirá esta propuesta. Esto quiere decir que lo más probable es que YA contemos con capacidad dedicada (para usar la feature embedded). Pero no desesperen si no la tienen, esta estretegia es totalmente viable sin capacidad tal como lo explico en este otro artículo. Las estrategias no estan ligadas una a otra, aunque son poderosas juntas.

El eje para liberar a los usuarios desarrolladores de sus licencias es pensar en desarrollo de software convencional. Si pensamos en la industra de software, un desarrollador, sea backend o frontend, tiene como trabajo solamente desarrollar. Su eje y foco esta en construir. Hoy esos roles no hacen integración de soluciones, implementaciones o deploys, puestas en producción, etc. Existen roles como DevOps que ayudan a delegar la construcción final.

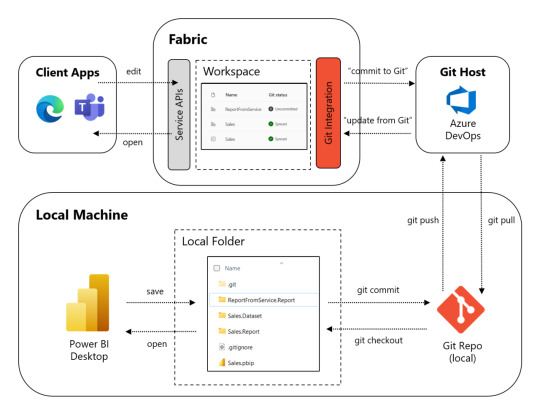

Tomando este enfoque como guía, si queremos que los desarrolladores de PowerBi no usen licencias, debemos concentrarnos en lo básico, un repositorio. Hoy Fabric nos da la posibilidad de integrar repositorios de GIT con Áreas de Trabajo. Esto no solo nos ayuda a que el desarrollador ni piense en Fabric o PowerBi Service, sino que también almacena los desarrollos en formato Power Bi Project que nos deja mergear código.

Si queremos ver eso en más profundidad pueden abrir éste artículo.

Así los desarrolladores de Power Bi. Solo desarrollarán. Comienzan el día armando o con un pull a su branch de repositorio, comiteando cambios y al terminar un push. Ni piensa ni escucha quienes ven que informes y donde está. Luego podemos pensar en otro perfil que podemos decirle Admin del Area o DataOps que garantice que los reportes están en el lugar apropiado o sean automáticamente deployados. Veamos un poco más gráfico esto:

Vean como Local Machine nunca ve Fabric. El desarrollador no necesita ingresar al portal web. Solo necesitamos licencias para DataOps o Administradores de areas. Así es como reducimos licencias y ganamos robustez y soluciones tanto versionables como escalables.

Se que fue mucho texto pero espero que haya sido a meno y les traigan nuevas ideas para optimizar efectivamente la operación y licencias de sus entornos.

#fabric#microsoft fabric#powerbi#power bi#dataops#pibi#ladataweb#power bi embedded#power bi training#power bi tutorial#power bi tips#power bi argentina#power bi cordoba#power bi jujuy#power bi isv

0 notes

Text

Navigating the World of Data Engineering

Navigating the World of Data Engineering. An Overview of Data Infrastructure! Dive into the dynamic field of data engineering to learn the fundamental ideas and strategies for developing strong data systems. LSET's thorough handbook delves into data modelling, processing, and pipeline creation, providing a road map for creating scalable and efficient data infrastructure. In addition, the London School of Emerging Technology (LSET) Data Engineer Course will provide expert-led training and hands-on experience in mastering data engineering tools and processes. Join on a path to becoming a skilled data engineer, prepared to face difficult data issues and drive digital innovation.

Enrol @ https://lset.uk/ for admission.

0 notes

Text

The Era of Data-Driven Decision Making with Data Reconciliation

Unveil the future of data management with Datagaps' DataOps 🚀 Suite! Dive into our latest blog to explore the transformative power of data reconciliation in today's data-driven world. Discover how automation and advanced tools are reshaping data integrity and consistency for strategic decision-making. 🔍💡

HERE IS THE BLOG

#DataReconciliation#DataIntegrity#DataOps#DataTestingAutomation#PowerBI#ETL#DataDrivenDecisionMaking

1 note

·

View note

Text

Maximizing Data Potential: The Power of Data Preparation Tools

Data preparation tools play a pivotal role in the realm of big data, catering to structured, unstructured, and semi-structured data environments. These tools come equipped with pre-built functionalities that effectively automate and streamline recurring processes. With collaborative interfaces for report generation and model construction, they ensure seamless operations in data management. Their primary objective is to facilitate the migration of top-quality data for analysis while promptly flagging any instances of data duplication, empowering users to take necessary corrective measures.

Key vendors of data analysis tools offer a plethora of capabilities, ranging from consolidating diverse data sources into cohesive datasets to employing AI-driven mechanisms for data and field identification within multi-structured documents. Automated extraction and classification of data, along with quality assessment, data discovery, and data lineage functionalities, are integral features provided by these leading tools. Moreover, they excel in rectifying imbalanced datasets by amalgamating internal and external data sources, generating new data fields, and eliminating outliers. The evolution of data preparation software is evident in the expansion towards cloud-based solutions and the augmentation of their capabilities to align with DataOps principles, facilitating the automation of data pipeline construction for business intelligence (BI) and analytics purposes.

Quadrant Knowledge Solutions emphasizes the significance of data preparation tools in enabling organizations to identify, cleanse, and transform raw datasets from diverse sources. These tools empower data professionals to conduct comprehensive analysis and derive valuable insights using machine learning (ML) algorithms and analytics tools. By streamlining processes such as data cleansing, validation, and transformation without necessitating human intervention or coding expertise, these tools expedite decision-making processes for businesses. They enable users to devote more time to data mining and analysis, thereby enhancing overall operational efficiency.

Prominent vendors in the data preparation software market include Modak Analytics, Oracle, Precisely, Quest, SAP, SAS, Talend, Tamr, TIBCO, and Yellowfin. These industry leaders offer robust solutions that cater to the diverse needs of modern enterprises. Their continuous innovation and commitment to enhancing data management capabilities contribute significantly to driving efficiency and fostering data-driven decision-making across various sectors.

In conclusion, data preparation tools serve as indispensable assets in the realm of big data, offering a wide array of functionalities to streamline data management processes. Their role in facilitating data migration, cleansing, and transformation cannot be overstated, especially in today's data-driven landscape. With advancements in technology and a growing emphasis on automation, these tools are poised to play an even more significant role in empowering organizations to harness the full potential of their data assets.

#DataAnalysisPreparation#DataPrepTools#DataPreparationSoftware#DataPrep#DataPrepSoftware#DataPreparationTools#CloudBasedDataPreparation#DataOps#BI

1 note

·

View note

Text

Conquer the Complex World of Data with Appzlogic's ETL Development Services

Appzlogic's team of expert ETL developers help you design, build and implement custom ETL solutions that meet your specific needs.

Visit: https://www.appzlogic.com/etl-development/

#Appzlogic#ETL#ETLDevelopment#DataIntegration#DataManagement#DataWarehouse#BigData#DataSolutions#CloudETL#DataOps

0 notes

Text

Jenkins Fundamental Tutorials for Beginners Part 1 Out 4

SRE School is a premier institute specializing in IT training, certification, and consulting services. We provide training, certifications, support and consulting for DevOps, Big Data, Cloud, dataops, AiOps, MLOps, DevSecOps, GitOps, DataOps, ITOps, SysOps, SecOps, ModelOps, NoOps, FinOps, XOps, BizDevOps, CloudOps, SRE and PlatformOps.

🔔 Don't Miss Out! Hit Subscribe and Ring the Bell! 🔔

👉 Subscribe Now

0 notes

Text

Creole Studios Launches Comprehensive Data Engineering Services with Azure Databricks Partnership

Creole Studios launches comprehensive data engineering services in partnership with Azure Databricks, empowering businesses to unlock insights, ensure compliance, and drive growth with expert solutions. From data strategy and consulting to advanced analytics and data quality assurance, Creole Studios offers tailored services designed to maximize the potential of your data.

#DataEngineering#AzureDatabricks#DataStrategy#AdvancedAnalytics#BigData#DataQuality#DataOps#DataGovernance#Compliance#BusinessInsights#CreoleStudios

0 notes

Link

0 notes

Text

Maximize your data's potential with our Data Engineering Services. We help you turn possibilities into actionable insights.

Explore our services at https://rtctek.com/data-engineering-services/ and unlock your data's full capabilities!

0 notes

Text

We are Hiring Senior Data Engineer

We are currently offering a compelling opportunity for a Senior Data Engineer to play a pivotal role in shaping the future of data infrastructure. Apply and grab the opportunity to align data with impact, contributing to the development of transformative solutions.

Job Description - https://bizessence.com.au/jobs/senior-data-engineer/

#bizessence#dataengineer#techcareer#datascience#careergrowth#techjobs#jobopportunity#jobalert#jobvacancy#dataops#dataanalytics#hiring#kochijobs#punejobs#chennaijobs#bengalurujobs#india

0 notes