#Text-Erkennung

Explore tagged Tumblr posts

Text

Oktober 2023

Audiotranskription 2023

Ich möchte den Inhalt eines Podcasts verschriftlichen und frage meine Arbeitskolleg*innen, wie sie Audiodateien transkribieren. "Mit Premiere" ist die vielstimmige Antwort, gemeint ist das Videoschnittprogramm von Adobe. Das verwirrt mich zunächst, denn ich will ja was mit Audio machen, nicht mit Video. Die Verwirrung klärt sich aber schnell: Die Transkriptionsfunktion ist eigentlich dafür da, Videos automatisch mit Untertiteln zu versehen. Man kann das Ergebnis aber auch als .txt oder .csv exportieren und nach Belieben weiterverarbeiten. Das Ergebnis ist sehr gut, das Programm hält die drei Personen, die sich auf Deutsch unterhalten, einwandfrei auseinander und lässt auch nur wenige Wörter aus. Ich wähle diese Technik, weil das Programm auf meinem Arbeitsrechner zur Standardsoftware gehört; viele Transkriptionsdienste sind billiger als das Abonnement für Premiere. Eine weitere Transkriptionsmöglichkeit entdecke ich durch Zufall. Ich bezahle das Unternehmen Dropbox dafür, dass es mir Speicherplatz vermietet. Als ich die Audiodatei im Dropbox-Speicher aus Versehen anklicke, wird sie abgespielt und automatisch transkribiert. Auch hier ist die Texterkennung sehr gut, aber das Transkript erscheint als durchgehender Text, es wird nicht zwischen den Sprechern unterschieden. Der Dienst steht nur zahlenden Kunden zur Verfügung, in der Kostenlos-Variante des Programmes gibt es ihn nicht. Wie ich auf Google Pinpoint aufmerksam werden, weiß ich nicht mehr. Der Dienst soll Journalisten helfen, große Datenmengen zu organisieren und zu analysieren. Hier dauert die Transkription am längsten. Es sind nur ein paar Minuten für den 20 Minuten-Podcast, aber die beiden anderen Programme erledigen das in wenigen Sekunden. Das Ergebnis wird als .pdf ausgegeben, kann aber als .txt exportiert werden. Es gibt keine Sprecher-Erkennung und der Anteil an sinnloser Übersetzung ist deutlich höher als bei den beiden Alternativen, dafür muss ich aber auch nichts bezahlen.

(Marlene Etschmann)

6 notes

·

View notes

Text

Der Aufstieg von KI-Schreibwerkzeugen hat eine digitale Landschaft geschaffen, in der es immer schwieriger wird, menschlichen von maschinell erzeugtem Text zu unterscheiden. Schreiber und Leser stehen täglich vor diesem modernen Rätsel, sei es beim Überprüfen von Schüleraufsätzen oder beim Bewerten von Online-Inhalten. Tools wie GPTZero und Writer.com bieten Erkennungsfunktionen, doch ihre Genauigkeit reicht von 26% bis 99,98%. Der Schlüssel liegt in der Kombination von automatischer Erkennung mit scharfer menschlicher Beobachtung. Die Erkennung erfordert einen vielschichtigen Ansatz. Automatisierte Tools scannen nach verräterischen Mustern, aber geschulte Augen fangen subtile Hinweise auf – ungewöhnliche Formulierungen, mechanische Wiederholungen oder Kontextfehler, die KI oft produziert. Durch die Kombination digitaler Werkzeuge mit manueller Analyse von Schreibmustern und Wortwahl entwickeln Leser ein zuverlässigeres System zur Identifizierung synthetischer Inhalte. Die digitale Schreiblandschaft entwickelt sich schnell weiter und verlangt anpassungsfähige Erkennungsstrategien. Nutzer brauchen aktuelles Wissen über KI-Fähigkeiten und -Grenzen sowie praktische Erfahrung mit verschiedenen Erkennungsmethoden. Diese Kombination aus technischen Werkzeugen und menschlichem Scharfsinn schafft den effektivsten Ansatz, um sich in der heutigen inhaltsreichen Online-Umgebung zurechtzufinden Auf einen Blick - KI-Erkennungstools sind unterschiedlich zuverlässig. Bei menschlichen Texten erreichen sie bis zu 99,98% Genauigkeit, aber bei KI-generierten Inhalten nur 26%. - Die Erkennung wird zuverlässiger, wenn mehrere Tools kombiniert werden, da jede Plattform einzigartige sprachliche Muster und Schreibmerkmale analysiert. - Viele KI-Detektoren können durch einfache Textänderungen und Umformulierungen umgangen werden, was die aktuellen technologischen Grenzen aufzeigt. - Der effektivste Ansatz verbindet automatisierte Tools mit menschlicher Analyse, untersucht Schreibmuster, Konsistenzlevel und ungewöhnliche Wortkombinationen. - Sprachliche Vielfalt beeinflusst die Erkennungsgenauigkeit erheblich. Nicht-englische Texte stellen besondere Herausforderungen dar und führen zu niedrigeren Zuverlässigkeitsraten bei den Erkennungsplattformen. Häufig gestellte Fragen zu KI-Detektoren KI-Detektoren analysieren Texte, um zwischen menschlicher und künstlicher Intelligenz-Autorschaft zu unterscheiden. Diese speziellen Tools untersuchen Schreibmuster, Unstimmigkeiten und sprachliche Merkmale, die auf KI-generierte Inhalte hinweisen. Beliebte Erkennungsplattformen sind GPTZero, Writer.com und ZeroGPT, obwohl ihre Genauigkeit je nach Tool und dem bewerteten KI-Modell variiert. Nutzer sollten realistische Erwartungen haben, da die Erkennungstechnologie oft hinter den sich schnell entwickelnden KI-Sprachmodellen zurückbleibt. Außerdem werden nutzerzentrierte Ansätze immer wichtiger, da KI-generierte Antworten zunehmend in Suchergebnissen erscheinen. Was ist ein KI-Detektor? KI-Detektoren fungieren als digitale Schnüffler in der Content-Erstellung und nutzen Algorithmen, um zwischen menschlich geschriebenem und KI-generiertem Text zu unterscheiden. Diese Erkennungstools verwenden Methoden der Mustererkennung, um Schreibstile zu analysieren und maschinell erstellte Inhalte zu identifizieren. Tests zeigen, dass der GPT-2 Output Detector eine Genauigkeit von 99,98% bei der Identifizierung von menschlichem Text erreicht, obwohl die Zuverlässigkeit der Erkennung bei verschiedenen Tools variiert. Kostenlose und kommerzielle Lösungen stehen vor anhaltenden Herausforderungen, wie die jüngsten Leistungsprobleme von Writer.com zeigen. Die perfekte Genauigkeit von GPTZero demonstriert das Potenzial für verbesserte Erkennungsalgorithmen. Die Technologie entwickelt sich ständig weiter und verbessert die Fähigkeiten dieser digitalen Verifizierungstools. Wie funktioniert die Erkennung von KI-generiertem Inhalt? Die Erkennung von KI-generiertem Inhalt basiert auf ausgeklügelten Mustererkennungs- und Analysetechniken. Moderne KI-Detektoren scannen Texte nach verräterischen Mustern, Originalitätsmarkern und sprachlichen Fingerabdrücken, die maschinell erstellte Texte von menschlichen Arbeiten unterscheiden. Diese Erkennungstools analysieren verschiedene Aspekte: sich wiederholende Strukturen, Schreibflüssigkeit und mögliche Ungenauigkeiten. Spezielle Tools wie GPTZero können Genauigkeitsraten von bis zu 100% erreichen, obwohl viele Detektoren KI-Texte mit 40-60% Genauigkeit identifizieren. Standard-Plagiatsprüfer enthalten jetzt spezielle Funktionen, um Sprachmodell-Outputs zu erkennen. Die zunehmende Raffinesse des KI-Schreibens stellt eine ständige Herausforderung dar und zwingt die Erkennungstools, ihre Erkennungsmethoden kontinuierlich anzupassen. Welche Tools gibt es als KI-Checker? Content-Ersteller und Pädagogen können verschiedene Tools nutzen, um KI-generierten Text zu erkennen, obwohl die Wirksamkeit je nach Plattform variiert. Moderne KI-Checker und KI-Tools (Künstliche Intelligenz) zielen auf Inhalte von GPT-4 und anderen Sprachmodellen ab. Tool-Name Erkennungsgenauigkeit GPT-2 Detektor 99,98% (menschlicher Text) Writer.com Variable Ergebnisse GPTZero 100% (KI-Inhalte) Turnitin Gemischte Leistung Kostenlose KI-Detektoren bieten weitverbreitete Zugänglichkeit, aber schwankende Zuverlässigkeit. GPTZero behält die Spitzenleistung mit hohen Genauigkeitsraten bei, ergänzt durch etablierte Plattformen wie Turnitins Erkennungsfunktionen. Nutzer sollten mehrere Erkennungstools für optimale Ergebnisse einsetzen, da jede Plattform bestimmte Vorteile bei der Identifizierung von KI-generierten Inhalten bietet. Wie kann ich KI-generierte Texte kostenlos erkennen? Kostenlose Tools wie GPTZero und ZeroGPT erkennen KI-generierte Inhalte mit einer Genauigkeit von 80-100%. Der beste Ansatz kombiniert mehrere Detektoren und achtet dabei auf wichtige Indikatoren wie sich wiederholende Formulierungen und unnatürliche Sprachmuster. Kostenlose Erkennungstools haben zwar ihre Grenzen, bieten aber einen praktischen Ausgangspunkt zur Überprüfung der Echtheit von Inhalten ohne kostenpflichtige Dienste. Die Einbeziehung von fortlaufenden SEO-Maßnahmen kann deine Fähigkeit, die Qualität und Authentizität von Inhalten zu erkennen, weiter verbessern. Gibt es irgendwelche kostenlosen Tools zur KI-Erkennung? Kostenlose KI-Erkennungstools dienen Lehrern, Autoren und Content-Erstellern, die zwischen menschlich und maschinell geschriebenen Texten unterscheiden müssen. Obwohl es keine perfekte Lösung gibt, um von ChatGPT oder GPT4 generierte Inhalte zu erkennen, liefern mehrere zuverlässige Detektoren gute Ergebnisse. Die besten kostenlosen Erkennungstools sind: - GPTZero, das bei aktuellen Tests 100% Genauigkeit zeigt - Writer.com, das trotz schwankender Leistung Einblicke bietet - QuillBot, das in der kostenlosen Version 80% Genauigkeit bietet - ZeroGPT, das zuverlässige grundlegende KI-Texterkennung liefert - Grammarly, das KI-Erkennungsfähigkeiten mit unterschiedlichen Ergebnissen bietet Diese Erkennungstools bleiben unvollkommen, und ihre Wirksamkeit ändert sich, während sich die KI-Technologie weiterentwickelt. Die Verwendung mehrerer Tools zusammen, kombiniert mit kritischer Analyse, bietet die zuverlässigste Bewertung von möglicherweise KI-generierten Texten. Wie genau sind kostenlose KI-Detektoren? Beliebte KI-Erkennungs-Tools zeigen große Genauigkeitsschwankungen, von GPTZeros 100% Erfolgsrate bis zu nur 40% bei einfachen Optionen. Kostenlose KI-Detektoren liefern oft uneinheitliche Ergebnisse bei der Analyse von KI-generiertem Content. Tool Genauigkeit Zuverlässigkeit GPTZero 100% Hoch GPT-2 Detector 99,98% Mittel Basic KI-Checker 40% Niedrig Die Grenzen von Erkennungs-Tools zu verstehen, erweist sich als wesentlich für zuverlässige Ergebnisse. GPTZero sticht als vertrauenswürdiger Detektor hervor, während viele kostenlose Tools immer noch grundlegende Plagiatsprüfungs-Methoden statt spezialisierter KI-Analyse verwenden. Die Nutzung mehrerer Erkennungs-Tools und der Vergleich ihrer Ergebnisse bringt die genaueste Bewertung. Hinweis: KI-Checker bezieht sich auf "Künstliche Intelligenz"-Erkennungssoftware. Welche Schritte sind nötig, um einen KI-Text zu überprüfen? Da es immer wichtiger wird, KI-generierte Inhalte zu erkennen, brauchst du einen systematischen Ansatz, der sowohl Tools als auch analytische Techniken kombiniert. Um effektiv zu überprüfen, ob ein Text von einer KI erstellt wurde, kannst du diese wichtigen Schritte befolgen, die automatisierte Erkennung mit manueller Analyse verbinden. - Lass den Text durch kostenlose KI-Detektoren wie GPTZero laufen, um eine erste Einschätzung zu bekommen - Analysiere Schreibmuster auf sich wiederholende Phrasen oder ungewöhnliche Wortkombinationen - Prüfe die Genauigkeit und Originalität des Inhalts mit Plagiats-Tools wie Copyleaks - Vergleiche die Flüssigkeit und Kohärenz des Textes mit bekannten menschlichen Schreibproben - Achte auf typische Anzeichen von KI-Generierung, wie übermäßig perfekte Grammatik oder generische Beispiele Denk daran, dass keine einzelne Methode hundertprozentig zuverlässig ist. Die Kombination mehrerer Ansätze gibt dir die verlässlichsten Ergebnisse beim Identifizieren von KI-generierten Inhalten. Fortgeschrittene Technologien zur Erkennung von KI-Texten KI-Detektoren nutzen Mustererkennungsalgorithmen, um Textstrukturen, Wortmuster und subtile sprachliche Marker zu analysieren, die für menschliche Leser unsichtbar sind. GPT-4-Erkennungstools konzentrieren sich auf statistische Wortmuster und kontextbezogenen Zusammenhang, während Gemini-Detektoren semantische Beziehungen und Schreibstilvariationen ins Visier nehmen. Diese Erkennungssysteme kombinieren mehrere Methoden – von der Perplexität (Messung der Textvorhersagbarkeit) bis zur Entropieanalyse (Bewertung der Informationszufälligkeit) – und schaffen so ein robustes System, das KI-generierte Inhalte kaum umgehen können. Zusätzlich können effektive Keyword-Auswahlstrategien die Genauigkeit der KI-Texterkennung verbessern, indem sie Systemen ermöglichen, Inhalte besser zu verstehen und zu kategorisieren. Welche Algorithmen verwenden moderne KI-Detektoren? Moderne KI-Erkennungsalgorithmen kombinieren neuronale Netzwerke mit statistischer Analyse, um maschinell erstellte Inhalte zu identifizieren. Diese Systeme analysieren sprachliche Merkmale und Muster, um zwischen menschlichen und KI-geschriebenen Texten zu unterscheiden. Erkennungsalgorithmen nutzen jetzt Maschinenlernverfahren, besonders Zero-Shot-Klassifikatoren - Systeme, die Inhaltstypen ohne vorherige Trainingsbeispiele erkennen können. Zu den Kernkomponenten gehören: - Neuronale Netzwerke, die Schreibstil, Vokabular und Satzstruktur bewerten - Statistische Mustererkennung zur Analyse der Textverteilung - Verarbeitung natürlicher Sprache zur Bewertung von Kohärenz und Bedeutung - Deep-Learning-Modelle für Kontext- und Konsistenzprüfungen - Hybridsysteme, die mehrere Erkennungsmethoden kombinieren KI-Detektoren werden täglich ausgefeilter, obwohl perfekte Genauigkeit nach wie vor schwer zu erreichen ist. Erkennungsmethoden passen sich zusammen mit der sich entwickelnden Technologie an, was die KI-Inhaltserkennung zu einem dynamischen Feld in der digitalen Analyse macht. Wie unterscheiden sich die Erkennungsmethoden von GPT-4 und Gemini? GPT-4 und Gemini stehen an vorderster Front der KI-Erkennungstechnologie und nutzen unterschiedliche Ansätze, um maschinell erzeugten Text zu identifizieren. GPT-4 verlässt sich stark auf Mustererkennung und sprachliche Hinweise und erreicht etwa 80% Genauigkeit bei der Erkennung von KI-generiertem Text durch ausgeklügelte kontextuelle Einbettungen - ein Prozess, der Wörter und Phrasen in mathematische Darstellungen überträgt - und Fine-Tuning-Prozesse. Geminis Erkennungsmethoden schlagen eine andere Richtung ein und nutzen modellübergreifendes Training und fortschrittliche Neural-Network-Architekturen. Das System legt Wert auf semantische Analyse, die Bedeutung und Kontext untersucht, was es vom Ansatz von GPT-4 unterscheidet. Beide Systeme aktualisieren ihre Erkennungsalgorithmen kontinuierlich, um komplexe KI-Texterstellung zu bekämpfen, aber Geminis robustes modellübergreifendes Training bietet einen klaren Vorteil bei der Bewältigung neuer Erkennungsherausforderungen. Was macht einen KI-Checker mächtig? Drei grundlegende Säulen definieren leistungsstarke KI-Checker: ausgeklügelte maschinelle Lernalgorithmen, umfangreiche Trainingsdatensätze und adaptive Mustererkennung. Diese fortschrittlichen Erkennungstools identifizieren KI-generierte Inhalte, indem sie bestimmte Muster und Schreibmerkmale analysieren. Zu den Hauptkomponenten gehören: - Maschinelle Lernmodelle, die mit verschiedenen menschlichen und KI-Schreibproben trainiert wurden - Mustererkennungssysteme, die KI-Textmarker erkennen - Regelmäßige Updates, um mit der sich entwickelnden KI-Schreibtechnologie Schritt zu halten - Verschiedene Schreibstile und Quellen in den Trainingsdaten - Fortschrittliche Algorithmen, die Textkonsistenz und Sprachfluss messen Erkennungstools kombinieren Spitzentechnologie mit ausgefeilten Analysemethoden, um hohe Genauigkeitsraten bei der Unterscheidung zwischen menschlich und KI-erstellten Inhalten zu erreichen. Die Rolle von ChatGPT bei der KI-Texterstellung ChatGPT funktioniert durch seine fortschrittliche Transformer-Architektur, ein neuronales Netzwerksystem, das Sprache in parallelen Segmenten verarbeitet, kombiniert mit umfassenden Trainingsdaten. Diese Grundlage ermöglicht eine natürliche Texterstellung aus Benutzereingaben mit kontextbezogenen, zusammenhängenden Antworten. KI-Erkennungssoftware kann ChatGPT-Inhalte mit unterschiedlicher Genauigkeit identifizieren, aber schnelle technologische Fortschritte machen eine konsistente Erkennung schwieriger. Im Vergleich zu anderen KI-Schreibplattformen überzeugt ChatGPT durch kontextuelles Verständnis, durchgängigen Erzählfluss und anpassbare Schreibstile, obwohl jedes System eigene Fähigkeiten bietet. Wie generiert ChatGPT Texte? KI-generierter Text basiert auf einem ausgeklügelten Sprachverarbeitungssystem, wie es die Transformer-basierte Architektur von ChatGPT zeigt. Dieses System zerlegt Text in Token (kleine Spracheinheiten) und analysiert Muster, um menschenähnliche Antworten zu erzeugen. Nutzereingaben durchlaufen mehrere Ebenen, während ChatGPT Wortsequenzwahrscheinlichkeiten berechnet, um zusammenhängenden Inhalt zu erstellen. Wichtige Funktionen: - Textverarbeitung durch fortschrittliche Aufmerksamkeitsmechanismen - Sprachtokenisierung zur Analyse - Lernen aus Internet-Datensätzen - Kontextbasierte Wortvorhersage - Echtzeitanpassung der Antworten Umfangreiche Datentrainings ermöglichen es ChatGPT, Text effektiv zu erkennen und zu generieren, was es zu einem wertvollen Werkzeug für die Inhaltserstellung macht. KI-Erkennungssysteme stehen vor wachsenden Herausforderungen bei der Identifizierung von ChatGPTs Output aufgrund seiner fortschrittlichen Sprachverarbeitungsfähigkeiten. Kann ChatGPT auch von KI-Detektoren erkannt werden? Die Erkennung von KI-generiertem Text steht bei fortschrittlichen Sprachmodellen wie ChatGPT vor erheblichen Herausforderungen. Aktuelle KI-Detektoren befinden sich in einem technologischen Wettrüsten und zeigen stark schwankende Genauigkeitsraten. Der GPT-2 Output Detector erreicht zwar bei menschlich geschriebenen Inhalten eine Genauigkeit von bis zu 99,98%, hat aber Schwierigkeiten, ChatGPTs Output zuverlässig zu identifizieren. Die zunehmende Komplexität von KI-Systemen erschwert die Erkennungsbemühungen. Viele Tools zeigen niedrige Genauigkeitsraten, manche erkennen KI-generierte Texte nur zu 26%. Einfaches Umformulieren kann Erkennungssysteme stören und sie unwirksam machen. Nutzer sollten mehrere Erkennungstools verwenden und neue Entwicklungen in diesem dynamischen Bereich beobachten, um KI-generierte Inhalte zuverlässig identifizieren zu können. Wie vergleicht sich ChatGPT mit anderen KI-Tools? ChatGPT stellt einen Durchbruch in der KI-Schreibtechnologie dar, verändert die Texterstellung und unser Verständnis von künstlicher Intelligenz. Seine fortschrittlichen Fähigkeiten übertreffen frühere KI-Tools bei der Erstellung menschenähnlicher Inhalte und schaffen neue Herausforderungen für Erkennungssysteme. Die ausgeklügelten Algorithmen des Tools erzeugen Texte, die natürlichen Schreibmustern sehr ähnlich sind, was wichtige Fragen zur Originalität und Plagiatserkennung aufwirft. Wichtige Unterscheidungsmerkmale: - Überlegene Genauigkeit bei der Nachahmung menschlichen Schreibens - Verbesserte Widerstandsfähigkeit gegen KI-Erkennungstools - Kontextuell relevante und flüssige Texterstellung - Inhaltsproduktion in nahezu menschlicher Qualität - Fortgeschrittene Bewältigung komplexer Schreibaufgaben Erkennungstools wie GPTZero und Originality.ai entwickeln weiterhin neue Methoden, um KI-generierte Texte zu identifizieren, doch ChatGPTs anspruchsvolle Ausgaben fordern diese Grenzen ständig heraus und etablieren es als führende Kraft in der KI-Texterstellung. Erkennung von KI-generiertem Inhalt in verschiedenen Sprachen KI-Erkennungstools haben Schwierigkeiten, maschinell erstellte Inhalte in verschiedenen Sprachen zu identifizieren, da die meisten Systeme für die englische Textanalyse optimiert sind. Es gibt zwar fortschrittliche Detektoren mit mehrsprachigen Funktionen, aber ihre Leistung nimmt ab, wenn sie Sprachen analysieren, für die nicht genügend Trainingsdaten vorliegen oder die besondere grammatikalische Muster aufweisen. Die sprachspezifische Genauigkeit variiert erheblich - Erkennungstools könnten bei der Analyse auf Spanisch hervorragende Ergebnisse liefern, aber bei japanischen Texten versagen, was gezielte Erkennungsstrategien für jede Sprachanwendung entscheidend macht. Wie funktioniert mehrsprachige KI-Erkennung? Die Erkennung von KI-generiertem Inhalt über verschiedene Sprachen hinweg nutzt sprachübergreifende Einbettungen und Machine-Learning-Algorithmen, um synthetischen Text zu identifizieren. Diese Systeme vergleichen Muster mit menschlichem Schreiben und mehrsprachigen Eingaben, indem sie sprachspezifische Strukturen analysieren. Wichtige Herausforderungen bei der Erkennung sind: - Sprachstruktur und kulturelle Nuancen beeinflussen die Erkennungsgenauigkeit - Tools analysieren Schreibmuster über Sprachen hinweg in Echtzeit - Natural Language Processing identifiziert Variationen in der Textzusammensetzung - Datenqualität bestimmt die Effektivität, besonders bei selteneren Sprachen - Algorithmen passen sich kontinuierlich an neue KI-Schreibfähigkeiten an Aktuelle Erkennungssysteme funktionieren am besten als Teil umfassender Verifizierungsstrategien, die mehrere Authentifizierungsmethoden und Kontextanalysen kombinieren. Welche Tools bieten mehrsprachige Unterstützung? GPTZero und Originality.ai führen den Markt für KI-Erkennung mit umfassenden mehrsprachigen Funktionen und fortschrittlicher sprachübergreifender Analyse an. Diese Plattformen sind entscheidend für die Überprüfung von Inhalten in mehreren Sprachen und passen ihre Erkennungssysteme effektiv an, um einzigartige sprachliche Muster in nicht-englischen Texten zu verarbeiten. Die KI-Erkennungstechnologie hat sich zusammen mit ChatGPT und ähnlichen Schreibwerkzeugen weiterentwickelt. Moderne Sprachmodelle können KI-generierte Texte in verschiedenen Sprachen identifizieren, obwohl die Genauigkeit der Erkennung je nach Sprache variiert. Jede Plattform glänzt bei bestimmten Sprachkombinationen, weshalb es wichtig ist, Tools auszuwählen, die ihre mehrsprachigen Algorithmen aktiv pflegen und breite Sprachunterstützung fördern. Wie beeinflusst Sprache die Genauigkeit der Erkennung? Die Genauigkeit der KI-Texterkennung variiert stark zwischen verschiedenen Sprachen. Read the full article

0 notes

Text

Elementor Ally – Web-Accessibility-Plugin

Elementor Ally verspricht umfassende Web-Accessibility-Lösungen, bleibt aber in wichtigen Bereichen hinter den Erwartungen zurück und liefert unzuverlässige Scan-Ergebnisse und übersieht wesentliche WCAG-Verstöße. Während das Plugin grundlegende Funktionen wie automatisierte Überprüfungen und Compliance-Tools innerhalb der Elementor-Oberfläche bietet, schaffen seine oberflächliche Analyse und Probleme mit dynamischen Inhalten erhebliche Hürden für die Erreichung echter Barrierefreiheitsstandards. Die Einschränkungen bei der KI-gestützten Erkennung, zusammen mit Support-Problemen und unklarer Preisgestaltung, deuten darauf hin, dass Website-Betreiber den vollen Umfang der Möglichkeiten und Nachteile dieses Tools verstehen müssen.

Die wichtigsten Punkte

- Elementor Ally integriert einen Zugänglichkeits-Checker, der Websites scannt und WCAG-Konformitätsprobleme innerhalb der Elementor-Oberfläche identifiziert. - Das Plugin verfügt über automatisierte Tools zur Erkennung problematischer Elemente wie Überschriftenstrukturen und fehlende Alt-Texte für Bilder. - Benutzerdefinierte Tastatursteuerung und visuelle Fokusindikatoren verbessern die Navigation für Benutzer, die auf Hilfstechnologien angewiesen sind. - Das Tool generiert automatisierte Compliance-Berichte, die WCAG 2.1, Section 508 und ADA Title III-Anforderungen behandeln. - Zu den Leistungseinschränkungen gehören unzuverlässige Scan-Ergebnisse, Schwierigkeiten mit dynamischen Inhalten und fehlende KI-gesteuerte Fehlererkennung.

Verständnis von Web-Zugänglichkeitsstandards und -Anforderungen

In Bezug auf Webzugänglichkeitsstandards und -anforderungen sehen sich Website-Betreiber einem zunehmend komplexen Umfeld von Vorschriften, Richtlinien und technischen Spezifikationen gegenüber, die sorgfältig beachtet werden müssen. Das Streben nach digitaler Gleichberechtigung hat ein kompliziertes Geflecht von staatlichen Vorschriften und Webstandards geschaffen, die eine akribische Beachtung benutzerfreundlichen Designs und inklusiver Inhalte erfordern. Website-Betreiber müssen sich durch detaillierte Zugänglichkeitstestprotokolle bewegen und dabei die nahtlose Integration mit unterstützender Technologie sicherstellen. Der Fokus auf Benutzererfahrung geht über die grundlegende Compliance hinaus und erfordert die durchdachte Implementierung von Funktionen, die unterschiedlichen Benutzerbedürfnissen gerecht werden. Dieses anspruchsvolle Anforderungsumfeld fordert Entwickler heraus, Lösungen zu schaffen, die sowohl Zugänglichkeit als auch Funktionalität der Website gewährleisten und technische Belastungen trotz des erheblichen Aufwands in Chancen für eine breitere digitale Inklusion verwandeln.

Hauptmerkmale von Elementor Ally

Der in Elementor Ally integrierte Zugänglichkeitsprüfer scannt Websites gründlich, hebt potenzielle Compliance-Probleme hervor und gibt spezifische Verbesserungsempfehlungen. Die WCAG-Compliance-Tools des Plugins erkennen automatisch problematische Elemente, einschließlich fehlerhafter Überschriftenstrukturen, fehlender Alt-Texte und unzureichender Farbkontrastverhältnisse, die die Zugänglichkeit beeinträchtigen könnten. Diese robusten Funktionen arbeiten nahtlos innerhalb der Elementor-Oberfläche und ermöglichen es Entwicklern und Content-Erstellern, Zugänglichkeitsprobleme effizient zu beheben und dabei die Design-Integrität ihrer Website zu bewahren. Funktionen der Barrierefreiheitsprüfung Die Barrierefreiheit-Prüffunktionen dieses Plugins erfüllen ihre Kernversprechen nicht und lassen Website-Ersteller ohne verlässliche Werkzeuge zur Verbesserung der Web-Barrierefreiheit. Trotz der Behauptung umfassender Scan-Fähigkeiten übersieht der Prüfer routinemäßig kritische WCAG-Verstöße und liefert inkonsistente Ergebnisse über verschiedene Seiten und Elemente hinweg. Die versprochenen Verbesserungen der Barrierefreiheitsprüfung bleiben hinter den Branchenstandards zurück, bieten begrenzte Nutzererfahrungsperspektiven und erzeugen häufig Falschmeldungen, die die Zeit der Entwickler verschwenden. Die Unfähigkeit des Tools, dynamische Inhalte, benutzerdefinierte Widgets und komplexe Layouts richtig zu analysieren, macht es für professionelle Webentwicklungsanforderungen ungeeignet. Während grundlegende Barrierefreiheitsprobleme möglicherweise gekennzeichnet werden, erschweren die oberflächliche Analyse und der unzuverlässige Berichtsmechanismus des Prüfers es Website-Betreibern, bedeutsame Verbesserungen der Barrierefreiheit umzusetzen, wodurch ihre Websites möglicherweise anfällig für Compliance-Probleme und Bedenken hinsichtlich der Benutzerbarrierefreiheit bleiben. WCAG-Konformitätswerkzeuge Die grundlegenden WCAG-Compliance-Tools in diesem Plugin weisen erhebliche Mängel auf und erfüllen nicht einmal grundlegende Barrierefreiheitsanforderungen für moderne Websites. Benutzer stehen vor anhaltenden Zugänglichkeitsproblemen bei der Umsetzung inklusiver Designprinzipien, da dem Plugin wesentliche Funktionalitäten für WCAG 2.1-Standards fehlen. FunktionStatusFarbkontrastFunktioniertAlt-Text-ValidierungUnvollständigTastaturnavigationEingeschränktARIA-LabelsFehlend Die Mängel des Plugins bei der Behandlung grundlegender Barrierefreiheitsanforderungen schaffen Hindernisse für Website-Betreiber, die Compliance anstreben. Wichtige Funktionen wie automatisierte Barrierefreiheitsprüfung, Echtzeit-Validierung und umfassende Berichtswerkzeuge fehlen deutlich. Diese Einschränkungen zwingen Benutzer dazu, zusätzliche Lösungen zu suchen, was den Hauptzweck des Plugins, die Implementierung von Barrierefreiheit und Compliance-Überwachung zu vereinfachen, untergräbt.

Echtzeit-Barrierefreiheit-Analyse

Trotz Behauptungen über Echtzeit-Scan-Funktionen bietet Elementor Ally keine tatsächliche kontinuierliche Barrierefreiheits-Überwachung während der Website-Entwicklung und lässt Nutzer ohne wesentliches sofortiges Feedback zurück. Diese Einschränkung zwingt Entwickler dazu, sich auf manuelle Überprüfungen oder Tools von Drittanbietern zu verlassen, um die Einhaltung der Barrierefreiheit zu überprüfen, was den Entwicklungsprozess erheblich verlangsamt. Das Fehlen von Echtzeit-Feedback schafft unnötige Hindernisse für Webfachleute, die ein sofortiges Verständnis von Barrierefreiheitsproblemen benötigen. Ohne kontinuierliche Überwachung müssen Entwickler nach jeder Änderung wiederholt separate Scans durchführen, was sich als ineffizient und frustrierend erweist. Diese Arbeitsablaufunterbrechung könnte dazu führen, dass Barrierefreiheitsprobleme übersehen oder zu spät im Entwicklungszyklus entdeckt werden, was möglicherweise zu kostspieligen Korrekturen und Compliance-Problemen führt, die mit einer ordnungsgemäßen Echtzeit-Scan-Funktionalität hätten verhindert werden können.

Automatische Problemerkennung und -behebung

Elementor Ally's automatische Scan-Technologie untersucht Websites gründlich auf Barrierefreiheitsprobleme und identifiziert systematisch Probleme, die Nutzer mit Behinderungen betreffen könnten. Das KI-gestützte Erkennungssystem des Plugins markiert alles, von fehlendem Alt-Text bis hin zu fehlerhaften Überschriftenstrukturen, und erstellt einen umfassenden Bericht über Verstöße gegen die Barrierefreiheit, die behoben werden müssen. Durch seine intelligente Automatisierung optimiert das Plugin den Lösungsprozess, indem es spezifische Korrekturen vorschlägt und, wo möglich, Verbesserungen automatisch implementiert, um eine schnellere Compliance zu gewährleisten. Webseiten nach Problemen scannen Während automatische Scan-Funktionen üblicherweise in Accessibility-Plugins erwartet werden, bietet das Elementor Ally Plugin derzeit keine automatisierte Problemerkennung oder Schnellkorrektur-Funktionen. Diese Einschränkung beeinflusst den Website-Analyseprozess und die allgemeine Benutzerfreundlichkeit, da eine manuelle Überprüfung von Barrierefreiheitsproblemen erforderlich ist. Für diejenigen, die automatisierte Scan-Funktionen suchen, gibt es folgende alternative Ansätze: - Implementierung von Barrierefreiheit-Scanning-Tools von Drittanbietern zur Identifizierung möglicher WCAG-Verstöße - Nutzung von Browser-Erweiterungen, die speziell für Barrierefreiheit-Tests und Validierung entwickelt wurden - Integration eigenständiger Website-Analysedienste, die umfassende Barrierefreiheit-Berichte liefern - Einsatz kombinierter Entwicklungstools mit Funktionen zur Überprüfung der Barrierefreiheit Das Fehlen integrierter Scan-Funktionen bedeutet, dass Website-Betreiber zusätzliche Schritte unternehmen müssen, um sicherzustellen, dass ihre Websites die Barrierefreiheit-Standards erfüllen, was zu einem zeitaufwändigeren und möglicherweise frustrierenden Arbeitsablauf für die Einhaltung der Barrierefreiheit führt. Schneller Problemlösungsprozess Das Fehlen der automatisierten Problemerkennung führt zwangsläufig zu einem Mangel an Quick-Fix-Funktionen im Lösungsprozess. Ohne systematische Scanning-Mechanismen wird die Identifizierung und Behebung von Barrierefreiheitsproblemen zu einer manuellen, zeitaufwändigen Aufgabe, die stark von Usability-Tests und direktem Nutzerfeedback abhängt. Website-Administratoren müssen jedes potenzielle Barrierefreiheitsproblem einzeln untersuchen, was zu verlängerten Lösungszeiten und erhöhter Frustration sowohl bei Entwicklern als auch bei Endnutzern führt. Der manuelle Ansatz erzeugt Engpässe im Arbeitsablauf und zwingt Teams dazu, umfangreiche Ressourcen für die Behebung von Barrierefreiheitsproblemen aufzuwenden, die durch Automatisierung rationalisiert werden könnten. Dieser ineffiziente Prozess führt oft zu verzögerten Korrekturen, beeinträchtigten Nutzererfahrungen und potenziellen Compliance-Risiken. Das Fehlen von Quick-Fix-Lösungen wirkt sich besonders auf diejenigen aus, die sofortige Verbesserungen der Barrierefreiheit benötigen, was den kritischen Bedarf an effizienteren Lösungswerkzeugen unterstreicht. KI-gestützte Fehlererkennung Moderne KI-gestützte Fehlererkennung fehlt bei diesem Barrierefreiheit-Plugin auffallend, was zu erheblichen Lücken bei der automatisierten Problemerkennung und Lösungsfähigkeit führt. Ohne KI-gesteuerte Analyse stehen Websitebetreiber vor unnötigen Herausforderungen bei der Aufrechterhaltung der ADA-Konformität und optimalen Benutzererfahrung. Die Einschränkungen des Plugins werden durch mehrere kritische Mängel deutlich: - Keine Echtzeit-Scan-Funktionen zur Erkennung von Verstößen gegen die Barrierefreiheit bei Inhaltsänderungen - Fehlen von maschinellen Lernalgorithmen zur Vorhersage potenzieller Zugänglichkeitsprobleme, bevor sie Benutzer beeinträchtigen - Mangel an automatisierten Vorschlägen zur Verbesserung von Inhaltsstruktur und Navigationsmustern - Fehlende intelligente Analysewerkzeuge für Farbkontrast- und Lesbarkeitoptimierung Diese Mängel zwingen Benutzer dazu, sich auf manuelle Tests und grundlegende Scan-Tools zu verlassen, was den Zeit- und Arbeitsaufwand für die Wartung barrierefreier Websites erheblich erhöht. Die Effektivität des Plugins könnte sich durch die Implementierung KI-gesteuerter Erkennungssysteme drastisch verbessern.

Farbkontrast-Verbesserungswerkzeuge

Schlechter Farbkontrast zwischen Text und Hintergrundelementen schafft erhebliche Barrieren für Nutzer mit Sehbehinderungen und macht Inhalte schwer oder unmöglich effektiv zu lesen. Das Elementor Ally Plugin begegnet dieser Herausforderung durch die Integration robuster Farbkontrast-Verbesserungswerkzeuge, die automatisch Website-Farbschemata analysieren und anpassen, um Zugänglichkeitsstandards zu erfüllen. Die ausgefeilten Testmethoden des Plugins bewerten Farbkombinationen anhand der WCAG-Kontrastrichtlinien und gewährleisten so optimale Lesbarkeit für Nutzer mit Farbenblindheit und anderen Sehbehinderungen. Durch nahtlose Theme-Integration und umfangreiche Anpassungsoptionen können Entwickler barrierefreie Farbpaletten implementieren und dabei Designprinzipien beibehalten, die das gesamte Nutzererlebnis verbessern. Das System markiert problematische Farbkombinationen und schlägt Alternativen vor, wodurch Website-Ersteller fundierte Entscheidungen über ihre Designauswahl treffen können, ohne ästhetische Attraktivität oder Zugänglichkeitsanforderungen zu beeinträchtigen.

Alt-Text-Verwaltungssystem

Das Alt-Text-Management-System in Elementor Ally bewältigt die zeitaufwändige Aufgabe der Bildzugänglichkeit durch seine fortschrittlichen automatisierten Alt-Text-Generierungsfunktionen. Website-Betreiber können Hunderte von Bildern effizient über die Mehrfachbearbeitungsfunktion verwalten, die gleichzeitige Alt-Tag-Aktualisierungen über mehrere Seiten und Beiträge hinweg ermöglicht. Der integrierte Compliance-Checker überwacht aktiv die Alt-Text-Implementierung, markiert fehlende oder unzureichende Beschreibungen und liefert spezifische Empfehlungen zur Erfüllung der WCAG-Zugänglichkeitsstandards. Automatische Alt-Text-Generierung Trotz der Behauptungen über automatisierte Intelligenz scheitert das Alt-Text-Generierungssystem von Elementor Ally konsequent daran, genaue oder aussagekräftige Bildbeschreibungen zu erstellen, wodurch Website-Betreiber mit unzuverlässigen und potenziell irreführenden Barrierefreiheitsfunktionen zurückbleiben. Die Mängel des Systems widersprechen etablierten Alt-Text-Best-Practices und schaffen Barrieren für Nutzer, die auf Screenreader angewiesen sind. Die Hauptprobleme mit den automatisierten Bildbeschreibungen umfassen: - Häufige Fehlidentifikation von wichtigen Bildelementen und Kontext - Generische, vorlagenbasierte Beschreibungen, denen es an notwendigen Details mangelt - Unfähigkeit, nuancierte oder technische Inhalte genau zu erfassen - Vollständiges Versagen bei der Verarbeitung komplexer Grafiken oder Infografiken Website-Betreiber müssen diese automatisch generierten Beschreibungen manuell überprüfen und korrigieren, was den Zweck der Automatisierung zunichtemacht und den Arbeitsaufwand für die Pflege barrierefreier Inhalte erhöht. Dieser grundlegende Mangel untergräbt das Kernversprechen des Plugins zur Vereinfachung der Barrierefreiheit-Implementierung. Stapelbearbeitung von Alt-Tags Verzweifelte Website-Administratoren sehen sich mit wachsender Frustration über das Batch-Bearbeitungssystem von Elementor Ally für Alt-Tags konfrontiert, das regelmäßig während Massenvorgängen abstürzt und Änderungen nicht zuverlässig speichert. Trotz der kritischen Bedeutung von Alt-Text für die Barrierefreiheit berichten Benutzer von anhaltenden Problemen bei dem Versuch, mehrere Bilder gleichzeitig zu modifizieren, was zu verlorener Arbeit und verschwendeter Zeit führt. Die Unfähigkeit des Systems, umfangreiche Bearbeitungen zu bewältigen, zwingt Administratoren dazu, auf mühsame manuelle Aktualisierungen zurückzugreifen, was die Benutzererfahrung und Arbeitseffizienz stark beeinträchtigt. Während Elementor Ally seine Batch-Bearbeitungsfunktionen als zeitsparende Funktion bewirbt, bleibt die Realität hinter den Erwartungen zurück und lässt Website-Manager nach alternativen Lösungen suchen. Die technischen Einschränkungen der Plattform schaffen unnötige Hindernisse für diejenigen, die sich der Pflege von barrierefreien Inhalten verschrieben haben, und unterstreichen den dringenden Bedarf an wesentlichen Verbesserungen der Batch-Bearbeitungsfunktionalität. Alt-Text-Konformitätsprüfer Zahlreiche Website-Administratoren berichten von erheblichen Problemen mit dem Alt-Text-Compliance-Checker von Elementor Ally, der häufig konforme Alt-Text-Beschreibungen falsch identifiziert und während der Zugänglichkeitsprüfungen falsch-positive Fehler generiert. Read the full article

#adatitleiii#alt-textefürbilder#automatisierteüberprüfungen#barrierefreiheit-plugin#compliance-tools#dynamischeinhalte#elementorally#ki-gestützteerkennung#section508#tastatursteuerung#unzuverlässigescan-ergebnisse#visuellefokusindikatoren#wcag-konformität#web-accessibility#webzugänglichkeitsstandards

0 notes

Text

Forensische Untersuchung von Duplicate Content

Die forensische Untersuchung von duplicate content ist entscheidend zum Schutz von geistigem Eigentum durch die Identifizierung von Plagiaten und Bestätigung der Authentizität von Inhalten . Sie dient als kritischer Prozess zur Aufrechterhaltung ethischer Standards und zur Verteidigung der Rechte von Inhaltserstellern. Sie liefert nicht nur konkrete Beweise zur Unterstützung von Ansprüchen auf ursprüngliche Autorschaft und Eigentum, sondern legt auch eine solide Grundlage für rechtliche Schritte, falls erforderlich. Indem man sich in die Tiefe des duplicate content begibt, können Personen ihre Arbeit vor möglichen rechtlichen Konsequenzen schützen und sicherstellen, dass ihre kreativen Rechte respektiert werden.

Forensische Untersuchung bestimmt die Originalität und Eigentumsrechte von Inhalten.

Identifiziert Fälle von Plagiat und Diebstahl geistigen Eigentums.

Unterstützt rechtliche Schritte mit konkreten Beweisen.

Hilft bei der Wahrung ethischer Standards und dem Schutz der Rechte von Schöpfern.

Gewährleistet Authentizität und verhindert unbefugte Nutzung von Materialien.

Die Notwendigkeit einer forensischen Untersuchung

Die forensische Untersuchung von doppeltem Inhalt ist entscheidend, um Fälle von Plagiat und geistigem Eigentumsdiebstahl in digitalen Umgebungen zu identifizieren. Die Sicherstellung der Authentizität von Inhalten ist wichtig, um ethische Standards aufrechtzuerhalten und die Rechte von Inhaltserstellern zu schützen. Wenn doppelter Inhalt erkannt wird, können erhebliche rechtliche Konsequenzen entstehen.

Aus rechtlicher Sicht können Plagiat und geistiger Eigentumsdiebstahl zu schwerwiegenden Folgen führen, einschließlich Klagen, Geldstrafen und beschädigten Ruf. Durch forensische Untersuchungen von doppeltem Inhalt können Einzelpersonen und Organisationen konkrete Beweise sammeln, um ihre Ansprüche auf ursprüngliche Autorenschaft und Eigentum zu unterstützen. Dieser Prozess hilft, eine solide Grundlage für rechtliche Schritte zu schaffen, wenn erforderlich.

Darüber hinaus ist es im digitalen Zeitalter, in dem Informationen leicht repliziert und verbreitet werden können, erforderlich, die Authentizität des eigenen Inhalts zum Schutz der geistigen Eigentumsrechte zu belegen. Durch forensische Analyse können Inkonsistenzen und Ähnlichkeiten zwischen verschiedenen Inhalten identifiziert werden, was dazu beiträgt, die Rechte von Inhaltserstellern zu bewahren und potenzielle Plagiatoren abzuschrecken.

Identifizierung von doppelten Inhaltsquellen

Die effiziente Identifizierung von doppelten Inhalten ist wichtig für die Inhaltsanalyse und den Schutz des geistigen Eigentums in digitalen Umgebungen. Inhaltsvergleichs- und Quellenerkennungstools spielen dabei eine bedeutende Rolle, indem sie die Erkennung von doppelten Inhalten über verschiedene Online-Plattformen hinweg ermöglichen. Diese Tools nutzen sophistizierte Algorithmen , um Texte, Bilder oder Multimedia-Dateien zu vergleichen und Ähnlichkeiten zwischen verschiedenen Quellen herauszuarbeiten.

Die Duplikaterkennung ist nicht nur wichtig, um die Originalität zu wahren, sondern auch um die Echtheit von Inhalten zu überprüfen. Durch die Identifizierung von doppelten Inhalten können Einzelpersonen und Organisationen ihre geistigen Eigentumsrechte schützen und unbefugte Nutzung ihrer Materialien verhindern. Originalitätsprüfung ist ein wichtiger Bestandteil, um sicherzustellen, dass Inhaltschaffende angemessene Anerkennung für ihre Arbeit erhalten und Plagiate effektiv abgeschreckt werden.

Auswirkungen auf die SEO-Leistung

Die Identifizierung von doppeltem Inhalt kann sich erheblich auf die SEO-Performance einer Website auswirken. Die Duplizierung von Inhalten kann schwerwiegende Folgen für das SEO-Ranking einer Website und die allgemeine Sichtbarkeit in Suchmaschinen haben. Wenn Suchmaschinen auf identische oder sehr ähnliche Inhalte auf mehreren Webseiten stoßen, haben sie Schwierigkeiten zu bestimmen, welche Seite in den Suchergebnissen höher gerankt werden soll. Diese Verwirrung kann zu niedrigeren Rankings für alle Versionen des duplizierten Inhalts führen und letztendlich den organischen Datenverkehr, den die Website erhält, reduzieren.

Um die Auswirkungen von doppeltem Inhalt auf die SEO-Performance klarer zu verstehen, betrachten Sie die folgende Tabelle: Aspekt Auswirkung SEO-Rankings Abnahme aufgrund von verdünnter Inhaltsautorität Organischer Datenverkehr Reduzierung der Sichtbarkeit und Klickraten Nutzererfahrung Verwirrung und potenzieller Verlust von Vertrauen Backlink-Qualität Verdünnung des Backlink-Werts Strafandrohungsrisiko Erhöhte Wahrscheinlichkeit von Suchmaschinenstrafen

Die zeitnahe Behebung von Problemen mit doppeltem Inhalt und die Umsetzung von Strategien zur Gewährleistung der Einzigartigkeit des Inhalts sind entscheidend, um eine starke SEO-Performance aufrechtzuerhalten und die Online-Sichtbarkeit zu maximieren.

Werkzeuge für Inhaltsanalyse

Wie können Website-Besitzer ihre Inhalte effektiv auf Duplikate analysieren, indem sie spezialisierte Tools verwenden? Eine gründliche Inhaltsanalyse ist entscheidend, um Duplikat-Inhaltsprobleme zu identifizieren. Um diesen Prozess zu unterstützen, können Website-Besitzer verschiedene Tools zur Keyword-Analyse und Inhaltsvergleichung nutzen. Hier sind drei wesentliche Tools für die Inhaltsanalyse:

Siteliner : Dieses Tool scannt die Website nach doppelten Inhalten, defekten Links und Seitenladegeschwindigkeit und liefert einen detaillierten Bericht über Inhaltsprobleme, die Aufmerksamkeit erfordern.

Copyscape : Mit Copyscape können Website-Besitzer Plagiate überprüfen, indem sie ihre Inhalte mit vorhandenen Online-Inhalten vergleichen, um Ähnlichkeiten zu identifizieren.

Screaming Frog SEO Spider : Dieses Tool durchsucht Websites, um Seitentitel, Meta-Beschreibungen und andere Elemente auf Duplikate zu analysieren und Einblicke in Bereiche zu bieten, die optimiert werden müssen.

Aufdecken von Plagiaten und Scraping

Um Plagiatismus und Scraping effektiv bekämpfen zu können, müssen Website-Besitzer robuste Erkennungsmethoden und -werkzeuge einsetzen. Plagiaterkennungssoftware spielt eine entscheidende Rolle bei der Identifizierung von Urheberrechtsverletzungen im Internet. Sie durchsucht Inhalte auf Websites, um Ähnlichkeiten aufzudecken, die auf unbefugte Duplikation hinweisen. Content-Scraping, auch als Inhaltsdiebstahl bekannt, beinhaltet das Extrahieren von Informationen von einer Website ohne Erlaubnis und das erneute Veröffentlichen an anderer Stelle. Diese unethische Praxis untergräbt nicht nur die Arbeit des Originalerstellers, sondern kann auch die Suchmaschinenplatzierungen und die Glaubwürdigkeit der Website beeinträchtigen.

Website-Besitzer können spezialisierte Tools nutzen, die ihren Inhalt mit einer umfangreichen Datenbank von Online-Material vergleichen, um Plagiatsfälle aufzudecken. Durch regelmäßige Überwachung ihrer Webpräsenz und gründliche Überprüfungen mithilfe dieser Tools können sie ihr geistiges Eigentum schützen und angemessene Maßnahmen gegen Urheberrechtsverletzungen ergreifen. Die Implementierung strenger Richtlinien gegen Plagiatismus und Content-Scraping ist notwendig, um ethische Standards aufrechtzuerhalten und die Integrität von Online-Inhalten zu schützen.

Empfehlungen zur Minderung

Effektive Maßnahmen zur Minderung sind unerlässlich, um Online-Inhalte vor Plagiaten und Scraping zu schützen. Um die Inhaltswiederholung zu verhindern und sich an die besten SEO-Praktiken zu halten, sollten Sie die folgenden Empfehlungen in Betracht ziehen:

Inhalte regelmäßig überwachen : Implementieren Sie Tools, die das Web nach doppelten Inhalten durchsuchen, um potenzielle Fälle von Plagiaten oder Scraping schnell zu identifizieren.

Verwenden Sie einzigartige Inhalte : Erstellen Sie hochwertige, originelle Inhalte, die den Lesern einen Mehrwert bieten und weniger wahrscheinlich von anderen dupliziert oder gescraped werden.

Urheberrechtsschutz implementieren : Zeigen Sie klare Urheberrechtsvermerke auf Ihrer Website an und erwägen Sie, Ihre Inhalte bei den entsprechenden Behörden zu registrieren, um den rechtlichen Schutz vor unbefugter Nutzung zu stärken.

Gewährleistung der Inhaltsintegrität

Die Integrität von Online-Inhalten zu wahren, ist fundamental für die Etablierung von Glaubwürdigkeit und Vertrauen bei Lesern und Suchmaschinen gleichermaßen. Die Überprüfung von Inhalten und die Validierung der Authentizität sind entscheidende Prozesse, um sicherzustellen, dass die präsentierte Information original und zuverlässig ist. Die Überprüfung von Inhalten beinhaltet die Bestätigung, dass der Inhalt nicht von anderen Quellen repliziert wurde, während die Validierung der Authentizität sicherstellt, dass der Inhalt korrekt und vertrauenswürdig ist.

Um die Integrität von Inhalten zu wahren, wird empfohlen, Tools wie Plagiatsprüfer zu verwenden, um die Einzigartigkeit des Inhalts zu überprüfen. Darüber hinaus können die Implementierung angemessener Zitierpraktiken und das Referenzieren von Quellen dabei helfen, die Authentizität der bereitgestellten Informationen zu etablieren. Das regelmäßige Aktualisieren und Überprüfen von Inhalten spielt ebenfalls eine bedeutende Rolle, um deren Integrität im Laufe der Zeit zu gewährleisten.

Über den Autor: Ralf Seybold — Agentur für Sichtbarkeit

Ralf Seybold ist der Gründer und Geschäftsführer der Agentur für Sichtbarkeit, die sich auf Online-Marketing und Suchmaschinenoptimierung (SEO) spezialisiert hat. Mit seiner langjährigen Erfahrung und umfassenden Expertise hilft er Unternehmen dabei, ihre digitale Präsenz zu optimieren und in der Online-Welt sichtbar zu werden. Auf seiner Webseite seybold.de bietet Ralf Seybold fundierte Einblicke in aktuelle SEO-Trends und maßgeschneiderte Strategien zur Steigerung der Sichtbarkeit im Netz. Sein ganzheitlicher Ansatz und seine Innovationskraft machen ihn zu einem gefragten Experten in der Branche. Darüber hinaus veröffentlicht er regelmäßig Fachbeiträge auf intuitives-wissen.de, in denen er vertiefte Einblicke und praxisnahe Tipps zu den neuesten Entwicklungen im Bereich SEO und Online-Marketing gibt. Hier finden sich weitere Informationen zu seiner Person, wie Fachvorträge, Social Media Accounts, Berufserfahrung, Auszeichnungen und Zertifizierungen, Engagements, Vorträge und Veröffentlichungen.

#DuplicateContent#SEO#ContentForensics#ContentAnalyse#SEOOptimierung#GoogleRanking#Plagiatsprüfung#DuplicateCheck#ContentAudit#ContentMarketing#SEOForensik#OnlineMarketing#WebAnalytics#ContentStrategie#Suchmaschinenoptimierung#SEOAnalyse

0 notes

Text

Deep Neural Networks (DNNs) sind eine Art von künstlichen neuronalen Netzwerken (ANNs), die aus mehreren Schichten von Neuronen bestehen und darauf spezialisiert sind, komplexe Muster und Abstraktionen in Daten zu erkennen. Sie bilden die Grundlage vieler moderner Anwendungen der Künstlichen Intelligenz, insbesondere im Bereich des Deep Learning.

1. Grundstruktur eines Neuronalen Netzwerks

Ein neuronales Netzwerk ist inspiriert von der Funktionsweise biologischer Gehirne. Es besteht aus einer großen Anzahl von miteinander verbundenen “Neuronen”, die in Schichten organisiert sind:

• Eingabeschicht (Input Layer): Diese Schicht nimmt die Daten aus der Außenwelt auf, z. B. Pixelwerte eines Bildes oder Wörter eines Satzes.

• Verborgene Schichten (Hidden Layers): Hier findet die eigentliche Verarbeitung und Abstraktion statt. Jede Schicht transformiert die Daten, bevor sie sie an die nächste weitergibt.

• Ausgabeschicht (Output Layer): Die Ergebnisse der Verarbeitung werden hier ausgegeben, z. B. eine Klassifikation (Hund oder Katze?) oder eine Wahrscheinlichkeit.

2. Was macht ein DNN „Deep“?

Ein Netzwerk gilt als „Deep“, wenn es mehrere versteckte Schichten enthält.

• Jede zusätzliche Schicht erlaubt dem Netzwerk, komplexere Muster und Zusammenhänge in den Daten zu erkennen.

• Während ein einfaches neuronales Netzwerk (z. B. mit einer Schicht) nur grundlegende Beziehungen modellieren kann, ermöglicht die Tiefe eines DNN die Erkennung von hierarchischen Mustern.

3. Wie funktionieren DNNs?

Der Kern eines DNNs besteht aus den folgenden Komponenten:

a) Neuronen und Gewichte

• Jedes Neuron in einer Schicht empfängt Eingaben aus der vorherigen Schicht.

• Diese Eingaben werden mit Gewichten (Weights) multipliziert, die die Bedeutung dieser Eingaben bestimmen.

• Das Ergebnis wird aufsummiert und durch eine Aktivierungsfunktion (Activation Function) geschickt, die entscheidet, ob das Neuron „feuert“ (aktiviert wird).

b) Vorwärtspropagation

• Daten fließen von der Eingabeschicht durch die verborgenen Schichten bis zur Ausgabeschicht. Jede Schicht transformiert die Daten weiter.

c) Fehlerberechnung

• Das Netzwerk berechnet den Fehler zwischen der vorhergesagten Ausgabe und der tatsächlichen Zielausgabe (z. B. mithilfe von Loss-Funktionen).

d) Rückwärtspropagation (Backpropagation)

• Der Fehler wird zurück durch das Netzwerk propagiert, um die Gewichte der Verbindungen zu aktualisieren.

• Ziel: Die Gewichte so anzupassen, dass der Fehler bei der nächsten Iteration kleiner wird. Dies geschieht durch einen Algorithmus namens Gradientenabstieg (Gradient Descent).

4. Hierarchische Merkmalsverarbeitung

Ein zentraler Vorteil von DNNs ist ihre Fähigkeit, hierarchische Muster zu lernen:

• Niedrige Schichten: Lernen einfache Merkmale wie Kanten, Linien oder Farben.

• Mittlere Schichten: Erkennen Kombinationen dieser Merkmale, z. B. Formen oder Texturen.

• Höhere Schichten: Erfassen abstrakte Konzepte wie Gesichter, Objekte oder Bedeutungen.

5. Aktivierungsfunktionen

Aktivierungsfunktionen führen Nichtlinearitäten ein, damit das Netzwerk komplexe Zusammenhänge modellieren kann. Häufige Funktionen:

• ReLU (Rectified Linear Unit): Setzt alle negativen Werte auf 0, behält positive Werte bei.

• Sigmoid: Komprimiert Werte in den Bereich zwischen 0 und 1.

• Softmax: Wandelt Ausgabewerte in Wahrscheinlichkeiten um (z. B. für Klassifikationsprobleme).

6. Anwendungsbereiche

Deep Neural Networks werden in vielen Bereichen eingesetzt:

• Bildverarbeitung: Objekterkennung, Gesichtsidentifikation, medizinische Bildanalyse.

• Sprachverarbeitung: Übersetzung, Sprachgenerierung, Sentimentanalyse.

• Generative KI: Bilder generieren (z. B. DALL·E), Texte erstellen (z. B. GPT).

• Spiele: Entscheidungsfindung in komplexen Szenarien (z. B. AlphaGo).

7. Herausforderungen von DNNs

• Rechenleistung: Training von DNNs erfordert viel Hardware (GPUs, TPUs).

• Datenbedarf: Große Datenmengen sind notwendig, um gute Ergebnisse zu erzielen.

• Erklärbarkeit: DNNs sind oft als „Black Boxes“ schwer zu interpretieren.

• Überanpassung (Overfitting): Modelle können zu stark auf Trainingsdaten optimiert werden und verlieren die Fähigkeit zur Generalisierung.

DNNs sind mächtig, weil sie nicht nur Daten „bearbeiten“, sondern lernen, sie zu verstehen und Abstraktionen zu schaffen. Dadurch haben sie viele der bahnbrechenden Entwicklungen in der KI ermöglicht.

0 notes

Text

0 notes

Text

Foto: Markus Breig, KIT Mit neuen Funktionen wie automatischer Kapiteleinteilung und Zusammenfassungen bietet der Lecture Translator eine verbesserte Spracherkennung.

Automatische Spracherkennung und -übersetzung: Schnelleres Arbeiten und Lernen

Karlsruhe, 15.08.2024. Automatische Spracherkennungssysteme wie der Lecture Translator des Karlsruher Instituts für Technologie (KIT) können das Gesprochene in Vorträgen in Echtzeit in einen Text in mehreren Sprachen umwandeln. Damit verbessern solche Systeme den Zugang zu Informationen für Studierende mit Behinderungen und ausländische Studierende. Nun haben Forschende des KIT den Lecture Translator um neue Funktionen erweitert. Automatische Erkennung des Gesprochenen in mehreren Sprachen gleichzeitig, Textsegmentierung und Titelgenerierung in Echtzeit, Zusammenfassungen und Verlinkungen zu Fachbegriffen und Abfragen des Gehörten vereinfachen nun das Verstehen und effiziente Aufarbeiten von Vorlesungen.

„Mit der automatischen Simultanübersetzung des Lecture Translators haben wir gesprochene Vorträge einem internationalen Publikum nähergebracht. Dieses macht aber in der Regel nur 15 Prozent der Zuhörerschaft aus. Mit den neuen KI-Werkzeugen wollen wir nicht nur Sprach-, sondern auch Verständnisbarrieren abbauen“, sagt Alexander Waibel, Professor für Informatik am KIT. „Oft sind automatisch transkribierte Texte von gesprochener Sprache schwer zu lesen, da sie zu schnell fortlaufend ohne Absätze und Zwischenüberschriften als langer Text erscheinen – eben genau so, wie der Vortrag oder die Vorlesung mündlich vorgetragen wurde“. Auch die Aufarbeitung der Vorlesung sei mühsam, da man die Vorlesung nach Verständnislücken durchsuchen müsse, so Waibel. Bessere Übersicht in Dokumenten Die Weiterentwicklung des Lecture Translators schafft hier Abhilfe. Die Forschenden haben mehrere neue automatische Funktionen wie „Smart Chaptering“, Summarization“, „Q&A“ oder „Auto-Links“ entwickelt. Dabei verwandelt eine neuartige Künstliche Intelligenz (KI), die automatisch die Sprache erkennt, den gesprochenen Text in ein Transkript in mehreren Sprachen und identifiziert automatisch Absätze, Kapitelüberschriften sowie wichtige Kernpunkte. Darüber hinaus erstellt sie eine akustische Wiedergabe, bei der Nutzerinnen und Nutzer eine von 18 Sprachen auswählen können. Außerdem zeigt das Programm automatisch Links als Querverweise zu relevanten Quellen in Vorlesungsskripten oder Wikipedia an, mit deren Hilfe die Studierenden die Vorlesung besser aufarbeiten können. „Mit unseren neuen KI-Modellen können Gespräche und Vorlesungen besser strukturiert und sogar Videos in leicht navigierbare Kapitel eingeteilt werden“, so Waibel. Somit sei ein besseres Verständnis nicht nur während, sondern auch nach der Vorlesung möglich. Lecture Translator übersetzt in 18 Sprachen Die Arbeiten hat das Forschungsteam in den Lecture Translator integriert, mit dem am KIT Vorlesungen in Echtzeit automatisch transkribiert werden. Kapiteleinteilung, Titelgenerierung, Absatzgestaltung, Zusammenfassungen mit Verlinkungen – auch jeweils online und offline anwendbar – erweitern nun den Service des Lecture Translators und vereinfachen die Arbeit mit dem Material. Die Übersetzung erfolgt in 18 Sprachen. Konkrete Anwendungsmöglichkeiten findet die Technologie für Content Creator, Studierende, Lehrende und Podcaster, die ihre Audio- und Videoinhalte erstmals strukturieren können. „Nutzerinnen und Nutzer können effizienter durch Videos und Vorträge navigieren, relevante Abschnitte schneller finden und wichtige Kerninhalte kompakt und effizient erfassen – sie haben insgesamt eine viel bessere grobe Übersicht sowie schnelleren Zugriff auf die Details“, sagt Waibel. Die Forschung fand im Projekt „How is AI Changing Science?“ statt und wurde für vier Jahre von der Volkswagenstiftung gefördert. Projektbeteiligte waren neben dem KIT die Universität Bonn sowie die Universität Wien. (mr/ase) Als „Die Forschungsuniversität in der Helmholtz-Gemeinschaft“ schafft und vermittelt das KIT Wissen für Gesellschaft und Umwelt. Ziel ist es, zu den globalen Herausforderungen maßgebliche Beiträge in den Feldern Energie, Mobilität und Information zu leisten. Dazu arbeiten rund 10 000 Mitarbeiterinnen und Mitarbeiter auf einer breiten disziplinären Basis in Natur-, Ingenieur-, Wirtschafts- sowie Geistes- und Sozialwissenschaften zusammen. Seine 22 800 Studierenden bereitet das KIT durch ein forschungsorientiertes universitäres Studium auf verantwortungsvolle Aufgaben in Gesellschaft, Wirtschaft und Wissenschaft vor. Die Innovationstätigkeit am KIT schlägt die Brücke zwischen Erkenntnis und Anwendung zum gesellschaftlichen Nutzen, wirtschaftlichen Wohlstand und Erhalt unserer natürlichen Lebensgrundlagen. Das KIT ist eine der deutschen Exzellenzuniversitäten.

Weitere Informationen:

http://Details zum KIT-Zentrum Information · Systeme · Technologien: https://www.kcist.kit.edu/

0 notes

Text

audio in text umwandeln

Stimme im Text

SpeechFlow is a very useful feature that includes text-to-speech. Wir stützen uns auf fortschrittliche Big-Data-Modelle und bis zu 500,000 Stunden hierwachter Datenhosen, so dass SpeechFlow in der Sprache zu texten e ak tuelle SpeechFlow supporten die Transkription der 14 Sprachen, die SpeechFlow supporter. Provides online transcription and API integration for audio, video and YouTube links. The transcription results of speechflow support automatic punctuation, automatic segmentation and automatic detection of gewaltätigen contents. Die Transcriptionsergebnisse von Speechflow support automatic Zeichnesetzung, automatic Segmentierung und automatic Erkennung von gewaltätigen Inhalten.audio in text umwandeln

Speech to text is a complete extension and has very good features. Es ermöglicht die Transcription von gesprochenem Wort in schriftlichte Form. Depending on the situation, you can encounter different situations, listen to the wonderful sound and analyze them. Here are some steps to convert Audio to Text:

1.Wählen Sie eine Spracherkennungssoftware oder -plattform aus: Es gibt eine Varaust von Online-Plattformen und Softwareanwendungen, die Spracherkennungsdienste anbieten. See Google Speech to Text, IBM Watson Speech to Text, Rev und viele mehr.

Laden Sie die Audiodatei hoch: On the selected platform, you must upload the audio file you want to convert to text. Be aware that most platforms accept data format.

Choose the Zielsprache aus: Je nachdem, welche Sprache im Audio gesprochen wird, müssen Sie die corresponding Zielsprache aussachen. Manche Plattformen offers special models that offer the best models.audio in text umwandeln

Visit : https://speechflow.io/de/tools/transcribe-audio-to-text

0 notes

Text

Test-Erkennung unter macOS Ventura z.B. in der Fotos-App

Vom iPhone her kenne ich es jetzt schon geraume Zeit, dass man in der Fotos-App zum Beispiel in einem Screenshot mittels eines (erscheinenden) Buttons den Text dort markieren und weiter verwenden kann. Die Funktion ist praktisch, verwende ich aber am Smartphone tatsächlich nicht so oft. Nun hatte ich wieder einmal den Fall, dass ich an meinem Mac mit macOS Ventura 13.1 auch aus einem Screenshot…

View On WordPress

0 notes

Text

6. April 2023

Der Zyberlihoger überfordert die Transkriptionssoftware

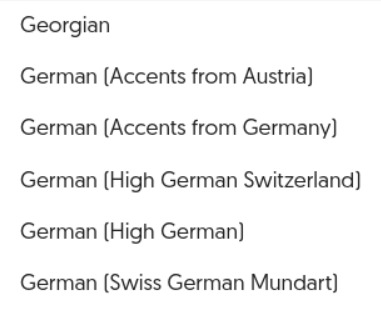

Als ich die WhatsApp-Sprachnachrichten von Alexander Krützfeldt transkribieren will, sehe ich, dass Amberscript neue Sprachoptionen bekommen hat:

Das hätte mir viel Arbeit gespart, denke ich, wenn der Fortschritt etwas schneller gewesen wäre, denn 2014 und 2015 habe ich viele Gespräche mit Schweizer*innen von Hand transkribiert. Das war einerseits mühsam, weil ich Schweizerdeutsch zwar besser verstehe, als Franziska Nyffenegger immer behauptet, aber auch nicht alles. Andererseits war es nicht mehr Arbeit als deutsche Transkription, weil, es tut mir leid, wenn ich an dieser Stelle Schweiz-Klischees bestätigen muss, viele Interviewte so angenehm langsam redeten, dass ich alles im selben Tempo abschreiben konnte, ohne in der Aufnahme zurückzuspringen.

Ich teste “Swiss German Mundart” mit Franziskas Hilfe. In ihrer ersten Sprachnachricht sagt sie ein paar Sätze auf Berndeutsch. Hier sind sie von mir transkribiert und in die hochdeutsche Form gebracht, weil Transkriptionssoftware ja auch nicht aufschreibt, was eigentlich gesagt wird. (Das würde ungefähr so aussehen: “Das ware jetz uf jede Fau aues Wörtli gsi, wo sie eigetlich müesst chönne versta.”) Der Schweizer Satzbau ist originalbelassen, denn auch dafür ist Transkriptionssoftware nicht zuständig. Ungefähr das hier würde ich also erwarten, wenn die Erkennung von “Swiss German Mundart” funktionieren würde:

“Ja hoi Kathrin, ich kann dir natürlich auch auf dem Kanal etwas draufschwätzen, ich hoffe, du bekommst das. Und jetzt hab ich den Faden verloren und weiß wäger meini* gar nicht, was ich dir soll sagen, damit's möglichst berndeutsch ist und damit deine Maschine das möglichst gar nicht kann transkribieren. Das wären jetzt auf jeden Fall alles Wörter gewesen, wo sie eigentlich müsste können verstehen. Jetzt hoff ich, dass es geklappt hat, du kannst das herunterladen und vertexten. Gut. Tschüs!”

* An dieser Stelle musste ich bei Franziska nachfragen. “Hochdeutsch in etwa: und jetzt weiss ich bei Gott nicht mehr, was ich dir sagen wollte. Wobei ‘bei Gott’ eigentlich wäre ‘bygoscht’. Kann ‘wäger meini’ nicht übersetzen grad. Wörterbuch sagt: wahrlich, gewiss.”

Aber Amberscript ist überfordert. Es lässt mehr als die Hälfte einfach weg und erfindet den Rest:

“Ja, ich hatte natürlich, dann ist schwarz. Ich hoffe, du uns das und jetzt verloren und weiß, was ich sage, damit möglichst bereich und damit man das möglichst transkribiere. Das war eigentlich erst das, das das versteht.“

Ich bekomme noch eine zweite Nachricht, in der Franziska Text von Jeremias Gotthelf vorliest. Die Amberscript-Version ist diesmal etwas besser als beim ersten Versuch, aber immer noch weit entfernt von ihren Fähigkeiten im Hochdeutschen. Meine manuellen Ergänzungen und Korrekturen des automatischen Ergebnisses sind fett markiert:

“Also Kathrin, hallo hallo. Ich tu dir jetzt etwas vorlesen, aus 'Anne Bäbi Jowäger' von Jeremias Gotthelf. Der erste Teil ist in 'High German Switzerland', und dann siehst du ja, wie's weitergeht. – So in halb trübem Wetter marschierte Jakobli fort, ordnete achtete sich der Landschaft nicht viel, wie der Lern Lewat errann, und was für Äpfel die Bäume hatten und die Hühner akkurat gleiche Schnebel Schnäbel wie bei ihnen, das sah er alles nicht. Aber hier und da versuchte er, ob einer Deutsch könnte könne, und fragte nach dem Ziel Zyberlihoger. Wenn ihnen ihn darauf die Leute wunderlich ansahen, so war der ward er rot, und wenn sie ihn fragen, was der ‘was wotsch dert?’, so sagte er, aparti nicht fehl viel, ich soll neue Verrichte her, ih soll neuis dert verrichte. ‘He nu, su schafft schaff de wohl,’ antworteten sie und zogen für Bass fürbass. Endlich hatte er vernommen, dass er nicht mehr als eine Stunde von seinem Ziele sei, kam so eben an einem internen Pintenschenk vorbei, fühlte Hunger und Durst, nahm sein Herz in beide Hände und trau trat zum ersten Mal in seinem Leben alleine in ein Wirtshaus. Dere Bursche, denen das im 19. Jahr begegnet, werden d’s Land auf und d’s Land ab und nicht vieles ein viele sein, nicht einmal machen manches Meitschi. Aber am Morgen hatte er wenig gegessen, und so hungrig an ein fremdes Ohr Ort zu kommen, das wusste er, schicke sich nicht, und Sammy Sami hatte ihm auch gesagt, wenn einer gegessen und getrunken hätte, so hätte er viel mehr Kuraschi. – Okay, jetzt bin ich gespannt, ob deine Maschine da irgendetwas versteht, und dann kannst du das subito fürs Techniktagebuch weiterverbrutzeln. Freue mich schon, das zu lesen. Tschüs!”

Das ist ungefähr der Stand von hochdeutscher Transkription im Jahr 2017. Es dauert also wohl noch mal ein paar Jahre, bis Amberscript seine Schweizversprechen wirklich einlösen kann.

(Kathrin Passig / Franziska Nyffenegger)

4 notes

·

View notes

Text

Die Entwicklung der KI-Texterstellung reichte von ELIZAs einfachen Antworten bis zu fortgeschrittenen Sprachmodellen. Moderne Werkzeuge wie ZimmWriter erzeugen durch KI professionelle Inhalte und verändern das digitale Schreiben. Diese schnelle Entwicklung deutet auf zukünftige Durchbrüche bei maschinell erstellten Texten hin. Die wichtigsten Erkenntnisse - KI-Texterstellung begann 1966 mit ELIZA, die durch einfache Mustererkennung und Antwortvorlagen menschliche Dialoge simulierte. - Die Transformer-Architektur revolutionierte die KI-Texterzeugung durch die Ermöglichung gleichzeitiger Analyse von Wortbeziehungen und kontextuellem Verständnis. - Vortrainierte Modelle wie GPT-3 und GPT-4 zeigen bedeutende Fortschritte bei der Erzeugung menschenähnlicher Texte in verschiedenen Anwendungsbereichen. - Moderne KI-Textgeneratoren integrieren Bias-Erkennung, ethische Überlegungen und vorlagenbasierte Systeme, um zuverlässige Ausgaben zu gewährleisten. - Der Markt soll bis 2029 ein Volumen von 1,1 Milliarden Dollar erreichen, angetrieben durch Innovationen von Unternehmen wie OpenAI und CopyAI. Von ELIZA zu modernen Wunderwerken: Eine Reise durch die Zeit Lassen Sie mich Sie zurück ins Jahr 1966 führen, als MITs Joseph Weizenbaum ELIZA erschuf - ein einfaches, aber revolutionäres Programm, das veränderte, wie wir mit Maschinen interagieren. Dieser frühe Chatbot spielte die Rolle eines Rogerianischen Psychotherapeuten und nutzte einfache Mustererkennung, um scheinbar bedeutungsvolle Gespräche zu führen. Man kann es als Urgroßeltern der heutigen KI-Assistenten betrachten, das uns den ersten Einblick in den Mensch-Maschine-Dialog gab. Die wahre Magie von ELIZA lag nicht nur in ihrer Programmierung - sondern darin, wie Menschen darauf reagierten. Benutzer entwickelten emotionale Verbindungen zum Programm und teilten persönliche Gedanken und Gefühle, obwohl sie wussten, dass es nur Programmcode war. Diese menschliche Neigung, Maschinen Verständnis und Empathie zuzuschreiben, wurde als "ELIZA-Effekt" bekannt, benannt nach diesem bahnbrechenden Programm. Sie erkennen dieses Phänomen heute wieder, wenn Menschen Beziehungen zu virtuellen Assistenten aufbauen, obwohl diese modernen Systeme trotz ihrer beeindruckenden Fähigkeiten grundsätzlich nur Muster verarbeiten, anstatt Bedeutung wirklich zu verstehen. Das Vermächtnis von ELIZA beeinflusst weiterhin die moderne Entwicklung und dient als wichtiger Referenzpunkt für die laufende Forschung in künstlicher Intelligenz und natürlicher Sprachverarbeitung. Die Technischen Durchbrüche Hinter der KI-Texterzeugung Lassen Sie uns die bemerkenswerte Technik hinter moderner KI-Textgenerierung erkunden - ein Zeugnis menschlichen Erfindungsreichtums, bei dem Linguistik auf höhere Mathematik und Informatik trifft. Die Transformer-Architektur markierte einen entscheidenden Moment, indem sie sich von der traditionellen sequentiellen Verarbeitung löste, um Beziehungen zwischen Wörtern simultan zu analysieren, ähnlich wie unser Gehirn Sprachmuster verarbeitet. Transfer Learning ermöglicht es diesen Modellen, sich schnell an spezialisierte Bereiche und Aufgaben anzupassen. Stellen Sie sich vortrainierte Modelle wie GPT-3 und GPT-4 als hochentwickelte Schreibassistenten vor, die Millionen von Texten studiert haben. Diese Modelle geben Entwicklern leistungsstarke Werkzeuge, um spezialisierte Anwendungen zu erstellen, ohne massive Rechenressourcen oder umfangreiche Datensätze zu benötigen. Durch die Integration fortschrittlicher Erkennungs- und Korrekturmechanismen für Voreingenommenheit erzeugen diese Systeme nun Texte, die sich natürlich anfühlen und dabei Fairness und Genauigkeit über verschiedene Themen und Perspektiven hinweg bewahren. Jüngste Fortschritte haben die Grenzen noch weiter verschoben, indem sie Textfähigkeiten mit visuellem und auditivem Verständnis verbinden. Diese modalitätsübergreifende Integration - die Fähigkeit, mehrere Arten von Informationen gleichzeitig zu verarbeiten - stellt einen bedeutenden Sprung nach vorne dar. KI kann jetzt Bilder "sehen", ihren Kontext "verstehen" und relevante Textbeschreibungen generieren, wodurch eine nahtlose Brücke zwischen verschiedenen Kommunikationsformen geschaffen wird. Marktführer prägen die KI-Schreiblandschaft Stellen Sie sich den KI-Textgenerierungsmarkt als eine aufregende Arena vor, in der Innovation auf Chancen trifft. Unternehmen wie OpenAI, CopyAI und INK stehen an vorderster Front und prägen die Art und Weise, wie wir Inhalte erstellen und personalisieren. Diese Pioniere haben unterschiedliche Ansätze entwickelt und verändern dadurch die Art und Weise, wie Unternehmen und Einzelpersonen durch künstliche Intelligenz kommunizieren. Der rasante Aufstieg von Text-zu-Text-Anwendungen zeigt den Fokus der Branche auf transformative Schreiblösungen. Die Landschaft entwickelt sich ständig weiter, während neue Wettbewerber auftreten. Jasper und Writesonic haben durch die Konzentration auf spezialisierte Content-Lösungen Erfolg gefunden und beweisen damit, dass gezielte Innovation nachhaltigen Wert schafft. Marktprognosen erzählen eine überzeugende Geschichte - die Branche wird bis 2029 1,1 Milliarden Dollar erreichen, was etablierte Akteure und Newcomer gleichermaßen dazu antreibt, strategische Allianzen zu schmieden und technologische Grenzen zu verschieben. Nordamerika führt zwar die Entwicklung an, aber behalten Sie die Region Asien-Pazifik im Auge, wo KI-Schreibtechnologien bemerkenswert an Dynamik gewinnen. Dieser intensive Wettbewerb treibt Fortschritte in der natürlichen Sprachverarbeitung (NLP) und dem maschinellen Lernen voran und schafft bessere Werkzeuge für Content-Ersteller, Vermarkter und Unternehmen weltweit. Praxisanwendungen, die Branchen transformieren Die KI-gestützte Textgenerierung hat die Arbeits- und Kommunikationsweise von Unternehmen grundlegend verändert. Studien zeigen, dass Unternehmen, die KI-Chatbots einsetzen, eine 30-prozentige Reduzierung der Kundenservicekosten bei gleichzeitiger 24/7-Verfügbarkeit verzeichnen. Diese Systeme bearbeiten täglich Millionen von Kundeninteraktionen in den Bereichen Einzelhandel, Gesundheitswesen und Finanzdienstleistungen. Kontinuierliche Modellverbesserungsprozesse stellen sicher, dass diese Systeme mit sich entwickelnden Kundenbedürfnissen und ethischen Standards im Einklang bleiben. Die kreative Landschaft zeugt von der Vielseitigkeit der KI. Professionelle Autoren arbeiten mit KI-Tools zusammen, um überzeugende Geschichten zu entwickeln, während Marketing-Teams ausgefeilte Algorithmen nutzen, um personalisierte Inhalte zu generieren, die bei bestimmten Zielgruppen Anklang finden. Aktuelle Daten zeigen, dass KI-gestützte Inhaltserstellung die Engagement-Raten im Vergleich zu traditionellen Methoden um bis zu 40% steigern kann. Die Verschmelzung von KI-Textgenerierung mit Sprachtechnologie und Internet of Things (IoT)-Geräten - dem Netzwerk internetfähiger Smart Devices - hat neue Möglichkeiten für Barrierefreiheit eröffnet. Brain-Computer-Interfaces (BCIs), die eine direkte Kommunikation zwischen Gehirn und externen Geräten ermöglichen, stellen die nächste Grenze der Textgenerierung dar. Führende Technologieunternehmen haben bereits eine 98-prozentige Genauigkeit bei der Umwandlung von neuronalen Signalen in Text erreicht und versprechen revolutionäre Anwendungen im Gesundheitswesen und in der Kommunikation. Exzellenter Kundenservice hängt heute von der Fähigkeit der KI ab, menschliche Emotionen zu verstehen und darauf zu reagieren. Fortschrittliche Stimmungsanalyse-Tools verarbeiten Kundenfeedback in Echtzeit und ermöglichen es Unternehmen, angemessene Antworten zu generieren und eine konstante Servicequalität aufrechtzuerhalten. Organisationen, die diese Systeme nutzen, berichten von Zufriedenheitsraten über 85% und demonstrieren damit die entscheidende Rolle der KI in modernen Geschäftsabläufen. Innovation nutzen und Herausforderungen meistern Lassen Sie uns untersuchen, was KI-Textgenerierung sowohl spannend als auch herausfordernd macht. Bedenken Sie - während diese Systeme bemerkenswerte Inhalte produzieren können, erfordern sie eine sorgfältige Navigation durch technische Komplexitäten. Der Weg zu besserer Kohärenz ist nicht einfach; er erfordert ausgefeilte maschinelle Lernmodelle und hybride Ansätze, die den Inhalt natürlich fließen lassen und gleichzeitig die richtige Botschaft vermitteln. Moderne Systeme stützen sich stark auf vorlagenbasierte Systeme, um eine konstante Qualität über verschiedene Anwendungen hinweg zu gewährleisten. Die Evolution der KI bringt eine wichtige Verantwortung mit sich: die direkte Auseinandersetzung mit Voreingenommenheit. Forschungen zeigen, dass die Implementierung vielfältiger Datensätze und robuster ethischer Aufsichtsmechanismen die Fairness in KI-Outputs erheblich verbessert. Der optimale Ausgleich zwischen Kreativität und Kontrolle erfordert ständige Feinabstimmung, doch jeder Durchbruch im kontextuellen Verständnis eröffnet neue Möglichkeiten. Führende Organisationen haben erkannt, dass die Behandlung dieser Herausforderungen als Chancen Innovation vorantreibt und zu ausgefeilteren Systemen führt. Aktuelle Studien zeigen, dass Unternehmen, die diese Denkweise verfolgen, zuverlässigere, ethisch fundierte Textgeneratoren entwickeln, die Nutzer unterschiedlicher Hintergründe und Bedürfnisse effektiv bedienen. Das ist ein Beispiel für Infografiken im Text. Infografiken in engl. sind kein Problem, in deutsch wird es haariger und ist noch nicht wirklich nutzbar. Das Problem ist das Zimmwriter zuerst in englisch schreibt und den fertigen Text am Ende, auch erst nach Generierung der Bilder, übersetzt. Das neue Experiment ist das auszuhebeln und im Bilderprompt die KI Recraft anzuweisen den Text in deutsch zu schreiben. Das funktioniert noch suboptimal. Aber wir bleiben dran und 100% gibt es in Kürze eine Lösung. Read the full article

0 notes

Text

ChatGPT-4 - das stärkste KI-Tool aller Zeiten