#Llama3.2

Explore tagged Tumblr posts

Text

he is 42 years old, hes sitting on his couch staring at that thing we always stare at

84 notes

·

View notes

Text

Learn how Meta’s Llama3.2, an open-source lightweight model, is revolutionizing AI. It outperforms models like Claude 3 and GPT-4 Mini, works well on small devices, and supports multiple languages. Discover how pruning and knowledge distillation make it a game-changer.

#AI#Llama3.2#Meta#OpenSource#MachineLearning#artificial intelligence#open source#machine learning#software engineering#nlp#programming#meta ai#ai technology

2 notes

·

View notes

Text

aún espero esa llamada

#llama#llama3.2#lana del ray lyrics#nocje#noches de pensamientos#esta noche#corazon triste#corazón vacío#corazón roto#mensagem#mente#we don't talk about bruno#we dont know

1 note

·

View note

Text

Unveiling Llama 3.2: Meta AI's Multimodal Marvel

Llama 3.2 by Meta AI represents a monumental leap in multimodal language models, capable of processing text, images, audio, and more. This latest iteration enhances applications like image captioning and extracting structured data from unstructured sources such as PDFs.

Introduction to Multimodal Language Models

Multimodal language models are designed to comprehend and process data from various modes such as text, images, and audio, offering a holistic approach to language understanding. These models harness the power of deep learning to create a unified framework that can interpret and generate diverse forms of content, breaking traditional boundaries. The evolution of multimodal models marks a significant trend towards more comprehensive artificial intelligence systems, enabling advanced capabilities across a multitude of applications. Llama 3.2 by Meta AI Llama 3.2 builds upon the foundation laid by its predecessors, introducing enhanced multimodal capabilities designed for superior data processing across text, images, audio, and beyond. This model represents a fusion of cutting-edge technologies aimed at expanding the horizons of natural language processing and machine learning. Meta AI's focus with Llama 3.2 is not only on scalability but also on improving the model's ability to handle complex multimodal tasks with unprecedented accuracy. Applications and Use Cases One of the standout applications of Llama 3.2 is in image captioning, where the model excels at generating accurate and contextually relevant descriptions from visual inputs. Beyond visual data, the model also shines in extracting structured information from unstructured documents such as PDFs, transforming them into actionable data. These capabilities are poised to revolutionize industries like content generation, accessibility design, and data analysis by significantly enhancing efficiency and precision. Impact on Industry and Research The introduction of Llama 3.2 is influencing a shift in computational paradigms, encouraging industries to adopt more integrated and intelligent systems. In academia, the model serves as both a tool and inspiration, driving research into deeper integrations of multimodal technologies and the exploration of AI's untapped potential. It sets a precedent for future investigations into multimodality, challenging researchers to push boundaries in cognitive and computational sciences. Future Prospects and Challenges Future advancements in multimodal models promise even more seamless interactions between different forms of data, leading to innovations not yet imaginable. However, challenges such as computational demands, data privacy concerns, and ethical considerations must be addressed to harness the full potential of models like Llama 3.2 responsibly. Read the full article

0 notes

Text

Llama Guard 3 Offers Protection With 1B, 8B, And 11B-Vision

Introduction

There are now three varieties of Llama Guard available: Llama Guard 3 1B, Llama Guard 3 8B, and Llama Guard 3 11B-Vision. The third model provides the same vision understanding features as the base Llama 3.2 11B-Vision model, while the other two models are text-only. For text-only prompts, all of the models are multilingual and adhere to the classifications established by the ML Commons project. For further information about each model and its capabilities, consult the corresponding model cards.

Llama 3.2 Update

By including a multimodal model (11B) for evaluating image and text input and a smaller text-only model (1B) for on-device and cloud safety evaluations, this update expands on the features first presented in Llama Guard 3. While a new special token has been added to accommodate picture input, the prompt format remains similar with the current one.

Image Support

To classify the prompt, the multimodal model assesses the image and the prompt text jointly. Image-only classification is not its intended function. Additionally, the prompt’s text component should be in English since the model has been tuned for English-language text. It is expected of developers of other languages to make sure that their deployments are tested and carried out in a responsible and safe manner.

You should use the Llama Guard 3 1B or Llama Guard 3 8B models (which came with Llama 3.1) for text-only classification.

The format (quality and aspect ratio) of the photos you provide to the Llama 3.2 multimodal models should match that of the images you submit for evaluation. Additionally, take note that the model is unable to evaluate photos that were produced using generative AI technology.

Images can be evaluated in multi-turn conversations, however the turn in which the image appears must have the image token added . However, the model only analyzes one image every question, thus multi-turn support here does not equate to multi-image support.

Use Llama Guard 3 8B for S14 Code Interpreter Abuse

The category S14 Code Interpreter Abuse was not optimized for the new Llama Guard 3 1B model. In combination with the Llama 3.1 release, you should use the 8B model that was introduced in Llama Guard 3 if you need to screen for this category.

Note: A well-designed Llama Guard prompt has several sections, separated by tags like and . The model can correctly understand the prompt because these are regular text in the prompt rather than special tokens.

There are two distinct prompts: one for user input and one for agent output because the guardrails can be applied to both the model’s input and output. User and Agent are two possible choices for the role placeholder; the former denotes the input and the latter the output. The agent answer must be absent from the conversation when assessing the user input. Both the user input and the agent response must be present in the conversation at the same time in order to evaluate the agent response; in this instance, the user input offers crucial context for the evaluation.

The llama recipes repository includes an example of inference and a helper function that demonstrates how to style the prompt correctly using the given categories. Custom categories for the prompt can be made using this as a template. The llama-stack GitHub repository, which contains reference implementations for input and output guardrails, is another option.

Note: An image will be provided to the model for assessment when the <|image|> token is present. Take this unique token out of the prompt for text-only inference, like when using Llama Guard 3 1B.

The variables to replace in this prompt template are:

{{ role }}: It can have the values: User or Agent. Note that the capitalization here differs from that used in the prompt format for the Llama 3.1 model itself.

{{ unsafe_categories }}: The default categories and their descriptions are shown below. These can be customized for zero-shot or few-shot prompting.

{{ user_message }}: input message from the user.

{{ model_answer }}: output from the model.

As an alternative, the question can also include the complete description for every category. This allows you to modify these descriptions in order to modify the behavior of the model for your particular use cases:

Model Specifications

A pretrained Llama-3.1-8B model, Llama Guard 3 has been optimized for content safety classification. It is capable of classifying material in both LLM responses (response classification) and LLM inputs (prompt classification), just as earlier iterations. In its output, it produces text that shows whether a prompt or response is safe or dangerous, and if unsafe, it also identifies the content categories that were broken. It functions similarly to an LLM.

Llama Guard 3 was created to support Llama 3.1 capabilities and was matched to protect against the MLCommons specified risks taxonomy. In particular, it offers content filtering in eight languages and was designed to enable code interpretation tool calls and safety and security.

Read more on Govindhtexch.com

#LlamaGuard3#Llama#Llama3.2#LLM#LlamaGuard#News#Technews#Technology#Technologynwes#Technologytrends#govindhtech

0 notes

Text

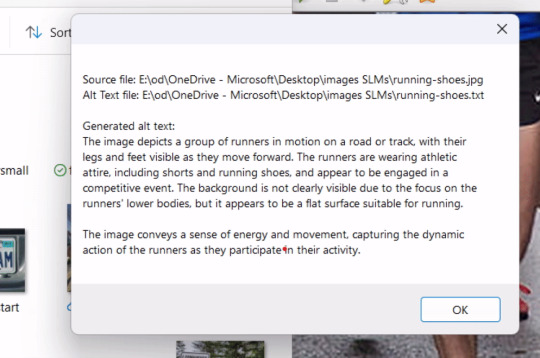

Using Large Language Models with .NET: Generating Image Alt Text Automatically

Hi! The following post is generated using some super cool LLMs, and hey it’s also about LLMs 😁 Introduction In this blog post, we’ll explore a practical use case for LLMs: generating alt text for images automatically, ensuring your applications are more inclusive and accessible. By the end of this post, you’ll learn how to: Leverage Llama 3.2 Vision for image analysis. Implement the solution…

View On WordPress

0 notes

Text

Ollama 0.4 is released with support for Meta's Llama 3.2 Vision models locally

https://ollama.com/blog/llama3.2-vision

2 notes

·

View notes

Text

Ollama Models in Use

Just documenting the current models in Ollama I am playing with.

mixtral:8x7b

mistral-nemo:latest

mistrallite:latest

qwen2.5-coder:14b

qwen2.5-coder:latest

llama3.2:latest

llama3.1:latest

0 notes

Text

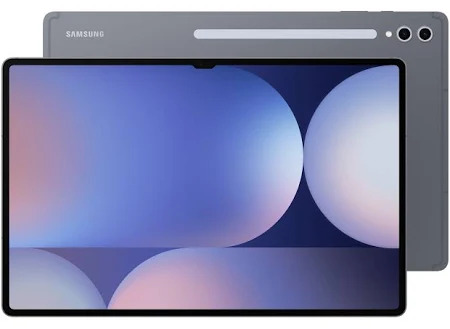

The Samsung Galaxy Tab S10 Ultra is a great tablet.

If you Google the mouthful, "Samsung Galaxy Tab S10 ultra review," you'll be forgiven for thinking this tablet is "Unwieldy," "too big," and "a behemoth."

The internet is covered with page 1 and 2 search results on Google, YouTube, and other locations, which are all very quick to tell you just how unusable this tablet is. It doesn't know what it is or how they tried Dex, and it just doesn't work.

These reviews often (not always) come from people who will also tell you how the iPad is a masterclass in the tablet world and laud the equivalent iPad Pro's

Many of these reviewers are stuck in a world where they rely on Windows or Mac software to do their jobs, and as such, if tools specific to their workflow don't exist, then something is a dud...

However, there is a huge Army of people out there for whom a device such as the S10 Tab Ultra is a great laptop alternative, and as one of those people, I'd like to explain a few reasons why.

As I've implied above, many reviewers find reviewing these types of systems difficult for three reasons.

Many of them are tied into the IOS infrastructure and come from the iPhone world. In doing so, they are immediately in unfamiliar territory.

If they are Android users, they are probably using a Laptop for most of their work and are trying to treat the Tablet as another Android phone device or, at best, a smaller tablet, which is, for the most part, just phones with bigger screens.

Finally, there is the issue of being tied into familiar software and workflows. This can make objective reviewing of a tablet like this very difficult because you are battling not just a new device but also new software.

I don't have any of these issues because my main daily driver is a Chromebook if I'm not using a Linux desktop. So, I'm adept at using alternative software and web front ends and am generally not tied to Windows or Mac OS desktops.

That ability to adapt my workflow has been invaluable when using this tablet.

You'll first notice that the tablet's snapdragon chip is powerful. I didn't realise how powerful it was until I installed Ollama under Termux and ran the llama3.2 model on the Tablet. It ran as fast as my i7/32Gb LG Gram running Arch...

You also notice just how much grunt it has when editing video in things like Insta360, and it's as fast, if not quicker, than the Pixel 9 Pro XL.

This also highlights another thing Samsung does that Apple just can't: It multitasks. I can put the render behind other tasks; it carries on, and I can do something other than watch VideoLeap render.

A device with a screen this size will immediately draw comparisons with a Laptop, and the obvious question is, can it or should it be used as one? With a good keyboard case, I do and have found no issues doing so. This, however, is possible because I am not tethered to software that I require for specific workflows, such as Adobe, for video editing. (That being said, Capcut is a beast on this thing.) Over the years, I've adapted my workflow to web apps, Android apps and the outcome rather than the tool.

That last sentence is significant because if you want to use the Tab S10 Ultra as a laptop device. You are going to need to be flexible in the software you use. Android has a lot of software available. A lot of it scales really well in Tablet Mode

This is assisted in no small amount by Dex, a Samsung service which a lot of people review via the Samsung phones, and is included and I'd even say is far more useful on a Tablet.

Dex, in a nutshell, makes your Tab S10 Ultra operate more like a Windows Desktop. It has a toolbar with menus and shortcuts, launcher icons, and Android apps that can run on Windows. Coupled with a second screen, I have zero issues using the Tab S10 Ultra as a Laptop replacement. Dex isn't perfect; however, no other Desktop is. They all have problems. Dex will, however, provide an interface on the tablet when working with a keyboard and a mouse, which feels familiar, provides windows you can cycle through and lets you get work done.

So in summary the Tablet itself is best described as having

Powerful Performance: Features a Snapdragon chip capable of running demanding applications and AI models efficiently

Superior Multitasking: Allows background rendering while performing other tasks

DeX Integration: Provides a desktop-like experience with familiar interface elements and window management

And is best suited for people who are

Comfortable with the Android ecosystem

Willing to adapt to web-based alternatives

Looking for a versatile device that can handle both creative and productive tasks

1 note

·

View note

Text

Ollama×Open WebUI:CPUオンリーのLinuxサーバーで最も簡単にLlama3.2をセットアップする手順

Ollamaのインストール Ollamaは高性能なオープンソースLLMを、プライバシーを確保しながらローカル環境で実行できる優れたツールです。 インストール手順を詳しく解説します。 基本インストール curl -fsSL <https://ollama.com/install.sh> | sh このコマンドでOllamaの最新バージョンがシステムに直接インストールされます。 シェルスクリプトを使用することで、依存関係の解決から初期設定まで自動的に実行されます。 システム���ービスの設定 sudo useradd -r -s /bin/false -U -m -d /usr/share/ollama ollama sudo usermod -a -G ollama…

0 notes

Text

the reason socks never match is because they were made on opposite sides of the ocean by identical but cantankerous seamstresses.

78 notes

·

View notes

Text

Learn how Aria, the open-source multimodal Mixture-of-Experts model, is revolutionizing AI. With a 64K token context and 3.9 billion parameters per token, Aria outperforms models like Llama3.2-11B and even rivals proprietary giants like GPT-4o mini. Discover its unique capabilities and architecture that make it a standout in AI technology.

#Aria#MultimodalAI#MixtureOfExperts#AI#MachineLearning#OpenSource#RhymesAI#open source#artificial intelligence#software engineering#nlp#machine learning#programming#python

4 notes

·

View notes

Text

VLM, l’avenir de l’IA ?

Les modèles de langage visuel (VLM) open source révolutionnent l'analyse de documents et l'extraction de données. Transformez des images en contexte ou en informations structurées et obtenez des résultats précis. Avec des outils open source comme Qwen2-VL, les VLM se transforment en extracteurs universels de données visuelles et permettent de simplifier vos pipelines RAG en évitant l'utilisation de multiples frameworks de parsing spécialisés. Découvrez de nombreux exemples à travers cet article.

Comme beaucoup je intéresse à l’IA et aux différents modèles. Même s’il m’arrive d’utiliser des grands modèles comme ChatGPT ou Claude, je m’intéresse surtout à des modèles plus petits ou atypiques. Je vous renvoie d’ailleurs sur mon article concernant CroissantLLM un petit LLM français (cocorico) qui a évolué pour devenir un standard d’utilisation pour certains « Agents ». Car oui on parle maintenant d’agents IA s’appuyant sur des LLM spécifiques qui, par l’enchérissement de données à travers des RAG, peuvent résoudre des problèmes en parfaite autonomie. On voit même des orchestrateurs d’agents IA qui fonctionnent sur des frameworks comme Swarm pour accomplir des tâches plus complexes.

Depuis maintenant plusieurs mois, on assiste à un développement fulgurant des « vision-langage-modèle » ou VLM. Ces modèles multimodales, dédiés à l’origine à la reconnaissance d’images, sont devenus de véritables « agents » qui peuvent analyser des données à travers une photo et même une vidéo. Combinant des fonctions d’OCR, d’analyse à travers IA et de restitutions sur différents formats, les petits VLM deviennent des agents incontournables pour améliorer la productivité. Pour vous donner un échantillon des possibilités, je vous propose d’illustrer cet articles de différents exemples.

Il existe différents modèles VLM Open source comme Llama3.2-11B-Vision, Phi3.5-Vision, Pixtral (la suite de Mistral) ou Qwen2-VL. C’est ces 2 derniers que je vais utiliser pour illustrer mon article. Les résultats sont proches & similaires.

Commençons simplement pour demander de décrire cette image :

Voici le résultat : La photo montre une petite sculpture en forme de chat. Le chat est représenté en position allongée, avec les pattes avant repliées sous son corps et la tête légèrement relevée. La sculpture semble être faite d'un matériau ressemblant à de la pierre ou de l'argile, avec une texture granuleuse et une couleur beige clair. La surface de la sculpture présente quelques taches et imperfections, ce qui lui donne un aspect légèrement vieilli. La sculpture est placée sur une surface rugueuse et grise, probablement une pierre ou un mur en pierre. En arrière-plan, on peut voir des éléments flous de verdure, suggérant que la photo a été prise à l'extérieur, peut-être dans un jardin ou un parc.

A travers cet exemple, je veux simplement vous montrer qu’à travers une photo, on peut rapidement définir un contexte. Il devient alors inutile d’utiliser un long prompt pour contextualiser notre demande, cela est un gain important.

Maintenant prenons un document d’identité assez mal visible :

Prompt : Peux-tu me générer au format JSON, à partir de la photo jointe, le nom, prénom, date de de naissance et lieu de naissance.

Voici le résultat :

{ "nom": "MARTIN", "prénom": "Maëlis-Gaëlle, Marie", "date_de_naissance": "13/07/1990", "lieu_de_naissance": "Paris" }

Et oui, les VLM sont de véritables OCR qui peuvent traiter de nombreux documents même s’ils sont peu visibles… Continuons avec ce schéma :

Prompt : Que représente le schéma et combien y a t'il de pièce ?

Voici le résultat : Ce schéma représente un éclaté d'une machine à haute pression, probablement un nettoyeur haute pression. Il montre les différentes pièces qui composent l'appareil, ainsi que leur disposition et leur assemblage. En comptant toutes les pièces numérotées, il y a un total de 63 pièces représentées sur ce schéma.

On pourrait poursuivre en lui demandant d’expliquer chaque pièce…

Continuons avec cette notion OCR. Voici un exemple de compte de résultat (Extrait du site « comprendre la compta ») sous forme d’une image PNG.

Prompt : Peux-tu extraire à travers le compte de résultats joint, un document de synthèse sous forme de tableau reprenant :

Le résultat d’exploitation qui est la différence entre les produits d’exploitation et les charges d’exploitation.

Le résultat financier qui est la différence entre les produits financiers et les charges financières.

Le résultat courant avant impôts qui est la somme du résultat d’exploitation et du résultat financier.

Le résultat exceptionnel qui est la différence entre les produits exceptionnels et les charges exceptionnelles.

Le résultat net qui est la somme du résultat courant avant impôts et du résultat exceptionnel, diminué de l’impôt sur les bénéfices. Si celui-ci est positif, tu mentionneras que c’est « un bénéfice » dans le cas inverse tu indiqueras « une perte ».

Voici le résultat, reprenant le tableau de synthèse avec les informations demandées : Indicateur -> Montant (en euros) Résultat d'exploitation -> 90 000 Produits d'exploitation -> 450 000 Charges d'exploitation -> 360 000 Résultat financier -> -10 000 Produits financiers -> 0 Charges financières -> 10 000 Résultat courant avant impôts -> 80 000 Résultat d'exploitation -> 90 000 Résultat financier -> -10 000 Résultat exceptionnel -> -5 000 Produits exceptionnels -> 0 Charges exceptionnelles -> 5 000 Résultat net -> 67 000 Résultat courant avant impôts -> 80 000 Résultat exceptionnel -> -5 000 Impôt sur les bénéfices -> 8 000 Nature du résultat net Bénéfice

Admettez que le résultat est satisfaisant, surtout que je n'ai rien spécifié concernant le modèle et le format de sortie. Pour compliquer l'exercice je vais fournir une image d'un autre compte de résultats mais avec une forme différentes et indiquant 2 années :

Prompt : Peux-tu faire la même opération avec cette photo.

Voici le résultat : Indicateur -> Année N (en euros) | Année N-1 (en euros) Résultat d'exploitation -> 56 773 | 66 029 Produits d'exploitation -> 155 500 | 151 000 Charges d'exploitation -> 98 727 | 84 971 Résultat financier -> -548 | -332 Produits financiers -> 0 | 0 Charges financières -> 548 | 332 Résultat courant avant impôts -> 56 225 | 65 697 Résultat d'exploitation -> 56 773 | 66 029 Résultat financier -> -548 | -332 Résultat exceptionnel -> 0 | 0 Produits exceptionnels -> 0 | 0 Charges exceptionnelles -> 0 | 0 Résultat net -> 44 472 | 50 786 Résultat courant avant impôts -> 56 225 | 65 697 Résultat exceptionnel -> 0 | 0 Impôt sur les bénéfices -> 11 753 | 14 911 Nature du résultat net -> Bénéfice Bénéfice

Je pense que vous commencez à comprendre la capacité d’un agent « automatisé » à produire des données en masse à partir de nombreux documents…

Pour terminer je vais soumettre cette image au VLM :

Prompt : Peux-tu me générer les codes HTML, javascript et css pour jouer au jeu correspondant à l’image. Il faudra implémenter une certaine intelligence pour jouer contre l'ordinateur.

Le résultat a été rapide et après avoir copié les codes, j'ai cliqué sur le fichier html et tout était opérationnel :

J'ai pu jouer au Morpion, également connu sous le nom de *Tic-Tac-Toe* en anglais. C'est un jeu de papier et crayon pour deux joueurs, qui utilisent des symboles "X" et "O" sur une grille de 3x3 cases. Le but du jeu est d'aligner trois de ses symboles à la suite, horizontalement, verticalement ou en diagonale, tout en empêchant l'adversaire de faire de même. Le jeu était parfaitement "jouable" à travers un navigateur.

J’aurai pu aussi vous montrez les capacités exceptionnelles des VLM pour l’analyse de graphique mais je pense que ces exemples ont pu vous donner envie d'essayer la puissance des VLM. Si vous désirez découvrir ces nouvelles capacités qui rendent l'interrogation et l'analyse de données visuelles plus accessibles que jamais, rendez-vous sur ces 2 sites :

https://chat.mistral.ai

N’hésitez pas à me laisser des commentaires sur vos différentes expériences.

0 notes

Text

nothing wrong with being silent. the wind is still outside

85 notes

·

View notes

Text

if my wallpaper was alive it would say no to me every time i tried to hang a picture

72 notes

·

View notes