#nginx webserver

Explore tagged Tumblr posts

Link

#autoSSL#Automation#cloud#configuration#containerization#DevOps#Docker#HTTPS#Let'sEncrypt#Linux#networking#NGINX#proxyserver#reverseproxy#Security#self-hosted#servermanagement#systemadministration#TLS#Traefik#webserver

0 notes

Text

Types of Web Servers

Ever wondered what powers the websites you visit daily? Web servers are the unsung heroes behind the scenes. This infographic guides you through the diverse world of web servers, including Apache, Nginx, and IIS. Discover their unique capabilities and learn how to choose the right one for your project.

0 notes

Text

0 notes

Text

1 note

·

View note

Text

Die besten Webserver im Vergleich: Caddy, Nginx und Apache – Wann verwende ich welchen Unterbau?

Ein Blick auf die aktuelle Webserver-Landschaft mit einem Vergleich zwischen Caddy, Nginx und Apache, mit ein paar Beispielen, in welchen Szenario ich welchen Webserver als Systemadministrator bevorzuge....[Weiterlesen]

0 notes

Note

Hi, TrueNAS ships with support for docker containers and I host a bunch of my services there. Are there any projects you would recommend for a static HTTP file host?

Honestly just a nginx webserver pointed to your storage, that's what I do and it works great. You can also make it so you can setup usernames and passwords or have it use LDAP... How idk but I do know it can be done

6 notes

·

View notes

Text

Hier sind die 10 beliebtesten Servertypen (Stand: 2025) und ihre jeweiligen Aufgaben – klar, direkt und ohne Bullshit: 1. Webserver Beispiele: Apache, Nginx, Microsoft IIS Aufgabe: Liefert Webseiten und Webanwendungen an Browser Verarbeitet HTTP/HTTPS-AnfragenTypische Nutzung: Hosting von Websites, Online-Shops, Blogs, APIs 2. Datenbankserver Beispiele: MySQL, PostgreSQL, Microsoft SQL…

0 notes

Link

0 notes

Text

Building Scalable Infrastructure with Ansible and Terraform

Building Scalable Infrastructure with Ansible and Terraform

Modern cloud environments require scalable, efficient, and automated infrastructure to meet growing business demands. Terraform and Ansible are two powerful tools that, when combined, enable Infrastructure as Code (IaC) and Configuration Management, allowing teams to build, manage, and scale infrastructure seamlessly.

1. Understanding Terraform and Ansible

📌 Terraform: Infrastructure as Code (IaaC)

Terraform is a declarative IaaC tool that enables provisioning and managing infrastructure across multiple cloud providers.

🔹 Key Features: ✅ Automates infrastructure deployment. ✅ Supports multiple cloud providers (AWS, Azure, GCP). ✅ Uses HCL (HashiCorp Configuration Language). ✅ Manages infrastructure as immutable code.

🔹 Use Case: Terraform is used to provision infrastructure — such as setting up VMs, networks, and databases — before configuration.

📌 Ansible: Configuration Management & Automation

Ansible is an agentless configuration management tool that automates software installation, updates, and system configurations.

🔹 Key Features: ✅ Uses YAML-based playbooks. ✅ Agentless architecture (SSH/WinRM-based). ✅ Idempotent (ensures same state on repeated runs). ✅ Supports cloud provisioning and app deployment.

🔹 Use Case: Ansible is used after infrastructure provisioning to configure servers, install applications, and manage deployments.

2. Why Use Terraform and Ansible Together?

Using Terraform + Ansible combines the strengths of both tools:

TerraformAnsibleCreates infrastructure (VMs, networks, databases).Configures and manages infrastructure (installing software, security patches). Declarative approach (desired state definition).Procedural approach (step-by-step execution).Handles infrastructure state via a state file. Doesn’t track state; executes tasks directly. Best for provisioning resources in cloud environments. Best for managing configurations and deployments.

Example Workflow: 1️⃣ Terraform provisions cloud infrastructure (e.g., AWS EC2, Azure VMs). 2️⃣ Ansible configures servers (e.g., installs Docker, Nginx, security patches).

3. Building a Scalable Infrastructure: Step-by-Step

Step 1: Define Infrastructure in Terraform

Example Terraform configuration to provision AWS EC2 instances:hclprovider "aws" { region = "us-east-1" }resource "aws_instance" "web" { ami = "ami-12345678" instance_type = "t2.micro" tags = { Name = "WebServer" } }

Step 2: Configure Servers Using Ansible

Example Ansible Playbook to install Nginx on the provisioned servers:yaml- name: Configure Web Server hosts: web_servers become: yes tasks: - name: Install Nginx apt: name: nginx state: present - name: Start Nginx Service service: name: nginx state: started enabled: yes

Step 3: Automate Deployment with Terraform and Ansible

1️⃣ Use Terraform to create infrastructure:bash terraform init terraform apply -auto-approve

2️⃣ Use Ansible to configure servers:bashansible-playbook -i inventory.ini configure_web.yaml

4. Best Practices for Scalable Infrastructure

✅ Modular Infrastructure — Use Terraform modules for reusable infrastructure components. ✅ State Management — Store Terraform state in remote backends (S3, Terraform Cloud) for team collaboration. ✅ Use Dynamic Inventory in Ansible — Fetch Terraform-managed resources dynamically. ✅ Automate CI/CD Pipelines — Integrate Terraform and Ansible with Jenkins, GitHub Actions, or GitLab CI. ✅ Follow Security Best Practices — Use IAM roles, secrets management, and network security groups.

5. Conclusion

By combining Terraform and Ansible, teams can build scalable, automated, and well-managed cloud infrastructure.

Terraform ensures consistent provisioning across multiple cloud environments, while Ansible simplifies configuration management and application deployment.

WEBSITE: https://www.ficusoft.in/devops-training-in-chennai/

0 notes

Text

How to Install Lychee with Nginx on Ubuntu 24.04

This article explains how to install Lychee Photo Management system with Nginx webserver on Ubuntu 24.04. Lychee is an open-source photo management system that lets you host your photo gallery. It provides a user-friendly interface for managing, organizing, and sharing your photos through a web browser. Installing Lychee with Nginx on Ubuntu is great because Nginx can handle many simultaneous…

0 notes

Text

Un día como hoy (1 de diciembre) en la computacion

El 1 de diciembre de 1995 se libera la primera versión del software para servidores web Apache HTTP, basado en el NCSA HTTPd, y que ha jugado un rol primordial en el crecimiento inicial y exponencial del WWW. Hoy, ocupa el segundo lugar, atrás por dos puntos a Nginx, como de lo más usados para servir sitios web #retrocomputingmx #apache #http #webserver

0 notes

Text

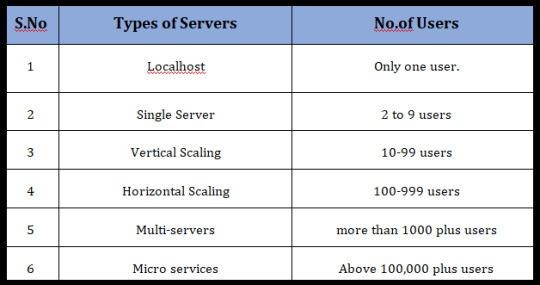

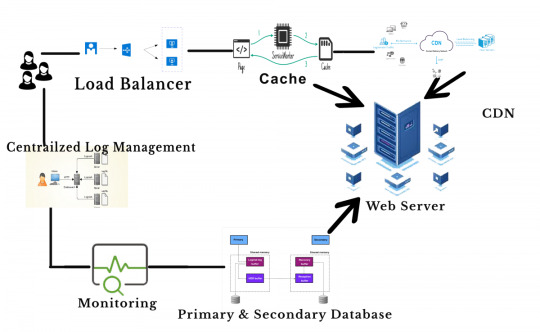

The Scaling with Node js

In this article, we will discuss the effective scaling practices of developing Node.js web applications. Most Developers are familiar with the Node.js implementation and we will focus on some advanced tactics to scale per the number of users.

Node.js

Node.js is a JavaScript run-time environment built on Chrome’s V8 JavaScript engine; it implements the reactor pattern, a non-blocking, event-driven I/O paradigm. Node.js is well good for building fast, scalable network applications, as it’s capable of handling a huge number of simultaneous requests with high throughput.

The way to improve the scalability

Before entering into the concept, let’s know what is Scalable? A word Scalable refers to expandable, which means the number of users will access the application from anywhere at the same time. Ensure your application is highly scalable; it can handle a large increase in users, workload or transactions without undue strain.

Regarding increasing the scalable, we are going to explain the options for concurrent users.

1. Localhost

Any application that runs on a developer machine for development purpose is hosting application locally. Generally, it is for the use of only one user, so there is no need to worry about scaling factor.

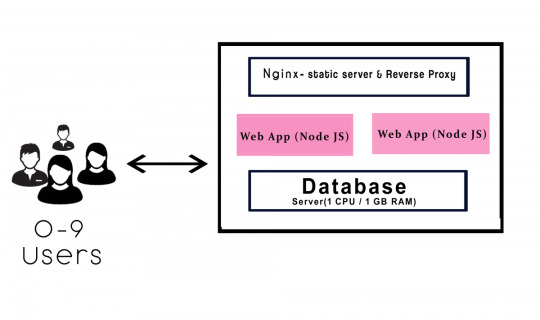

2. Single server

A single server system can accommodate around 1 to 9 concurrent users. Assume, your application will be used locally then the deployment will be carried out locally. It’s fine to do in a single server. For hosting the node.js application one can use Nginx as the webserver.

If you are using a single server application for few users well enough. It is simple to implement the single server and very much efficient for a few users. The requirements consist of only one CPU and 1 GB RAM, which is equivalent to web server AWS t2.micro / t2.nano.

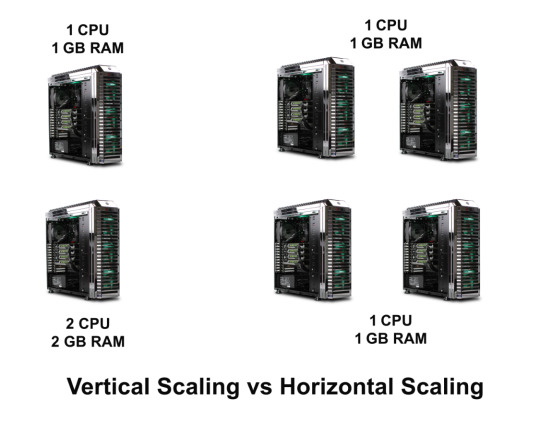

3. Vertical scaling

The term “vertical” states that to manage by adding extra capability or power to a single component. When the server begins to start slower or longer time to execute at the level we will transform to the vertical scaling. In vertical scaling the requirements consist of 4 GB RAM, which is equivalent to web service t2. medium.

The above diagram explains the workflow in the vertical scaling.

a. It consists of two instances of Node.js which runs to deploy/update within zero downtime.

b. The function of Nginx handles the load balance.

c. If server 1 works to upgrade, then the other server keeps serving the requests. Continue this process until the buffer will get empty.

d. The purpose in Nginx takes into account of all the user requests, It consists of two functions such as a static file server and reverses proxy.

Static — The static files like CSS, JS, Images, this will not disturb the web app.

Reverse Proxy — It will access the request for the needs the application to resolve which redirects it.

4. Horizontal scaling

The Scaling horizontally, which means adding more machines to scale up your pool of resources. This concept will work out in the enterprise from the level of 100 to 1000 employees. Whenever the app responses get slowdown from the database you have to upgrade to 16 GB RAM. Cassandra, MongoDB is suitable for horizontal scaling. It provides for implementing a scale from smaller to a bigger machine.

Companies like Google, Facebook, eBay and Amazon are using horizontal scaling.

Differences

In horizontal scaling, you can add more machines to scale dynamically. If any system fails, then another system will handle the process. No worry about the process failing. It will bring high I/O concurrency, reducing the load on existing nodes and improve disk capacity.

In vertical scaling, the data resides on a single node, it gets easy to slow down when the load increases. If the system fails to process, then the whole system may get a collapse. Horizontal scaling is little bit cost-effective than the vertical scaling.

5. Multi-servers

As the business grows, it’s time to add more servers to host the node.js application. The capacity of multi-servers can accommodate above 1000’s of concurrent users. Are you like to transform the previous server to the multi-servers? If Yes, continue with the following steps

1. First, add a load balancer and app units.

2. Set up multiple availability zones (AZ) in a region which one is connected through low latency links.

3. By splitting up the static files for easier maintenance.

4. CDN is one of the servers, which is used to manage files like images, videos, CSS, JS etc.,

Amazon provides load balancing through Elastic Load Balancer (ELB). It is available for the entire availability zone. This service routes to the active host only and can able to manage 1000 instances. By this set up you can use horizontally either vertically.

6. Microservices

Most of the giant companies like Netflix, Uber, Amazon are using microservices. The goals of microservice are to separate the services like search, build, configure and other management functionalities from database instances and deploy them as a separate microservices. Each of these services will take care of their tasks and can communicate with other services via API.

Traditionally we use the monolithic database. In monolithic, we can’t extend our application for several users. All modules are composed together in a single piece. As your business growing up, you have to move on the microservices. This will take to the next level in your production.

Conclusion

Hope this article helped you with scalability issues and helped you understand a bit better of how you can use the available services perfectly.

0 notes

Text

127.0.0.1:49342 – Was die Adresse bedeutet und wie du sie nutzen kannst

Hast du schon einmal die Adresse 127.0.0.1:49342 in einer Anleitung, bei einer Installation oder vielleicht zufällig in den Einstellungen einer Software entdeckt und dich gefragt, was genau dahintersteckt? Diese Kombination ist viel mehr als eine scheinbar zufällige Zahlenfolge. Sie ist ein wichtiger Bestandteil der Netzwerkkommunikation deines Computers und wird häufig in der Softwareentwicklung und beim Testen von Anwendungen eingesetzt. Doch was macht sie so besonders? Lass uns eintauchen und die Details entschlüsseln.

127.0.0.1 – Die Loopback-Adresse, die dich zu deinem eigenen Computer führt

Die IP-Adresse 127.0.0.1 ist auch als Loopback-Adresse bekannt. Dieser Begriff „Loopback“ bedeutet, dass der Datenverkehr quasi „im Kreis zurück“ auf deinen eigenen Rechner geleitet wird. Technisch gesehen ist das eine Adresse, die immer auf das lokale Gerät verweist, also auf den Computer, den du gerade benutzt. Das hat den Vorteil, dass du Verbindungen und Prozesse auf deinem Rechner testen kannst, ohne überhaupt auf ein Netzwerk angewiesen zu sein. Warum ist das nützlich? Ganz einfach: Stell dir vor, du entwickelst eine Anwendung, zum Beispiel einen Webserver, und möchtest prüfen, ob sie wie erwartet funktioniert. Statt sie sofort ins Internet zu stellen, nutzt du 127.0.0.1, um quasi „intern“ auf deinen Rechner zuzugreifen und alle Funktionen zu testen. Auf diese Weise kannst du sicherstellen, dass keine Daten über Netzwerke oder das Internet übertragen werden. Warum nicht einfach „localhost“? Eine interessante Nebenfrage: „localhost“ ist der Name, den wir oft sehen und der mit der Adresse 127.0.0.1gleichgesetzt wird. Beide führen zum gleichen Ziel, aber technisch gesehen ist „localhost“ eher ein Spitzname, der speziell für diese IP-Adresse reserviert ist.

Der Port 49342 – Die Tür zu spezifischen Anwendungen

Ein Computer kommuniziert über sogenannte Ports – und jeder Port ist wie eine eigene Tür, die nur für bestimmte Anwendungen oder Dienste geöffnet wird. Der Port 49342, den du in 127.0.0.1:49342 siehst, gehört zum Bereich der sogenannten ephemeren oder dynamischen Ports. Diese Ports liegen typischerweise im Bereich von 49152 bis 65535 und werden von Betriebssystemen oft automatisch und temporär für eine bestimmte Anwendung zugewiesen. Ephemere Ports sind praktisch, weil sie für jede neue Verbindung, die kurzfristig bestehen soll, schnell und automatisch verfügbar sind. Sie sind also nicht fest für einen bestimmten Dienst reserviert, wie etwa Port 80 für HTTP oder Port 443 für HTTPS, sondern variieren. Wenn dein Computer also 127.0.0.1:49342 nutzt, hat er diesen Port temporär zugewiesen, um z. B. eine Entwicklungsumgebung, ein Webserver oder ein Datenbankdienst lokal zu testen.

Kombination von 127.0.0.1 und Port 49342: Praktische Bedeutung

Die Kombination von 127.0.0.1 und einer Portnummer wie 49342 hat eine zentrale Rolle in der Softwareentwicklung, besonders bei lokalen Tests. Doch wie funktioniert das in der Praxis? Stell dir vor, du entwickelst eine Webanwendung und möchtest sie sehen und ausprobieren, als wäre sie schon „live“ im Internet – allerdings ohne, dass irgendjemand außer dir darauf zugreifen kann. Du startest dafür einen kleinen lokalen Webserver auf deinem Computer, und dieser Server öffnet zufällig den Port 49342. Das bedeutet, dass du in deinem Browser http://127.0.0.1:49342 eingeben kannst und deine Anwendung so aufrufen kannst, als sei sie online. Nur eben ohne jegliche Risiken und ohne, dass sie tatsächlich öffentlich zugänglich ist. Es ist wie eine Testbühne, auf der du deine Idee ausprobieren kannst, bevor du sie deinem Publikum vorführst. Beispiel: Web- und Datenbankentwicklung Entwickler arbeiten häufig mit Tools wie Docker oder lokalen Webservern wie Apache oder Nginx, um Anwendungen lokal zu testen. Sie erstellen dann oft eine Vielzahl von Testverbindungen: Eine könnte auf 127.0.0.1:8080 laufen, die andere auf 127.0.0.1:49342. So lassen sich mehrere Versionen und Services isoliert voneinander betreiben und testen. Genauso nutzen Datenbanken wie MySQL und PostgreSQL ebenfalls spezifische Ports, um Zugriffe zu steuern und Verbindungen sauber zu trennen.

Photo by RoonZ nl

Sicherheit und Kontrolle über lokale Verbindungen

Eine wichtige Frage, die sich gerade im Zusammenhang mit 127.0.0.1 stellt, ist die der Sicherheit. Du könntest meinen, dass diese lokale Adresse per Definition sicher ist, da sie ja nur auf deinem Rechner funktioniert. Das stimmt im Großen und Ganzen auch – allerdings kann es Sicherheitsrisiken geben, wenn versehentlich Dienste auf Ports laufen, die von außen zugänglich sind, oder wenn ein Fehler in der Konfiguration vorliegt. Moderne Firewalls und Netzwerküberwachungstools sorgen dafür, dass sensible Ports geschlossen bleiben und nur für lokale Zwecke genutzt werden können. Falls du aber viele Entwicklungsumgebungen parallel laufen hast, lohnt es sich, ab und an nachzusehen, welche Ports gerade genutzt werden. Über Tools wie netstat kannst du leicht herausfinden, welche Verbindungen bestehen und welche Ports geöffnet sind.

Fazit: Warum 127.0.0.1 und Port 49342 für Entwickler unverzichtbar sind

Die Kombination 127.0.0.1:49342 ist ein gutes Beispiel dafür, wie tief Technik im Alltag der Softwareentwicklung verankert ist. Für Entwickler bietet sie eine flexible, sichere Umgebung, um Projekte isoliert und risikofrei zu testen. Indem du diese Adresse und Ports nutzt, schaffst du quasi eine geschlossene Testwelt auf deinem eigenen Rechner – ohne dabei das Internet zu belasten oder Daten einem unnötigen Risiko auszusetzen. Diese Methode ist nicht nur effizient, sondern auch unverzichtbar, um Software zuverlässig und sicher entwickeln zu können, bevor sie die Welt da draußen erreicht. Read the full article

0 notes

Text

Unlocking the Power of Ansible Automation: Best Practices and Performance Optimization

Introduction

In the fast-paced world of IT, automation has become a critical component for managing and scaling infrastructure efficiently. Among the many automation tools available, Ansible stands out for its simplicity, powerful features, and wide adoption. This blog post will dive into the best practices for using Ansible, along with tips on optimizing its performance, especially in large environments.

Why Ansible?

Ansible is an open-source automation tool that automates software provisioning, configuration management, and application deployment. Its agentless architecture, using SSH for communication, makes it easy to set up and use. With a declarative language, playbooks written in YAML, and a rich set of modules, Ansible simplifies complex automation tasks.

Getting Started with Ansible

Installation: Begin by installing Ansible on a control node. For RHEL-based systems, use:

sudo yum install ansible

For Debian-based systems, use:

sudo apt-get install ansible

2. Inventory Setup: Ansible manages hosts through an inventory file, which can be a simple text file or dynamic inventory scripts.

[webservers]

web1.example.com

web2.example.com

[dbservers]

db1.example.com

3.Writing Playbooks: Playbooks are the heart of Ansible, defining tasks to be executed on remote hosts.

---

- hosts: webservers

tasks:

- name: Install Nginx

yum:

name: nginx

state: present

Best Practices for Ansible

Modular Playbooks: Break down large playbooks into smaller, reusable roles. This promotes reusability and easier management.

---

- name: Setup web server

hosts: webservers

roles:

- nginx

- php

- firewall

2.Idempotency: Ensure that your playbooks are idempotent, meaning running the same playbook multiple times should not produce different results. Use the state parameter effectively to manage resource states

3.Version Control: Store your playbooks in a version control system like Git. This allows for tracking changes, collaboration, and rollback if needed

4.Use Variables and Templates: Leverage Ansible variables and Jinja2 templates to create flexible and dynamic configurations.

---

- hosts: webservers

vars:

server_name: "example.com"

tasks:

- name: Configure Nginx

template:

src: templates/nginx.conf.j2

dest: /etc/nginx/nginx.conf

Optimizing Ansible Performance

Parallel Execution: Increase the number of forks (parallel tasks) to speed up execution. Edit the ansible.cfg file:

[defaults]

forks = 10

2. Reduce SSH Overhead: Use persistent SSH connections to minimize the overhead of establishing new connections.

[ssh_connection]

ssh_args = -o ControlMaster=auto -o ControlPersist=60s

3. Limit Fact Gathering: Disable fact gathering if not needed or limit it to specific tasks to reduce execution time.

---

- hosts: webservers

gather_facts: no

tasks:

- name: Setup Nginx

yum:

name: nginx

state: present

4. Optimize Inventory: Use a dynamic inventory script to manage large environments efficiently. This can help scale Ansible to manage thousands of hosts.

Conclusion

Ansible automation is a powerful tool for managing IT infrastructure. By following best practices and optimizing performance, you can harness its full potential, ensuring efficient and scalable automation. Whether you're managing a small set of servers or a large, complex environment, Ansible's flexibility and simplicity make it an indispensable tool in your DevOps toolkit.

For more details click www.hawkstack.com

#redhatcourses#information technology#container#docker#containerorchestration#kubernetes#linux#containersecurity#dockerswarm#aws

1 note

·

View note

Text

how create a vpn server

🔒🌍✨ Erhalten Sie 3 Monate GRATIS VPN - Sicherer und privater Internetzugang weltweit! Hier klicken ✨🌍🔒

how create a vpn server

VPN-Protokolle

VPN-Protokolle spielen eine entscheidende Rolle bei der Sicherheit und Privatsphäre von Internetnutzern. Wenn es um die Auswahl eines VPN-Dienstes geht, ist es wichtig zu verstehen, welche Protokolle zur Verfügung stehen und wie sie sich unterscheiden.

Ein häufig verwendetes VPN-Protokoll ist das OpenVPN. Es gilt als sicher und zuverlässig und wird für die Verschlüsselung des Datenverkehrs verwendet. Ein weiteres gängiges Protokoll ist L2TP/IPsec, das eine Kombination aus dem Layer 2 Tunneling Protocol (L2TP) und dem Internet Protocol Security (IPsec) darstellt. Es bietet eine gute Balance zwischen Sicherheit und Geschwindigkeit.

Für Nutzer, die besonderen Wert auf Sicherheit legen, ist das IKEv2/IPsec-Protokoll eine gute Wahl. Es zeichnet sich durch schnelle Verbindungen und eine starke Verschlüsselung aus. SSTP ist ein weiteres Protokoll, das von Microsoft entwickelt wurde und oft in Windows-Betriebssystemen eingesetzt wird. Es ist besonders nützlich für die Umgehung von Firewalls.

Neben diesen Protokollen gibt es auch das WireGuard-Protokoll, das für seine Geschwindigkeit und Effizienz bekannt ist. Es wird zunehmend beliebter bei VPN-Anbietern aufgrund seiner modernen und leistungsstarken Technologie.

Insgesamt ist die Wahl des richtigen VPN-Protokolls eine wichtige Entscheidung für die Sicherheit und Leistung Ihres VPN-Dienstes. Es ist ratsam, die verschiedenen Optionen zu prüfen und das Protokoll auszuwählen, das Ihren Bedürfnissen am besten entspricht.

Serverkonfiguration

Die Serverkonfiguration ist ein entscheidender Aspekt für die Leistung und Sicherheit einer Website. Eine sorgfältige Konfiguration des Servers gewährleistet einen reibungslosen Ablauf und schützt vor potenziellen Bedrohungen.

Zu den wichtigen Elementen einer Serverkonfiguration gehören die Betriebssystemauswahl, die Webserver-Software, die Datenbankoptionen, die Firewall-Einstellungen und die Sicherheitsprotokolle. Die Auswahl des richtigen Betriebssystems, wie z.B. Windows, Linux oder Unix, hängt von den spezifischen Anforderungen der Website ab.

Die Webserver-Software spielt eine Schlüsselrolle bei der Bereitstellung von Inhalten an die Benutzer. Bekannte Webserver wie Apache, Nginx oder Microsoft IIS bieten verschiedene Funktionen und Leistungsoptionen.

Darüber hinaus muss die Datenbankkonfiguration sorgfältig durchgeführt werden, um eine effiziente Verwaltung und Sicherung von Daten zu gewährleisten. Beliebte Datenbanken wie MySQL, PostgreSQL oder MongoDB bieten verschiedene Möglichkeiten für die Speicherung und den Abruf von Informationen.

Die Implementierung einer Firewall und weiterer Sicherheitsprotokolle ist unerlässlich, um die Website vor potenziellen Bedrohungen wie Hacking-Versuchen oder Datenlecks zu schützen. Die regelmäßige Aktualisierung von Software und Sicherheitspatches ist ebenfalls entscheidend, um Schwachstellen zu schließen und die Integrität des Servers zu gewährleisten.

Insgesamt ist eine professionelle Serverkonfiguration entscheidend für den Erfolg und die Sicherheit einer Website. Durch eine gründliche Planung und Umsetzung können potenzielle Probleme vermieden und die Leistung optimiert werden.

Sicherheitsmaßnahmen

Sicherheitsmaßnahmen sind entscheidend, um die Sicherheit von Personen, Gebäuden oder Informationen zu gewährleisten. In verschiedenen Bereichen wie im öffentlichen Raum, am Arbeitsplatz oder im Internet sind Sicherheitsmaßnahmen unverzichtbar, um Gefahren und Risiken zu minimieren.

Im öffentlichen Raum spielen Sicherheitsmaßnahmen wie Videoüberwachung, Sicherheitspersonal und Notrufsäulen eine wichtige Rolle. Diese Maßnahmen dienen dazu, die Sicherheit der Bürger zu gewährleisten und mögliche Straftaten zu verhindern oder aufzuklären. Zudem können Sicherheitsmaßnahmen wie bauliche Sicherungen oder Beleuchtung dazu beitragen, das Sicherheitsgefühl der Menschen zu stärken.

Auch am Arbeitsplatz sind Sicherheitsmaßnahmen von großer Bedeutung, um Unfälle oder Gesundheitsschäden zu vermeiden. Dazu zählen beispielsweise Schulungen zum Arbeitsschutz, die Bereitstellung von Schutzausrüstung oder die Einhaltung von Sicherheitsrichtlinien. Durch diese Maßnahmen können Arbeitgeber die Sicherheit und Gesundheit ihrer Mitarbeiter gewährleisten und gleichzeitig gesetzliche Vorgaben einhalten.

Im digitalen Bereich werden Sicherheitsmaßnahmen immer wichtiger, da die Bedrohungen durch Cyberkriminalität zunehmen. Hierzu zählen Maßnahmen wie der Einsatz von Virenschutzprogrammen, die Verschlüsselung von Daten oder regelmäßige Updates von Software und Betriebssystemen. Indem Nutzerinnen und Nutzer aufmerksam sind und Sicherheitsmaßnahmen beachten, können sie Risiken minimieren und ihre persönlichen Daten schützen.

Insgesamt sind Sicherheitsmaßnahmen unerlässlich, um Risiken zu reduzieren und die Sicherheit von Personen, Gebäuden oder Informationen zu gewährleisten. Durch eine gezielte Umsetzung von Sicherheitsmaßnahmen können potenzielle Gefahren frühzeitig erkannt und abgewendet werden.

VPN-Verbindung

Eine VPN-Verbindung, was für Virtual Private Network steht, ist ein wichtiges Tool, um Ihre Online-Privatsphäre und Online-Sicherheit zu schützen. Mit einer VPN-Verbindung können Sie eine sichere und verschlüsselte Verbindung zwischen Ihrem Gerät und dem Internet herstellen. Dadurch wird es für Dritte viel schwieriger, Ihre Online-Aktivitäten zu verfolgen oder auf Ihre persönlichen Daten zuzugreifen.

Es gibt verschiedene Gründe, warum Menschen eine VPN-Verbindung nutzen. Ein häufiger Grund ist der Schutz der Privatsphäre. Durch die Verwendung einer VPN-Verbindung können Sie sicher im Internet surfen, ohne dass Ihr Internetdienstanbieter oder Regierungsbehörden Ihre Online-Aktivitäten überwachen können.

Ein weiterer Grund für die Nutzung einer VPN-Verbindung ist der Zugriff auf geo-blockierte Inhalte. Viele Streaming-Dienste und Websites beschränken den Zugriff auf ihre Inhalte auf bestimmte Länder. Mit einer VPN-Verbindung können Sie diese Beschränkungen umgehen und auf Inhalte zugreifen, die normalerweise nicht in Ihrem Land verfügbar wären.

Es ist wichtig zu beachten, dass nicht alle VPN-Anbieter gleich sind. Bevor Sie sich für einen VPN-Dienst entscheiden, sollten Sie sich über die Sicherheitsfunktionen, Datenschutzrichtlinien und Geschwindigkeiten des Anbieters informieren. Auf diese Weise können Sie sicherstellen, dass Sie eine zuverlässige und sichere VPN-Verbindung erhalten.

Insgesamt kann eine VPN-Verbindung eine wertvolle Ergänzung für Ihre Online-Sicherheits- und Datenschutzstrategie sein. Indem Sie Ihre Internetverbindung schützen und Ihre Online-Aktivitäten privat halten, können Sie ein Stück mehr Sicherheit und Freiheit im digitalen Raum gewinnen.

Datenverschlüsselung

Die Datenverschlüsselung ist ein wesentlicher Bestandteil der heutigen digitalen Welt, insbesondere in Bezug auf die Sicherheit von sensiblen Informationen und persönlichen Daten. Durch die Verschlüsselung werden Daten in eine unverständliche Form umgewandelt, sodass Unbefugte keinen Zugriff auf die eigentlichen Informationen erhalten können.

Es gibt verschiedene Verschlüsselungsmethoden, darunter die symmetrische Verschlüsselung, bei der sowohl der Sender als auch der Empfänger denselben Schlüssel zum Entschlüsseln der Informationen verwenden. Die asymmetrische Verschlüsselung hingegen nutzt einen öffentlichen und einen privaten Schlüssel, wodurch eine sicherere Kommunikation ermöglicht wird.

Durch den Einsatz von Datenverschlüsselung werden sowohl persönliche Informationen als auch Unternehmensdaten vor Hackerangriffen und Datenmissbrauch geschützt. Dies ist besonders wichtig in Bereichen wie dem Online-Banking, der medizinischen Industrie und der Regierungsarbeit, wo höchste Vertraulichkeit gewährleistet sein muss.

Es ist jedoch darauf zu achten, dass die Verschlüsselungstechnologien kontinuierlich weiterentwickelt werden, da auch Cyberkriminelle ihre Methoden ständig verbessern. Deshalb ist es ratsam, auf dem neuesten Stand der Verschlüsselungsstandards zu bleiben und regelmäßig sicherheitsrelevante Updates durchzuführen.

Insgesamt ist die Datenverschlüsselung ein unverzichtbares Werkzeug, um die Integrität und Vertraulichkeit von Informationen zu gewährleisten und somit die Privatsphäre und Sicherheit der Nutzer zu schützen.

0 notes

Text

Häufige und am häufigsten verwendete Nginx-Befehle für Anfänger

Einblick: Häufige und am häufigsten verwendete Nginx-Befehle für Anfänger Nginx ist ein beliebter Open-Source-Webserver, der von Igor Sysoev entwickelt wurde. Es kann als HTTP-Server, Reverse-Proxy, Load Balancer und Mail-Proxy verwendet werden. Heute werden wir über die häufigsten und am häufigsten verwendeten Nginx-Befehle unter Linux-Benutzern sprechen. Häufige und am häufigsten verwendete…

View On WordPress

0 notes