#Deepmind

Explore tagged Tumblr posts

Text

MY OC :D :D :D :D :D :D

#purerockerhk#deepmind#reina yukki#traditional art#traditional sketch#pencil#art#artwork#my ocs#original character#magic#magic oc

32 notes

·

View notes

Photo

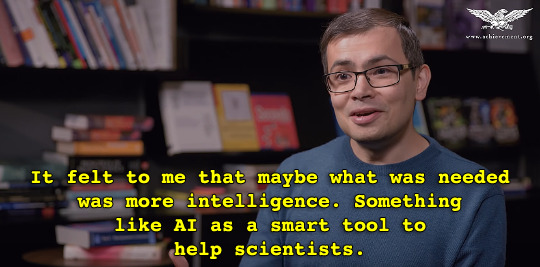

MBTI & Celebs Demis Hassabis: INTP

“Demis Hassabis CBE FRS FREng FRSA (born 27 July 1976) is a British artificial intelligence researcher, neuroscientist, video game designer, entrepreneur, and world-class games player.

He is the founder and CEO of DeepMind. (…)

A child prodigy in chess, Hassabis reached master standard at the age of 13 with an Elo rating of 2300 and captained many of the England junior chess teams. (…)

Hassabis began his computer games career at Bullfrog Productions, first level designing on Syndicate and then at 17 co-designing and lead programming on the 1994 game Theme Park, with the games designer Peter Molyneux. (…)

DeepMind's mission is to "solve intelligence" and then use intelligence "to solve everything else".

More concretely, DeepMind aims to meld insights from neuroscience and machine learning with new developments in computing hardware to unlock

increasingly powerful general-purpose learning algorithms that will work towards the creation of an artificial general intelligence (AGI).”

Sources: video, wiki/Demis_Hassabis. Screencaps: transcript.

24 notes

·

View notes

Video

youtube

Otra nueva locura de las IAs.

Después de que nos prometieran que bitcoin, NFTs, metaversos y demás humo eran el futuro... lo que están haciendo las IAs sí que es futuro presente.

20 notes

·

View notes

Link

"Machine-learning system can identify more than 50 different eye diseases and could speed up diagnosis and treatment". Reblog with caption 🙃

#artificial intelligence ai#deepmind#alphabet#technology#medical research#science#health#healthcare industry#society#research and development#business

19 notes

·

View notes

Link

#reasoning#deepmind#google#ai#artificial intelligence#artificialintelligence#ml#machine learning#data science#data#tech#technology#tech news#technology news#computing

10 notes

·

View notes

Link

8 notes

·

View notes

Text

Mi cariño esta a salvo contigo. Duerme. Niña bonita

Apreciar a alguien es apreciar lo que esa persona puso en ti. ¿Que semillas has sembrado en los corazones de los humanos que nombras como tuyos con los que has compartido tu tiempo de Vida?

¿Qué es lo que más disfrutas cuando estas con ellos?

7 notes

·

View notes

Photo

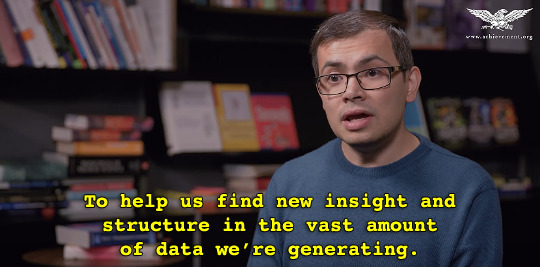

The new NFT Collection you need. A 1rs Edition of 100 "Risks" Next to the BlockChain🖤 A New Clan on Metaverse not a CryptoMonkey Its a Crypto Inc.🙈🙉🙊 They Belive in Zodiac, Some of them not look like Neymar, some of them wears adidas and other are pixels 💣💣💣💣💣🐉 👉MINT ON CENT.CO https://wezap.cent.co👈 💣💣💣💣💣🐉 #deepmind #arte #Inspiración #NFT #NFTCOMMMUNITY #TheRisks #collection #EndlessJourney #apes #magazine #Today #fantasy #uhive #opensea #polygon #ETH #TimBurton #Unique #Photoshop #blockchain #Cryptopunks #💯 https://www.instagram.com/p/ClZLE7xOyZj/?igshid=NGJjMDIxMWI=

#deepmind#arte#inspiración#nft#nftcommmunity#therisks#collection#endlessjourney#apes#magazine#today#fantasy#uhive#opensea#polygon#eth#timburton#unique#photoshop#blockchain#cryptopunks#💯

7 notes

·

View notes

Photo

“The pace of progress in artificial intelligence (I’m not referring to narrow AI) is incredibly fast. Unless you have direct exposure to groups like Deepmind, you have no idea how fast—it is growing at a pace close to exponential. The risk of something seriously dangerous happening is in the five-year time frame. 10 years at most.” —Elon Musk #ai #artificialintelligence #deepmind #dangers #geneva #philosophy #future #philosopher #singularity #transhumanism #singularityus #transhumanismus #transhumanist #ai #robot #robots #technological #technology #technologicalrevolution https://www.instagram.com/p/CnXez9VOu_h/?igshid=NGJjMDIxMWI=

#ai#artificialintelligence#deepmind#dangers#geneva#philosophy#future#philosopher#singularity#transhumanism#singularityus#transhumanismus#transhumanist#robot#robots#technological#technology#technologicalrevolution

5 notes

·

View notes

Photo

DeepMind's AI biologist can decipher secrets of the machinery of life (Michel Le Page, New Scientist, Nov 30 2020)

“Cells are full of machines – from turbines that generate energy to transporters that walk along tracks pulling cargo – that are built from proteins, and the shapes of these machines are crucial.

For instance, the coronavirus can enter and infect cells because the spike protein on its surface fits into a receptor on human cells, like a key into a lock.

These shapes depend on the sequence of 20 different amino acids that are chained together to make proteins.

It is easy to work out the sequence of any protein because this is determined by the DNA that codes for it.

But despite half a century of efforts, biologists hadn’t previously been able to work out the shape of a protein from its sequence alone. (…)

Brute-force computing based on physics alone isn’t an option, because proteins are too complex.

Instead many groups worldwide have turned to machine learning, where AI systems are trained using data sets of known protein structures.

For each target protein, groups including DeepMind’s look for variants found in related species and feed their sequence and structure into the AI system, along with the sequence of the target protein.

The idea is that the system learns to work out the shape of the target protein by looking at patterns linking sequence and structure. (…)

Lupas thinks for the next few years researchers will still need to do some experimental work to check shape predictions, but will eventually be able to rely on computation alone.

This will make a huge difference, he says, but the real revolution will come from being able to use computers to predict how proteins interact with other molecules.

“This will completely change the face of medicine,” says Lupas.

For instance, AlphaFold was able to predict the shapes of several coronavirus proteins soon after the virus was first sequenced in January, he says.

Even better would be to have the ability to predict which of the thousands of existing drugs bind to these proteins and might have a therapeutic effect, without having to do expensive experiments.”

10 notes

·

View notes

Link

5 notes

·

View notes

Quote

Weight training or resistance training strengthens your heart, bones, immune system and your way of thinking. Why are we so against resistance then? Growth requires resistance

Dirk O’Kennedy

5 notes

·

View notes

Link

#science#AlphaFold2#AlphaFold#Google#Deepmind#CASP14#structural biology#protein structure prediction#biophysics#bioinformatics#computational biology#AI#neural networks

4 notes

·

View notes

Video

youtube

4 notes

·

View notes

Text

Deepmind’s Goals

1. Solve intelligence

2. Use it to solve everything else

#deepmind#quotes#they came to talk and recruit at mit#ai#reinforcement learning#deep learning#ml#spring 2018

4 notes

·

View notes

Text

youtube

What's next for AI at DeepMind, Google's artificial intelligence lab

At Google DeepMind, researchers are chasing what’s called artificial general intelligence: a silicon intellect as versatile as a human's, but with superhuman speed and knowledge.

#deepmind#ai technology#ai tools#google#artificial intelligence#60 minutes#google artificial intelligence#new technology#ai model#Youtube

3 notes

·

View notes