#kinect2

Explore tagged Tumblr posts

Video

vimeo

Kinect2 | Oculus | Depth Mirror | Particles from Drew Skillman on Vimeo.

AWESOME.

0 notes

Photo

Sparkfox 90902-703-25 Camera Sticker for XBOX ONE Kinect Install a Kinect 2.0 sensor for the XBOX ONE console Link to online store: https://www.topmarket.co.il/en/sparkfox-90902-703-25-camera-sticker-for-xbox-one-kinect/

#xbox#kinect#kinect2#xboxone#gaming#console#onlinestore#israel#computers#hardware#electronics#gadgets

0 notes

Video

instagram

HÉLICE : Interactive Projection Mapping. Mutek IMG 2018. @mapp_mtl @quartierdesspectacles_mtl #touchdesigner #maxmsp #interactive #3dslices #kinect2 #mutekimg2018 (à Saint-Laurent station)

0 notes

Photo

Digital self! #notch #kinect2 #pixelsandnoise (at Godalming)

0 notes

Photo

Switch... all eyes are on you. www.twitch.tv/daftsamurai www.facebook.com/daftsamurai www.twitter.com/daftsamurai www.daftsamurai.com Xbox Live gamertag: L DaftSamurai L Playstation Network: L_DaftSamurai_L #nintendoswitch #nintendo #switch #docked #kinect #kinect2 #pscamera #psvr #playstationvr #vr #digital #technology #tech #enthusiast #gamer #gaming #xbox #xbox360 #xboxone #xb1 #xbone #ps #playstation #playstation4 #psn #xboxlive

#pscamera#kinect#gaming#technology#psvr#gamer#xbox#playstation4#vr#switch#digital#playstation#psn#xboxone#ps#xb1#enthusiast#xbox360#kinect2#playstationvr#docked#xboxlive#nintendo#nintendoswitch#tech#xbone

0 notes

Text

Desarrollo de Anfitriones Virtuales para Accenture Argentina. Producción de Sake Argentina.

Software utilizado: VVVV + Resolume. Captura de imagen con Kinect2.

0 notes

Video

vimeo

[Cybernetics] from motus.lumina on Vimeo.

[Cybernetics] Compilation of my real-time Kinect2 presets programmed with Vuo & Vdmx.

0 notes

Text

Final Project<week 4>Graphic bouncing collision

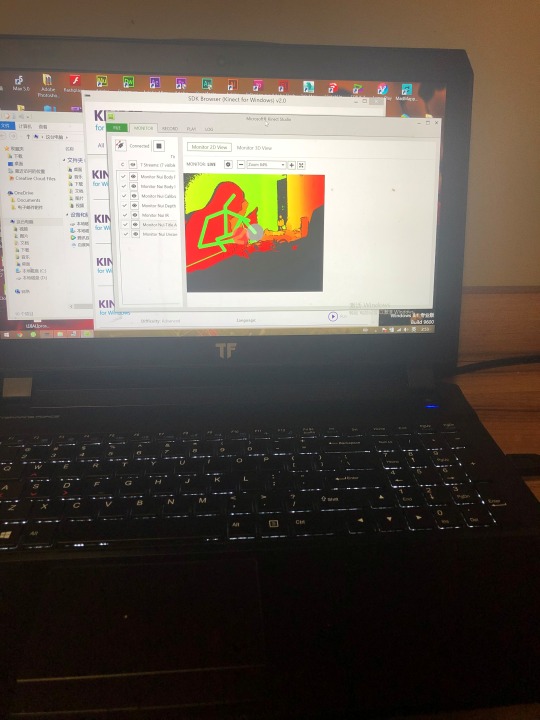

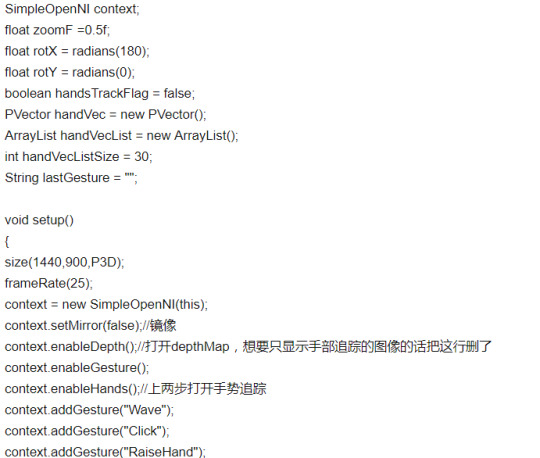

Today, I connected the Kinect device to the computer on the Win system. This time was very successful. It works fine. My Kinect is able to capture my bones.

This is worth making me happy. The last time I connected my device, it didn't work. The computer does not capture bones.

So I started testing whether Kinect can work in processing. I found the tracking case on the Internet.

youtube

code show as below:

// Daniel Shiffman // All features test // https://github.com/shiffman/OpenKinect-for-Processing // http://shiffman.net/p5/kinect/ import org.openkinect.freenect.*; import org.openkinect.freenect2.*; import org.openkinect.processing.*; //<>// Kinect2 kinect2; void setup() { size(1024, 848, P2D); kinect2 = new Kinect2(this); kinect2.initVideo(); kinect2.initDepth(); kinect2.initIR(); kinect2.initRegistered(); // Start all data kinect2.initDevice(); } void draw() { background(0); image(kinect2.getVideoImage(), 0, 0, kinect2.colorWidth*0.267, kinect2.colorHeight*0.267); image(kinect2.getDepthImage(), kinect2.depthWidth, 0); image(kinect2.getIrImage(), 0, kinect2.depthHeight); image(kinect2.getRegisteredImage(), kinect2.depthWidth, kinect2.depthHeight); fill(255); text("Framerate: " + (int)(frameRate), 10, 515); }

But it seems that this code does not work completely. I have to make a careful revision.

References

Shiffman.net. (2019). Getting Started with Kinect and Processing | Daniel Shiffman. [online] Available at: https://shiffman.net/p5/kinect/ [Accessed 18 Jun. 2019].

0 notes

Text

Installation de Sarah

Bonjour et bienvenue pour ce second billet. Il va présenter le premier pas dans la domotique appliquée à la maison des objets connectés. Tout d'abord une petite présentation de S.A.R.A.H. reprise sur le site de l'auteur Jean-Philippe Encausse. L’objectif du Projet S.A.R.A.H est la conception d’une maison intelligente connectée à l’internet des objets un peu dans l’esprit de la série TV Eureka. L’idée est de mettre des technologies avancées de reconnaissance vocale, gestuelle, faciale, de QRCode, … à la portée de tous pour réfléchir et innover sur l’ergonomie et les usages de demain. Ce framework S.A.R.A.H. est un projet français supporté sur une communauté google + de près de 3 000 membres à ce jour. Il est construit en C# (Kinect) client Pour la Voix, Gesture, reconnaissance faciale et de QRCode et NodeJS (ExpressJS) server pour la communication de l'internet des objets. Nous avons actuellement une version 3 disponible et plutôt stable et aussi une version 4 en beta. Pour piloter S.A.R.A.H. il faudra un PC, un micro ou Kinect (j'y reviens plus loin) et une sortie haut-parleur. Si l'on souhaite utiliser les fonctions de reconnaissance faciale, QRcode et un micro de meilleur qualité, il faudra implémenter un kinect xbox 360 V1 facile à trouver sur les sites d'occasion comme leboncoin.fr. Un kinect Xbox one peut également être utilisé. Il procurera une meilleure reconnaissance cependant, il nécessite une connection usb3 au PC, ainsi que windows 8.1. Je ne reviendrai pas ici sur l'installation de windows (7 ou 8.1). Une fois ce windows fraichement installé (pour ne pas rencontrer de soucis) nous pouvons passer à l'installation des prérequis de S.A.R.A.H. Je vais distinguer l'installation en V3 de celle en V4.

S.A.R.A.H V3

Sur un windows "normal" certaines étapes sont déjà faites par défaut. Ci-dessous les différentes étapes : Télécharger et dézipper SARAH ➔ Lorsque vous dézippez le package de SARAH il faut vous assurer de ne pas avoir d'espaces dans le nom du chemin d'accès. Par exemple SARAH pourra se trouver dans C:\SARAH\ mais pas dans C:\Chemin avec des espaces\SARAH\ (par défaut) Télécharger et installer .Net 4.5 Framework (déjà installé sur un windows 8) (par défaut) Télécharger et installer la version x86 ou (x64 en fonction de votre machine) Microsoft Speech Platform 11 ➔ Ainsi que la langue du moteur Microsoft Speech Platform - Languages 11 (optionnel) Installer une voix TTS ou utiliser la voix par défaut de Windows 8 ➔ la voix de Virginie fonctionne bien. ➔ la société Voxygen propose de nombreuses voix (parlez leur de SARAH !) ➔ En cas de problèmes, merci de consulter la FAQ Après toutes ces étapes SARAH est prête à être configurée. Si vous avez un Kinect merci de suivre les instructions ci-dessous afin de pouvoir l'utiliser. Kinect v1 Ce dispositif est très puissant et bien meilleur qu'un microphone ordinaire. Si vous en achetez un assurez-vous qu'il est livré avec le câble USB et son adaptateur. Attention ! Microsoft arrête la vente de Kinect 1 au profit de Kinect 2. Ci-dessous les instructions pour installer le Kinect v1 sous Windows : Télécharger et installer Kinect SDK v1.8 Télécharger et installer le Language Pack (au moment du téléchargement il faudra bien choisir "FR-fr" pour la langue) Quelques remarques à propos de l'installation d'un Kinect v1 : Certains utilisateurs ont indiqué avoir des soucis avec l'USB 3, Le Kinect consomme des ressources, si vous utilisez plusieurs Kinects avec de la vidéo, utilisez deux ports USB différents (les prolongateurs RJ45 ne marcheront pas). Mettre le Kinect en face de l'utilisateur Mettre les sources audio sur le côté ou derrière L'utilisateur doit parler 20db au dessus du son Les voix aigues sont mal reconnues Kinect v2 Ci-dessous les instructions pour la deuxième génération de Kinect : Télécharger et installer Kinect SDK v2 Télécharger et installer language packs v2 (au moment du téléchargement il faudra bien choisir "FR-fr" pour la langue) Dans SARAH v3 le Kinect2 est considéré comme un super Microphone (la partie Kinect n'est pas utilisée)

Configuration

Si vous souhaitez que SARAH fonctionne bien, il faut utiliser un bon micro. Dans cet article trois microphones (Microphone, Kinect et VoiceTracker II) ont été testés avec SARAH. Ci-dessous les prochaines étapes à suivre : Aller dans le répertoire profile/ et effacer le fichier profile.json (sinon SARAH risque de vous appeler Jean-Philippe de temps en temps !) Récupérer une Google API Key (voir ci-dessous) Regarder les différents paramètres disponibles dans le fichier config.ini Changer le volume d'entrée du son : aller dans ➔ Panneau de Configuration ➔ Chercher Gérer les périphériques audio ➔ Clique droit sur votre microphone ➔ Cliquer sur Propriétés ➔ Change le niveau (par exemple, pour un microphone classique, ce doit être ~90, et pour un Kinect, il faut tenter plusieurs configurations) Entrainer la reconnaissance vocale de Windows : aller dans ➔ Panneau de Contrôle ➔ Reconnaissance vocale ➔ Suivre les didactitiels de reconnaissance vocale(attention : avec un microphone classique il ne faut pas faire ce didacticiel plus d'une fois) Récupérer une Google API Key SARAH sait reconnaitre des commandes. Mais elle ne sait pas gérer les questions ouvertes: "SARAH recherche * sur wikipedia". Dans ce cas SARAH interroge l'API de Google. La Google API Key est nécessaire pour plusieurs plugins. Merci de suivre attentivement les différentes étapes décrites ci-dessous (instructions provenant du site http://www.chromium.org/developers/how-tos/api-keys) 1) S'enregistrer sur chromium S'enregistrer sur le Google Group chromium : S'assurer d'être un membre de [email protected] (vous pouvez souscrire à chromium-dev et choisir de ne pas recevoir d'emails). Pour cela, se rendre à l'adresse https://groups.google.com/a/chromium.org/forum/?fromgroups#!forum/chromium-dev Puis cliquer sur « Join the group to send a message »

Choisir « Do not send updates by email » Cliquer sur « Join the group »

2) Créer une App Console Créer une console app sur Google Se rendre sur https://cloud.google.com/console Click on « Create Project »

Donner un nom Accepter the Terms of Use Puis « Create »

3) Activer Speech Api Aller dans « APIs & Auth > APIs » à partir du menu à gauche Dans Browse API chercher « Speech API » Cliquer sur « Speech API »

Activer la clé

Accepter les terms of use

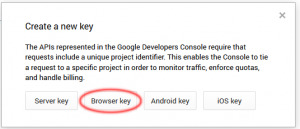

4) Créer une Speech Key Créer sa clé « Speech API » Aller dans « APIs & Auth > Credentials » à partir du menu à gauche Et sur le bouton « Create New Key »

Cliquer sur le bouton « Browser key »

Puis sur le bouton « Create »

Votre API key :

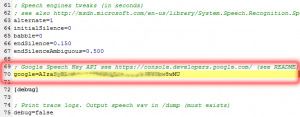

5) Intégration dans S.A.R.A.H. Intégration dans SARAH Ouvrir le fichier de configuration de SARAH (custom.ini) situé à la racine du répertoire d'installation de SARAH Chercher la ligne Google Speech Key API see https://console.developers.google.com/

Modifier la ligne ;google= : supprimer le point-virgule ; au début de la ligne ajouter la clé API juste après le égal =

Remarque : cette clé est pour votre usage exclusive et ne doit pas être utilisée par d'autres personnes.

Démarrer

Et finalement, voici comment démarrer SARAH : Démarrer le serveur : double-cliquer sur le fichier appelé Server_NodeJS.cmd ➔ une fenêtre MS-DOS s'ouvre affichant plusieurs lignes ➔ vous pouvez ouvrir le site web http://127.0.0.1:8080 dans votre navigateur pour voir l'interface de SARAH Démarrer le client - plusieurs options: Microphone (si vous n'avez pas de Kinect) : double-cliquer sur le fichier Client_Microphone.cmd; Kinect (pour n'utiliser que l'audio) : double-cliquer sur le fichier Client_Kinect_Audio.cmd; Kinect (toutes les fonctionnalités comme l'audio, la vidéo, reconnaissance des gestes, etc): double-cliquer sur le fichier . ➔ Une fois que le client est lancé une icône en forme de maison apparait alors près de l'horloge de Windows. Ça y est ! Vous pouvez maintenant utiliser SARAH et la tester en disant "SARAH quelle heure est-il ?". Et pour vous éclatez encore plus vous pouvez installer un plugin (voir ci-dessous). Si vous avez des problèmes, merci de se référer à la FAQ.

Plugins

SARAH fonctionne surtout grâce aux plugins. Installation AppStore La meilleure façon d'installer un plugin est de passer par le store : Ouvrir l'interface Web de SARAH (http://127.0.0.1:8080) Cliquer sur 'Store' (dans le menu de gauche) Choisir les plugins voulus et cliquer sur 'installer' (si l'opération échoue, retenter plusieurs fois) Redémarrer SARAH Manuellement Il est également possible d'installer manuellement un plugin. Pour ce faire il faut dézipper l'archive du plugin dans le répertoire plugins. La structure des fichiers sera alors: plugins/demo/demo.js plugins/demo/demo.prop plugins/demo/demo.xml Configuration Plugins Les plugins installés s'affichent dans l'interface Web (http://127.0.0.1:8080) sous forme de widgets.

Configuration Documentation Editeur de fichiers Certains plugins ont un widget personnalisé. Il faudra alors cliquer sur le bord droit pour pouvoir retourner le widget et voir apparaitre les trois boutons (cela ne fonctionne que sous Chrome). Utilisation Si vous ne savez pas comment utiliser le plugin, alors vous pouvez : Lire la documentation liée au plugin. Et s'il n'y a pas de documentation fournie, vous pouvez ouvrir le fichier XML pour trouver les commandes vocales disponibles.

Mise à jour de SARAH

Si vous voulez mettre à jour SARAH, vous devrez suivre les étapes ci-dessous : Sauvegarder (en renommant le répertoire) votre installation courante Télécharger et dézipper la nouvelle version Copier les fichiers/dossiers ci-dessous de votre ancienne installation vers la nouvelle : custom.prop: la configuration du serveur custom.ini: la configuration du client (être sûr que rien de nouveau n'a été ajouté dans ce custom.ini) plugins/*: vos plugins profile\profile.json: informations des profils enregistrés profile\faces: informations des visages enregistrés

S.A.R.A.H. V4

Sur un windows "normal" certaines étapes sont déjà faites par défaut. Ci-dessous les différentes étapes : Télécharger et dézipper SARAH ➔ Lorsque vous dézippez le package de SARAH il faut vous assurer de ne pas avoir d'espaces dans le nom du chemin d'accès. Par exemple SARAH pourra se trouver dans C:\SARAH\ mais pas dans C:\Chemin avec des espaces\SARAH\ (par défaut) Télécharger et installer .Net 4.5 Framework (par défaut) Télécharger et installer la version x86 Microsoft Speech Platform 11 ➔ Ainsi que la langue du moteur Microsoft Speech Platform - Languages 11 (optionnel) Installer une voix TTS ou utiliser la voix par défaut de Windows 8 ➔ la voix de Virginie fonctionne bien. ➔ la société Voxygen propose de nombreuses voix (parlez leur de SARAH !) ➔ En cas de problèmes, merci de consulter la FAQ Après toutes ces étapes SARAH est prête à être configurée. Si vous avez un Kinect merci de suivre les instructions ci-dessous afin de pouvoir l'utiliser. Kinect v1 Télécharger et installer Microsoft Kinect SDK 1.8 ➔ Ainsi que la langue du moteur Kinect for Windows Language pack v11 (optionnel) Installer le Kinect Developper Toolkit 1.8 pour jouer avec les exemples Dans client/custom.ini enable=true enable=false Sinon le Kinect est considéré comme un Microphone. Actuellement vous ne pouvez pas utiliser simultanément Kinect 1 et Kinect 2. Kinect v2 Télécharger et installer Microsoft Kinect SDK 2.0 ➔ Ainsi que la langue du moteur Kinect for Windows SDK 2.0 Language Packs (optionnel) Installer le Kinect Developper Toolkit 1.8 pour jouer avec les exemples Dans client/custom.ini enable=true enable=false Sinon le Kinect est considéré comme un Microphone. Actuellement vous ne pouvez pas utiliser simultanément Kinect 1 et Kinect 2. Reconnaissance Vocale Si vous souhaitez que SARAH fonctionne bien, il faut utiliser un bon micro. Dans cet article trois microphones (Microphone, Kinect et VoiceTracker II) ont été testés avec SARAH. Mettre le microphone devant vous en hauteur avec les sources sonore parasite sur le côté ou dans le dos. Changer le volume d'entrée du son : aller dans ➔ Panneau de Configuration ➔ Chercher Gérer les périphériques audio ➔ Clique droit sur votre microphone ➔ Cliquer sur Propriétés ➔ Change le niveau (par exemple, pour un microphone classique, ce doit être ~90, et pour un Kinect, il faut tenter plusieurs configurations) Entrainer la reconnaissance vocale de Windows : aller dans ➔ Panneau de Contrôle ➔ Reconnaissance vocale ➔ Suivre les didactitiels de reconnaissance vocale(attention : avec un microphone classique il ne faut pas faire ce didacticiel plus d'une fois)

Démarrer

Voici comment démarrer SARAH : Démarrer le serveur : double-cliquer sur le fichier appelé Start_Server.cmd ➔ une fenêtre MS-DOS s'ouvre affichant plusieurs lignes ➔ vous pouvez ouvrir le site web http://127.0.0.1:8080 dans votre navigateur pour voir l'interface de SARAH Démarrer le client : double-cliquer sur le fichier appelé Start_Client.cmd ➔ Une fois que le client est lancé une icône en forme de maison apparait alors près de l'horloge de Windows. Ça y est ! Vous pouvez maintenant utiliser SARAH et la tester en disant "SARAH quelle heure est-il ?". Et pour vous éclatez encore plus vous pouvez installer un plugin (voir ci-dessous). Si vous avez des problèmes, merci de se référer à la FAQ. Ne pas oublier la configuration de la google API Key. Voilà S.A.R.A.H. sera alors à vos ordres. Le placement du micro a une grande importance et il y a des ajustements à faire pour qu'elle reconnaisse bien ce qu'on lui demande. L'un des plugins à installer pour la suite est Jeedom. Il va permettre d'interfacer S.A.R.A.H avec le reste de la maison et nous verrons prochainement à quel point cela peut être intéressant. Une nouvelle version beta est disponible. Merci de votre lecture. Read the full article

0 notes

Photo

. KINECT XBOX ONE + S . . . . . . #kinect #kinect2 #kinectxbox #microsoft {#video_games} {#blackops} {#minecraft} {#videogames} {#blackops2} {#blackops3} {#instagaming} {#instagamer} {#playinggames} {#online} {#ps4} {#bo3} {#fifa} {#instagame} {#instagood} {#fifa17} {#uae} {#ksa} {#ultimateteam} {#gtav} {#cod} {#GAMER} {#سوني} {#حرامي_السيارات} {#توصيل} {#شحن} #JD4Games . {فلو 👤👥Follow} . {Like ❤👍❤ لايك} . {كومنت📋✔️} . {منشن أصدقائك 👬} (at Medina, Saudi Arabia)

#ksa#ps4#microsoft#fifa#blackops2#حرامي_السيارات#توصيل#fifa17#instagaming#instagood#bo3#jd4games#ultimateteam#kinect#video_games#kinectxbox#سوني#blackops3#playinggames#online#gtav#شحن#uae#kinect2#instagame#blackops#instagamer#cod#gamer#minecraft

1 note

·

View note

Video

youtube

Kinect2 Natural Interaction skeleton tracking tutorial in openFrameworks

0 notes

Text

import processing.video.*;

import blobDetection.*;

import org.openkinect.freenect.*;

import org.openkinect.freenect2.*;

import org.openkinect.processing.*;

Kinect2 kinect2;

BlobDetection theBlobDetection;

PWindow win;

PImage img;

float KinectImageSizeWidth = 1024;

float KinectImageSizeHeight = 748;

float kinectWidth = 512;

float kinectHeight = 424;

float offsetX = 0;

float offsetY = 0;

float scaleX = 1;

float scaleY = 1;

public void settings() {

size(1212, 824); //--------------------@@

}

void setup() {

//fullScreen();

kinect2 = new Kinect2(this);

kinect2.initDepth();

kinect2.initVideo();

kinect2.initIR();

kinect2.initDevice(0); //index 0 //Start tracking each kinect

// BlobDetection

// img which will be sent to detection (a smaller copy of the cam frame);

img = new PImage(80, 60);

theBlobDetection = new BlobDetection(img.width, img.height);

theBlobDetection.setPosDiscrimination(true); //-- true = dark, false = bright detect

theBlobDetection.setThreshold(0.55f); // will detect bright areas whose luminosity > 0.2f; //-- sensitivity

offsetX = (width - KinectImageSizeWidth) / 2;

offsetY = (height - KinectImageSizeHeight) / 2;

scaleX = KinectImageSizeWidth / 512;

scaleY = KinectImageSizeHeight / 424;

println(scaleX + " " + scaleY);

println(width + " " + height);

println(KinectImageSizeWidth + " " + KinectImageSizeHeight);

win = new PWindow();

win.kinect2 = kinect2;

win.theBlobDetection = theBlobDetection;

}

// ==================================================

void draw() {

// //----make it filtered Depth Image(B/W)--------------------------------------

int[] depth;

depth = kinect2.getRawDepth();

int threshold =1000;//1045(Ceiling to Head)//3800

//PImage display = createImage(kinect2a.depthWidth, kinect2a.depthHeight, RGB);

PImage video = kinect2.getDepthImage();

// Being overly cautious here

if (depth == null || img == null) return;

// Going to rewrite the depth image to show which pixels are in threshold

// A lot of this is redundant, but this is just for demonstration purposes

//--------filtered----------------------------------

// Filter depth and ignore pixels that are outside of the depth range that we are interested in.

video.loadPixels();

for (int x = 0; x < kinect2.depthWidth; x++) {

for (int y = 0; y < kinect2.depthHeight; y++) {

// mirroring image

int offset = (kinect2.depthWidth - x - 1) + y * kinect2.depthWidth;

// Raw depth

int rawDepth = depth[offset];

int pix = x + y*video.width;

if (rawDepth > 0 && rawDepth < threshold) {

video.pixels[pix] = color(200);

} else {

//display.pixels[pix] = video.pixels[offset]; // 0: black out / offset

video.pixels[pix] = color(0); // 0: black out / offset //0- under130 no tracking line

//255 - clear but white //130 coner draw

}

}

}

video.updatePixels();

background(80);

pushMatrix();

translate(offsetX, offsetY);

scale(scaleX, scaleY);

// Horizontal invert

//translate(offsetX + KinectImageSizeWidth, offsetY);

//scale(-scaleX, scaleY);

// println(scaleX + " " + scaleY);

//println(video.width + " , " + video.height);

image(video, 0, 0);

//image(video,0,0,width,height);//-----------------------------------------------@@

img.copy(video, 0, 0, video.width, video.height, 0, 0, img.width, img.height);

theBlobDetection.computeBlobs(img.pixels);

drawBlobsAndEdges(true, true, kinectWidth, kinectHeight);

drawLine(theBlobDetection, kinectWidth, kinectHeight);

popMatrix();

}

// ==================================================

void drawLine(BlobDetection blobs, float width, float height)

{

strokeWeight(4);

stroke(255);// blue 25, 25, 112

//float[] x = new float[20];

//float[] y = new float[20];

float[] x = new float[blobs.getBlobNb()];

float[] y = new float[blobs.getBlobNb()];

for (int n=0; n<blobs.getBlobNb(); n++)

{

Blob b = blobs.getBlob(n);

if (b!=null)

{

//check here again.

//background(204);

for (int i = x.length-1; i > 0; i--) {

x[i] = x[i-1];

y[i] = y[i-1];

}

x[0] = b.xMin*width+b.w*width/2; //topcenter

y[0] = b.yMin*height; //topcenter

for (int i = 1; i < x.length-2; i++) {

line(x[i-1], y[i-1], x[i], y[i]);

}

}

}

}

// ==================================================

void drawBlobsAndEdges(boolean drawBlobs, boolean drawEdges, float width, float height)

{

noFill();

Blob b;

EdgeVertex eA, eB;

for (int n=0; n<theBlobDetection.getBlobNb(); n++) {

b=theBlobDetection.getBlob(n);

if (b!=null) {

// Edges

if (drawEdges) {

strokeWeight(3);

//stroke(176, 196, 222);

stroke(0, 255, 0);

for (int m=0; m<b.getEdgeNb(); m++) {

eA = b.getEdgeVertexA(m);

eB = b.getEdgeVertexB(m);

// println("-----------"+ eA);

if (eA !=null && eB !=null )

line(

eA.x*width, eA.y*height,

eB.x*width, eB.y*height

);

//stroke(50,100,100);

//line(eA.x*width,eA.y*height,width/2,height/2);

}

}

// Blobs

if (drawBlobs) {

strokeWeight(1);

stroke(255, 0, 0);

rect(

b.xMin*width, b.yMin*height,

b.w*width, b.h*height

);

}

}

}

}

0 notes

Video

instagram

OBJI timelapse avec @prunetextile #magicmove #touchdesigner #obji #htcvive #kinect2 #pointcloud (à Montreal, Quebec)

0 notes

Video

instagram

When you fail to load yourself onto 'The Grid' #notch #kinect2 #pixelsandnoise #tron (at Godalming)

0 notes

Text

Project idea:

Use kinect2/Processing with the depth field parameter set to make a border in which subject only seen when piercing through.

0 notes

Text

People Are Just Particles in this Visually Stunning Performance

A version of this article originally appeared on The Creators Project Germany.

This article was originally published on November 25, 2014 but we think it still rocks!

Berlin-based interaction design studio Schnellebuntebilder are masters when it comes to transforming physical movements into stunning visuals. With MOMENTUM, they've teamed up with sound designers Kling Klang Klong to create "a synaesthetic experiences of sounds and visuals generated real-time from body movement," according to Schnellebuntebilder's Magdalena Eder.

MOMENTUM transforms the user into a sea of digital particles. It consists of "several blocks with different functions called nodes," explains Schnellebuntebilder's John Timpernagel. "There is a node that controls the Kinect2, created from the RGB data and infrared image of the dancer. From that data, [MOMENTUM] creates point-clouds that capture the depth of various points in space."

"We connect the data to a graphical system which puts the dancers' particles in motion. A hand movement to the right can push them [the particles] to the right," says Timpernagel.

Originally, MOMENTUM could only link movements to sounds and sound dynamics, which came from Kling Klang Klong. Based on the readouts of data points, paramaters were mapped to dancers' entire bodies. Quick hand movements could trigger wind noise. Making one's self small by squatting on the floor could induce a low-cut filter.

The soundscape consists of several layers. The first, a pre-produced track, forms MOMENTUM's musical backbone upon which the other layers are generated in real time. Parameters such as pitch can change over the course of the dancer's interactions.

Based on the generated sounds, the body's movements are also transformed into colorful images. "We had the data already, so now we could make nice visuals. MOMENTUM's first graphical interface was relatively ugly—now, we've connected the particle system to the data," Timpernagel tells The Creators Project.

The results look like flowing, colorful virtual reality creatures who exist in 3D space. It's a synesthetic experience of liquid forms and sounds that allow users to control and manipulate dynamic models with their own bodies.

Visit schnellebuntebilder's and kling klang klong's websites to see more of their works.

To learn more about Schnellebuntebilder click here.

0 notes