#falsación

Text

«El empleo que hago de los términos “objetivo” y “subjetivo” no es muy distinto del kantiano. Kant utiliza la palabra “objetivo” para indicar que el conocimiento científico ha de ser justificable, independientemente de los caprichos de nadie: una justificación es “objetiva” si en principio puede ser contrastada y comprendida por cualquier persona. “Si algo es válido —escribe— para quienquiera que esté en uso de razón, entonces su fundamento es objetivo y suficiente”.

Ahora bien; yo mantengo que las teorías científicas no son nunca enteramente justificables o verificables, pero que son, no obstante, contrastables. Diré, por tanto, que la objetividad de los enunciados científicos descansa en el hecho de que pueden contrastarse intersujetivamente.»

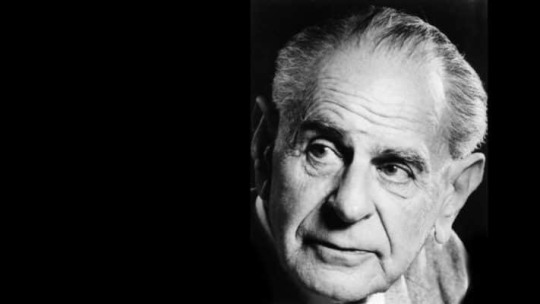

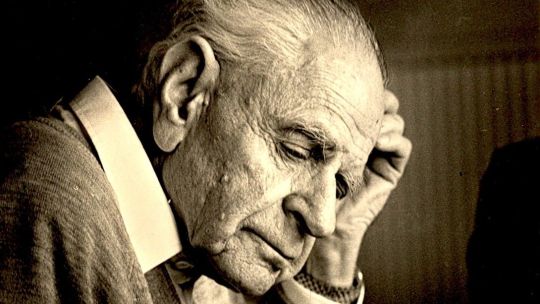

Karl R. Popper: La lógica de la investigación científica. Editorial Tecnos, pág. 43. Madrid, 1962.

TGO

@bocadosdefilosofia

@dias-de-la-ira-1

#karl r. popper#karl popper#popper#la lógica de la investigación científica#ciencia#teoría de la ciencia#filosofía de la ciencia#epistemología#objetividad científica#provisionalidad#enunciado#enunciado científico#objetividad#subjetividad#convicción#experiencias subjetivas#falsación#falsabilidad#intersubjetividad#contrastación intersubjetiva#contrastación#teorías científicas#kant#justificación#justificabilidad#uso de razón#razón#fundamento objetivo#fundamento suficiente#teo gómez otero

6 notes

·

View notes

Text

La nuevas generaciones ante la herencia recibida.

Las generalizaciones siempre son fallidas. El enunciado que afirma que todo A es B, tiene un uso ordinario habitual, pero está siempre sujeto a su falsación. De ahí que, debamos ser cautos con las generalizaciones que son formuladas a la ligera y que la realidad desmiente tarde o temprano.

Un caso concreto, en el que a menudo utilizamos este tipo de enunciados fallidos, es la percepción que de…

View On WordPress

0 notes

Photo

¡Holita! Continuamos este #viernes con el tag #AI en él reseñamos antologías por entregas. Así, continuamos con la 2º reseña de 'Vampiros… y más que vampiros (una antología de horror y sangre)' publicada por @valdemareditorial Espero que os guste. 😊💜. . 📜[Fragmento]📜. Creo que siempre que nos acercamos a narraciones en las que el objetivo es descubrir algo (quién es el asesino, cuál es el objeto o qué es lo que sucedió) la clave del asunto se basa en el razonamiento. Sin embargo, si profundizamos un poco más, siempre buscamos evidencias y, en este sentido, el «si no lo veo, no lo creo» cobra mucha importancia. En los relatos que vamos a reseñar en esta parte, será esa necesidad de falsación la que lleve a sus personajes a vivir situaciones que van más allá de su razonamiento y de su moral. Además, es curioso cómo este último elemento se incluye como otra vía para encontrar lo correcto. Así, vamos con los cuatro siguientes relatos de la antología, en este caso con innovaciones al género y al propio fenómeno del vampiro. Vamos con ellos. En esta ocasión reseñaremos: . 🦇𝕭𝖊𝖗𝖊𝖓𝖎𝖈𝖊, 𝕰𝖉𝖌𝖆𝖗 𝕬𝖑𝖆𝖓 𝕻𝖔𝖊, 1835. . 🦇𝕴𝖘𝖔𝖇𝖊𝖑, 𝖑𝖆 𝖗𝖊𝖘𝖚𝖈𝖎𝖙𝖆𝖉𝖆, 𝕮𝖑𝖆𝖚𝖉𝖊 𝖁𝖎𝖌𝖓𝖔𝖓, 𝖃𝕴𝖃 . 🦇𝕸𝖆𝖗𝖘𝖎𝖆𝖘 𝖊𝖓 𝕱𝖑𝖆𝖓𝖉𝖊𝖘, 𝖁𝖊𝖗𝖓𝖔𝖓 𝕷𝖊𝖊, 1900. . 🦇𝕰𝖑 𝖕𝖆𝖗á𝖘𝖎𝖙𝖔, 𝕬𝖗𝖙𝖍𝖚𝖗 𝕮𝖔𝖓𝖆𝖓 𝕯𝖔𝖞𝖑𝖊, 1894📚📚. . 🧐¿Os llama la atención alguno? ¿Conocíais alguno?🧐. . 💙Link de la reseña completa en la Bio 💙. . #antología #vampiros #lecturasrecomendadas #lecturasrecomendadas #bookfenix #bookstagramespaña #literatura #leoycomparto #instalibros #popularbooks #booklove #blog, #compartoloqueleo #leoycomento #book #libros #booklover #autoras #recomiendoautores #viviresleer #bookstagram #librosymaslibros #librosrecomendados #booksnifer . (en Fuenlabrada, Madrid, Spain) https://www.instagram.com/p/Ck0eFxHjDvD/?igshid=NGJjMDIxMWI=

#viernes#ai#antología#vampiros#lecturasrecomendadas#bookfenix#bookstagramespaña#literatura#leoycomparto#instalibros#popularbooks#booklove#blog#compartoloqueleo#leoycomento#book#libros#booklover#autoras#recomiendoautores#viviresleer#bookstagram#librosymaslibros#librosrecomendados#booksnifer

0 notes

Text

La temporalidad de las personas en el mundo es tan insistente como su propia salida de la vida en si misma.

Si cada ser es relativo según el entorno cambiante de las personas, las perspectivas relativas de cada uno no son más que una falsación que en el momento menos pensado se va a volver temporal y pasajera.

0 notes

Text

Sesgo de confirmación, otra vez...

«En general, los sujetos adoptan estrategias que persiguen la confirmación y no la falsación e incluso muestran una persistencia inadecuada al seguir defendiendo un argumento en el que creen a pesar de la evidencia contraria al mismo (Nisbett y Ross, 1980)».

Fuente: Leído en el capítulo «Psicología del razonamiento», escrito por María José González Labra, dentro del libro «Psicología del pensamiento», Sanz y Torres, ISBN: 978-84-16466-66-5, p. 36.

1 note

·

View note

Text

Minuta del n encuentro interestatal

Siento no poder prometer ningún drama, ningún breakdown, mucho menos puedo prometer que fue la última vez. Probablemente va a volverme a pasar porque soy insegura, ansiosa, porque tengo aún traumas sin trabajar y porque me da mucho miedo sentirme vulnerable, que me veas vulnerable y que pueda ser el rayo que cayó dos veces en el mismo sitio. Pero sí te prometo que lo estoy intentando y que todos los días me esfuerzo por ser mejor persona. Espero lo puedas ver. Espero que éso sea suficiente.

Un acto con "pretensión de bondad" debe (y esta exigencia deontológica es un deber en sentido estricto) hacerse cargo de sus consecuencias ..., en especial éticamente cuando son efectos negativos no-intencionales, pero no menos objetivos, observables, descubribles ... que los hechos empíricos de las ciencias "duras". Para que el agente permanezca con "pretensión de bondad" debe corregir su acto (su decisión, sus efectos). La falsación o corrección del acto no muestra que el acto era "malo" y que hubiera ahora que convertirlo en "bueno". El acto no podía ser "malo" porque fue seria y honestamente obrado teniendo clara "pretensión de bondad" -o habiendo, dentro de la condición humana finita, cumplido seriamente las condiciones universales-. El acto debe corregírselo no porque fuera "malo" (porque en ese caso nunca tampoco podrá ser "bueno", porque en realidad siempre habrá que efectuar una corrección continua, perfectiva pero no perfecta), sino porque toda "pretensión de bondad" presupone la finitud del acto y por lo tanto inevitablemente aspectos negativos (porque la decisión de la máxima no es perfecta, ni perfecta es la predicción de sus consecuencias). Es inevitable que "el justo cometa siete pecados por día" -dice un proverbio antiguo-. No por cometer pecado deja de ser "justo"; dejaría de ser "justo" si no corrigiera los efectos advertidos de sus pecados. El agente con "pretensión de bondad" no puede dejar de cometer actos injustos, pero debe honestamente corregirlos para seguir siendo "justo", es decir, un agente con permanente "pretensión de bondad". De esta manera, la universalidad de los principios no niega la contingencia de los actos; ni la necesidad de las condiciones universales la falibilidad, exigencia de falsación y corrección de los actos éticos. (Dussel, 2001:147)

Soy mis inseguridades, soy mi ansiedad, soy los traumas que tengo, las culpas que cargo, los miedos con que vivo, soy vulnerable, soy humana, "mi piel es tan frágil como la de un bebé. Soy huesos quebradizos y humanos, te digo, soy un brazo roto", pero también soy amor y soy ternura y comprensión y escucha atenta y cariño y compañía. Y si mis errores nublan el resto de lo que soy entonces quizá sea verdad que no hay futuro y está bien, pero ahora, en este momento, te veo en línea y me entristezco.

0 notes

Text

A propósito del título de “La doble rendija”

Por Pablo Canales Tejedor

Ediciones Dyskolo acaba de publicar el poemario “La doble rendija” de Daniel Noya. El texto que sigue a continuación figura en el libro a modo de epílogo y trata de buscar una explicación a su título a partir del célebre experimento llevado a cabo por Thomas Young, en 1801.

En mi época de estudiante cayó en mis manos una referencia bibliográfica que me inquietó: “Física para poetas”, de Robert March. No eran tiempos en los que acceder a un libro descatalogado estuviese a media docena de clicks de distancia y tuve que recorrer bibliotecas, librerías y ferias de libro para, después de un par de años o tres dar con él.

Me llamó poderosamente la atención por aquel entonces que la esfera del conocimiento objetivo de la naturaleza, la ciencia, se intentase fusionar con las emocionales, difusas y para mí poco precisas formas de los poetas. Pretendía encontrar en aquel título ese emulsionante que, como la yema del huevo, es capaz de mezclar íntimamente el agua y el aceite. Al final se trataba de un curso de física para estudiantes de letras muy bien escrito, pero sin ninguna pretensión poética.

Hoy me sorprende la referencia inversa. “La doble rendija” de Daniel Noya, no como texto científico sino como cabecera lírica. Se trata de un buen libro de poesía sin ninguna pretensión científica.

El de la doble rendija es uno de esos experimentos cruciales que introdujo importantes grietas en la eterna adolescencia del conocimiento humano. Un descubrimiento sorprendente que cuando se conoce, no permite concebir la realidad material de la misma manera que antes.

Una versión del mismo la realizó Thomas Young en 1801, con la finalidad de demostrar definitivamente que la luz, cuya naturaleza íntima se desconocía, era una onda. Una vibración de algo (luego se supo de qué) que se extendía por el espacio de forma análoga a como se extienden las olas del agua.

En ese experimento, al hacer pasar un haz de luz por dos rendijas muy juntas, se consigue la división del haz en dos partes, cada una de las cuales viaja extendiéndose en el espacio. Si finalmente ambos haces impactan en una pared, veremos, no dos líneas luminosas (la luz procedente de cada rendija) sino unas franjas brillantes y oscuras alternadas con asombrosa periodicidad. Ambos haces han interferido de manera análoga a como lo hacen las ondas del agua producidas al lanzar dos piedras en un estanque. Los frentes circulares, nacidos en el impacto de cada piedra con el agua, interfieren al juntarse produciendo máximos y mínimos. En ocasiones anulan su efecto en un punto y en otras lo refuerzan, dependiendo de si confluyen una cresta y un valle o dos crestas o dos valles. De la misma manera que las olas que llegan a la orilla de un acantilado y las olas que vuelven, a veces actúan conjuntamente y se elevan atrevidas y otras se apaciguan mutuamente frustrando nuestras expectativas.

En el caso de la luz que atraviesa dos rendijas muy juntas, en vez de obtener como imagen dos franjas luminosas debido a la luz que procede de cada rendija, se obtiene el patrón de interferencias. Esta característica es propia de las ondas, lo que permitió establecer la naturaleza ondulatoria de la luz. Conocer a la naturaleza por cómo se comporta, aunque no podamos verla (nadie puede ver de qué está hecha la luz, aunque nos permita ver...). La potencia de la falsación de los modelos para avanzar lentamente en el conocimiento.

Es evidente que si ese experimento de doble rendija se hace con materia, no con luz (por ejemplo un chorro de granos de arena o de agua) lo que observamos en la pantalla son los impactos separados de la arena o el agua que proviene de cada fuente. Caso de que coincidan en el espacio los procedentes de cada rendija siempre reforzarán su efecto, nunca lo anularán. La materia no es una onda.

La naturaleza de la constitución de la materia, que tras un par de milenios hemos podido elevar al siempre provisional podio de la verdad científica, es la que nos dejó como tarea Demócrito. Un agregado de diminutas partículas que él llamó, ya por entonces, átomos. Idea a la que llegó intuitivamente al carecer de la capacidad experimental que fuimos adquiriendo con el paso de los siglos.

Más o menos todos conocemos el argumento. Un puñado de partículas absolutamente invisibles a nuestra percepción (protones, electrones, neutrones...) que se agrupan en número diferente debido a atracciones o repulsiones eléctricas para formar átomos, que a su vez se agrupan para producir moléculas, que a su vez se agrupan para constituir agregados organizados de moléculas que forman estructuras, que se organizan para formar células, tejidos, organismos e individuos sensibles que se preguntan de qué están hechos. Todo como si fuese un enorme y complejísimo “Lego” con un puñado reducidísimo de piezas diferentes. Todavía no sabemos con certeza en qué parte de la película se produce el que algunos han considerado como milagro de la conciencia pero no renunciamos a entenderlo algún día.

Uno de los pilares lógicos en los que se basa toda esta teoría atómica está en la individualidad de esas partículas. Aunque iguales entre sí las de la misma clase, mantienen su individualidad espacial de manera que entre ellas no haya nada. Interaccionan y se influyen mutuamente, modificando su posición y movimiento según unas leyes bastante bien conocidas y universales aplicables a todos los cuerpos materiales. Ellas constituyen la materia. Fuera de ellas no hay nada. Salvo las ondas de luz.

A estas alturas de la historia, el nudo de la narración ya se intuye. ¿Qué pasa si conseguimos aislar esas partículas diminutas y hacerlas pasar por una doble rendija? Disponemos de tecnología para hacerlo y se ha realizado en multitud de ocasiones.

El resultado es que, en vez de obtener unos resultados como si de partículas se tratase, es decir que unas pasen por un rendija y otras por otra y finalmente obtengamos dos manchas en la pantalla, se obtiene un patrón de interferencias que no se puede explicar si no es con la asunción de que las partículas, al pasar por las rendijas, se desdoblan; ¿quizá como si fuesen una onda? Porque la figura aparece aún si hacemos pasar de una en una las partículas por las rendijas. Eso sí, siempre que no sepamos por cual de las rendijas ha pasado. Es decir haciendo el experimento sin fijarnos en las rendijas, sino solo en la pantalla.

La imposibilidad de esta situación de desdoblamiento de la partícula nos obliga a ser más cuidadosos y hacer la prueba definitiva. Acoplar un dispositivo que nos informe, en cada paso de la partícula por las rendijas, por cuál de las dos ha pasado, para por fin salir de la ilusión de sospechar que las partículas se han “ondulizado”.

En ningún caso la detección de la partícula se produce en las dos rendijas, faltaría más. Pero, si miramos entonces a la pantalla ¡la figura de interferencias ya no se produce! ¡Nuestro experimento con partículas, cuando sabemos si pasan por una rendija u otra, produce dos manchas de impactos! Incrédulos repetimos el experimento sin fijarnos en conocer por cuál de las rendijas ha pasado cada partícula y se vuelve a observar el comportamiento ondulatorio, es decir, la figura de interferencia.

Actualmente el experimento lo explica exitosamente la conocida como Mecánica Cuántica, que introduce unos elementos completamente nuevos y extraños a nuestra lógica. En ella la teoría establece que magnitudes como posición, velocidad energía, etc., de las partículas están indefinidas y determinadas por el entorno de una peculiar manera. Se habla de una superposición de estados posibles como la única manera de referirse a ellas… hasta que se produce la manifestación aleatoria (pero predecible probabilísticamente) de uno de los posibles estados. ¿Qué ha pasado con las otras posibilidades? ¿Por qué se ha producido el colapso del estado?

Hay que decir que a pesar de su aparente imprecisión, la mecánica cuántica ha permitido hacer predicciones de enorme exactitud.

La interpretación de esta situación ha traído a los físicos de cabeza durante años. Que si la teoría está incompleta, que si la naturaleza de la materia es dual a nivel microscópico y la naturaleza se protege de las contradicciones, que si la realidad es múltiple e indefinida (aunque predecible probabilísticamente) y su definición en uno u otro sentido es aleatorio.

Las implicaciones que sobre nuestra idea del mundo tiene el admitir esta especie de no localidad e indefinición espacio temporal de los entes individuales de los que estamos formados han cambiado la manera de pensar en la realidad.

Quizá en eso se parezca finalmente la experiencia poética y la científica. Ambas modifican nuestra forma de ver la realidad, cualquiera que esta sea.

La doble rendija

Daniel Noya Peña

Colección: Poesía

1ª edición julio 2021

70 páginas.

Ediciones Dyskolo

ISBN: 978-84-124082-0-1

Página del libro: https://www.dyskolo.cc/cat%C3%A1logo/lib066/

0 notes

Text

¿Vino viejo en botellas viejas? ¿Un Nobel para un astuto envoltorio?, por Mises Hispano.

El Premio Sveriges Riksbank en Ciencias Económicas en Memoria a Alfred Nobel 2018 se otorgó el 8 de octubre a Paul Romer, Profesor de la Universidad de Nueva York, “por integrar las innovaciones tecnológicas en el análisis macroeconómico a largo plazo”, específicamente por lo que a veces se denomina “Nueva teoría del crecimiento”. Compartió el premio con el profesor William Nordhaus, profesor de la Universidad de Yale (y Bonesman), quien lo recibió “para integrar el cambio climático en el análisis macroeconómico a largo plazo”. El Premio Romer había sido previsto durante mucho tiempo.

Como era de esperar, los comentaristas, economistas, expertos, etc. han adulado los “descubrimientos” de Romer y Nordhaus (incluido al menos un importante austriaco contemporáneo que aparentemente no ve problemas en tratar el “conocimiento” como un factor de producción homogéneo). Nada nuevo aquí, y nada de malo en celebrar un gran avance científico. Esto vale la pena, claro, y por supuesto, un gran forraje para los tuiteros y blogueros. Pero, el Nobel de este año es particularmente ilustrativo de lo que se recompensa en economía, y cómo esto no se ajusta exactamente con nociones más intuitivas de progreso científico.

Si se nos pregunta qué entendemos por “progreso científico”, el proverbial (Wo)Man in the Street probablemente respondería algo así como “Señalando nuevos fenómenos de los que nadie ha sido consciente hasta ahora”, “Explicar los fenómenos de una manera fundamentalmente novedosa” o similar.

Por cierto, muchos filósofos estarían de acuerdo. Por ejemplo, para muchos científicos, Karl Popper es una referencia estándar y muchos científicos no solo podrán invocar sino también explicar el “criterio de falsación” (solo las teorías que pueden ser rechazadas por hechos pueden considerarse “científicas”). Popper, por supuesto, se trata de proponer nuevas predicciones. Su seguidor Imre Lakatos estaría de acuerdo: el avance científico consiste en formular teóricamente y corroborar empíricamente los “hechos novedosos”, nuevas ideas en el mundo que la generación anterior de científicos había pasado por alto.

Los economistas están familiarizados con una versión bastarda del popperianismo, a saber, el famoso énfasis de Milton Friedman en las teorías económicas como herramientas de predicción. Por lo tanto, estas ideas ciertamente tienen moneda en la economía. ¿Practican los economistas lo que (muchos de ellos) predican, en particular que el progreso científico equivale a presentar hechos novedosos y/o mecanismos explicativos novedosos en forma de nuevas y audaces hipótesis? El difunto Mark Blaug señaló repetidamente que no lo hacen. El reciente Nobel puede confirmar esto.

Considere cómo el Comité de Premios justifica el Premio a Romer :

Romer demuestra cómo el conocimiento puede funcionar como motor del crecimiento económico a largo plazo. Cuando el crecimiento económico anual de un pequeño porcentaje se acumula durante décadas, transforma las vidas de las personas. Las investigaciones macroeconómicas anteriores habían enfatizado la innovación tecnológica como el principal motor del crecimiento económico, pero no habían modelado cómo las decisiones económicas y las condiciones del mercado determinaban la creación de nuevas tecnologías. Paul Romer resolvió este problema demostrando cómo las fuerzas económicas gobiernan la disposición de las empresas para producir nuevas ideas e innovaciones.

No hay ninguna duda de que Romer es un modelador y economista extremadamente inteligente (que en estos días suele ser lo mismo). Pero, fíjese en la redacción del comunicado de prensa: faltaba “investigación previa” porque no había “modelado” un cambio técnico endógeno. El comunicado de prensa no dice que Romer descubrió algo nuevo per se.

Hace muchos años, reflexioné sobre el éxito entre los economistas investigadores de la nueva teoría del crecimiento que se cree que Romer creó. El punto clave fue que la esencia de los mecanismos explicativos propuestos y modelados por Romer y otros nuevos teóricos del crecimiento se conoce desde al menos la labor de Allyn Young en la década de 1920 sobre el aumento de los retornos y las externalidades en el proceso de crecimiento. Kenneth Arrow, otro premio Nobel, destacó el papel de aprender haciendo en el crecimiento. El economista evolutivo Richard Nelson ha argumentado que gran parte del contenido de la nueva teoría del crecimiento se puede encontrar en la obra de Moses Abramovitz en la década de 1950. Cuando los economistas hablan de las contribuciones de Romer (y de otros) como la “Nueva teoría del crecimiento”, la “vieja” teoría implícitamente referida es muy específicamente la teoría de Robert Solow desde mediados de la década de 1950, que no solo tenía implicaciones novedosas sino que también Una teoría formal. Sin embargo, la “vieja teoría” no incluye los muchos pensamientos sobre el proceso de crecimiento que los economistas han ofrecido (casi) desde Adam Smith.

Por ejemplo, Mises y Hayek, e incluso antes, Carl Menger señaló que el progreso científico y el avance general del conocimiento están fuertemente interrelacionados con el proceso de crecimiento. Además, ellos, y muchos de los primeros escritores sobre el proceso de crecimiento, destacaron la importancia de las instituciones —los derechos de propiedad privada, el estado de derecho y el sistema de precios— para promover el crecimiento, y enfatizaron que el avance del conocimiento está determinado en gran medida por tales instituciones Cualquier lector de, por ejemplo, el Socialismo de Mises reconocerá este tema. El Premio Nobel Douglass North pensó que estos aspectos estaban tan ausentes en la Teoría del Nuevo Crecimiento que planteaba todas las preguntas importantes.

Por supuesto, aquellos que están familiarizados con la economía moderna saben que “progreso” significa principalmente lo que podría llamarse “progreso heurístico”: modelos mejores, más elegantes y más limpios que, por ejemplo, logran endogenizar lo que hasta ahora se ha considerado endógeno. . Como escribí en 1998: “Esto, entonces, explica el éxito de la [Nueva Teoría del Crecimiento]: el advenimiento de la NGT significó que un problema recalcitrante (endogenizar el cambio tecnológico en el contexto del crecimiento económico) podría tratarse de manera formal. términos, y así asimilados en la economía neoclásica “.

Sin duda, estos ejercicios pueden tener un valor muy importante, al hacer algunas suposiciones explícitas, ilustrar mecanismos particulares y similares. (No siempre) Pero, poner las ideas existentes en un idioma diferente no constituye, por sí solo, un gran avance en la comprensión científica. Para esto necesitamos nuevas explicaciones causales de los fenómenos (como la explicación de Menger sobre la formación de precios, la crítica de Mises a la planificación socialista, los avances de la teoría del ciclo económico de Hayek, etc.). Por ejemplo, la famosa crítica de Mises incluía la predicción de que el socialismo no puede funcionar por razones muy específicas relacionadas con la fijación de precios y la asignación de bienes de capital. Hay una diferencia enorme, y quizás categórica, entre tales predicciones fundamentales y encontrar nuevas formas de ubicar las perspectivas existentes, aunque informales, en modelos establecidos, como el equilibrio general neoclásico.

El artículo original se encuentra aquí.

de Mises.org.es https://ift.tt/2PVLmfl

https://ift.tt/2Dmh3HX

de nuestro WordPress https://ift.tt/2qPnWKd

Difundimos las ideas liberales, libertarias, minarquistas y anarcocapitalistas. https://ift.tt/2Dmh3HX November 16, 2018 at 07:01AM

0 notes

Text

Ventajas y desventajas de la Terapia Cognitivo-Conductual

[La psicología es una ciencia compleja](/psicologia/psicologia-ciencia), en la cual existen muy diversos paradigmas los cuales estudian la psique desde perspectivas diversas. En la actualidad, una de las mejor valoradas y que cuenta con mayor evidencia empírica es [la cognitivo-conductual](/clinica/terapia-cognitivo-conductual), la cual ha ido generando una gran cantidad de técnicas en su uso terapéutico. **La aplicación de las terapias de esta corriente teórica tiene una serie de grandes ventajas, pero también presenta algunas limitaciones** e inconvenientes en comparación con las de otros paradigmas. A lo largo de este artículo vamos a comentar algunas de las principales ventajas y desventajas de la terapia cognitivo-conductual, con el fin de aprender de ellos y valorar cómo pueden mejorarse y en qué sentido puede aprender de otras corrientes y desarrollos. * Artículo recomendado: ["Los 10 tipos de terapia psicológica más eficaces"](/clinica/tipos-terapia-psicologica-mas-eficaces) ## La terapia cognitivo-conductual: una definición básica **Se conoce como terapia cognitivo-conductual al tipo de terapia y conjunto de técnicas que parten del modelo cognitivo-conductual**. Este tipo de terapia se basa en la identificación y posterior trabajo de las creencias y pensamientos disfuncionales que generan sufrimiento o disfuncionalidad al paciente, así como a su manera de relacionarse emocionalmente con ellos. Se parte del modelo cognitivo-conductual, el cual es heredero de la perspectiva conductista al cual se incorporan los avances del cognitivismo. Dicho modelo parte de una metodología estricta y basada en el método científico, investigando en base a la observación empírica y la experimentación y partiendo de la verificación y falsación de los hipótesis experimentales. Se pretende evaluar de manera científica y objetiva la conducta humana y los procesos mentales que la rigen, operativizando y haciendo medibles constructos abstractos como los propios de la cognición y la emoción. El principal trabajo se lleva a cabo con las cogniciones y con las conductas que se llevan a cabo, con un enfoque en el que se pretende enseñar al paciente a modificar sus expectativas, creencias y miedos así como en alterar los patrones de conducta disfuncionales que se llevan a cabo a causa de estos. Se trabaja a través del [aprendizaje](/desarrollo/tipos-de-aprendizaje) y la modificación de cogniciones y conductas, pudiendo tener el terapeuta diferentes grados de directividad en la terapia pese a que su papel es el de guía o apoyo en el proceso de cambio. ## Principales ventajas **La terapia cognitivo-conductual es una de las más valoradas a nivel científico**, y se trata sin duda alguna de la corriente teórica que en mayor grado se enseña a nivel universitario. Una gran mayoría de los psicólogos actuales siguen o han partido inicialmente del enfoque cognitivo-conductual para desarrollarse profesionalmente. Y ello se debe a que esta terapia ofrece una gran cantidad de ventajas respecto a otros enfoques, entre las que podemos mencionar las que siguen. ### 1. Basado en el método científico Una de las más destacadas virtudes de la terapia cognitivo conductual se encuentra en que el modelo del que **emplea una metodología experimental que permite el análisis objetivo de los resultados de la terapia**, de manera que se encuentra muy asociada al método científico. Es posible elaborar hipótesis basadas en informaciones previas para posteriormente comprobarlas experimentalmente e incluso replicar sus resultados. Dicho de otra manera, establece una metodología que permite que la psicología avance como ciencia. ### 2. Evidencia empírica de su gran efectividad La terapia cognitivo-conductual **es el tipo terapia que presenta mayor evidencia empírica en lo que respecta a la efectividad de las técnicas y subtipos de terapia** que utiliza, en base a la reducción de la sintomatología de los diferentes trastornos a tratar. ### 3. Flexibilidad **La terapia cognitivo-conductual tiene como otra de sus grandes ventajas el hecho de ser extremadamente versátil**. Y es que a menudo podemos encontrar como los especialistas en este tipo de terapia aceptan e integran técnicas procedentes de otros enfoques, como la terapia psicodinámica, la humanista o la gestalt. Asimismo, evoluciona incorporando nuevas maneras de actuar o relacionarse con el paciente (como el constructivismo) así como nuevas teorías y técnicas (como las contextuales). ### 4. Sujeto como agente activo En algunos paradigmas de la psicología el sujeto es visto como un agente pasivo, alguien que reacciona al medio de forma prácticamente automática. El enfoque cognitivo-conductual fue uno de los primeros en que empezó a verse que es la acción del propio sujeto el que puede llevar a la superación o a la reducción de los síntomas: la terapia pretende dar instrumentos al sujeto para que por sí mismo pueda hacer frente o modificar aquello que genera malestar. ### 5. Valora el papel de lo cognitivo en la conducta Nuestros pensamientos, creencias, perspectivas y capacidades, así como la manera en que procesamos la información del entorno, resultan analizables y trabajables desde el paradigma cognitivo-conductual. Es importante el hecho de que se trabaje no solo el contenido sino el cómo se llega a él y las estructuras y esquemas mentales que influyen en su aparición. ### 6. Altamente sistematizada Además de adscribirse al método científico, otra de las grandes ventajas de esta terapia es su elevado grado de sistematización. Aunque depende de la técnica en cuestión puede existir mayor grado de libertad, por lo general las técnicas empleadas por la terapia cognitivo-conductual tienen unas bases, estructura y una forma de proceder bastante claras (si bien el terapeuta deberá adaptarse a las respuestas que dé el paciente). ### 7. Permite adquirir competencias y habilidades La terapia cognitivo-conductual se basa en gran medida en el aprendizaje como medio para generar, modificar o eliminar conductas o productos mentales desadaptativos. Asimismo, su actuación hace que el sujeto adquiera capacidades que anteriormente no poseía o que podrían beneficiarse de un cambio o un entrenamiento, de una manera que no solo puede ayudar a solventar un problema actual sino también favorecer y optimizar la adecuación y adaptación al medio. ### 8. Efectiva en una gran cantidad de condiciones Otra de las grandes ventajas de este tipo de terapia es su amplia aplicabilidad en la mayoría de trastornos mentales existentes, e incluso en situaciones no patológicas. Así, se puede trabajar en problemas como ansiedad, depresión, problemas obsesivos, trastornos de la conducta alimentaria o trastornos sexuales, entre otros muchos. ## Desventajas y limitaciones del modelo cognitivo-conductual El modelo de terapia cognitivo-conductual, tal y como hemos visto, resulta de gran utilidad y permite el tratamiento de gran cantidad de alteraciones mentales. Sin embargo, **presenta una serie de limitaciones que cabe tener en cuenta. Entre ellas podemos destacar las siguientes**. ### 1. Focalización en el síntoma actual La terapia cognitivo-conductual **se centra en gran medida en trabajar las dificultades y el conjunto de síntomas que se encuentran presentes en la actualidad**. Es decir trabaja desde el presente y en lo que ahora nos ocurre. Si bien el pasado se tiene en cuenta y se explora de cara a explicar la situación actual, a nivel de terapia no suelen tratarse de manera directa las causas que empezaron el problema que hoy aflige al sujeto. Y en muchas ocasiones se requiere trabajar los elementos que originaron en primer lugar el malestar, pues de otro modo el malestar puede llegar a aparecer bajo otra forma. ### 2. Excesivamente cognitivista Si bien una de las ventajas de esta terapia se encuentra en que trabaja en profundidad aspectos tan relevantes como las creencias, expectativas y procesos de pensamiento, factores de gran relevancia a la hora de explicar nuestras conductas, lo cierto es que en ocasiones **la terapia cognitivo-conductual puede pecar de reduccionismo** y de valorar en menor medida aspectos como la emoción y la motivación. No es que no trabajen elementos emocionales, pero el trabajo en este ámbito se hace desde una perspectiva racional y no tan emocional o vivencial. ### 3. Efectivas, pero.. ¿por qué? Las terapias cognitivo-conductuales gozan de una gran efectividad y los diversos estudios realizados suelen dar fe de ello. Sin embargo, **ofrecen poca información respecto al motivo por el que son efectivos o por qué en ocasiones puede llegar a fracasar**. Se ha observado qué técnicas funcionan mejor, pero se ha prestado poca atención al porqué. ### 4. Focalización en el individuo: poca valoración del contexto La terapia cognitivo-conductual tiene presente que el entorno es un factor relevante en el origen, mantenimiento e incluso tratamiento de los trastornos mentales, pero **tiende a centrarse en exclusiva en el sujeto que tiene el problema o la dificultad** y deja de lado la mayoría de elementos contextuales que afectan a las problemáticas en cuestión. Esta limitación parece estar solventándose con la aplicación de las terapias de tercera generación, que poco a poco gozan de cada vez mayor popularidad. ### 5. Relación terapéutica aséptica e instrumental En la terapia cognitivo-conductual se tiene en cuenta el elevado valor de la relación terapéutica, pero **históricamente ha tendido a verse como una vía a través de la que aplicar las técnicas**. En los últimos años sin embargo, y especialmente en las terapias contextuales, se trabaja cada vez más en la relación terapéutica como un elemento per se terapéutico, probablemente uno de los más (si no el que más) relevancia tiene para predecir el éxito de la terapia. Algunos pacientes indican también que este tipo de técnicas, aunque efectivas, son frías y no valoran ni terminan de comprender el sufrimiento que padecen, algo que dificulta que confíen en ellas y que estas tengan éxito. ### 6. Posible rigidez como consecuencia **La terapia cognitivo-conductual clásica se centra en combatir, cambiar o modificar los pensamientos, creencias y conductas que generan sufrimiento al sujeto**. Se tiene una estrategia de oposición al sufrimiento, que en principio puede parecer positiva pero que sin embargo puede empujar al paciente a una conducta cada vez más rígida dirigida a evitar el dolor y que conlleve un patrón conductual poco adaptativo, lo que a su vez puede ser el origen de nuevos sufrimientos. #### Referencias bibliográficas: * Caballo, V.E. (1998). Manual de técnicas de terapia y modificación de conducta. Siglo XXI. * Caro, I. (2009). Manual teórico-práctico de Psicoterapias Cognitivas. Biblioteca de Psicología Desclée de Brouwer. * Vila, J. & Fernández, M.C. (2004). Tratamientos psicológicos. La perspectiva experimental. Madrid: Pirámide.

Ver Fuente

Ver Fuente

0 notes

Text

Sesión #3

Agenda para el martes 6 de febrero de 2018

Actualicémonos

Glosario

Sesión #3: ciencia, investigación y diseño

Taller #2

Próxima sesión

1. Actualicémonos

youtube

Seguir viendo: https://www.netflix.com/co/title/80134797

Blog

Seleccionemos uno: https://designresearchlab.tumblr.com/clase-2018-1

2. Glosario

Construcción colaborativa de un glosario con los términos más representativos de la asignatura:

¿Quién lo va a hacer?

¿Dónde se va a hacer?

¿Cuál será la estructura?

Lectura recomendada

3. Ciencia, investigación y diseño

3.1 Epistemología

Se puede entender la epistemología como una reflexión sobre los fundamentos y métodos del conocimiento científico. En palabras de Bunge (1980) “es la reflexión crítica sobre la investigación científica y su producto, el conocimiento, en otras palabras, es la ciencia de la ciencia”. Según García (1997), si una disciplina se maneja sin epistemología, el proceso del conocimiento se inhibe, la producción técnica y científica se vuelve precaria, y su impacto e influencia en el medio resultan muy pobres (Citado por Bernal, 2010).

Añade Bernal (2010):

Queda claro, entonces, que la epistemología es un llamado a reflexionar sobre la ciencia en general y en torno a cada disciplina en particular, y que en la actual sociedad del conocimiento este campo de la reflexión se vuelve indispensable para todos los seres humanos, especialmente para los académicos y los profesionales, quienes deben estar en capacidad de opinar de manera crítica sobre los diferentes aspectos que enfrentan a diario. Sin embargo, se debe tener presente que si bien en la actualidad todos pueden opinar sobre cualquier aspecto de la vida, en la academia, especialmente en la universidad, son fundamentales la argumentación racional y la actitud científica. La sociedad del conocimiento exige cada vez más las condiciones éticas, cognitivas y reflexivas mínimas para opinar.

En esta sociedad, más participativa, los académicos requerimos argumentos y una actitud reflexiva, no sólo especulación ni sólo buenas intenciones. Esto es un requisito indispensable para toda persona que se inicie en su formación profesional. Por tanto, se necesita que el futuro profesional esté consciente de que en la universidad toda opinión debe ser argumentada y no simple especulación, pues ello será parte de su formación como profesional. El avance o el estancamiento de las diferentes disciplinas y de la ciencia misma dependerá de la capacidad epistemológica de los profesionales de la respectiva disciplina, así como de la capacidad de la propia profesión o campo del conocimiento para reflexionar sobre sí misma y acerca de la realidad cambiante de la cual forma parte. (pág. 27-28)

En síntesis, la epistemología es un llamado a reflexionar sobre la ciencia en general y en torno a cada disciplina en particular, indispensable para todos los seres humanos, especialmente para los académicos y los profesionales, quienes deben estar en capacidad de opinar de manera crítica sobre los diferentes aspectos que enfrentan a diario. El avance o el estancamiento de las diferentes disciplinas y de la ciencia misma dependerán de la capacidad epistemológica de los profesionales de la respectiva disciplina, así como de la capacidad de la propia profesión o campo del conocimiento para reflexionar sobre sí misma y acerca de la realidad cambiante de la cual forma parte. (p. 31)

3.2 Ciencia

La definición de ciencia, según la RAE:

Del lat. scientia.

1. f. Conjunto de conocimientos obtenidos mediante la observación y el razonamiento, sistemáticamente estructurados y de losque se deducen principios y leyes generales con capacidad predictiva y comprobables experimentalmente.

2. f. Saber o erudición. Tener mucha, o poca, ciencia. Ser un pozo de ciencia. Hombre de ciencia y virtud.

3. f. Habilidad, maestría, conjunto de conocimientos en cualquier cosa. La ciencia del caco, del palaciego, del hombre vividor.

4. f. pl. Conjunto de conocimientos relativos a las ciencias exactas, físicas, químicas y naturales.

Según Mario Bunge

Mientras los animales inferiores sólo están en el mundo, el hombre trata de entenderlo; y sobre la base de su inteligencia imperfecta pero perfectible, del mundo, el hombre intenta enseñorarse de él para hacerlo más confortable. En este proceso, construye un mundo artificial: ese creciente cuerpo de ideas llamado “ciencia”, que puede caracterizarse como conocimiento racional, sistemático, exacto, verificable y por consiguiente falible. Por medio de la investigación científica, el hombre ha alcanzado una reconstrucción conceptual del mundo que es cada vez más amplia, profunda y exacta (p. 1).

Añade Bernal (2010):

[...] La polémica que desde el siglo XVIII d. C., ha venido dándose en relación con el concepto de ciencia social, muestra que históricamente la ciencia se ha conceptuado desde diversos enfoques que tienen concepciones diferentes de la realidad y, por consiguiente, plantean métodos distintos para la generación del conocimiento científico, lo cual origina la pluralidad de métodos que existen en la investigación científica actual, cada uno de ellos con sus propias fortalezas y debilidades. Los principales enfoques de polémica sobre el concepto de ciencia social se resumen en los siguientes:

Enfoque positivista (David Hume, Francis Bacon, Auguste Comte, William James y J. Stuart Mill) Considera que todo conocimiento para ser científico ha de acomodarse a los criterios de la ciencia natural caracterizada por el monismo metodológico (fisico-matemático) y homogeneidad doctrinal; la explicación causal expresada por leyes y la predicción de los fenómenos. (p.45)

Enfoque hermenéutico (Droysen, Dilthey y Weber, en los siglos XVIII y XIX, y en el siglo XX Windelband, Rickert, Croce y Collingwood, entre otros) Rechaza el monismo metodológico, la física matemática como canon regulador de toda explicación científica y el afán predictivo, causalista, de la ciencia. Propone la comprensión como el método propio de las ciencias sociales así como la unidad sujeto-objeto y la generación de principios y no leyes en la ciencia. (p.45)

Enfoque neopositivista o positivismo lógico del Círculo de Viena (Schick, Carnap y Wittgenstein) Asume una actitud antimetafísica y enfatiza que en la ciencia todo debe someterse a observación directa y a comprobación mediante la experimentación. La ciencia debe caracterizarse por un lenguaje científico universal, por la precisión y la formalización en sus enunciados, por la comprobación y verificación empírica de todas las afirmaciones. (p.45)

Enfoque del racionalismo crítico (Popper) Arremetió contra el positivismo lógico por pretender verificar empíricamente todo enunciado científico, ya que la ciencia no es un saber seguro sino hipotético conjetural, que se construye con el método deductivo y no inductivo, que debe someterse a la falsación y no a la verificación. Para Popper, la ciencia no es posesión de la verdad, sino búsqueda incesante, crítica, sin concesiones de la misma. (p.45)

Enfoque de la teoría crítica de la sociedad (Horkheimer, Teodor Adorno, Herbert Marcuse, Erich Fromm, Jürgen Habermas y K.O. Apel) Considera que el problema de la ciencia no debe consistir en mostrar si un enunciado responde o no a los hechos empíricos para darle la categoría de conocimiento científico, sino que ha de ser una crítica que orienta a la anticipación de un modo de sociedad que facilite que el ser humano sea cada vez más humano y mejor. (p.45)

Enfoque de la estructura de las revoluciones científicas (Kuhn) Asegura que la comunidad científica se constituye mediante la aceptación de paradigmas que durante un tiempo determinado ofrecen un modelo de problema y de soluciones para quienes trabajan en un campo de investigación. Según este enfoque, el progreso científico no se da por acumulación de certezas (verdades) que produce un paradigma, sino por la sustitución del vigente por uno nuevo que se impone gracias a una revolución científica. (p.46)

Enfoque de programas de investigación científica (Lakatos) Afirma que la ciencia es un conjunto de programas de investigación (conjunto de teorías con concepciones distintas y a veces opuestas de estudiar la realidad), que coexisten y compiten entre sí. De esta manera, la ciencia progresa por la competencia permanente que se establece entre esos programas de investigación, que pretenden ofrecer mayor eficacia ante las diversas y nuevas situaciones que cotidianamente surgen de la realidad. (p.46)

Enfoque del anarquismo metodológico (Feyerabend) Rechaza todo postulado absoluto que impida llevar adelante una nueva o diferente forma sistemática de conocer e interpretar el mundo. Considera que la adherencia dogmática a cualquier método científico resulta ineficaz para el progreso de la ciencia, porque ningún método, por excelente que parezca para conocer la realidad, es aplicable con efectividad para el estudio de todos los casos. (p.46)

Enfoque de la complejidad y la integración del conocimiento (Morin) Hace énfasis en la complejidad como un rasgo general de la realidad, dentro de la cual está la del propio ser humano, que se caracteriza por la multidimensionalidad. Desde esta perspectiva, la ciencia debe ser, entonces, un conocimiento abierto, inacabado y autocorrectivo, que integra saberes y conjuga: orden y caos, armonía y disfuncionalidad, determinismo y casualidad. (p.46)

3.3 Metodología

De acuerdo con Vilches (2014):

Toda disciplina está estructurada con base en un sistema tripartito cuyo esquema integra a la teoría -fundamentos, leyes generales, conceptos, etc.-, al método -modelos de organización del pensamiento- y a la técnica -procedimientos prácticos y operativos-. Es importante comprender que en una misma disciplina existen tantos métodos como corrientes de pensamiento y la validez de cada uno estriba en el contenido que se le adjudique y en sus vinculos con los objetos de estudio (p.15)

Según Tamayo y Tamayo (1999):

Entendemos por método un orden o procedimiento, a partir de la lógica del

pensamiento científico que surge de la teoría. Teoría y método van siempre

juntos, mientras que la metodología es la parte instrumental de la investigación, y como tal lleva al objeto de investigación. (p.29)

3.4 Investigación

Para Tamayo y Tamayo (1999):

La investigación científica, como base fundamental de las ciencias, parte de la realidad, investiga la realidad, la analiza, formula hipótesis y fundamenta nuevas teorías. El conocimiento de la realidad es la mayor garantía para cualquier proceso investigativo. Si durante el desarrollo de este proceso el investigador no se sirve de un diseño previo, de una estructura básica, su trabajo puede resultar infructuoso.

La investigación es un proceso que, mediante la aplicación del método científico, procura obtener información relevante y fidedigna, para entender, verificar, corregir o aplicar el conocimiento. (p.34)

3.4.1 Modernidad

Según Arturo Escobar:

“La modernidad es un período histórico que aparece, especialmente, en el norte de Europa, al final del siglo XVII y se cristaliza al final del siglo XVIII. Conlleva todas las connotaciones de la era de la ilustración, que está caracterizada por instituciones como el Estado-nación, y los aparatos administrativos modernos. Tiene, por lo menos, dos rasgos fundamentales que todos los teóricos enfatizan. El primero es la autorreflexidad. Giddens y Habermas quieren decir con esto que la modernidad es ese primer momento en la historia donde el conocimiento teórico, el conocimiento experto se retroalimenta sobre la sociedad para transformar, tanto a la sociedad como al conocimiento. Eso con la era de la información ha llegado a un nivel supersofisticado. Las sociedades modernas, distinguiéndolas de las tradicionales, son aquellas sociedades que están constituidas y construidas, esencialmente, a partir de conocimiento teórico o conocimiento experto.

Para dar un ejemplo, la diferencia estereotipada entre sociedad tradicional y sociedad moderna. En la sociedad tradicional, —un grupo étnico en el Amazonas hace 30 o 40 años—, las normas que rigen la vida diaria son generadas endógenamente a través de relaciones cara a cara, en el día a día, históricamente. En las sociedades modernas las normas que rigen la vida cotidiana, que determinan cómo significamos, cómo interpretamos, cómo vivimos nuestra vida, no están producidas a ese nivel de la relación cara a cara, sino que están producidas por mecanismos expertos, impersonales, que parten del conocimiento experto en relación con el Estado”.

“La segunda característica de la modernidad que Giddens enfatiza es la descontextualización, que es el despegar, arrancar la vida local de su contexto, y que la vida local cada vez es más producida por lo translocal. Por eso muchos movimientos sociales hablan de resituar la vida local en el lugar. Estas teorías de Giddens están muy por detrás de la forma en que se ve la globalización. Muchos de los teóricos parten de la teoría de este sociólogo inglés, en sus libros de finales de los 80 y comienzos de los 90. Giddens dice que la globalización no es una etapa nueva, distinta a la modernidad; no hay posmodernidad, eso son invenciones de algunos filósofos, que estamos todavía dentro de la modernidad, que la globalización simplemente es una radicalización y universalización de la modernidad, cuando la modernidad ya no es solamente un asunto de los países modernos occidentales europeos, sino que, precisamente, la globalización ocurre cuando la modernidad logra universalizarse, globalizarse. Lo que quiere decir que, en gran medida, el control de occidente sobre la modernidad se debilita, pero que al mismo tiempo, precisamente, porque ya occidente ha alcanzado a abarcar todo el resto del planeta”

Desde esta perspectiva de la supuesta globalización de la modernidad se pueden distinguir las siguientes opciones:

La globalización conlleva la radicalización de la modernidad.

La modernidad debe ser transformada o completamente reconstruida desde adentro.

El mundo actual se compone de variaciones múltiples de la modernidad

Características

Según Juan Chinesa (2015)

1. Institucionalización de la racionalidad moderna europea: subalternización de lenguas, razas y saberes

Descartes: El Discurso del Método

Kant: Crítica de la Razón Pura (Ilustración)

Benjamin Franklin: electricidad y eurocentrismo

Cézanne: padre de la modernidad en la pintura, influye en Picasso

= Razón y lógica (científica) desplaza a la representación y la belleza

2. Conocimiento científico vs. saberes tradicionales

Espacios más vitales que adornados, más funcionales que decorados

La utilidad se transforma en el principio de organización de la forma moderna

Dominio de la CyT no tiene límites

La modernidad reemplazo las catedrales por museos, bibliotecas y cinematógrafos

¿Conclusión?

“si usted no se moderniza y no es capaz de entender los cambios que se generan en occidente [y] condena a su pueblo al atraso y a la tragedia, (...) como le pasó a los pueblos árabes que quedaron sometidos. Necesariamente tienen que dar ese salto si quieren seguir en una condición mínimamente soberana, y esa disyuntiva se hace irrenunciable ya a partir del siglo XIX (...) Para poderse modernizar [un pueblo] debe renunciar a muchas cosas que le son esenciales, le son profunda y le son íntimas. Todo pueblo debe sacrificar su alma por la modernidad, Occidente también lo hizo, también desaparecieron los más profundos espíritus en aras de la ciencia. La ciencia perdió toda relación con lo sagrado, con la madre y con el cosmos. Lo que eso costó se está pagando ahora; en todo sentido, ecológico, político, espiritual. Los costos de la modernidad son terribles”. (Diana Uribe, 2016)

De la modernidad a:

la posmodernidad

la hipermodernidad (Lipovetsky)

la modernidad líquida (Bauman)

la posverdad

¿Neologismos o modos de pensamiento?

Colonialidad epistémica occidental:

- Sánchez-Tarragó, N., Bufrem, L. S., & dos Santos, R. N. M. (2015). La producción científica latinoamericana desde una mirada poscolonial. Tendências da Pesquisa Brasileira em Ciência da Informação, 8(2).

Este artículo asume la perspectiva de los estudios postcoloniales con una crítica al pensamiento hegemónico que sostiene que los saberes producidos por Europa Occidental (y Estados Unidos) son los únicos que pueden ser considerados universales, valiosos y que constituyen el modelo obligatorio a seguir para el resto de las naciones y culturas en su trayecto hacia el desarrollo/modernidad. Para ello, a través de una investigación bibliográfica, se analizan algunas manifestaciones de la geopolítica del conocimiento que influyen en la perpetuación de la colonialidad del saber en las instituciones académicas latinoamericanas: hegemonía del idioma inglés en la publicación científica, los índices bibliométricos, las políticas de publicación, evaluación y recompensa científica y las integraciones asimétricas.

3.4.2 Creación vs. Investigación

“Ilustración”

Científicos del siglo XIX:

Debo encontrar la explicación de este fenómeno con el fin de entender realmente la “Naturaleza”

Científicos del siglo XXI

Debo escribir a como de lugar un artículo que sea aceptado para publicación en "Nature"

Fuente: Twitter

La ciencia parece hoy reducirse a: "Publish or Perish"

Implicación en las artes, arquitectura y diseño

Javier Gil Marín y Víctor Laignelet Sourdis en su texto ‘ Las artes y las políticas del conocimiento: tensiones y distensiones’ afirman que:

“[el] conocimiento científico es solamente una modalidad del pensamiento y del conocimiento. Es evidente que el pensamiento y el conocimiento no se pueden reducir al contexto de las operaciones lógicas propias de la ciencia. Más allá de una búsqueda de recursos y financiación, lo que está en juego son las políticas del conocimiento, los sistemas de validación, el valor que se otorga a la creación y a lo sensible en la producción del conocimiento y, por tanto, en sus proyecciones pedagógicas. (...) Consideramos que las artes, frente a las lógicas del conocimiento científico, se presentan como lo otro, un otro que se resiste a ser conceptualizado desde miradas ajenas a su naturaleza. (...) Es claro que el conocimiento artístico, fundamentado en los procesos de creación, difiere radicalmente de los modos científicos de investigar y de la organización formal del conocimiento; esa diferencia, más allá de esperar un auténtico reconocimiento, puede movilizar los mapas dominantes de comprensión y valoración de saberes y modos de conocer”. (p. 38)

youtube

youtube

youtube

Ver además:

Santiago Castro-Gómez [Video 1] [Video 2]

Resultado:

Por primera vez, la Convocatoria 737 de medición de grupos de @Colciencias reconoce y valora la creación en artes, arquitectura y diseño. [Ver tweet]

Según Vilches (2014):

El diseño es una disciplina altamente problemática; en principio, dice Selle, porque desempeña un papel determinante en la implantación o afianzamiento de un acuerdo sobre la interpretación y transformación de la realidad. Cuando el diseñador formula el problema de diseño, como en todo disciplina científica, debe ser también un investigador: para estudiar si el problema tiene solución debe saber qué exigencias debe satisfacer, porque el mundo contemporáneo altamente tecnificado requiere del conocimiento de los resultados del saber indispensables para generar mejores proyectos.

Todo acto creativo requiere de conocimientos suficientes para comprender sus consecuencias. Por eso el diseñador debe satisfacer las exigencias del quehacer científico: sentido de la observación, gusto por la precisión, imaginación, curiosidad, imparcialidad, y todas aquellas actitudes requeridas por la objetividad (p.33)

A modo de conclusión

Según Bernal (2010):

En la actualidad, el desafío en el campo de la epistemología consiste en la integración del conocimiento entendido como una categoría más amplia que la de la ciencia misma, porque incluye los saberes de la vida cotidiana como la religión, el mito, las creencias, etcétera.

Hoy se necesita integrar el conocimiento y para ello se requiere investigar en grupos interdisciplinarios capaces de trascender su disciplina, para generar nuevo conocimiento mediante la transdisciplinariedad. El investigador individual no tiene razón de ser.

Este aspecto de la complejidad y transdisciplinariedad de la ciencia es muy importante en el campo de todo conocimiento, si se tiene en cuenta que estas disciplinas se apoyan en otras para su desarrollo y su acción práctica, así como en otros tipos de conocimiento. (p. 53)

Control de lectura:

- Herrera Batista, Miguel Ángel (2010). Investigación y diseño: reflexiones y consideraciones con respecto al estado de la investigación actual en diseño. Disponible en http://www.nosolousabilidad.com/articulos/investigacion_diseno.htm

Consultar:

¿Cuáles son las líneas de investigación del Departamento de Diseño?

3.5 Metodología e Investigación en Diseño

¿Qué es el Diseño?

¿Definiciones?

Xènia Viladàs (2010) utiliza una serie de descriptores que caracterizan al diseño más que lo definen. En síntesis, configuran la función proyectual del diseño como sigue:

Tiene un componente clave de creatividad

Sigue una metodología precisa

Es fruto de una decisión consciente y no del azar o de la costumbre

Da respuestas, explícitas o latentes, a necesidades de las personas

Se propone alcanzar unos objetivos fijados que se establecen en el encargo

Debe ceñirse a unos determinados grados de libertad (en términos presupuestarios, temporales, etc)

Alcanza unos resultados que tienen que poder evaluarse según lo establecido en el encargo

Además, indica que el diseño en todo su potencial y no solo en su cometido más trivial, el de dar forma, el diseño cumple tres funciones críticas

Identifica el valor

Confiere valor

Comunica el valor

Según Vilches (2014):

Todos los diseños, como disciplinas autónomas, tienen su propia metodología emanada de la metodología general. Las teorías pueden ser intradisciplinarias, multidisciplinarias e interdisciplinarias, y las resultantes de sus posibles relaciones son las corrientes teóricas expresadas en un modelo para diseñar o entender lo ya diseñado.

Leer:

Los métodos de diseño y sus limitaciones en la fase creativa desde Portsmouth hasta el Design Thinking, por Irma Laura Cantú Hinojosa

Taller #2

Para el martes 20 solamente leer. Después de esta sesión publique la respuesta a cada pregunta en el blog.

1. Explore el proyecto: Diseño Participativo como estrategia de competitividad en la Cestería de la Comunidad Artesanal del Valle de Tenza.

¿Cuáles son los argumentos que le permiten o no identificarla como investigación cualitativa?

2. Realice la lectura del artículo: Campos de poder artesanales en la comunidad Kamsá de Sibundoy, Putumayo, Colombia. Del trueque a las tendencias de moda Autor Barrera Jurado, Gloria Stella

¿Qué deduce de la Investigación cualitativa y de la participación de los diseñadores en la investigación?

Próxima sesión

Enfoques de la investigación: cualitativa

youtube

La investigación cualitativa en el campo del Diseño Industrial

Procesos para la realización de una investigación cualitativa

Referencias

Bernal Torrez, C. A. (2010). Metodología de la investigación, administración, economía, humanidades y ciencias sociales. Pearson.

Bunge, M. (2014). La ciencia, su método y su filosofía. Sudamericana.

Tamayo, M. (1999). La investigación, Serie aprender a investigar. Módulo 2. ICFES. Bogotá.

Vilchis Esquivel, L. D. C. (2014) Metodología del diseño: fundamentos teóricos. México: Designio

0 notes

Text

«El criterio de demarcación propuesto nos conduce a una solución del problema de Hume de la inducción, o sea, el problema de la validez de las leyes naturales. Su raíz se encuentra en la aparente contradicción existente entre lo que podría llamarse “la tesis fundamental del empirismo” —la de que sólo la experiencia puede decidir acerca de la verdad o la falsedad de los enunciados científicos— y la inadmisibilidad de los razonamientos inductivos, de la que se dio cuenta Hume. Esta contradicción surge únicamente si se supone que todos los enunciados científicos empíricos han de ser “decidibles de modo concluyente”, esto es, que, en principio, tanto su verificación como su falsación han de ser posibles. Si renunciamos a esta exigencia y admitimos como enunciados empíricos también los que sean decidibles en un solo sentido —decidibles unilateralmente, o, más en particular, falsables— y puedan ser contrastados mediante ensayos sistemáticos de falsación, desaparece la contradicción: el método de falsación no presupone la inferencia inductiva, sino únicamente las transformaciones tautológicas de la lógica deductiva, cuya validez no se pone en tela de juicio.»

Karl R. Popper: La lógica de la investigación científica. Editorial Tecnos, págs. 41-42. Madrid, 1962

TGO

@bocadosdefilosofia

@dias-de-la-ira-1

#karl r. popper#karl popper#popper#la lógica de la investigación científica#ciencia#teoría de la ciencia#filosofía de la ciencia#epistemología#criterio de demarcación#enunciado#enunciado científico#falsabilidad#enunciado falsable#falsable#falsación#método inductivo#métodos inductivos#inducción#problema de la inducción#lógica deductiva#inferencia lógica#inferencia inductiva#inferencias inductivas#hume#crítica de hume al método inductivo#enunciados empíricos#ciencias empíricas#ciencias experimentales#leyes naturales#teo gómez otero

2 notes

·

View notes

Text

AGS&B on Twitter

portal_com: ¿Cuando una proposición es científica? Sobre falsación y filosofía de la ciencia, Ll. Codina https://t.co/K8PVjSuosE

Check out the entire post on https://twitter.com/agsb_bilbao/status/930036596103090176

0 notes

Text

«Vale la pena reparar en otra diferencia entre el marxismo y el hegelianismo. El hegelianismo no es una teoría con cuya ayuda se pueda predecir eventos u ocurrencias —sea en la Naturaleza o acerca de la Historia. El marxismo, sin embargo, es una teoría acerca de la Historia precisamente en el sentido de teoría según la cual se pueden hacer predicciones. El hegelianismo pretende poder entender y explicar lo que ocurre o ha ocurrido, pero no pretende poder predecir lo que ocurrirá. El marxismo tiene además esta pretensión: pretende poder predecir lo que ocurrirá. Esta es una diferencia radical con respecto al hegelianismo, ya que el hegelianismo es un sistema categoríal, resultado de un análisis lógico-filosófico de las condiciones lógicas de nuestro pensamiento. Pero en el momento mismo en que el marxismo pretende poder predecir eventos, ya no es un sistema filosófico, es una teoría de la Historia. Y al hacer predicciones ha quedado abierto al falseamiento. Innecesario es decir que es objeto de discusión si ha sido falseado o no. Si se es marxista apasionado difícilmente se aceptará que haya sido falseado. Es obvio que tal posición crea también problemas pues, como ha señalado Popper, una teoría que no pueda ser falseada no puede pretender tener status científico.»

Justus Hartnack: Breve historia de la filosofía. Ediciones Cátedra, pág. 242. Madrid, 1989

TGO

@bocadosdefilosofia

@dias-de-la-ira-1

#justus hartnack#breve historia de la filosofía#marximo#hegelianismo#falsacionismo#falsabilidad#falsación#falseación#falseabilidad#naturaleza#historia#teoría de la historia#ciencia#status científico#análisis#análisis lógico-filosófico#popper#marx#materialismo histórico#materialismo dialéctico#predicción#hechos#eventos#sucesos#karl marx#lógica#condiciones lógicas#pensamiento#teo gómez otero

2 notes

·

View notes

Text

«El antiguo ideal científico de la epistēmē —de un conocimiento absolutamente seguro y demostrable— ha demostrado ser un ídolo. La petición de objetividad científica hace inevitable que todo enunciado científico sea provisional para siempre: sin duda, cabe corroborarlo, pero toda corroboración es relativa a otros enunciados que son, a su vez, provisionales. Sólo en nuestras experiencias subjetivas de convicción, en nuestra fe subjetiva, podemos estar “absolutamente seguros”».

Karl R. Popper: La lógica de la investigación científica. Editorial Tecnos, pág. 261. Madrid, 1962

TGO

@bocadosdefilosofia

@dias-de-la-ira-1

#karl r. popper#karl popper#popper#la lógica de la investigación científica#ciencia#teoría de la ciencia#filosofía de la ciencia#episteme#epistemología#objetividad científica#provisionalidad#enunciado#enunciado científico#fe#fe subjetiva#convicción#experiencias subjetivas#falsación#falsabilidad#criterio de demarcación#teo gómez otero#ideal científico#ídolo#corroboración

4 notes

·

View notes

Text

¿Los austriacos rechazan realmente las evidencias empíricas?, por Mises Hispano.

Hace poco un amigo Facebook me preguntó lo siguiente:

¿Puedes explicarme esa historia de que los austriacos no creen en las evidencias empíricas o los factores estadísticos para el estudio de la economía? ¿Es verdad? A menudo se argumenta que los austriacos trabajan sobre axiomas previos que pueden tener o no evidencias empíricas y que si se aporta alguna evidencia empírica que pueda enfrentarse a una conclusión de la Escuela Austriaca, esta se rechaza considerándola una nimiedad. Se dice que rehúyen las estadísticas y otros medios de medir las acciones de los hombres. Esto resulta extraño porque veo que los austriacos usan gráficos y similares para ilustrar cosas como los auges económicos. ¿Me puedes explicar todo esto?

¿Y Rothbard tiene alguna divergencia con Mises sobre este tema? Gracias.

Deberíamos hacer inmediatamente una distinción, como hacía Mises, entre teoría e historia económica, siendo la primera el estudio de la acción humana en su relación con el hombre en un mundo de recursos escasos y la segunda una explicación real de cómo hombres, precios, bienes y servicios han interactuado entre sí en el pasado. En otras palabras, por definición, hay una diferencia entre los que afirmamos lograr por medio de la teoría de la acción humana frente a la investigación histórica. Y así Mises escribió un libro entero llamado Teoría e historia. Consideremos lo que dice Mises en La acción humana:

Los enunciados y proposiciones [económicos] no derivan de la experiencia. Son a priori, como los de la lógica y la matemática. No están sometidos a verificación y falsación a partir de experiencias y hechos. Son tanto lógica como temporalmente anteriores a cualquier comprensión de hechos históricos. Son un requisito necesario para cualquier entendimiento intelectual de acontecimientos históricos.

Mises llamaba praxeología a la teoría general y formal de la acción humana. La economía era una parte de la praxeología.

Así que la respuesta correcta a la pregunta inicial es que los austriacos no creen que las leyes económicas puedan descubrirse a través de evidencias empíricas/estadísticas. Pues, por definición, el propósito de las evidencias y las estadísticas es reunir información histórica, no descubrir teoría económica. Por tanto, la información empírica se relaciona con la “economía” solo de una manera amplia y general, para conseguir una imagen mejor del pasado, pero nunca para lograr leyes de la acción humana. Un buen ejemplo puede encontrarse en el Capítulo 4 de America’s Great Depression de Murray Rothbard. Al preparar su explicación de cómo la década de 1920 estuvo marcada por una tendencia monetaria inflacionista, Rothbard hace una observación con respecto a su método (saltos de párrafo añadidos):

La mayoría de los escritores sobre la Depresión de 1929 cometen el mismo error grave que asola los estudios económicos en general: el uso de estadísticas históricas para “probar” la validez de la teoría económica. Hemos tratado de indicar que esta es una metodología radicalmente defectuosa para la ciencia económica y que la teoría solo puede confirmarse o refutarse sobre bases apriorísticas. El hecho empírico entra dentro de la teoría, pero solo al nivel de axiomas básicos y sin relación con los “hechos” histórico-estadísticos comunes usados por los economistas actuales. (…)

Baste con decir aquí que las estadísticas no pueden demostrar nada, porque reflejan la operación de numerosas fuerzas causales. Por ejemplo, “refutar” la teoría austriaca del comienzo del auge porque los tipos de interés podrían no haberse rebajado en algún caso es irrelevante. Sencillamente significa que otras fuerzas (tal vez un aumento en el riesgo, tal vez la expectativa de una subida de precios) fueron lo suficientemente fuertes como para aumentar los tipos de interés. Pero el análisis austriaco del ciclo económico sigue operando independientemente de los efectos de otras fuerzas. Pues lo importante es que los tipos de interés son más bajos de los que habrían sido sin la expansión del crédito.

A partir del análisis teórico, sabemos que este es el efecto de toda expansión del crédito por los bancos, pero estadísticamente estamos desvalidos: no podemos usar la estadística para estimar cuál habría sido el tipo de interés. Las estadísticas solo pueden registrar eventos pasados, no pueden describir eventos posibles, pero sin cumplir.

Así que las estadísticas no se “rehúyen” como tales: más bien, se relegan a su lugar adecuado en el edificio económico. El que los austriacos no piensen que las leyes de la economía se descubren mediante modelos complejos no significa que las estadísticas en general no se usen nunca. Sería como quejarse de que las leyes de la lógica nunca se han “demostrado” con estadísticas. Es natural que las leyes lógicas no se determinen mediante investigación empírica, sino que más bien se presuponen.

Así que cuando se nos acusa de rechazar las evidencias empíricas, tendríamos que señalar que las estadísticas, por su propia naturaleza epistemológica, no pueden dejar de demostrar lo que se descubre mediante pensamiento apriorístico. Las estadísticas están repletas de sus propios supuestos, correlaciones, condiciones temporales y más cosas, lo que las hace absolutamente insuficientes para proporcionar leyes inquebrantables de teoría económica. Traedme un estudio que demuestre que los controles de precios no funcionan y os señalaré otro que demuestra que los salarios mínimos son el secreto de una economía próspera.

¿Qué hay de las diferencias entre Rothbard y Mises en este punto?

Como he indicado anteriormente en este sitio, quiero destacar siempre el hecho de que Rothbard veía la teoría económica como un estudio a priori, es decir, defendía una metodología económica que destacaba el hecho de que la teoría económica y las leyes económicas deben obtenerse por una aplicación de las leyes de la lógica y el razonamiento sobre el axioma de la “acción humana” (los seres humanos actúan con un propósito y cada uno emplea medios para alcanzar sus fines valorados). Dicho de otra manera, Rothbard seguía totalmente la tradición económica de su mentor, Ludwig von Mises, como la metodología económica apropiada.

Pero debemos echar un paso atrás hacia el propio axioma. ¿Cómo “sabemos” que los humanos actúan con un propósito? ¿Cómo descubrimos el axioma de la acción?

Fijémonos en lo siguiente, extraído de la cita anterior de Rothbard:

El hecho empírico entra dentro de la teoría, pero solo al nivel de axiomas básicos y sin relación con los “hechos” histórico-estadísticos comunes usados por los economistas actuales.

La postura de Rothbard era que había que reflexionar y aplicar experiencia del mundo real para alcanzar este axioma económico. Así que, categóricamente, Rothbard era un “empirista” en sentido tomista. Pero este empirismo estaba muy lejos del más moderno “positivismo lógico” empírico. En todo caso Mises rechazaba a Tomás de Aquino y en su lugar prefería un punto de partida más “racionalista”: presupuestos y leyes de pensamiento. Mises veía el axioma de la acción de tal forma que negarlo era probarlo.

Es decir, en palabras de Hans-Hermann Hoppe, comentando sobre la epistemología de Mises:

[Los axiomas] son evidentes porque no se puede negar su verdad sin contradecirse; es decir, al tratar de negarlos se admite implícitamente su verdad.

Mises consideraba los axiomas, no como deducidos empíricamente, sino como proposiciones sintéticas a priori, en la terminología de Immanuel Kant: proposiciones que no se descubren por experiencia y que tampoco son simplemente verdaderas por definición.

Debería insistir, de forma que nadie cuestione esto, en que, a pesar de que Rothbard y Mises estaban en desacuerdo en el fundamento de un axioma, ambos consideraban la economía como una ciencia a priori que se basa en una metodología deductiva (ver En defensa del apriorismo extremo, de Murray Rothbard).

El artículo original se encuentra aquí.

de Biblioteca Mises https://ift.tt/2ECAV6u

https://ift.tt/2v4Q1Cd

de nuestro WordPress https://ift.tt/2v5GVVR

Difundimos las ideas liberales, libertarias, minarquistas y anarcocapitalistas. https://ift.tt/2Hp3OpK April 11, 2018 at 08:07AM

0 notes

Text

Praxeología: Ciencia y método, por Mises Hispano.

El objetivo de este texto es fundamentar el método praxeológico partiendo de la propia filosofía y ciencia del conocimiento. Pienso que aún no están claros esos fundamentos ni siquiera entre buena parte de sus defensores. Las críticas a las objeciones al método praxeológico comúnmente atacan a éstas sobre una base errónea. Se suele argumentar que el método de las ciencias naturales no debe ser aplicado a la economía, cuando la verdad es que ni siquiera es posible hacer tal cosa. Voy a demostrar que los críticos a la praxeología no utilizan en economía el método de las ciencias empíricas, sino el método induccionista. Y la inducción es una falacia. En economía, y en ciencias naturales. Lo cual también voy a demostrar aquí. Al final expondré los fundamentos de la praxeología.

1. Introducción al método deductivo

El falsacionismo popperiano es mucho más que un mero criterio de demarcación1,2. Es una actitud, una filosofía de la actividad científica. Esa actitud consiste en exponer a las pruebas empíricas las teorías que uno maneja, buscando no su confirmación –porque las pruebas empíricas, desde el punto de vista estrictamente lógico, no confirman nada– sino al contrario, su falsación. Es decir, consiste en buscar pruebas empíricas de que la teoría en cuestión es falsa, en exponerlo al método de contrastación deductiva.

Esta propuesta de Popper a menudo no ha sido honestamente valorada por sus críticos. Kuhn sugiere con razón en el hecho de que lo que distingue a la actividad científica de la que no lo es, no puede consistir sólamente en la contrastación. Si toda la actividad científica se tuviera que reducir a buscar pruebas que falseen nuestras teorías, dicha actividad no pasaría de un mero ejercicio teórico, y no podríamos sacar provecho del avance en la investigación científica que permite aceptar nuestras teorías como verdades dadas e investigar en base a ellas, sin cuestionarlas todo el tiempo.

El mismo Popper tampoco sugería eso, y cualquiera que haya leído alguno de sus textos fundamentales, lo puede corroborar. Él mismo aclaraba que el método de contrastación debía terminarse en algún momento, en el que hay suficiente acuerdo entre los investigadores. Pero que no por eso significaba que debíamos aceptar la teoría como dogma. Siempre era posible, cuando se hiciera necesario, seguir con el proceso de poner a prueba nuestras teorías e hipótesis.

Por lo tanto, al contrario de lo que afirman los críticos de Popper, Kuhn no invalidó la propuesta de Popper. Pues siempre que el conocimiento se vuelve problemático y hay desacuerdo, no hay otro camino útil que el método de contrastación deductiva, es decir, poner a prueba las teorías que originan el desacuerdo, buscando honestamente aquellos hechos empíricos que, de darse, las contradicen. Además ninguna tarea tendría la ciencia normal de Kuhn sin las revoluciones científicas que fueron el producto de la actitud de las nuevas generaciones de investigadores que se atrevieron a cuestionar y someter a pruebas las ideas científicas que el conservadurismo de las viejas aún sostenía incluso frente a las contradicciones con la experiencia. Sin embargo, es claro también que la observación de Kuhn relativiza el criterio de demarcación de Popper. Y esto es un problema en que Lakatos y Feyerabend se enfocan, si bien no voy a entrar en detalles aquí, ya que no corresponde al tema que quiero exponer.

Por supuesto, los hechos empíricos –enunciados básicos– también pueden ser objeto de la contrastación. Puede ser que la teoría sea válida y que los hechos empíricos que parecen demostrar que es falsa, se fundamenten en una base teórica problemática. Pues todo enunciado sobre un hecho de la realidad, nunca deja de remitir a conceptos universales que tienen la misma forma lógica que cualquier teoría.

Trabajemos con el siguiente ejemplo para ilustrar todo lo expuesto. Si yo sostengo la teoría de que todos los cisnes son negros (enunciado de carácter universal), y aquí y ahora me encuentro con un cisne, o en forma más general, en la localización espacial x, en el momento t hay un cisne (enunciado de carácter singular, en este caso las condiciones iniciales a partir de las cuales aplico la teoría), entonces la teoría en principio es falsada si el enunciado “hay un cisne blanco en las coordenadas espacio temporales x,t” es verdadero. Pero la teoría nunca puede ser confirmada si el cisne en cuestión es negro. Pues es sólo una observación –o, en general, una cantidad finita de observaciones–. De una cantidad finita de observaciones que corrobore una teoría, nunca puede deducirse lógicamente que la teoría es verdadera y que ha sido confirmada. De una cantidad finita de observaciones en que cada cisne observado resulta de color negro, no puede deducirse que todo cisne es negro. Es decir, del hecho de que no se hayan observado cisnes no negros, no se puede deducir que todo cisne es negro.

Por lo tanto, de esta manera el método inductivista del positivismo queda seriamente cuestionado. Y a partir de Popper, la tarea científica ya no se considera como el método de pasar de lo particular a lo general, sino a la inversa, de proponer un enunciado de validez general, y ponerlo a prueba o bien aplicarlo deductivamente para predecir y controlar eventos en el mundo real.

Ahora bien, puede suceder que el enunciado falsador –en las coordenadas espacio temporales x,t hay un cisne–, no sea cierto. Es probable que lo que hayamos observado no sea un cisne. De hecho el concepto de cisne es un concepto de carácter universal, que tiene la misma forma lógica que una teoría. Si en la observación a la que nos referimos reconocemos un cisne, es porque el objeto observado tiene todas las características mediante las cuales definimos un cisne: “todos los cisnes tienen tales o cuales características” es un enunciado universal. Es por eso que decíamos que implícitamente todo enunciado de carácter singular remite a alguno de carácter universal.